杰克马回归引爆AI圈,QwQ-32B强势开源,笔记本秒杀Deepseek!

凌晨,阿里云扔出了一颗大招——。,能写代码、解数学题、逻辑推理一把抓。更夸张的是——有兴趣的可以直接试试看,。在大模型的世界,大家早已习惯了“参数越大,效果越强”这一 Scaling Law。DeepSeek-R1、GPT-4 这些巨无霸模型,依靠庞大参数量形成碾压式优势,但这意味着。阿里这次反其道而行之,,靠的是什么?QwQ-32B 通过,针对数学、编程、逻辑推理等任务进行了专项优化。在和中,。

凌晨,阿里云扔出了一颗大招——QwQ-32B,仅 320 亿参数,却能硬刚 DeepSeek-R1 满血版(6710 亿参数)。

不是“还可以”,是真的能打!

最小 13GB,普通电脑能跑,推理速度 30+ Token/s,能写代码、解数学题、逻辑推理一把抓。更夸张的是——MacBook M4 Pro(48G 内存)本地跑,完全流畅!

有兴趣的可以直接试试看,这款 320 亿参数的小钢炮,推理质量和输出稳定性,居然能跟 DeepSeek-R1 满血版一较高下。

参数量级相差一个数量级,结果却难分伯仲!

📌开源地址:https://huggingface.co/Qwen/QwQ-32B

📌博客:https://qwenlm.github.io/blog/qwq-32b

为什么 QwQ-32B 能挑战 DeepSeek-R1?

在大模型的世界,大家早已习惯了“参数越大,效果越强”这一 Scaling Law。

DeepSeek-R1、GPT-4 这些巨无霸模型,依靠庞大参数量形成碾压式优势,但这意味着训练成本极高,部署门槛更是劝退了一大波开发者。

阿里这次反其道而行之,用 1/20 的参数量,挑战行业顶级推理模型,靠的是什么?

1. 强化学习+多阶段优化,推理质量不掉线

QwQ-32B 通过强化学习(RLHF)+ 多阶段训练,针对数学、编程、逻辑推理等任务进行了专项优化。

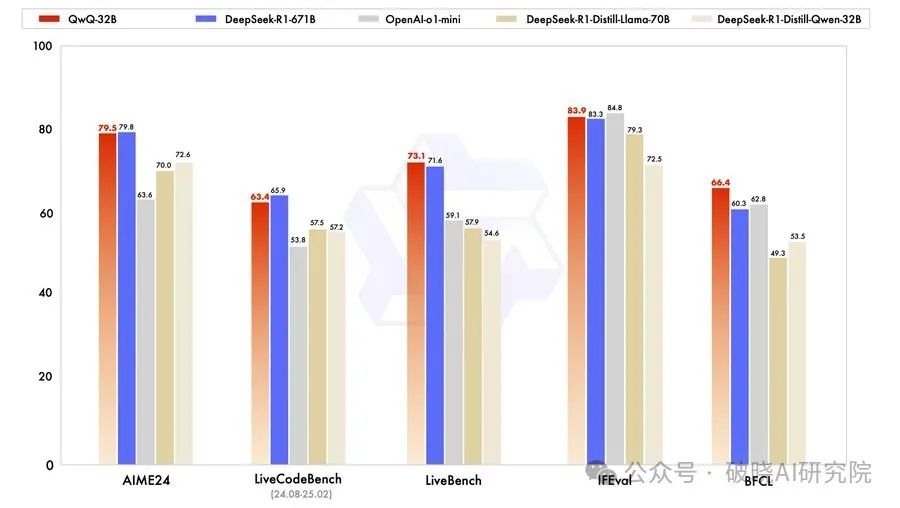

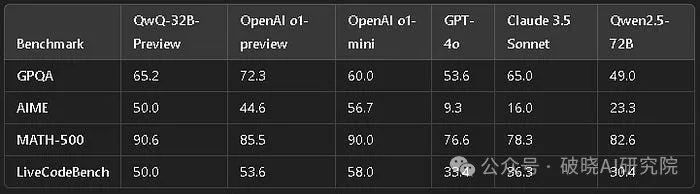

在AIME 2024 数学测试和LiveCodeBench 代码评测中,QwQ-32B 直接对标 DeepSeek-R1,在部分场景下表现甚至更稳定。

2. 量化优化,小显卡也能带飞

DeepSeek-R1 的 Q4 量化版,光是模型就 400GB+,需要四张 24GB 显存的 4090 才能跑起来。

QwQ-32B 呢?最小 13GB,单卡 RTX 3090 就能流畅跑,甚至连 MacBook Pro M4 Max 也能带得动。

家用电脑跑大模型?几年前这还是天方夜谭!

3. 极速推理,30+ Token/s

一般小模型参数少,推理快但质量差。QwQ-32B 却是个例外——

每秒 30+ Token 的生成速度,还能维持高质量推理,显然不是简单削减参数就能做到的。

如何快速上手 QwQ-32B?

都能本地跑了,怎么最快体验这款模型的实力?

1. 直接下载开源模型

-

Hugging Face 或 ModelScope(魔搭)搜索 QwQ-32B,一键下载。

-

确保安装了 PyTorch 和 Transformers,并有 ≥16GB 显存 的显卡。

2. 本地部署

如果想自己跑,操作很简单:

方式一:

-

安装 Ollama

-

终端运行:

ollama run qwq:32b -

没了,等进度条就行

方式二:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained("QwQ-32B路径")

tokenizer = AutoTokenizer.from_pretrained("QwQ-32B路径")

inputs = tokenizer("请用 Python 写一个快速排序", return_tensors="pt")

outputs = model.generate(**inputs)

print(tokenizer.decode(outputs[0]))如果嫌麻烦?可以用 OpenBayes 这样的预配置环境,几分钟内搞定部署。

QwQ-32B 不只是能跑,还能在多个应用场景正面对标 GPT-4:

✅ 代码补全 & 调试:LiveCodeBench 评测接近 GPT-4,可作为编程 AI 助手。

✅ 数学推理:AIME 2024 结果显示,QwQ-32B 在数学逻辑推理上稳压 o1-mini,部分场景接近 DeepSeek-R1。

✅ 本地 AI 助手:数据不想上传 OpenAI?QwQ-32B 直接本地跑,隐私安全可控,适合企业内网部署。

✅ AI Agent:结合 LangChain / transformers,轻松打造专属 AI 助手,用于 SQL 生成、数据分析等。

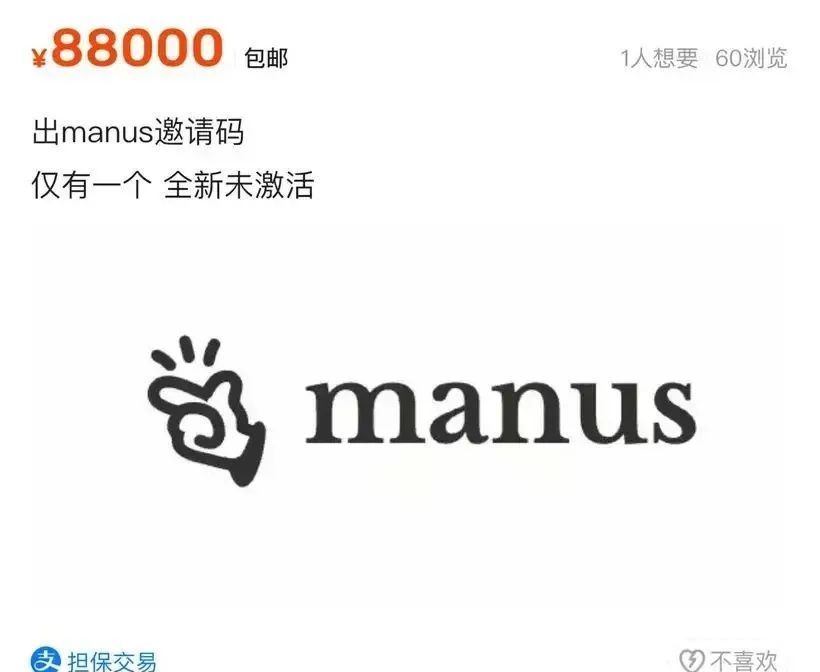

按理说,QwQ-32B 本该是 AI 圈热议的焦点,结果被 Manus 的“限量发售+测评翻车”抢了风头。

Manus 一码难求,测评却翻车

如果 Manus 晚两天发布,底层模型换成 QwQ-32B,说不定还能稳住口碑。

QwQ-32B 在强化学习和推理稳定性上的优化,真金白银砸出来的,不靠花里胡哨的宣传,实际测试也扛得住。反观 Manus,宣传视频做得满分,结果实测时各种掉链子,最终高开低走。

实力,不是靠 PPT 和营销堆出来的,而是得撑得住实际场景的检验。

很多厂商在发布前高调宣传推理能力,结果一到大规模测试就出问题,用户反馈一塌糊涂。而阿里这次直接开源,提供了透明的测试环境,模型下载即用,没有各种复杂限制。选择不同,结果自然不同。

QwQ-32B 的开源,正式宣告:AI 推理的“显卡税”被终结了!

DeepSeek-R1 太大,GPT-4 直接闭源,Manus 刚出道就翻车,普通开发者根本没得选。

QwQ-32B 这次直接把开源 AI 拉到了家用显卡能跑、消费级设备能用的水平,让“高性能 AI 推理”真正走向大众。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)