DeekSeek本地化部署初体验

DeepSeek的横空出世,如同一颗技术“核弹”投入了AI领域,迅速引发了全球科技界的广泛关注。它的出现不仅打破了传统大模型高昂的训练成本和技术门槛,还通过开源策略和创新的架构设计,为AI的普及和应用带来了新的机遇。

DeepSeek的横空出世,如同一颗技术“核弹”投入了AI领域,迅速引发了全球科技界的广泛关注。它的出现不仅打破了传统大模型高昂的训练成本和技术门槛,还通过开源策略和创新的架构设计,为AI的普及和应用带来了新的机遇。

对于中小企业和资源有限的机构来说,DeepSeek的低成本和高效率特性使其成为理想的AI解决方案。它不仅降低了智能化转型的门槛,还通过本地部署确保了数据隐私和安全。这种全方位的优势,使得DeepSeek在自然资源、测绘等多个垂直领域展现出强大的应用潜力。

一、本地化部署

1、安装Ollama

首先我们需要安装Ollama,它可以在本地运行和管理大模型。

到Ollama官网 https://ollama.com,点击下载,然后选择适合自己系统的版本,这里选择Windows:

为了避免模型数据量过大,占用C盘资源,可通过设置环境变量,修改模型存放位置:

OLLAMA_HOST:设置为0.0.0.0 会将ollama服务暴露到所有的网络,默认ollama只绑定到了127.0.0.1和localhost上了。

OLLAMA_MODELS:设置了模型的存放的地址。

验证Ollama是否安装成功:

![]()

2、部署 DeepSeek R1 模型

访问 Ollama 官网并点击页面顶部的「模型」(Models)选项,接着在列表中找到并点击「DeepSeek-R1」:

在模型详情页面,根据我们计算机的显存容量选择合适的模型版本。具体可参考:

运行命令:ollama pull deepseek-r1:14b

等待模型下载即可。运行效果14b的模型基本能用,32b的模型使用很是顺滑。至此,deepseek的本地部署已经完成。

测试一下:

二、WebUI可视化

WebUI可视化选择直接在浏览器安装Page Assist插件的方式来实现。

Page Assist是本地 AI 模型的 Web UI,可以使用本地运行的 AI 模型来辅助进行网络浏览,利用本地运行的AI模型,在浏览网页时进行交互,或者作为本地AI模型提供者(如Ollama、Chrome AI等)的网页界面。

仓库地址:https://github.com/n4ze3m/page-assist

打开浏览器,在扩展中的管理扩展页面,搜索找到Page Assist。

然后点击获取Page Assist进行安装,完成后就可以在扩展中看到PageAssist插件,点击对应的插件就可以直接使用。

配置模型地址:

可视化对话:

通过对话询问OGC中常见的GetMap接口参数,可以看出来deepseek-r1:14b模型中不包含此类型专业知识。

三、数据投喂训练

1、拉取模型nomic-embed-text

执行命令:ollama pull nomic-embed-text

2、配置RAG

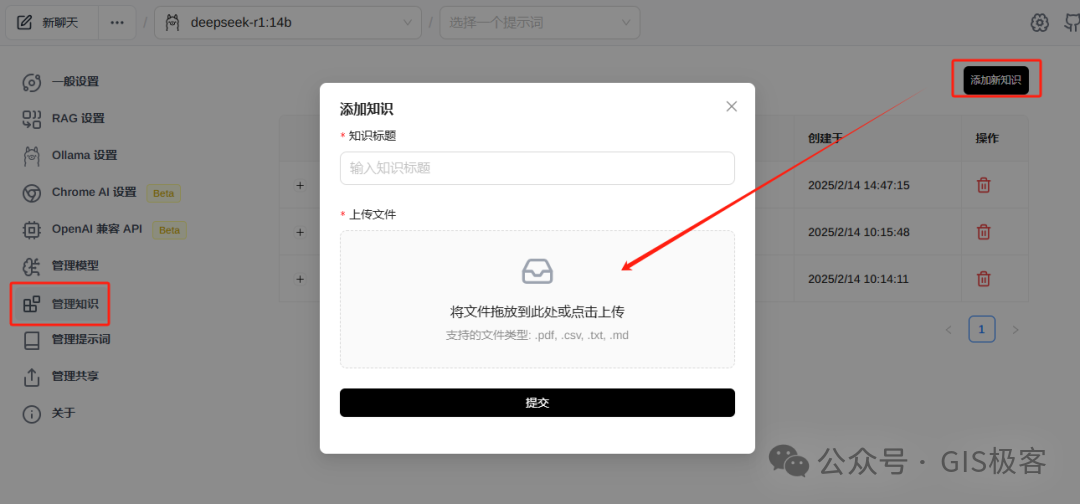

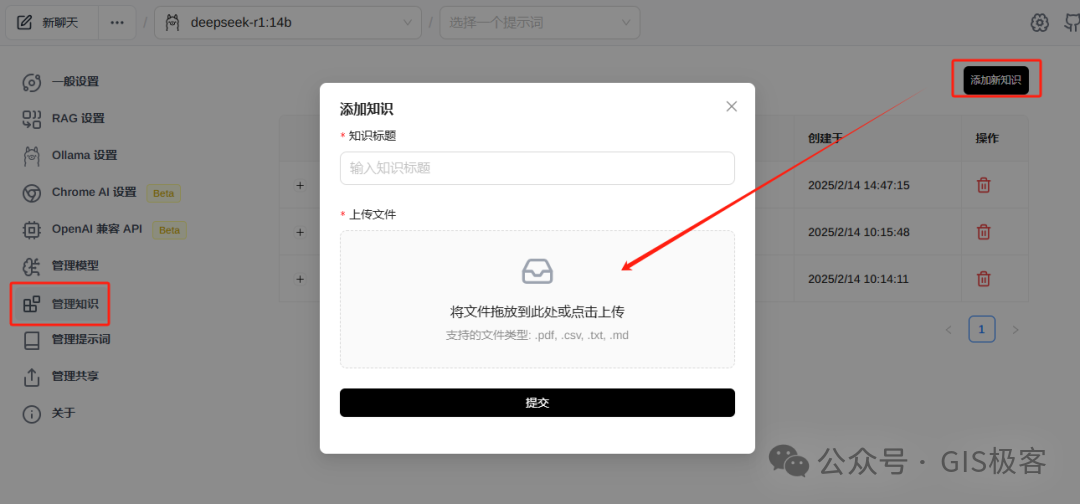

3、上传文档,训练知识

4、训练后效果

知识投喂训练后,再次询问GetMap接口参数,DeepSeek经过思考后,给出了正确答案。

思考过程

四、API接口调用

上面步骤已经配置过环境变量OLLAMA_HOST参数,即可通过url地址进行远程调用交互,接口示例:

curl http://192.168.1.37:11434/api/generate -d {"model": "deepseek-r1:14b","prompt": "你好,deepseek","stream":false}

Postman模拟请求示例:

五、与GIS产品集成的思考

1、通过投喂GIS专业知识、各行业及产品相关知识,训练垂直行业的私域模型,将训练好的深度学习模型集成到GIS平台中,提高产品智能化能力。

2、与可视化系统打通,提供智能助手,让系统更能理解用户想法,让用户更容易使用系统。

3、与自动化或低代码平台集成,根据用户需求自动生成代码、页面、业务系统,实现所见即所得的体验效果。

(以上纯属个人看法,如有不对之处,请大家评论区留言交流)

相信未来通过不断的与AI进行结合,可以为地理信息系统注入智能化能力,推动其在各行业的创新应用。这种结合不仅能够提升GIS的数据处理效率,还能为用户提供更精准、更智能的空间分析服务。

更多学习资料,请关注公众号【GIS极客】,或者加微信【eryeiscool】进技术交流群!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)