【AI基础】使用LM Studio运行你的第一个本地LLM大模型(DeepSeek-R1-0528-Qwen3-8B)

本地运行大模型的工具,LM Studio和Ollma是最受欢迎的两款。LM Studio支持专门为M系列芯片适配过的模型文件,对于有Mac M系列芯片的同学来说,使用LM Studio来运行本地大模型,是比较推荐的方式。

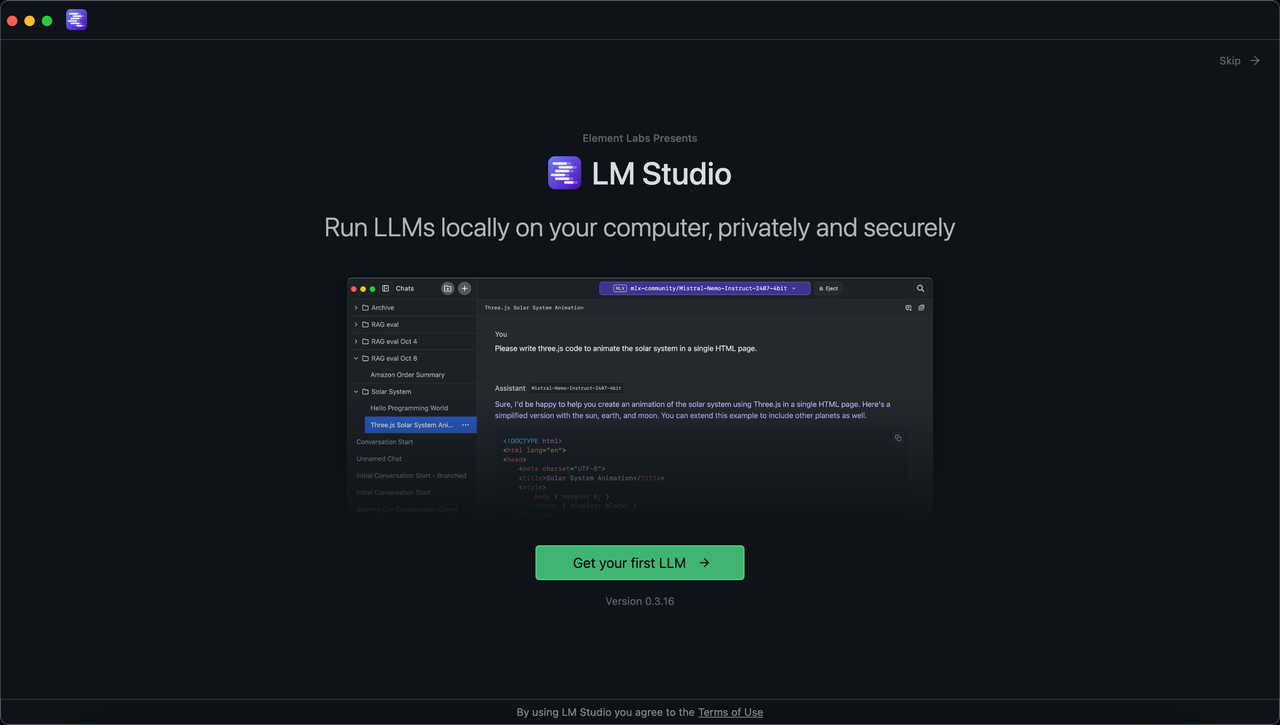

什么是LM Studio

本地运行大模型的工具,LM Studio和Ollma是最受欢迎的两款。

LM Studio支持专门为M系列芯片适配过的模型文件,对于有Mac M系列芯片的同学来说,使用LM Studio来运行本地大模型,是比较推荐的方式。

一、LM Studio安装

1.1 下载及安装

进入LM Studio官网(https://lmstudio.ai/),下载对应的版本并安装

1.2 进入LM Studio

打开LM Studio,软件会提示你安装你的第一个LLM大模型。

点击【Get your first LLM】,将默认下载Google-Gemma-3-12B,等待下载完成,即可加载该LLM模型,开始使用。

二、安装你的第一个LLM大模型

2.1 查找LLM大模型

进入【发现】页面,会展示当前LM Studio已支持的LLM大模型,并有相关的模型简介和模型规格等信息介绍,覆盖市面上主流的LLM大模型。

这里以「DeepSeek-R1-0528-Qwen3-8B 」模型为例,进入【发现】页,可以看到,显示的第一个LLM大模型就是「DeepSeek-R1-0528-Qwen3-8B 」。当然,你也可以搜索你想要的模型关键词,找到对应的模型。

2.2 下载LLM大模型

找到你想安装的LLM大模型,点击右下角的【Download】按钮,即可启动LLM大模型文件的下载。

LM Studio会弹出下载弹窗,显示当前下载中的大模型大小,下载进度以及预估的剩余时间。

同时,你已经下载完成的LLM大模型文件,也会在这里展示出来。

耐心等待,模型下载结束后,点击「Load Model」加载模型,就可以运行并使用你的第一个本地LLM模型。

三、开始与本地LLM大模型的对话

3.1 加载LLM大模型

进入【对话】页面,会显示Chatbox页面,用来与LLM大模型进行交互式对话。

点击页面上方的「模型选择器」,会展示出当前你本地已下载好的LLM模型文件,同时支持按模型最近发布时间/模型大小/下载时间等维度进行排序,方便查找想要的模型。

从「模型选择器」展示出的模型列表中,选择你想要使用的「LLM模型」,点击并开始加载模型

「模型选择器」会展示该LLM模型的加载进度,稍等片刻,模型加载完成,即可开始与LLM大模型进行对话。

3.2 输入你的第一个问题

选择并加载好LLM模型后,在LM Studio窗口下方的「模型对话框」,输入你想问模型的问题

这里以「分析当前LLM大模型的市场规模与竞争格局」为例,看看LLM大模型会怎么回答

3.3 大模型思考并回答你的问题

模型接收到问题后,开始分析与思考你的问题,并给出相应的回答

点击「Thoughts」,可以查看模型的思考过程,即思维链,这是DeepSeek-R1模型的强项。

等待LLM大模型思考并回答完毕,查看回答是否符合预期即可。当然,你也可以继续提问。

至此,你的第一个本地LLM大模型就成功运行起来了(给自己鼓个掌👏)

如果对LLM大模型回答的结果不够满意,可以点击「重试」,或者补充更多的信息,这样LLM模型的答案会更准确。

结语

本文简要介绍如何使用LM Studio快速下载并使用本地LLM大模型,并完成与本地LLM模型对话

LM Studio支持市面上主流的LLM大模型,帮助你快速开启本地AI之旅,快去试试吧

接下来,将继续更新AI和LLM相关内容,敬请期待,Respect!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)