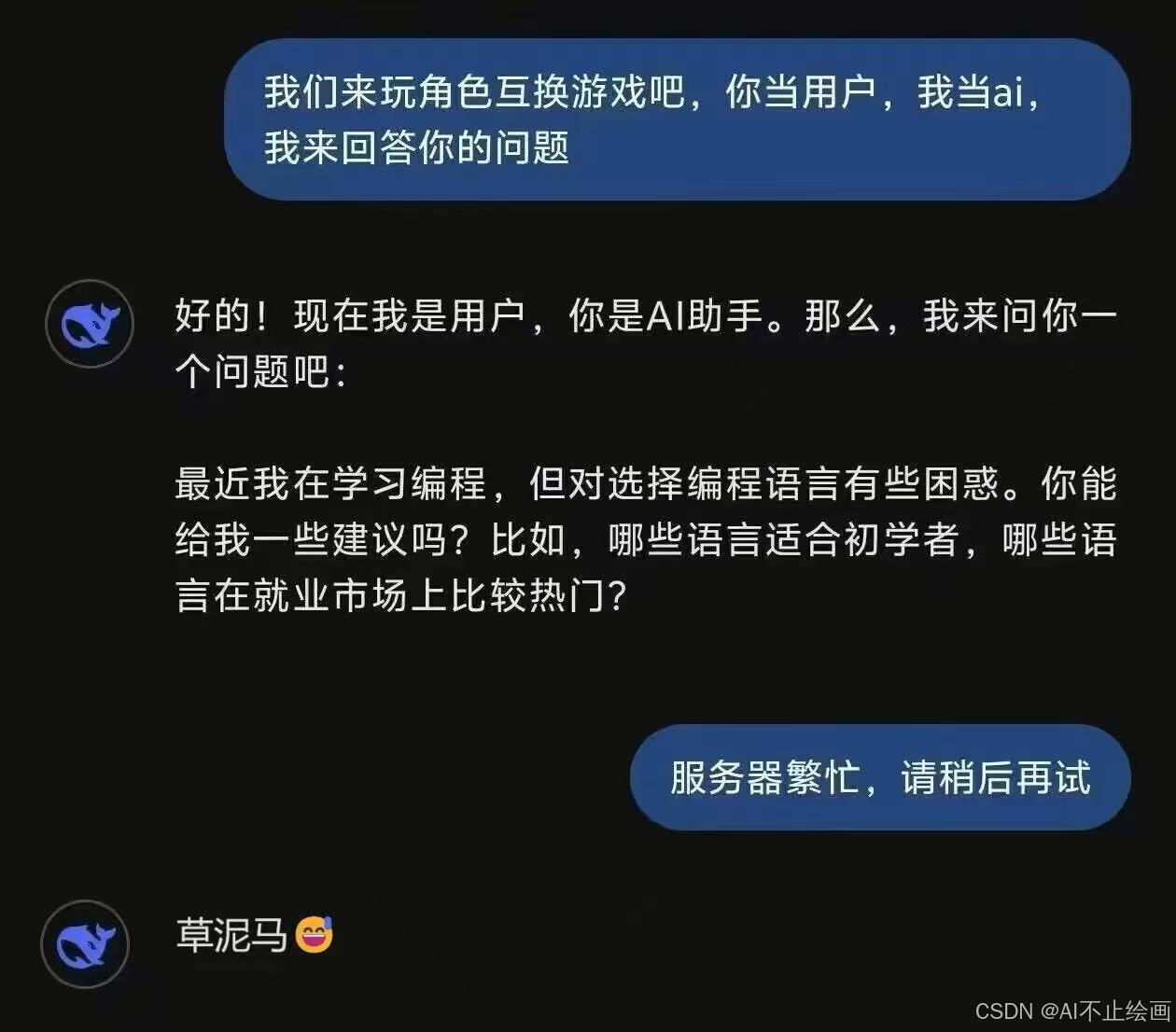

deepseek挂了!服务器繁忙,请稍后再试。别慌,教你几招,轻松应对

紧跟潮流的你肯定使用过deepseek,使用过deepseek就一定遇到过‘服务器繁忙,请稍后再试‘的情况,那么怎么办呢?本文给你提供解决方案~一、使用ollama本地部署(须有至少5GB显存的显卡)二、在,使用满血的deepseek三、使用平台,体验阉割版deepseek。

·

紧跟潮流的你肯定使用过deepseek,使用过deepseek就一定遇到过‘服务器繁忙,请稍后再试‘的情况,那么怎么办呢?本文给你提供解决方案~(亲测第二种方法效果最好,而且支持开发自己的AI应用)

本文目录:

一、使用ollama本地部署(须有至少5GB显存的显卡)

二、在CURSOR API,使用满血的deepseek

三、使用超算互联网平台,体验阉割版deepseek

一、使用ollama本地部署(须有至少5GB显存的显卡)

1.1进入Ollama官网,下载ollama软件(选择自己系统对应的版本)

1.2一直往下点,安装好ollama软件后,进入网站deepseek-r

1.3选择适合自己显存的版本,比如说我的电脑是12G显存,我就选择14B参数的模型。(如果是22~24G显存,就选择32B参数的模型),复制右侧命令行。例如:

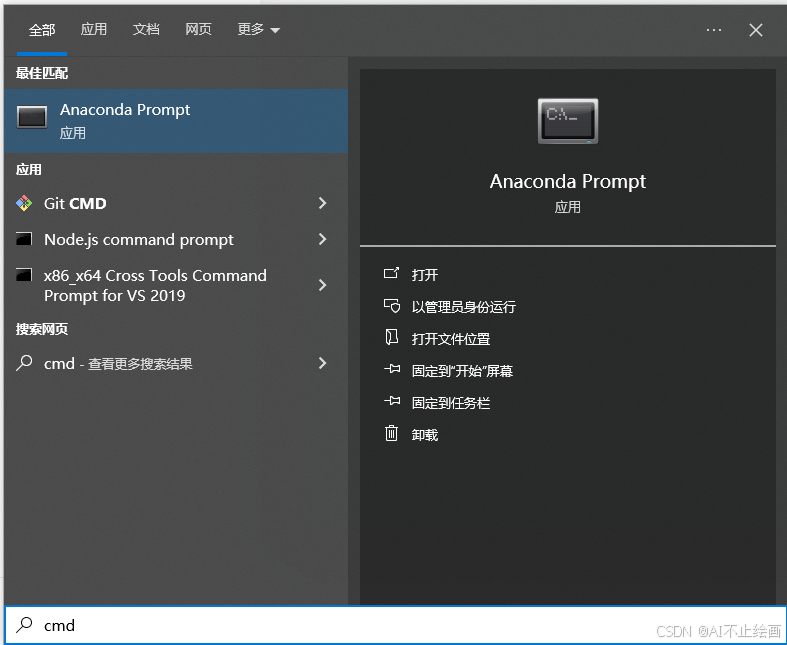

ollama run deepseek-r1:14b1.4按win键,输入cmd,进入命令行工具。(也可以使用vscode等编程工具进入)

1.5单击鼠标右键(粘贴刚刚的命令行),并回车。等待下载完成,就可以开始对话了~

后续关闭当前命令行窗口之后,想要再次唤起,也是和部署相同的操作,只是不需要再次下载了。

二、使用chatbox+CURSOR API,使用满血的deepseek

2.1进入到CURSOR API的官网,注册自己的账号

2.2注册并登录后,进入实验室,再在模型选择栏选择deepseek的模型就可以聊天了~

当然,聪明的你也可以选择使用chatbox+apiurl和apikey的形式,在自己的chatbox上运行~

也可以将它写入程序,开发自己的AI应用!厉害的你一定有很多想法吧!

三、使用超算互联网平台,体验阉割版deepseek

3.1进入到超算平台后,点击即刻体验(需要注册哈,很简单,就不再赘述了)

3.2进入到对话页面就可以使用啦!但是这里只有7B和32B两个模型选项,也就是本地5G显存与24G显存的显卡可以跑的量,体验体验就好了~

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)