AI大模型DeepSeek总是服务器繁忙?一文教你使用Ollama本地部署DeepSeek并流畅使用

一文教你本地使用Ollama本地部署AI大模型DeepSeek,可离线流畅使用!!!

DeepSeek作为国产AI大模型黑马,瞬间引爆了全球互联网,使用之后感觉他的深度思考能力已经超越很多普通人,像一个博士教授一样,非常好用,我坚信人工智能AGI已经不远,作为互联网码农,虽然AI发展必然会取代大部分程序员的工作,但是AI作为先进生产力的发展方向,必须拥抱未来,跟上时代的步伐。

一、安装Ollama大模型工具

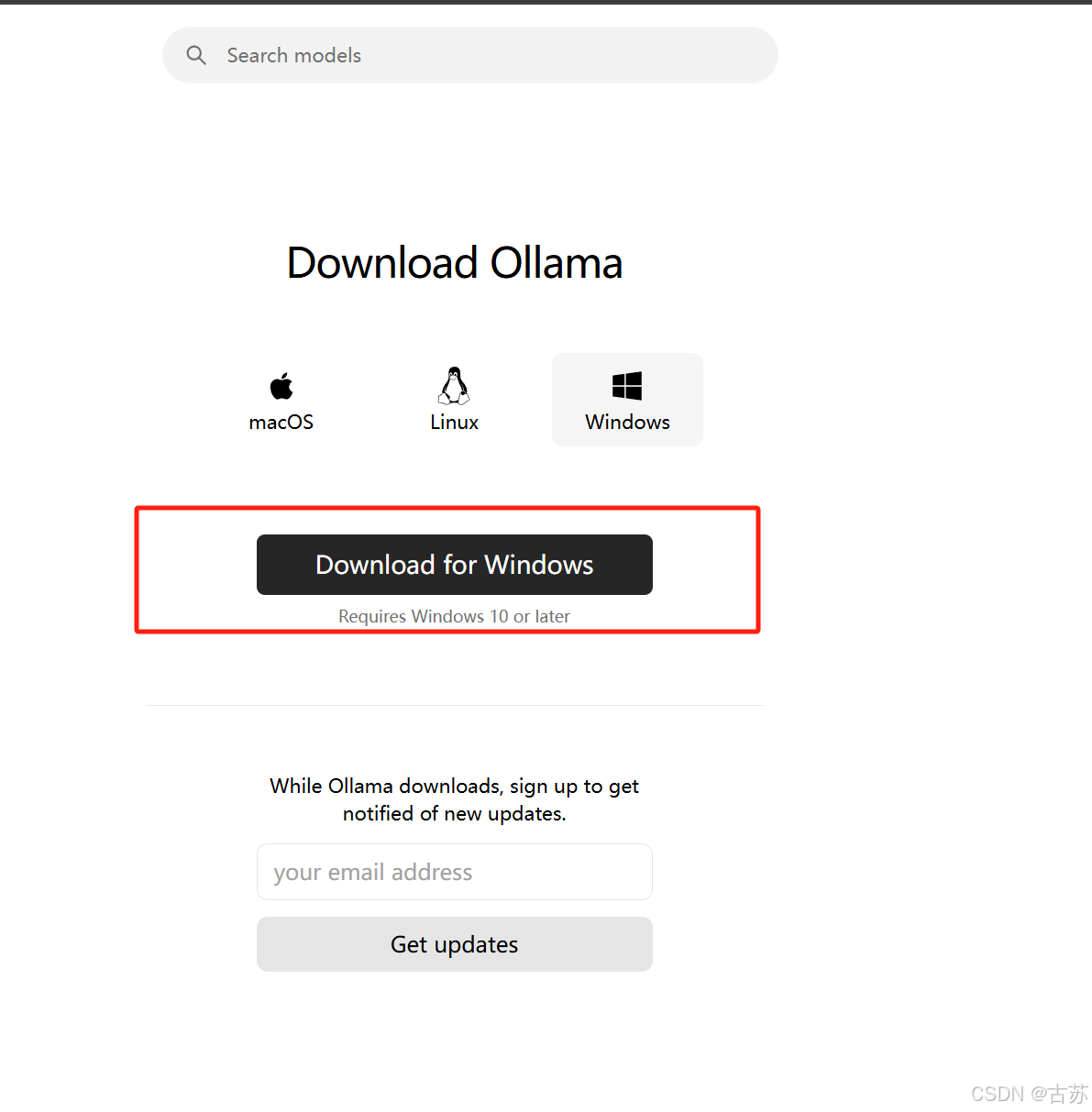

1、官网:https://ollama.com/,选择你电脑的系统下载就可以了

2、选择你的电脑平台,然后点击下载安装即可

3、配置环境变量

3.1 找ollama的安装路径,配置到系统环境变量上。安装到哪里就配置到哪里的路径

3.2 配置开源AI大模型的存储路径

由于AI开源大模型文件一般比较庞大,需要给ollama配置开源AI大模型的存储路径,避免占用C盘。如图所示,新建一个变量名为 OLLAMA_MODELS,变量值自己决定,就是AI大模型的存储路径,比如 D:\ollama-models

3.3、验证ollama安装成功

终端输入命令 ollama -v,显示版本信息即为安装成功

二、下载AI大模型deepSeek并运行

1、选择适合自己电脑显卡的deepSeek大模型参数版本

目前开放出来的1.5B、7B、8B之类的是Qwen/llama那些借助R1推理强化调出来的“蒸馏”版本,不是真正的R1。671B全量版才是真R1,真正的R1模型一般人是部署不起来的,需要非常强大的GPU配置。

根据自己的独立显卡容量选择,参考如下。

deepSeek大模型配置要求:

- deepseek-r1:1.5b——1-2G显存

- deepseek-r1:7b——6-8G显存

- deepseek-r1:8b——8G显存

- deepseek-r1:14b——10-12G显存

- deepseek-r1:32b——24G-48显存

- deepseek-r1:70b——96G-128显存

- deepseek-r1:671b——需要496GB显存以上

ollama下载安装deepseek命令,来自官网教程:deepseek-r1

DeepSeek-R1-Distill-Qwen-1.5B

ollama run deepseek-r1:1.5b

DeepSeek-R1-Distill-Qwen-7B

ollama run deepseek-r1:7b

DeepSeek-R1-Distill-Llama-8B

ollama run deepseek-r1:8b

DeepSeek-R1-Distill-Qwen-14B

ollama run deepseek-r1:14b

DeepSeek-R1-Distill-Qwen-32B

ollama run deepseek-r1:32b

DeepSeek-R1-Distill-Llama-70B

ollama run deepseek-r1:70b我电脑显卡内存容易只有6G,所以只能选择7B版本,下载安装命令为

ollama run deepseek-r1:7bollama会把大模型自动安装部署到OLLAMA_MODELS对应的变量路径里

2、下载安装成功,在终端里命令行使用。

ollama list 命令列出所安装的AI大模型,我这里只安装了deepsekk-r1:7b

windows终端推荐使用powershell,也可以用cmd(比较难用,复制困难)

复制这个NAME,运行大模型,命令为 ollama run deepseek-r1:7b

运行起来后,输入你的问题,回车键deepseek就可以非常流畅地回答你的问题了

三、把本地模型配置开源chatbox生成式对话软件上

1、下载安装chatbox开源AI对话软件,点击去下载安装到电脑上,选择你对应的电脑版本即可 https://chatboxai.app/zh#download

下载完成,打开安装即可。

2、打开chatbox,配置本地大模型。

使用cmd命令行先启动本地大模型deepseek,这个是配置前提,否则chatbox无法勾选大模型。

命令为 ollama run deepseek-r1:7b,注意不要关闭终端。

打开chatbox软件进行配置使用本地大模型。

- 模型提供方选择OLLAMA API

- 域名是 http://127.0.0.1:11434 , 这个是Ollama本地大模型的本机地址

- 模型需要点击勾选一下,我这里是 deepseek-r1:7b,如果不选,对话会报错,model requre!

- 最后点击保存,就可以快乐地使用带有对话框界面的本地大模型deepseek了。

使用效果如图

说明一下,生成式回答后,chatbox会自动计算出消耗的token,以及大模型的提供方

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)