在本地部署Deepseek-R1模型

使用ollma将模型部署到本地,再使用openWebUI作为美观的UI界面调用本地模型

在本地部署Deepseek-R1模型

注意:本文中所有的命令行窗口都是以管理员身份打开的

1.安装 ollama

(1)进入 ollama 官网 https://ollama.com/,点击 Download

(2)点击 Download for Windows,浏览器将跳转到 github 进行下载(记得挂梯子)

(3)待下载完成后,点击 OllamaSetup.exe

(4)点击 Install

(5)待安装完成后,打开“编辑账户的环境变量”,点击“系统变量”中的“新建”

(6)新建一个系统变量,这个变量用来存指示 Ollama 下载的模型的存储路径。其变量名为 OLLAMA_MODELS,变量值为自定义的模型存储路径。如下图所示

(7)在任务管理器中关闭 Ollama 和 ollama.exe

(8)再打开 Ollama 即可((7)(8)两步的目的是重启 Ollama,使得 OLLAMA_MODELS 设置的路径生效)

(8)找到当前 OLLAMA_MODELS 指向的路径,若发现多了一个 blobs 的目录,则标志着OLLAMA_MODELS 设置的目录生效了,之后下载的模型都会存储在这里。

2. 运行 Ollama 命令部署模型

以管理员身份打开命令行,输入 ollama 命令得到如下响应,说明安装完成

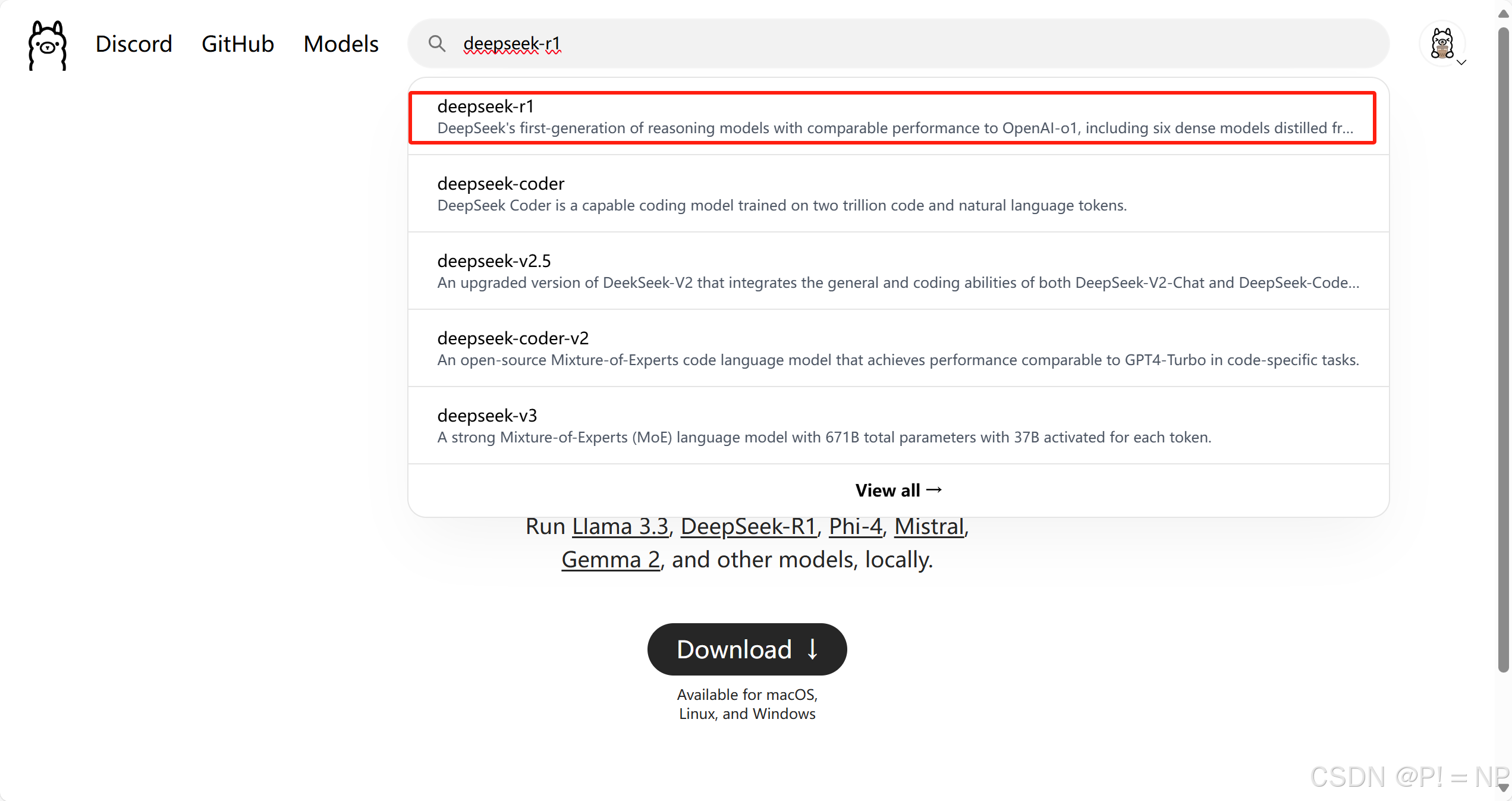

再回到 Ollama 官网,搜索 deepseek-r1

选择8b的模型(要根据自己的电脑配置来决定下载什么模型,本机GPU为 RTX4060,可以良好地运行8b的模型)

在命令行运行上图右侧的代码以下载 deepseek 模型(需耐心等待)

Ctrl+Z 即可结束与模型的对话,想要再次运行模型只需要输入命令 ollama run deepseek-r1:8b 即可。

3.使用GPU进行模型推理(本机 GPU 是 RTX4060)

3.1 安装 Visual Studio

“工作负荷”选择“使用 C++ 的桌面开发”,“安装详细信息”中的可选部分选择下图右侧所示的选项。Visual Studio 的版本需要与 Cuda 匹配,这里的 Visual Studio 是2022版,Cuda是 12.8 版本。

3.2 安装 Cuda

下载 CUDA Toolkit,网址:https://developer.nvidia.com/cuda-downloads

选择好机器型号后,点击 Download

下载完成后得到如下的 .exe 文件,运行文件以安装 Cuda

接下来直接点击 OK 就行,这是临时抽取 CUDA Toolkit installer 文件目录,用完了就删除了

等待抽取完成,进入安装界面,点击同意并继续

选择 自定义 -> 下一步

只选择 CUDA 即可

展开 CUDA,不需要选择 Nsight 开头的组件

点击下一步,等待安装完成即可(安装路径选择C盘中的默认位置比较稳妥,否则环境变量不好配置)

3.3 配置 CUDA 的环境变量

打开“编辑系统环境变量”,其中 CUDA_PATH 和 CUDA_PATH_V12_8 是自动配置好的

CUDA_SDK_PATH 和 CUDA_PATH 或 CUDA_PATH_V12_8 保持一致即可。

需要配置的五个路径如下

CUDA_SDK_PATH = C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.6

CUDA_LIB_PATH = %CUDA_PATH%\lib\x64

CUDA_BIN_PATH = %CUDA_PATH%\bin

CUDA_SDK_BIN_PATH = %CUDA_SDK_PATH%\bin\win64

CUDA_SDK_LIB_PATH = %CUDA_SDK_PATH%\common\lib\x64

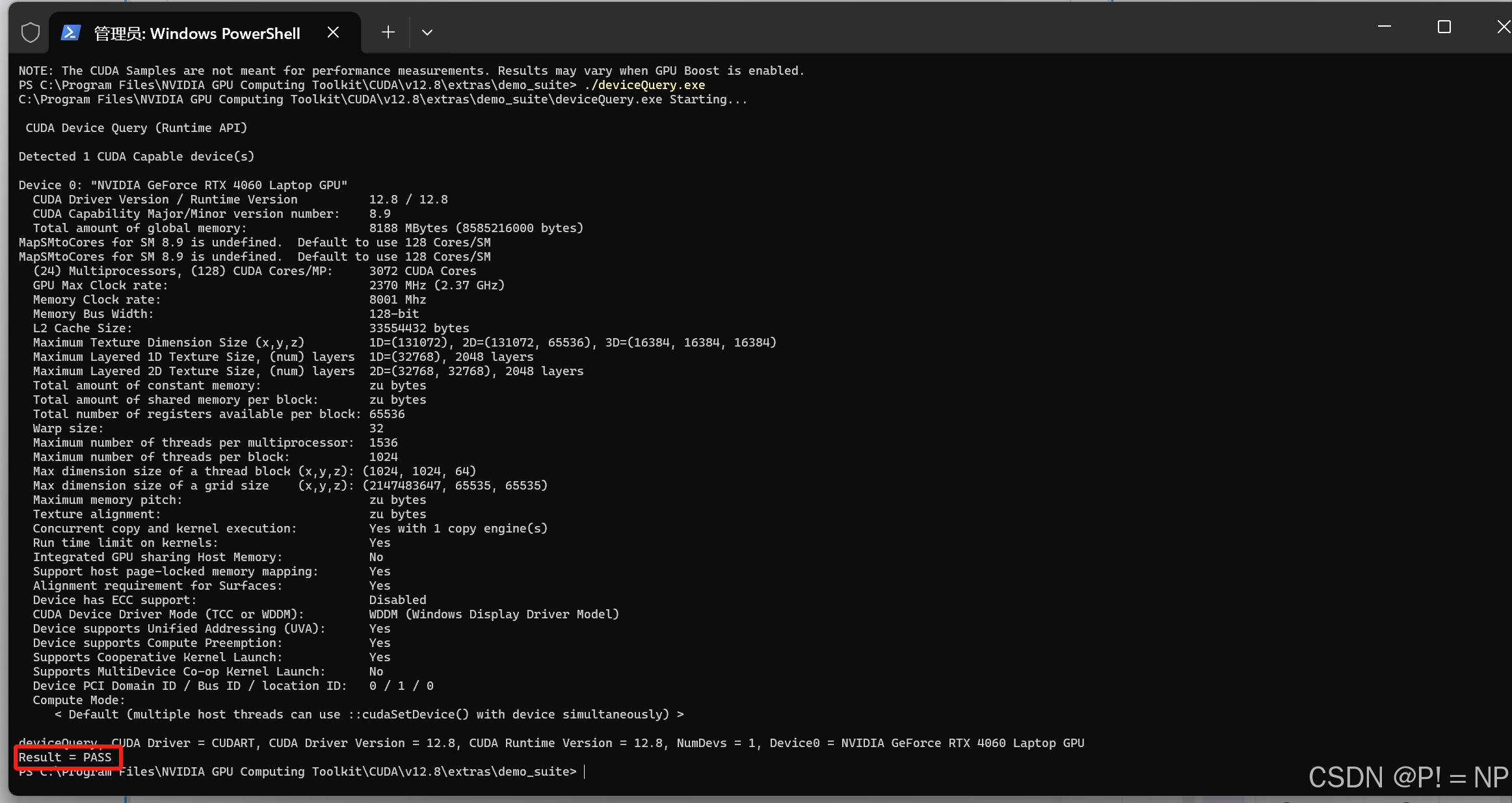

配置好后用 cmd 打开 C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.8\extras\demo_suite 目录,运行 bandwidthTest.exe 和 deviceQuery.exe,如果二者的 Result = PASS,那么 CUDA 安装成功

3.4 监听GPU的运作

新创建一个命令行窗口,执行命令 ollama ps 即可查看每个模型推理用到的设备是什么

4.配置Open WebUI环境

4.1 下载Docker

下载链接 https://docs.docker.com/desktop/setup/install/windows-install/

点击"Docker Desktop for Windows - x86_64"

下载完成得到如下.exe文件

4.2 启动微软 Hyper-V

使用gitcode上的项目“Win11家庭版部署 Hyper-V 命令文件” https://gitcode.com/open-source-toolkit/f7b9e 提供的脚本一部配置到位。

克隆得到如下目录

进入目录中,发现有名为“部署hyper-v-20230708.zip”的压缩包。将压缩包解压,并且进入解压后的目录“部署hyper-v-20230708”

发现该目录中有一个脚本“部署hyper-v-20230708.cmd”,以管理员身份运行该脚本

运行脚本之后,检查Windows工具是否多出了这两项,如果多出来,则 Hyper-V 启动成功

4.3 安装Docker

运行 Docker Desktop Installer.exe

勾选 Add shortcut to desktop,点击 OK 后等待安装

安装完成后点击Close

4.4 执行命令

在命令行运行以下命令后重启电脑,使得Docker可以正常工作

bcdedit /set hypervisorlaunchtype auto

如果执行命令后VMware虚拟机不可用,则需要执行以下命令再重启电脑

bcdedit /set hypervisorlaunchtype off

4.5 使用 Docker 安装 Open WebUI

在命令行中运行以下的命令

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

命令行的运行结果如下

之后需启动 Docker Desktop,再通过浏览器访问 http://localhost:3000 。

以下是初次进入 localhost:3000 时的界面,点击“开始使用”

输入相关信息创建账号,即可开始使用Open WebUI

点击左上角的模型名称可以切换模型,可切换的模型都是已部署到本地的模型

以后每次开机后,只需要启动Docker Desktop,再通过浏览器访问 http://localhost:3000即可进入Open WebUI。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)