deepseek本地(笔记本,集显)部署实战1

使用8B模型,提问冒泡排序,则能正确回答,不必给他程序员的角色指定。运行8b,一点担心就是笔记本风扇呼呼的转,直到问题结果输出完成才慢慢停下来,看来配置还是差了些!但似乎有时需要更多的提示词,比如,直接问它冒泡排序,它不懂,而是进行自我介绍,当告诉它作为一个程序员讲解冒泡排序时,则能正确给出解释输出。按默认选项安装即可,其中台式机安装提示不支持win7,要求win10以上,最终笔记本上安装Olla

现有资源

1)台式机:内存8/16g,独立显卡1g,win7

2)笔记本:内存16g,集成显卡,win11

思路

向网上的早鸟们学习,分步骤的实现本地部署和本地知识库搭建。目前主流安装步骤如下:

1)安装ollama;

2)通过Ollama下载deep seek,并使用;

3)安装chatbox,UI方式使用deep seek、构建智能体;

4)下载anything,挂在本地知识库;

5)dify,制作工作流和你本地知识库

6)coze,工作流;等等。

具体步骤:

a)下载ollama

官网下载(支持macos,linux和Windows三个系统,当前选择Windows版本)

结果:下载太慢,会断线;

解决:网上寻找Bai度网盘资源。按默认选项安装即可,其中台式机安装提示不支持win7,要求win10以上,最终笔记本上安装Ollama成功。

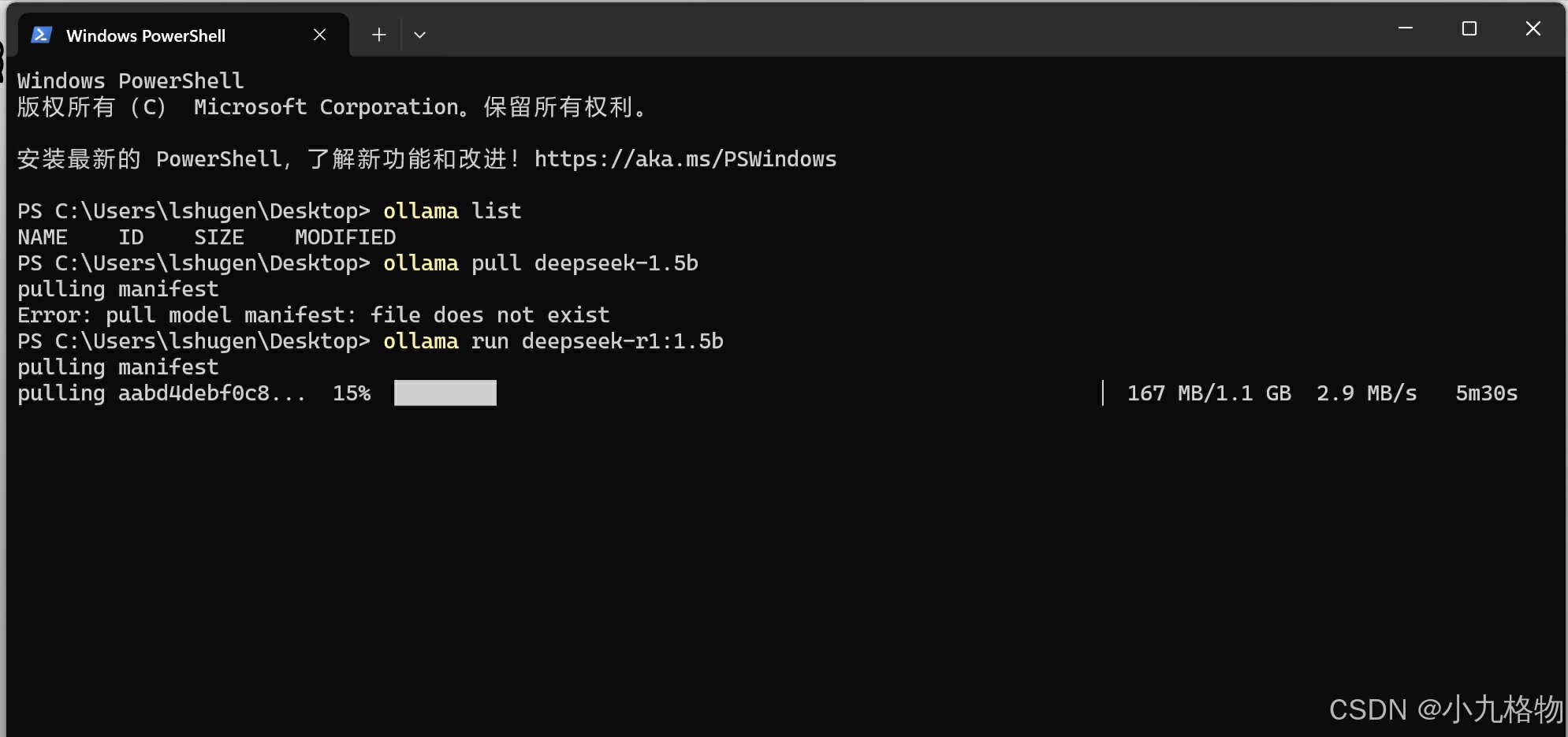

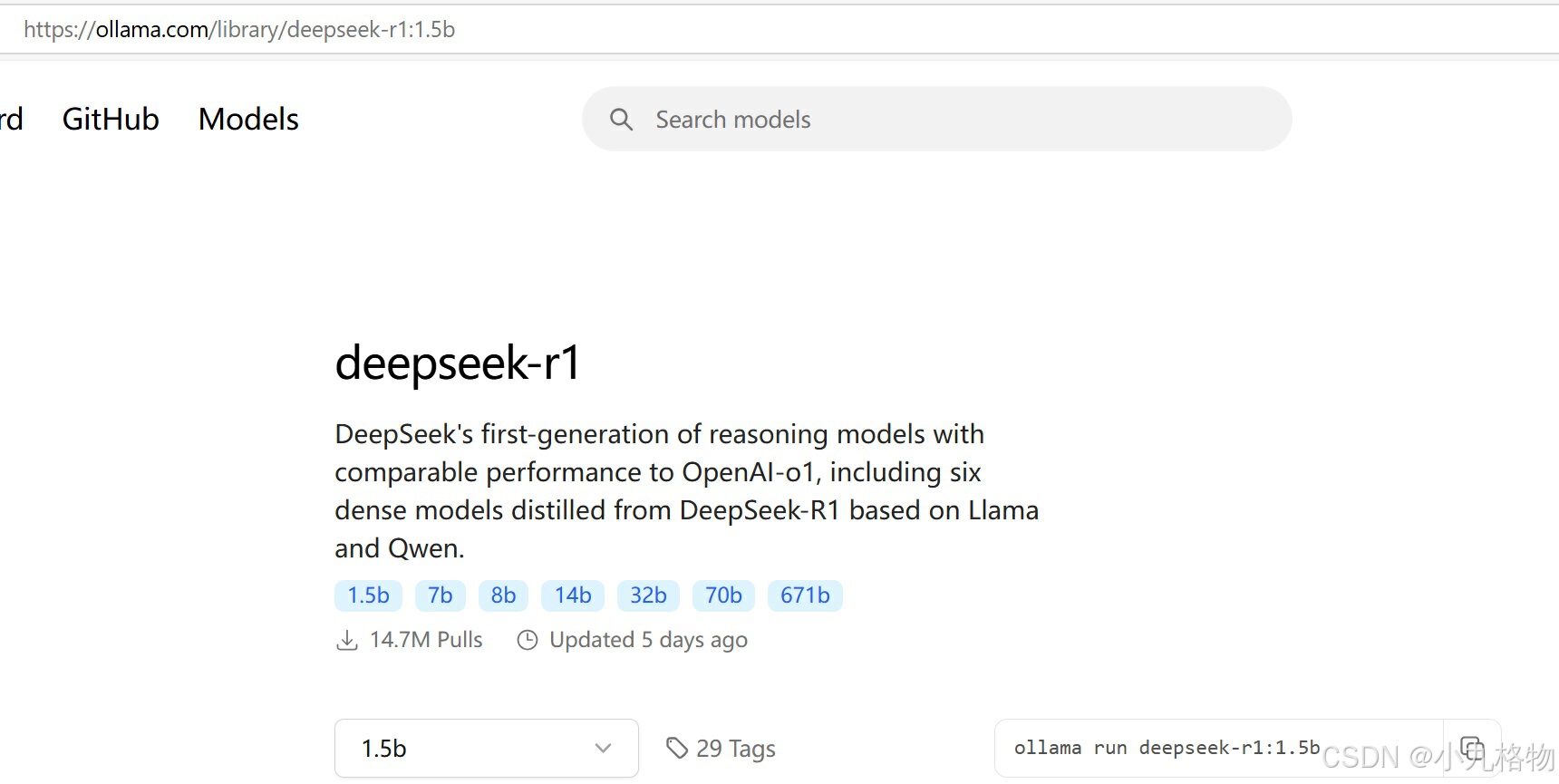

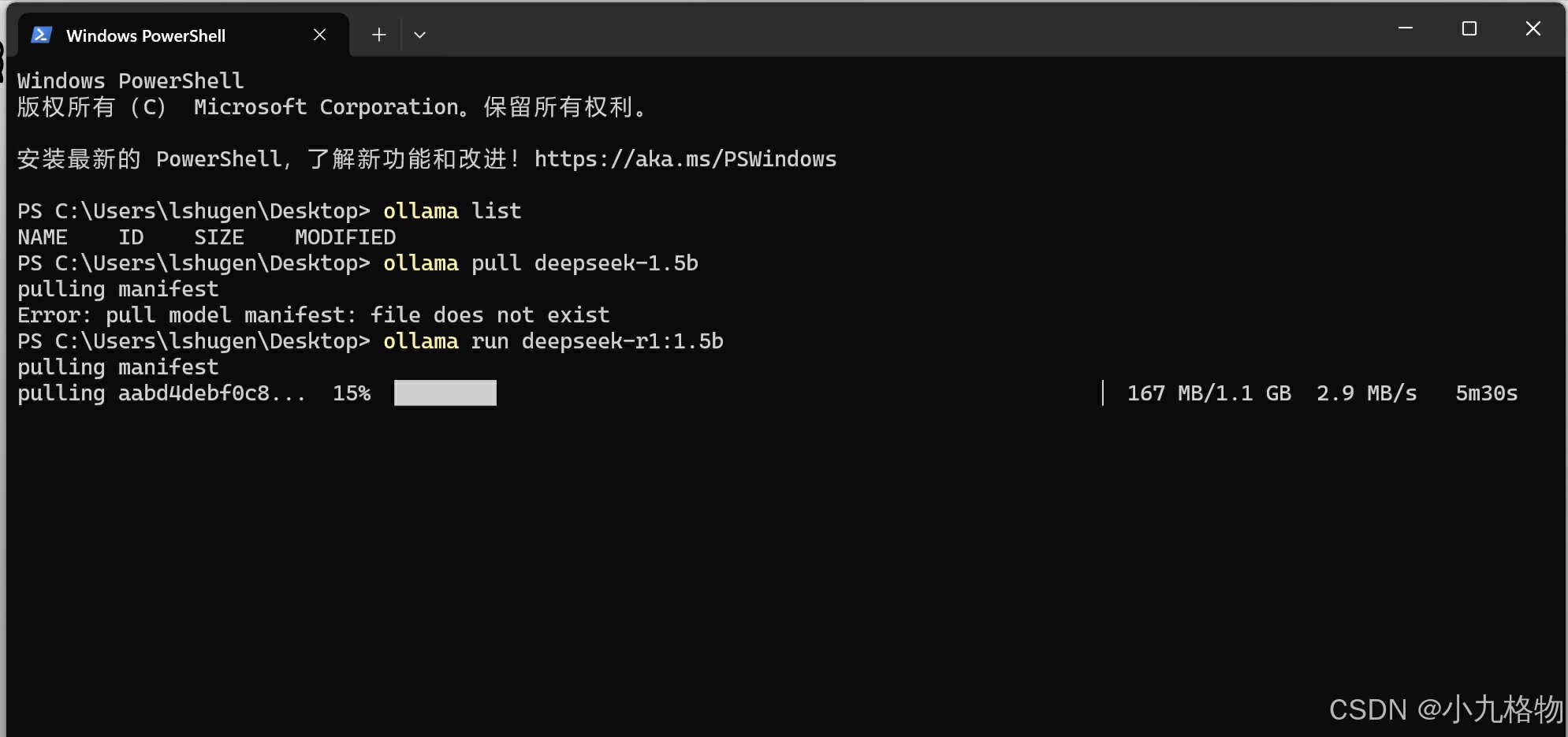

b)下载deep seek

因笔记本无独立显卡,考虑从最小版本(1.5b)开始,先跑通。

另外,直接向deep seek提问,当前配置适合选择哪个模型,结果也是建议1.5b。

【利用Ollama指令(直接从ollama官网复制)下载对应的模型,缺点是比较慢,好处是Ollama下载后基本不用配置直接可用】

安装后使用效果:

安装后使用效果:

初步可以使用,进行交互对话。但似乎有时需要更多的提示词,比如,直接问它冒泡排序,它不懂,而是进行自我介绍,当告诉它作为一个程序员讲解冒泡排序时,则能正确给出解释输出。【看来好的提示词系统可以提高命中率】

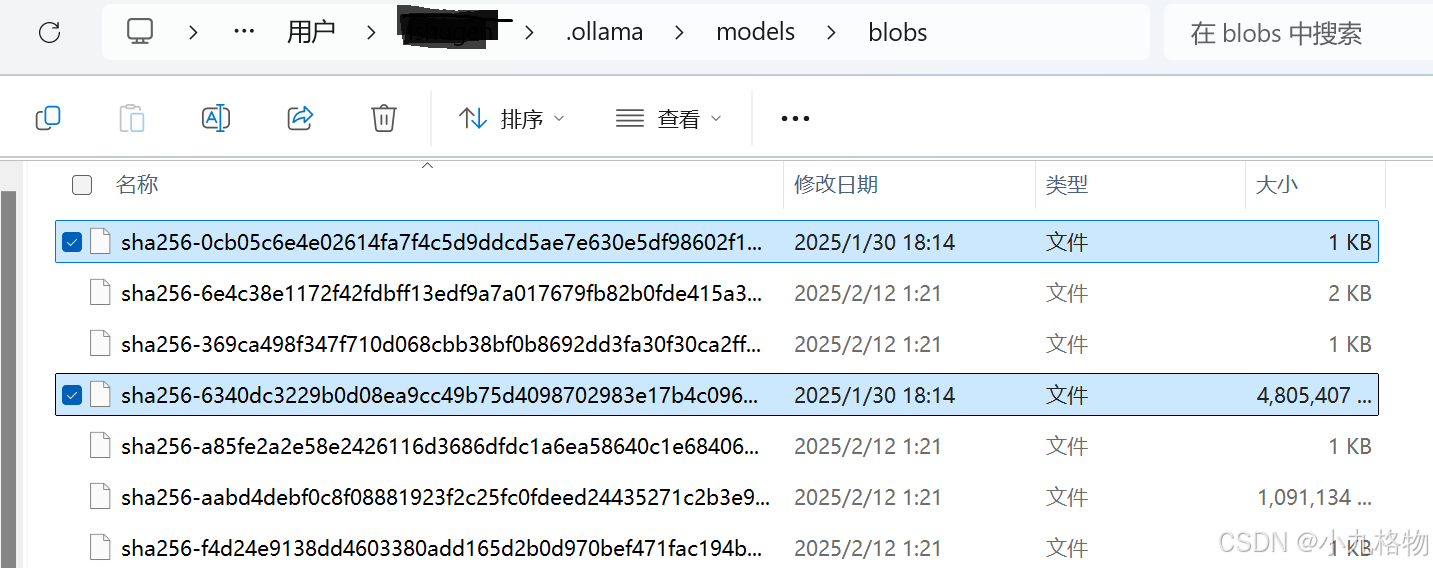

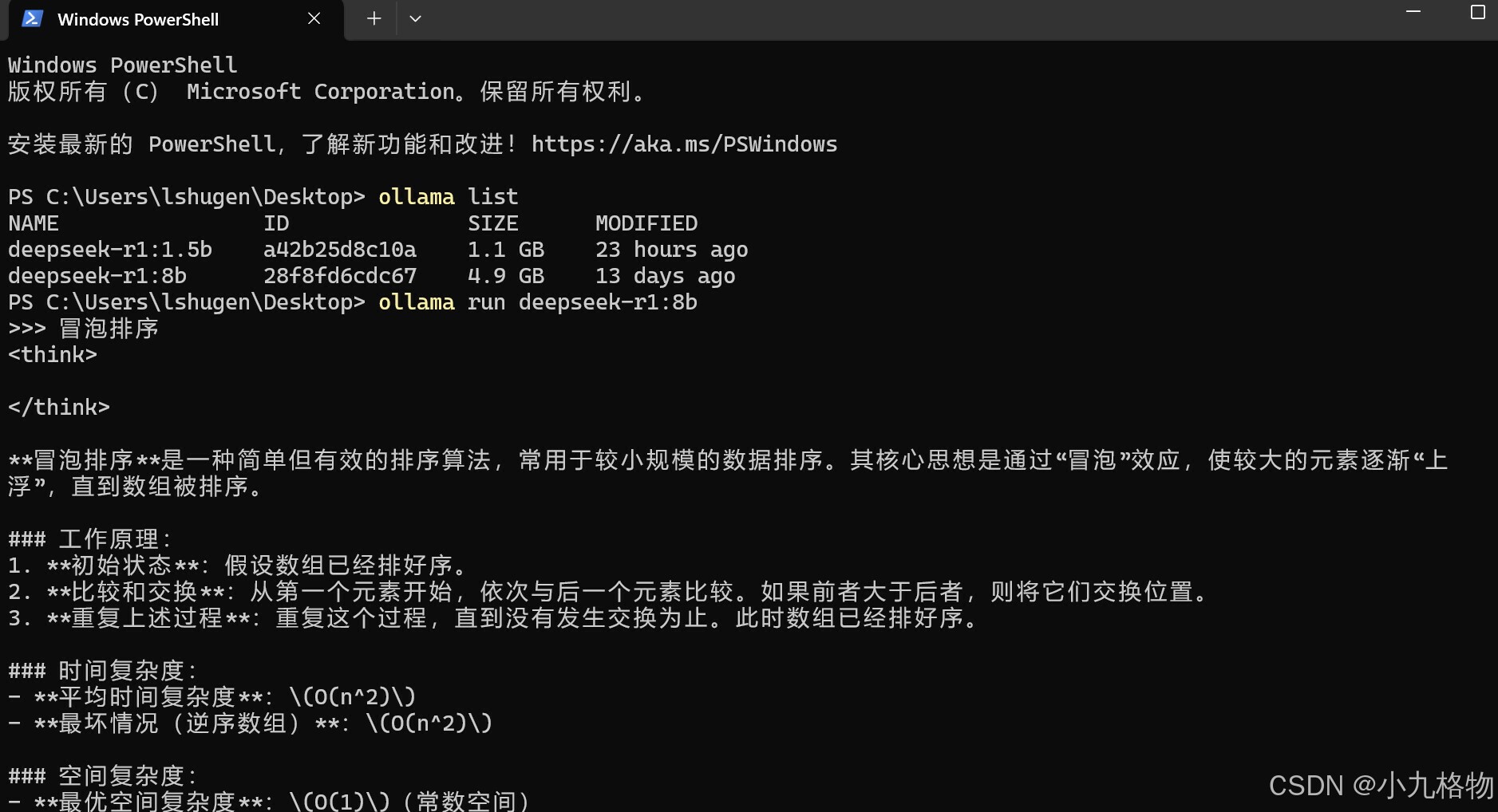

此外,尝试了8B模型的安装和使用,安装方式改为bai度网盘下载,直接复制到Ollama对应的目录

通过Ollama查询指令,发现已经成功安装8B模型。

【8B初步使用结果】

使用8B模型,提问冒泡排序,则能正确回答,不必给他程序员的角色指定。继续提问与1.5b的区别,回答很详细、全面。运行8b,一点担心就是笔记本风扇呼呼的转,直到问题结果输出完成才慢慢停下来,看来配置还是差了些!

【下一步】chatbox,anything,提示词、智能体、知识库...

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)