本地服务器部署deepseek(windows平台)

如果使用的是外部机器访问,需要关闭服务器防火墙,或者开放ollama的端口、选择的模型文件较大,下载的过程会比较长。安装完成之后,先不着急下载模型镜像,先配置环境变量,否则默认存储在C盘,模型镜像文件比较大。(3)OLLAMA_PORT=11434 这个变量允许我们更改Ollama的默认端口,默认端口是11434。下载完成之后,就可以实现python调用本地的部署deepseek模型,进行功能开发

1、进入Ollama官网,如下图点击下载。

下载完成之后,直接双击安装。默认安装在C盘。安装完成之后,先不着急下载模型镜像,先配置环境变量,否则默认存储在C盘,模型镜像文件比较大。

2、配置ollama环境变量

(1)OLLAMA_MODELS=D:\OllamaCache,这个变量指定了模型镜像的存储路径。避免C盘空间不足的问题。

(2)OLLAMA_HOST=0.0.0.0 这个变量定义了Ollama监听的网络接口。默认是127.0.0.1,只能本地访问。如果需要外部网络访问,配置成0.0.0.0

(3)OLLAMA_PORT=11434 这个变量允许我们更改Ollama的默认端口,默认端口是11434。

(4)OLLAMA_ORIGINS=* 表示允许所有来源的请求。如果设置为*,则表示不限制来源,允许任何请求访问服务。如果设置为具体的域名或IP地址,则只有这些指定的来源才能访问服务。

windows平台下配置完环境变量之后,需要重启之后,才生效。

3、下载deepseek下载模型镜像。

选择对应的模型,复制右侧的下载命令。打开CMD窗口,输入下载命令。

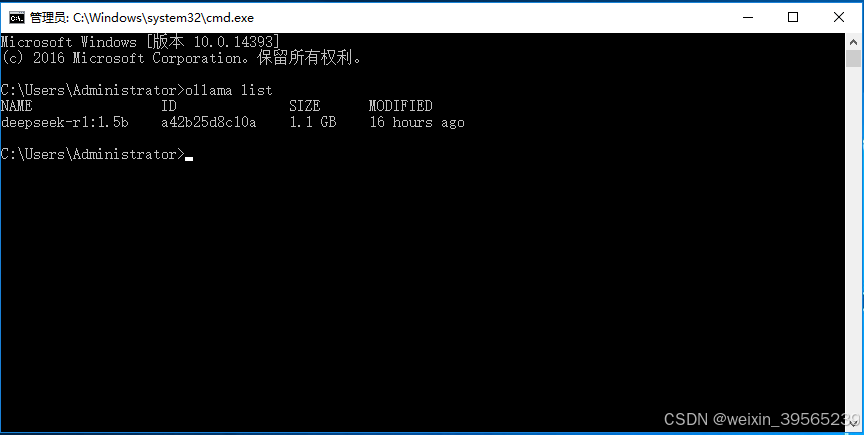

选择的模型文件较大,下载的过程会比较长。模型下载完成之后。在CMD输入ollama list命令,会显示下载成功的模型镜像。就可以正常使用了。

继续输入 ollama run deepseek-r1:1.5b 与以下载的模型对应。就可以正常使用deepseek AI模型了。

4、集成第三方客户端工具Cherry-Studio

自行去搜索Cherry-Studio工具,然后安装。配置如下。API地址为上述部署安装的服务器IP地址及端口。如果使用的是外部机器访问,需要关闭服务器防火墙,或者开放ollama的端口、

点击添加按钮,添加下载的模型。

以上配置完成之后,就可以使用对话窗口,与deepseek模型进行对话了。

5、集成Python开发应用

下载python ollama依赖库。

pip install ollama下载完成之后,就可以实现python调用本地的部署deepseek模型,进行功能开发。

from ollama import Client

def ollama():

client = Client(

host='http://192.168.200.216:11434', // 替换成本地部署的服务器ID及端口。

headers={'x-some-header': 'some-value'}

)

response = client.chat(model='deepseek-r1:1.5b', messages=[ // 与本地下载的模型对应。

{

'role': 'user',

'content': '写一遍300字的小品文,主题自拟',

},

])

print(response)

if __name__ == '__main__':

# 注意,run的第一个参数 必须是文件名:应用程序名

ollama()更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)