如何使用Ollama部署本地模型,如何部署本地DeepSeek-R1模型

如何使用Ollama部署本地模型,如何部署本地DeepSeek-R1模型

一.本地部署Ollama

1.Ollama介绍

Ollama是一个开源的大型语言模型部署服务工具,让用户能够轻松地在本地运行、管理和与大型语言模型进行交互,它不仅仅提供了现成的模型和工具集,还提供了一个简洁的 API,使得开发者能够轻松创建、运行和管理大型语言模型实例,降低了与模型交互的技术门槛。

2.Ollama下载

官网下载地址:Ollama

点击Download下载,无脑点击下一步即可,中间碰到安装路径可以改为其他盘

3.验证是否安装成功

安装成功后按下Win+R输入cmd然后回车,打开命令窗输入以下指令:

ollama -v

如上图所示,输入指令后输出ollama版本,这就安装成功了

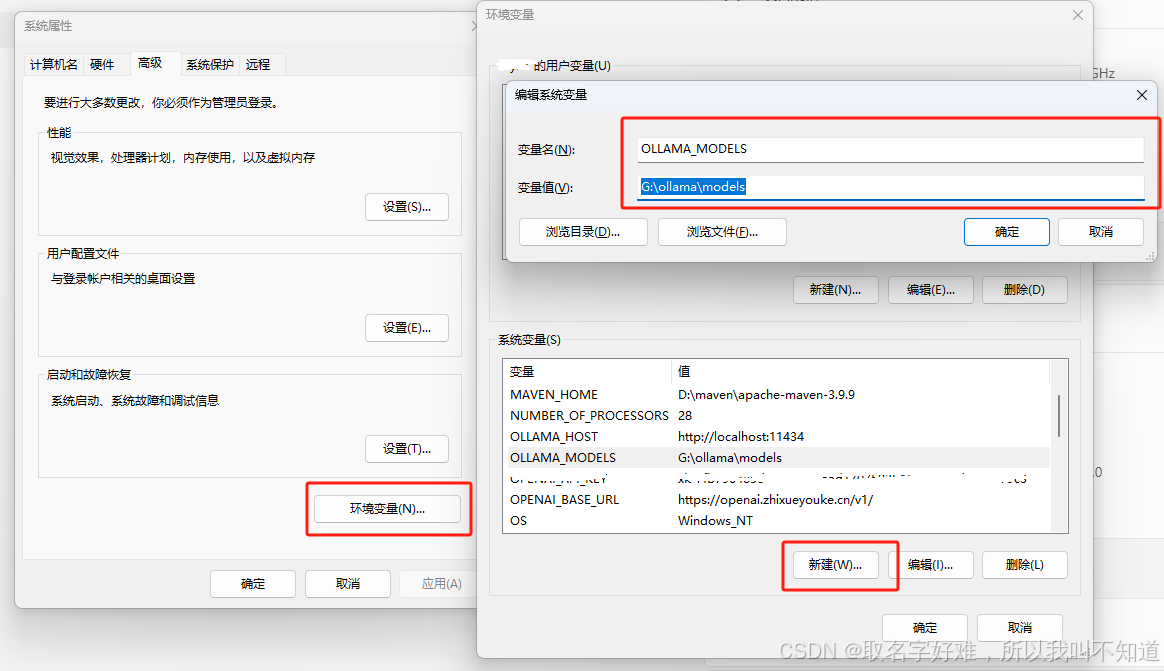

4.配置环境变量

ollama模型文件默认存储在C盘下,可以通过添加环境变量指定模型存储位置。打开系统管理界面,点击高级系统设置,

高级—>环境变量—>新建。

变量名写入:OLLAMA_MODELS

变量值写入:要存储模型文件的路径

之后点击确定就可以了

配置好环境变量后需要重启Ollama服务,win系统可以在进程中停止服务,右键桌面下方导航栏打开任务管理器

找到任务Ollama进程右击结束任务

进程结束后打开命令窗口执行以下命令重新启动Ollama服务:

ollama list

该命令用于列出本机上的模型,使用ollama命令会启动ollama桌面应用程序使用其他命令也是可以的。

ollama serve想要启动ollama而不运行桌面应用程序时使用。

更多ollama命令可以查阅官网地址:https://github.com/ollama/ollama/blob/main/README.md#quickstart

5.拉取deepseek-r1模型并与模型进行对话

更多模型地址:Ollama Search

命令窗口中通过执行下方命令拉取模型到本地,我本次拉取模型为deepseek-r1:1.5b示例

注意:对于不会使用梯子的小伙伴,网络不太好的话可能会下载失败,多试几次看看

ollama pull deepseek-r1:1.5b

该命令将会运行deepseek-r1:7b的模型,将deepseek-r1:7b替换为你自己的本机模型名称,可以使用ollama list来查看本机模型列表

ollama run [模型名称]

这样就可以开始对话了。

如何使用python调用deepseek点击这里查看

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)