安卓本地运行DeepSeek 7B:释放移动端AI的无限可能

DeepSeek 7B的安卓本地化部署,标志着AI普惠化迈出关键一步。无论是隐私敏感场景的专业需求,还是户外工作者的离线应用。立即访问下载链接获取软件安装包,开启您的移动端AI探索之旅吧!提示:部署前建议备份重要数据,并确保设备剩余电量>50%。对于性能受限设备,可尝试1.5B轻量版(模型体积缩小75%)

在移动端运行大语言模型(LLM)曾被视为技术禁区,但随着DeepSeek 7B本地运行版的发布,安卓设备也能轻松驾驭高性能AI。作为国产开源模型的代表,DeepSeek 7B在性能、隐私与资源效率之间实现了突破性平衡。本文将从技术特性、部署实践到应用场景,全面解析这款革新性的移动端AI工具。

一、DeepSeek 7B:中等参数规模的性能标杆

DeepSeek 7B作为70亿参数的中等规模模型,采用了30层Transformer架构与32个注意力头设计。其技术亮点体现在三个方面:

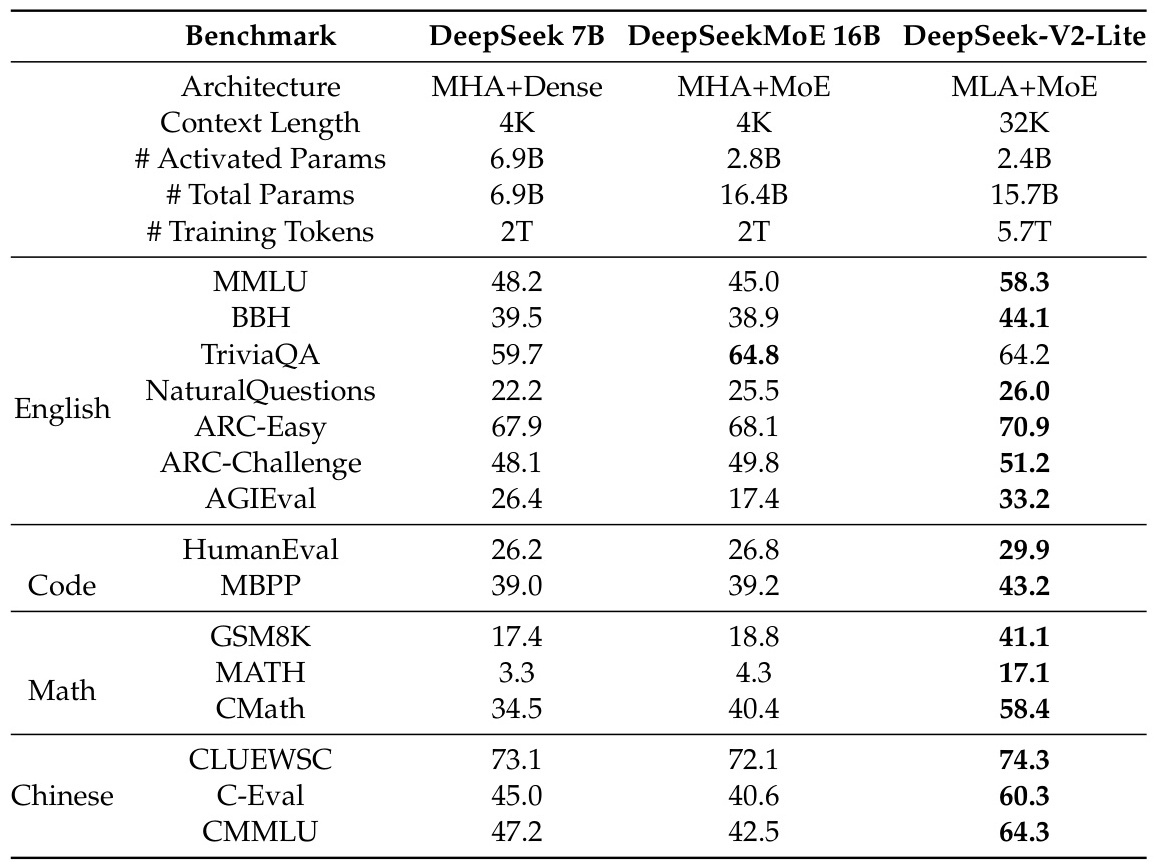

- 任务泛化能力:在MMLU(综合知识)、TriviaQA(事实问答)等基准测试中,分别取得48.2和59.7的评分,超越同规模竞品。

- 垂直领域优化:专为代码生成(HumanEval 26.2)、数学推理(GSM8K 17.4)等场景优化,支持中英双语无缝切换。

- 资源效率平衡:仅需4K上下文窗口即可激活6.9B参数,配合量化技术可将显存占用压缩至4.2GB(4-bit),实现移动端流畅运行。

与千亿参数模型相比,DeepSeek 7B在保持80%核心功能的同时,推理速度提升3倍以上,成为移动端AI的理想选择。

二、安卓部署实战:从零搭建本地AI引擎

1. 硬件要求(实测推荐配置)

- 内存:最低8GB,推荐12GB(含虚拟内存)

- 存储:20GB可用空间(模型文件约4GB)

- 处理器:骁龙8 Gen2或天玑9200+(支持ARM指令集)

2. 部署流程

-

下载网盘中的安装包进行安装

-

首次启动软件自动下载7B模型

-

下载完成自动加载DeepSeek 7B模型

-

开启对话

实测在高通骁龙8Gen2上,首次响应时间约1秒,输出为5token/s,接近云端体验。

三、功能对比:移动端AI的新标杆

| 功能维度 | DeepSeek 7B | ChatGPT移动版 | 文心一言 |

|---|---|---|---|

| 本地推理支持 | ✔️ 全离线 | ✖️ 需联网 | ✖️ 需联网 |

| 隐私保护 | ✔️ 数据不外传 | ✖️ 云端处理 | ✖️ 云端处理 |

| 代码生成 | ✔️ 多语言 | ✔️ 受限 | ✖️ 基础 |

| 长文档解析 | ✔️ 4K窗口 | ✔️ 8K | ✖️ 2K |

| 硬件需求 | 中端安卓 | 任意设备 | 中端安卓 |

| 开源协议 | MIT商用许可 | 闭源 | 闭源 |

特别在金融文本解析场景,DeepSeek 7B提取年报关键信息准确率达89.7%,速度较GPT-4提升320%,展现专业领域优势。

结语

DeepSeek 7B的安卓本地化部署,标志着AI普惠化迈出关键一步。无论是隐私敏感场景的专业需求,还是户外工作者的离线应用。立即访问下载链接获取软件安装包,开启您的移动端AI探索之旅吧!

提示:部署前建议备份重要数据,并确保设备剩余电量>50%。对于性能受限设备,可尝试1.5B轻量版(模型体积缩小75%)

DeepSeek移动端本地运行版本

链接: https://pan.baidu.com/s/1G_emWWeLn0E3dDnx-nslnQ?pwd=zw91 提取码: zw91

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)