《1小时搞定!从零到一:用DeepSeek搭建私人AI助手!零基础跑通AI大模型》

本地部署Deepseek全指南:基于Ollama+Chatbox实现私有化AI助手

一、引言

听说你还在用云端AI服务?每次提问都像在动物园隔着玻璃看AI表演——得联网、排队、还要忍受“当前服务繁忙”的告示牌?是时候给你的电脑来一场AI大解放运动了!

本地部署Deepseek的三大爽点:

隐私保护:你的问题再也不会被云端管理员当成八卦素材(想象一下AI在服务器吐槽:“用户今天又问我怎么追女神了”)。

离线狂飙:就算外星人炸了互联网,你还能和AI讨论《三体》生存指南。

为所欲为:给AI起名叫“二狗子”也不会被平台审核(正经人谁用官方命名啊!)

二、 不说废话,直接上干货

下载什么?(重点)

Ollama;Chatbox

为什么下载这两样?

1、为什么需要Ollama?

——因为它让你在家就能开“AI动物园”,还不用买门票!

想象一下,你突然想养一只「70亿参数」的AI宠物(比如Deepseek),但云端大模型就像去动物园看老虎——得联网、排队、还要担心管理员(服务器)突然下班。而Ollama就是你家的「魔法冰箱」,功能包括:

①本地驯兽师:直接在你电脑里运行大模型,半夜灵感突袭也不用求云服务开门

②模型自助餐:一条命令就能投喂不同模型(ollama pull llama3 = 给冰箱塞进一只羊驼)

③跨平台遛弯:Windows/macOS/Linux 三栖生存,连树莓派都能勉强当猫窝

2、为什么需要Chatbox?

——因为不是所有人都想和AI用摩斯密码聊天!

如果你觉得在命令行里敲代码对话,像在用电报机调戏AI,Chatbox就是你的「AI智能点餐机」:

①颜值担当:按钮比命令行参数可爱100倍,支持一键换皮肤(黑暗模式保护深夜程序员的眼睛)

②会话管理大师:聊天记录自动存档,再也不怕灵感像金鱼记忆一样消失

③防手残设计:自带预设提示词模板,拯救「输入“你好”后大脑死机」患者

3、为什么是他两?

当Ollama遇到Chatbox,就像…

①蝙蝠侠+阿尔弗雷德:一个负责在后台默默干活(Ollama运行模型),一个在前台优雅待客(Chatbox交互)

②火锅+蘸料:Ollama是沸腾的锅底(计算核心),Chatbox是你调配的独家酱料(交互体验)

③程序员+咖啡机:一个24小时待命处理代码,一个让你用最懒的姿势获得精神食粮

警告:

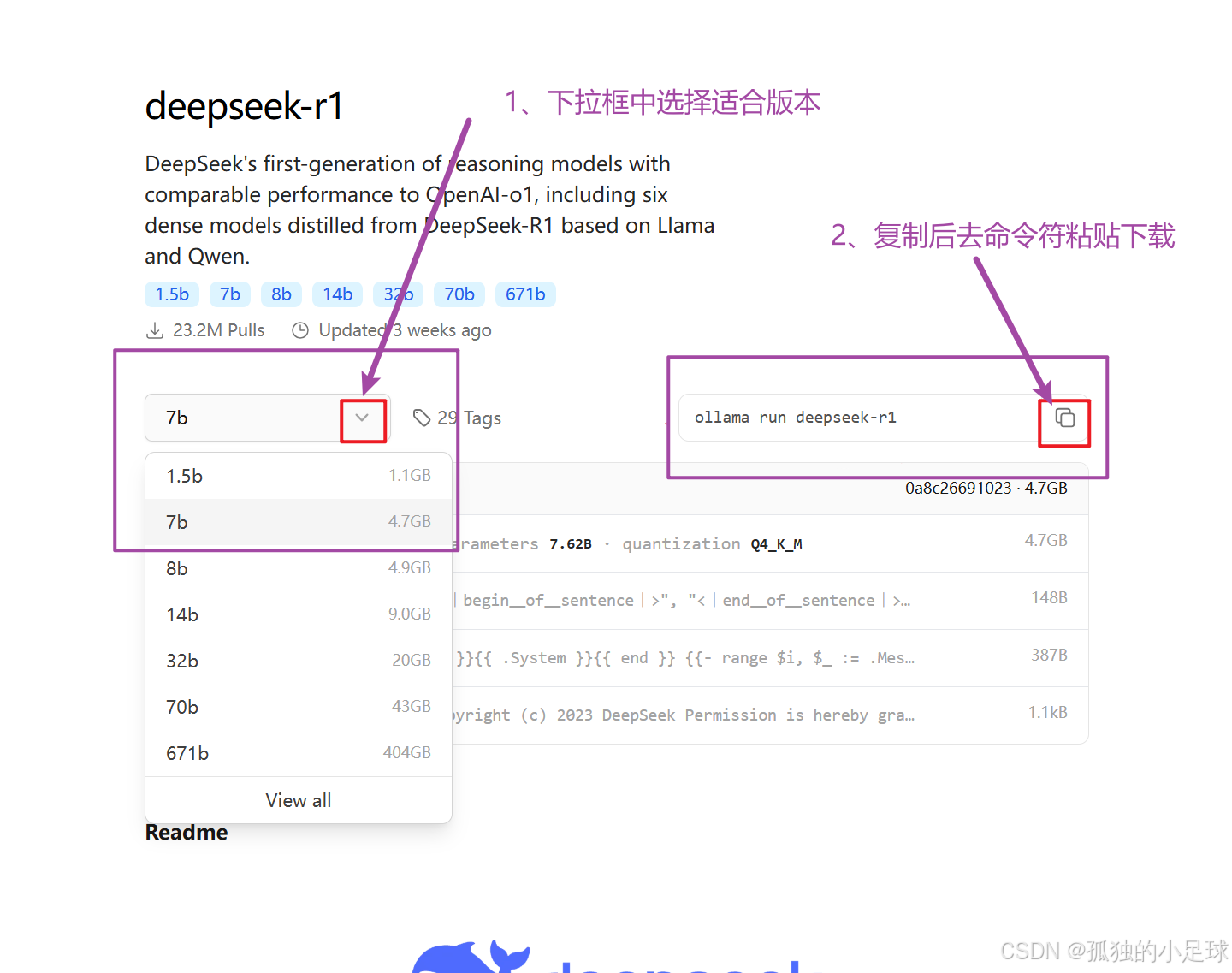

小心Ollama吃光你的显卡零食(显存)!按照下图选择所需参数模型!

Chatbox的界面可能让你忘记自己其实在搞严肃AI研究(误以为在玩模拟经营游戏)

总之,这俩活宝组合让你:

✅ 摆脱联网焦虑(断网也能玩AI)

✅ 告别命令行恐惧(图形界面拯救手残党)

✅ 实现中二幻想(给自己的AI起名“赛博神龙”)

——而且完全免费,不用卖肾买会员! 🎉

根据自己电脑配置选择即可,我是NVIDIA RTX 3070Ti,使用1.5b和7b都可。

三、宝宝级下载教程

Ollama:

https://ollama.com/

认准小羊驼!

找到下载后的文件夹,打开。

点击Install安装,默认会安装到C盘,后续会教你怎么更改路径。

安装完成后,右下角任务栏会生成小羊驼头像。

手动更改路径并配置环境变量!(为了方便大家,我会以自己安装路径为模板并附上图,UU们自行对比安装哦)

1、在E盘新建Ollama文件夹,并手动创建三个子文件夹→models(模型),logs(日志),exe(程序文件)。

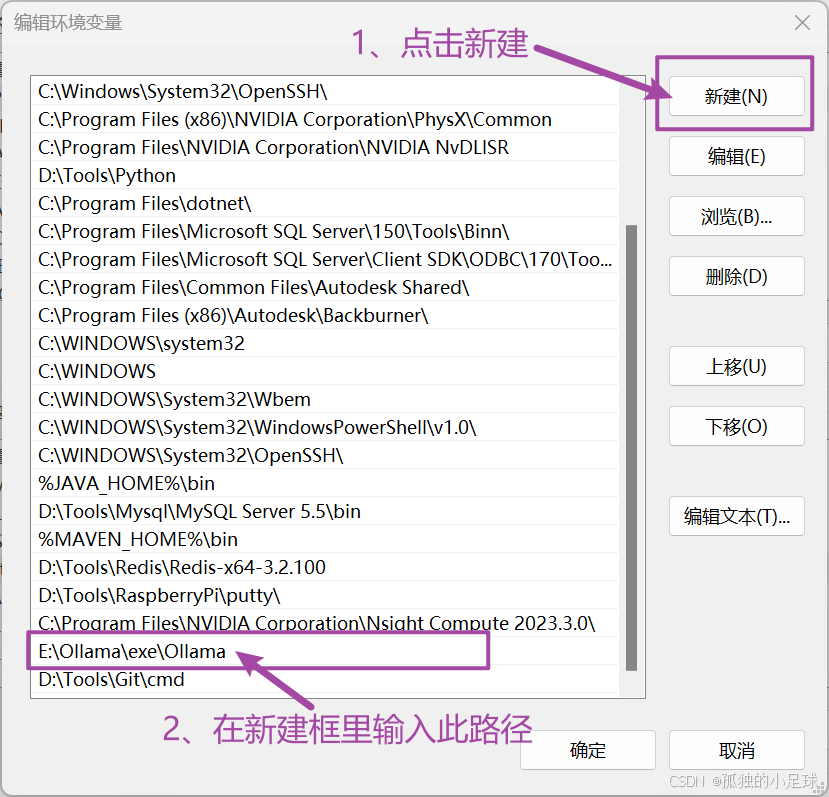

2、打开环境变量,跟着下图操作↓。

随后一路确定即可!

重点来喽!!!

首先将桌面右下角的Ollama关掉(必须关掉再进行后续操作!)

找到Ollama在C盘的默认安装路径(有三处),分别将其剪切至E盘新建的三个子文件夹。(这儿是剪切,省去了删除原C盘的操作,更加一步到位,但是前提是先关掉桌面右下角的Ollama!)

①C:\Users\Administrator.ollama-------→E:\Ollama\models

②C:\Users\Administrator\AppData\Local\Ollama-------→E:\Ollama\logs

③C:\Users\Administrator\AppData\Local\Programs\Ollama-------→E:\Ollama\exe

接下来我们要使用**“软连接”**的方式——软连接(符号链接,Symbolic Link)是文件系统中的一种特殊文件,类似于“快捷方式”。它的核心价值在于用轻量级引用代替实际文件操作,可跨越不同磁盘分区、甚至网络存储创建链接,突破物理存储限制。

**说人话:**是为了让电脑认为Ollama的文件还在C盘,但实际上已经被我们转移了,这样做是为了节省C盘空间且不影响程序正常运行。具体做法如下:

打开命令提示符,以管理员身份运行,依次输入如下命令(对比下图,按着自己的用户名修改!!!):

mklink /D C:\users\xqj.ollama E:\Ollama\models

mklink /D C:\users\xqj\AppData\Local\Ollama E:\Ollama\logs

mklink /D C:\users\xqj\AppData\Local\Programs\Ollama E:\Ollama\exe

这样就好啦,你会发现C盘中出现如下小箭头标标(就是它成为快捷方式啦):

验证是否安装成功:

win+R,输入cmd打开命令提示符:

ollama --version

这样就代表成功喽!

那么,至此就可下载大模型了!

仍然是打开Ollama官网https://ollama.com/download,点击Models。

等待下载完成。(如果提示错误检查有没有启动Ollama服务)

至此Ollama就加载deepseek本地部署成功啦!!!

Chatbox:

进去后点击免费下载,安装到自己想要安装的盘后,仍然是先关闭Ollama

编辑环境变量↓

完成后一路确定!!

环境设置完成后打开安装好的Chatbox

至此,就全部完成了。

四、结语

有任何问题欢迎留言,UU们一起进步!

本地部署AI模型不仅解决了数据隐私的痛点,更为开发者提供了定制化创新的土壤。经实测,在RTX 3060显卡上,Deepseek-7B可实现每秒18 tokens的生成速度,满足大部分场景需求。建议定期关注Ollama的GitHub仓库更新日志,获取最新性能优化特性。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)