本地离线部署 deepseek

(可选)环境准备:docker-compose 自行下载rocky-linux or kylin-v10。docker-compose up -d后 查看 docker-compose ps。(这里可以选择多个语言模型进行下载比如亚马逊 微软 谷歌的都能下载)1. 部署 ollama 大模型框架 和web 方式的 对话框。下载完毕后退出就可以了因为我们通过web 的方式进行对话。说明:左边是开源后

docker-compose + ollama + open-webui + deepseek-r1:1.5b

(可选)环境准备:docker-compose 自行下载 rocky-linux or kylin-v10

1. 部署 ollama 大模型框架 和web 方式的 对话框

services:

ollama:

user: root # 为了避免一些权限问题 在这我使用了root

restart: always # 重启方式

image: xxxx/pub/ollama/ollama

container_name: ollama

ports:

- "8083:8000"

environment:

- TZ=Asia/Shanghai

- OLLAMA_HOST=0.0.0.0:8000

- OLLAMA_MODELS=/data/models

volumes: # 卷挂载路径

- /data/docker-data/ollama:/data/models

healthcheck:

test: ["CMD", "curl", "-f", "http://localhost:8000"]

interval: 30s

timeout: 10s

retries: 3

open-webui:

#user: root # 为了避免一些权限问题 在这我使用了root

restart: always # 重启方式

image: xxxx/pub/open-webui

container_name: open-webui

ports:

- "8084:8080"

environment:

- OLLAMA_BASE_URL=http://xxxxxxxx:8083 #ollama的地址

- TZ=Asia/Shanghai

volumes: # 卷挂载路径

- open-webui:/app/backend/data

volumes:

open-webui: #目前测试 必须使用 动态卷分配的方式 要不启动报错docker-compose up -d 后 查看 docker-compose ps

2. 查看 下载大模型的框架

列表 大模型语言 (这里可以选择多个语言模型进行下载 比如亚马逊 微软 谷歌的都能下载)

说明:左边是开源后的大模型语言版本 右边是下载命令

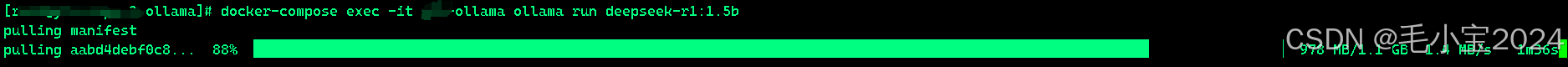

3. 使用docker 命令进行 下载

docker-compose exec -it ytx-ollama ollama run deepseek-r1:1.5b

下载完毕后退出就可以了 因为我们通过web 的方式进行对话

4.部署完成测试效果:

访问: http://xxxx.com:8084

对话测试效果

轻松搞定

附件:

1. docker pull ollama/ollama:latest

2.文档

docker pull ghcr.io/open-webui/open-webui:main

-- 直接用docker 启动的 如下:

docker run -d -p 3000:8080 -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)