【AI论文】Logic-RL: 利用基于规则的强化学习释放大型语言模型的推理能力

受DeepSeek-R1成功的启发,我们探索了基于规则的强化学习(RL)在大型推理模型中的潜力。为了分析推理动态,我们使用了合成逻辑谜题作为训练数据,因为它们的复杂性可控且答案验证直接明了。我们提出了一些关键的技术贡献,从而实现了有效且稳定的RL训练:一个强调思考和回答过程的系统提示、一个严格的格式奖励函数(对走捷径的输出进行惩罚),以及一个简洁的训练方案,该方案能够实现稳定的收敛。我们的70亿参

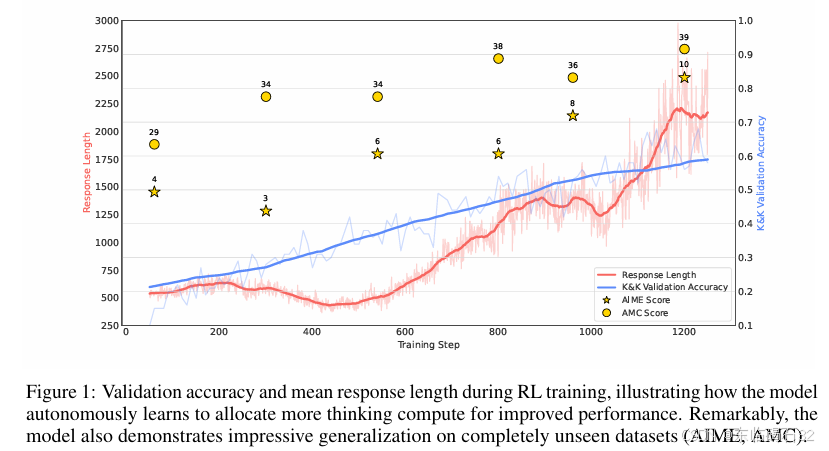

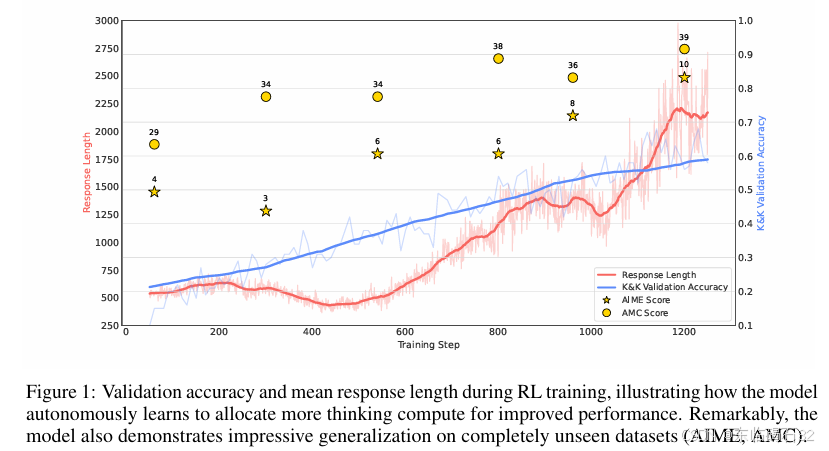

摘要:受DeepSeek-R1成功的启发,我们探索了基于规则的强化学习(RL)在大型推理模型中的潜力。为了分析推理动态,我们使用了合成逻辑谜题作为训练数据,因为它们的复杂性可控且答案验证直接明了。我们提出了一些关键的技术贡献,从而实现了有效且稳定的RL训练:一个强调思考和回答过程的系统提示、一个严格的格式奖励函数(对走捷径的输出进行惩罚),以及一个简洁的训练方案,该方案能够实现稳定的收敛。我们的70亿参数模型发展出了高级推理技能,如反思、验证和总结,这些技能在逻辑语料库中并不存在。值得注意的是,在仅训练了5000个逻辑问题后,该模型就展现出了对具有挑战性的数学基准测试AIME和AMC的泛化能力。Huggingface链接:Paper page,论文链接:2502.14768

1. 引言

- 研究背景:大型语言模型(LLMs)的后训练阶段取得了显著进展,如DeepSeek-R1等模型展示了强大的推理能力。这些模型通过基于规则的强化学习(RL)方法,实现了无需传统脚手架技术(如蒙特卡罗树搜索MCTS或过程奖励模型PRM)的推理模式。

- 研究动机:尽管DeepSeek-R1等模型取得了成功,但将这些进展转化为可复现的研究仍存在较大差距。DeepSeek-R1虽然提供了开源模型权重,但未发布相应的训练代码或数据集,这引发了一系列问题,如小规模模型是否能获得类似推理能力、何种训练数据结构最优、以及如何可靠地复制这些结果。

- 研究贡献:本文引入了Logic-RL框架,通过基于规则的强化学习在逻辑谜题上训练模型,获得了与R1类似的推理模式。关键贡献包括强调思考和回答过程的系统提示、严格的格式奖励函数,以及实现稳定收敛的直观训练方案。

2. 方法

2.1 数据合成

- Knights and Knaves(K&K)谜题:K&K谜题是一种算法生成的推理数据集,其中角色分为总是说真话的骑士和总是说谎的骗子。谜题的目标是根据角色的陈述确定每个人的身份。

- 数据特点:

- 程序化生成:谜题通过逻辑模板系统生成,确保一致性和无限可变性,是测试模型泛化能力的理想数据。

- 难度可控:通过调整角色数量(2-8人)和逻辑运算复杂度(1-4个布尔运算符组合),可以精确控制谜题难度,便于设计课程学习策略。

- 易于验证:每个谜题都有唯一的正确答案,且答案的正确性由生成算法保证,便于准确评估模型响应,减少奖励黑客攻击的风险。

2.2 基于规则的奖励建模

- 系统提示:模型被要求以<think></think>标签包含推理过程,以<answer></answer>标签提供最终结论。这种结构化响应格式有助于引导模型进行逻辑推理。

- 奖励函数:

- 格式奖励:使用正则表达式提取来强制执行结构化响应格式。正确的格式得分为1,错误的格式得分为-1。

- 答案奖励:在格式验证通过后,检查模型答案是否与真实答案完全匹配。完全匹配的答案得分为2,部分不匹配的答案得分为-1.5,无法解析或缺失的答案得分为-2。

- 奖励黑客攻击:在早期不完美的规则设计下,观察到多种奖励黑客攻击现象,如跳过思考过程直接回答、在答案标签中包含推理等。通过迭代细化规则设计,确保不同行为根据其对格式的遵守程度获得适当奖励。

2.3 RL算法

- REINFORCE++算法:采用REINFORCE++算法作为基线算法,并在其基础上进行了几项改进。

- KL损失:将RL模型与SFT模型响应分布之间的KL散度作为PPO训练期间的奖励函数中的惩罚项。

- KL估计:使用GRPO中的无偏KL散度估计器,确保KL估计值始终为非负,提供更稳定可靠的发散度量。

2.4 训练计划

- 训练参数:直接训练模型3600步,学习率为4×10^-7,温度参数为0.7。模型直接暴露于混合复杂度的逻辑谜题中,范围从3人到7人。

- 训练效果:通过固定超参数的连续训练,模型发展出稳定的推理模式,包括逻辑探索、中间验证和系统总结,在最终答案生成前展现出复杂行为。

3. 实验

3.1 模型选择

- 基线模型:从Qwen2.5系列中选择了多个模型作为基线候选,最终选择了Qwen2.5-7B-Instruct-1M作为基线模型,因其稍高的测试准确性。

- 训练效果:尽管训练数据集仅限于3到7人的K&K逻辑谜题,且合成样本少于5000个,但模型展示了对8人谜题等分布外(OOD)场景的显著泛化能力。

3.2 复杂推理行为

- 推理行为分析:随着训练步骤的增加,模型输出长度几乎线性且稳定地增加到2000个令牌,是初始平均长度的4倍。这种增长伴随着模型更复杂的行为,如反思和替代解决方案的探索。

- 特定词汇影响:包含“verify”和“re-evaluate”等词汇的响应得分显著高于不包含这些词汇的响应,而包含其他语言词汇的响应得分较低。这表明复杂推理行为和语言混合对推理能力有显著影响。

4. 研究问题

4.1 GRPO与其他RL算法的比较

- 实验结果:PPO在准确性和奖励方面表现出显著优势,但训练速度比REINFORCE++慢138%。REINFORCE++在训练稳定性、性能增益和训练效率方面优于GRPO。总体而言,REINFORCE++在几乎所有指标上都优于GRPO。

4.2 特定思考词汇和语言混合现象对推理的影响

- 语言混合:语言混合显著降低推理能力。

- 复杂思考词汇:如“verify”和“re-evaluate”显著提高推理能力,而“recheck”等词汇则降低推理能力。

4.3 “啊哈时刻”的出现

- 实验观察:尽管模型在训练过程中展现出复杂的推理行为,但没有观察到突然的“啊哈时刻”。这些行为随着性能增长而逐渐显现,表明复杂推理行为并非在特定训练步骤中突然涌现。

4.4 模型对分布外任务的泛化能力

- 泛化能力:模型在AIME和AMC等具有严格和多样问题集的数学基准测试上表现出色,显示出强大的分布外泛化能力。这表明RL训练过程中学到的推理技能超越了K&K数据集的特定模式。

4.5 SFT与RL的泛化能力比较

- 实验结果:SFT主要学习表面的答案格式,而RL鼓励模型独立探索,培养源于增强推理能力的泛化能力。在相同的记忆分数区间内,RL在测试准确性上显著优于SFT。

4.6 课程学习在RL中的必要性

- 实验比较:课程学习与混合难度训练在测试分数上的差异在早期训练阶段统计上可忽略不计,表明课程学习的实际必要性未得到明确支持。

4.7 响应长度与推理能力的关系

- 实验分析:响应长度的增加并不总是保证更好的推理能力。增强的推理能力可能自然导致更详细的解释,但人为延长响应长度并不一定会导致比例性的性能提升。

5. 讨论与未来工作

- 小规模数据集:尽管本文研究在小规模逻辑数据集上展示了Logic-RL的潜力,但其在大规模现实世界数学或编码场景中的可泛化性仍有待探索。

- 长期思考方法:为了提高处理冗长输出的效率和有效性,探索将长响应转换为更短、更易消化的格式的方法具有重要意义。

- 稳定RL训练:计划进一步研究SFT阶段对RL训练有效性和效率的影响,以及在不同情况下消除KL约束的益处。

- 混合语言推理:观察到模型在<think>部分频繁使用中文标记的现象,计划调查代码切换或随机标记切换是否能系统地辅助内部推理。

- 放松格式约束:尽管<think>...</think>有效地组织了思考链,但完全无约束或潜在的方法是否可能产生更好的结果仍是一个开放问题。

6. 结论

本文通过引入Logic-RL框架,展示了基于规则的强化学习在大型语言模型推理能力开发中的巨大潜力。通过合成逻辑谜题作为训练数据,并利用系统提示、严格格式奖励和直观训练方案,成功训练出具有高级推理技能的模型。实验结果表明,该模型不仅能够在训练数据上表现出色,还能泛化到具有挑战性的分布外任务中。未来的工作将集中在将该方法扩展到更多样化和复杂的数据集上,以进一步验证其有效性和鲁棒性。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)