【dify—4】安装Ollama,部署Deepseek-R1模型

Ollama 是一个。

目录

第一部分 安装dify+docker教程:【dify+docker安装教程】-CSDN博客

第二部分 dock重装教程: 【dify—2】docker重装-CSDN博客

第三部分 dify拉取镜像:【dify—3】拉取镜像、本地访问dify-CSDN博客

本文主要介绍安装Ollama,并将其下载语言大模型路径迁移至其它盘的方法,并通过部署本地大模型,实现本地对话。

一、进入Ollama官网

ollama官网地址:Ollama

(1)ollama简介

Ollama 是一个开源工具,主要用于在本地计算机上快速、便捷地运行和操作各种开源大型语言模型(如 LLaMA、Mistral、Gemma 等)。以下是它的核心功能:

(2)主要用途

本地运行大模型

无需联网或依赖云端服务,直接在个人电脑(支持 macOS、Linux、Windows)上运行模型,适合注重隐私或需要离线使用的场景。简化模型管理

通过命令行一键下载、更新、删除模型(如ollama run llama2),自动处理依赖项和配置。支持多种模型

提供丰富的模型库(ollama.com/library),包括对话、代码生成、多模态等类型,例如:

Whisper(语音转文本)

Code Llama(编程辅助)

LLaMA 2(通用对话)

开发者友好

提供 REST API,方便集成到其他应用或服务中,支持通过 Docker 部署。

(3)典型场景

-

隐私敏感任务:处理内部文档或机密数据时,避免数据上传云端。

-

定制化需求:结合自有数据微调模型,打造专属AI助手。

-

低成本实验:本地调试模型,节省云服务费用。

(4)与云端模型(如 ChatGPT)的区别

| 特性 | Ollama(本地模型) | 云端模型(如 GPT-4) |

|---|---|---|

| 隐私 | 数据完全本地处理,不外传 | 依赖服务商的数据政策 |

| 成本 | 免费(需自备算力) | 按使用量付费 |

| 性能 | 依赖本地硬件配置 | 通常响应更快、效果更强 |

| 灵活性 | 可自由修改、微调模型 | 只能通过 API 调用 |

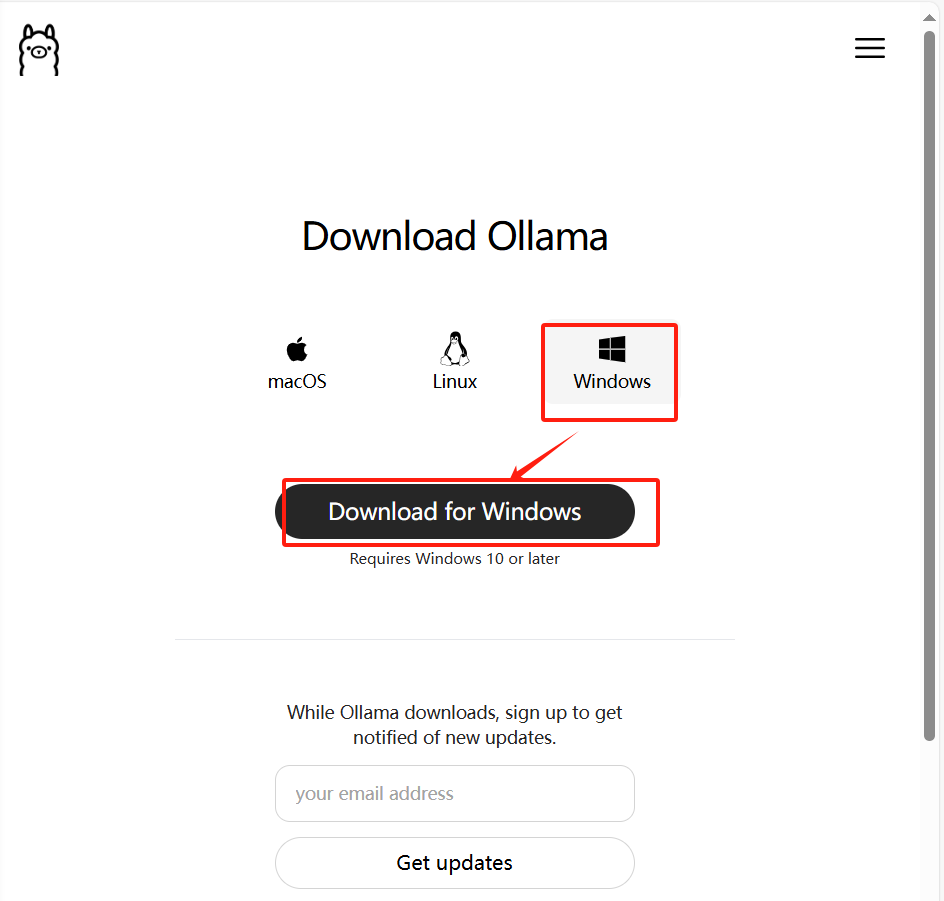

二、下载Ollama

三、安装Ollama

说明:安装会默认安装在C盘,占用大小4.56G

验证是否安装成功:

测试1:cmd打开命令,输入:ollama,显示以下内容表示安装成功

Usage:

ollama [flags]

ollama [command]Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any commandFlags:

-h, --help help for ollama

-v, --version Show version informationUse "ollama [command] --help" for more information about a command

测试2:浏览器访问“http://localhost:11434/”,显示如下图表示成功安装

四、将Ollama文件迁移到D盘

(1)在 C:\用户\asus\.ollama 这个路径下含有 models 和 blobs 两个文件夹,如果下载语言模型是默认下载这个路径下的 blobs 文件夹里。这个文件夹需要移动到D盘指定的文件夹。

(2)C:\用户\asus\AppData\Local 这个路径下 Ollama 文件夹不用动,Programs 文件夹内 Ollama 整个文件夹复制到D盘指定文件夹里。这个Ollama文件夹约有4.56GB。

(3)下图是Programs 文件夹内 Ollama 文件夹里的内容,约有4.56GB

(4)上面说的两个文件夹移动到D盘,我的方法如下,也可 D:\Ollama ,因为考虑到 AI 方面的软件安装管理,所以多增加了一个 AI 文件夹。(自定义位置)

文件路径:D:\computer_soft\AI\Ollama

五、设置环境变量

5.1 查看高级系统设置

5.2 用户环境变量编辑

5.3 修改系统环境变量

#变量名

OLLAMA_MODELS

#变量值:D盘中的.ollama路径

D:\computer_soft\AI\Ollama\.ollama

5.4 重启电脑即可生效

(1)进入D盘,我的D盘指定路径如下,然后在上边栏内输入“cmd”打开终端

D:\computer_soft\AI\Ollama\Ollama

(2)查看模型列表

在终端里输入如下命令回车,显示还没有模型,表面原有文件移动,及环境变量设置成功。

ollama list

六、本地部署大模型

6.1 进入官网

搜索模型

6.2 选择模型大小

6.3 运行安装命令

运行命令:ollama run deepseek-r1:1.5b

安装的语言模型 位置

参考

https://zhuanlan.zhihu.com/p/22615618497![]() https://zhuanlan.zhihu.com/p/22615618497

https://zhuanlan.zhihu.com/p/22615618497

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)