小白也能看懂的Open-WebUI+DeepSeek实现本地知识库实战教程

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种 LLM 运行器,如 DeepSeek 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎(本地知识库),使其成为强大的 AI 部署解决方案。自DeepSeek模型崭露头角以来,Open WebUI作为其优秀的配套界面也随之广受关注。这两者的完美结合不仅为用户提供了强大的本地部署方案,

Open WebUI 是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种 LLM 运行器,如 DeepSeek 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎(本地知识库),使其成为强大的 AI 部署解决方案。

自DeepSeek模型崭露头角以来,Open WebUI作为其优秀的配套界面也随之广受关注。这两者的完美结合不仅为用户提供了强大的本地部署方案,更成为了构建私有知识库的理想选择。DeepSeek出色的理解能力与Open WebUI便捷的操作界面相得益彰,为用户打造了一个功能完整、使用便利的本地化AI解决方案。

Windows安装部署教程

一、环境准备

1、安装Python环境

使用openwebui需要安装python版本需要>=3.11(开发版本)。本次安装使用python3.11.6,推荐大家也使用相同版本即可。这里我准备好了本次实战版本,下载即可:https://ablai.lyzplus.cn/python-3.11.6-amd64.exe

Python安装教程可以参考:https://blog.csdn.net/qq_53280175/article/details/121107748

安装过程中需要注意:勾选 Add Python to PATH 选项

安装过程中需要注意:勾选 Add Python to PATH 选项

安装过程中需要注意:勾选 Add Python to PATH 选项

2、手动安装

我们使用官方强烈建议的uv,因为它可以简化环境管理并最大限度地减少潜在冲突。

运行时管理器可确保对 Open WebUI 等应用程序进行无缝的 Python 环境管理。请按照以下步骤开始:

1. 安装uv:

- Win+X(开始+搜索PowerShell+选择管理员打开)打开

Powershell - 执行以下安装命令:

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

如果连接超时使用下面这个命令:

powershell -ExecutionPolicy ByPass -c "irm https://ablai.lyzplus.cn/uv-installer.ps1 | iex"

2.运行 Open WebUI

安装后,运行 Open WebUI 就轻而易举了。使用以下命令,确保设置环境变量以避免数据丢失。为每个平台提供了示例路径:uv DATA_DIR

执行以下命令运行:

$env:DATA_DIR="C:\open-webui\data"; uvx --python 3.11 open-webui@latest serve

等待安装/启动完成即可。(只有首次启动需要安装)

运行成功后访问:http://127.0.0.1:8080 即可访问Open WebUI,安装完成。

MacOS/Linux部署教程

一、环境准备

1、安装Python环境

使用openwebui需要安装python版本需要>=3.11(开发版本)。本次安装使用python3.11.6,推荐大家也使用相同版本即可。这里我准备好了本次实战版本,下载即可:https://ablai.lyzplus.cn/python-3.11.6-macos11.pkg

运行python安装程序,一路点下一步完成安装即可。

在终端输入python3 -v显示:

Python 3.11.6 (v3.11.6:8b6ee5ba3b, Oct 2 2023, 11:18:21) [Clang 13.0.0 (clang-1300.0.29.30)] on darwin

则安装成功。

2、手动安装

我们使用官方强烈建议的uv,因为它可以简化环境管理并最大限度地减少潜在冲突。

运行时管理器可确保对 Open WebUI 等应用程序进行无缝的 Python 环境管理。请按照以下步骤开始:

1. 安装uv:

在终端执行以下安装命令:

curl -LsSf https://astral.sh/uv/install.sh | sh

2.运行 Open WebUI

安装后,运行 Open WebUI 就轻而易举了。使用以下命令,确保设置环境变量以避免数据丢失。为每个平台提供了示例路径:uv DATA_DIR

执行以下命令运行:

DATA_DIR=~/.open-webui uvx --python 3.11 open-webui@latest serve

等待安装/启动完成即可。(只有首次启动需要安装)

运行成功后访问:http://0.0.0.0:8080 即可访问Open WebUI,安装完成。

知识库配置(必需)

想要实现本地RAG(检索增强生成),也就知识库,需要借助向量模型对上传到知识库的文本进行向量化解析,通俗的讲就是将文本语义解析为LLM容易识别的向量名词。

本次实战使用的是 阿波罗AI(提供一站式大模型对接服务,稳定快速可靠)

设置向量模型

1、进入管理员设置

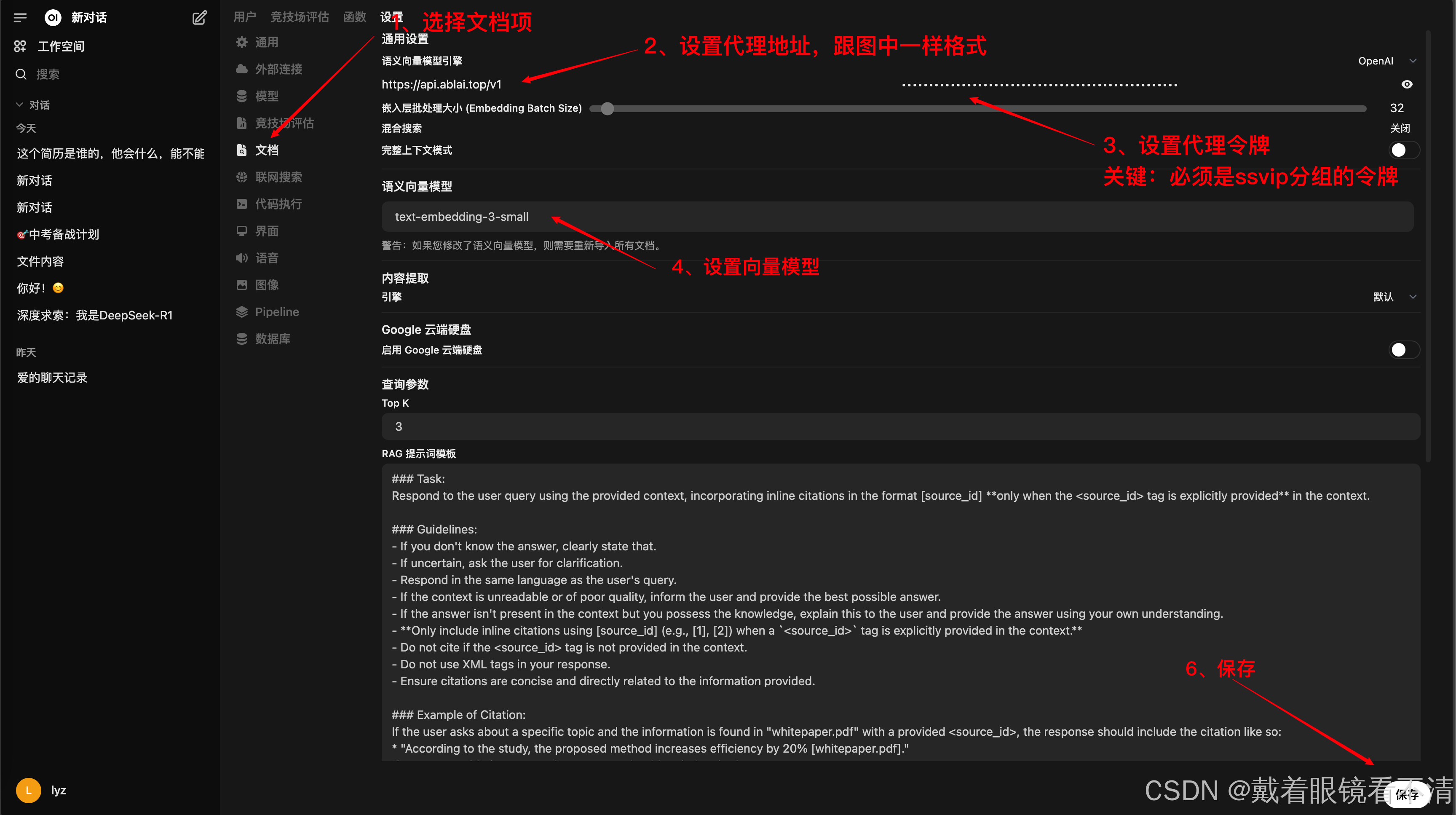

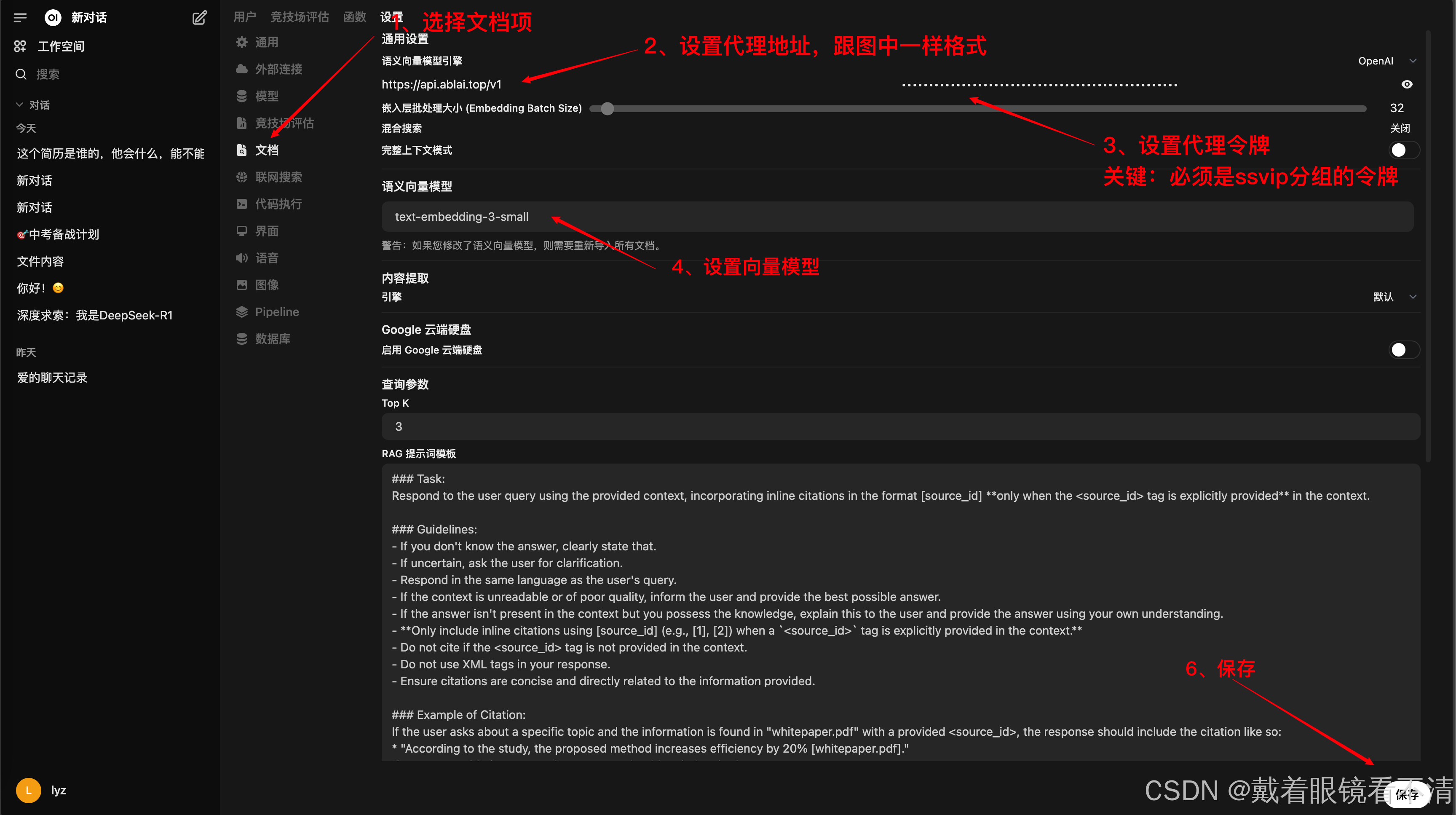

2、设置文档项

按照上图中的步骤进行设置,其中需要注意的是:

- 代理地址填 https://api.ablai.top/v1 (没有账号需要 注册)

- 令牌密钥

必须是ssvip分组的API_KEY,没有的话新建一个。

设置完毕后,对话上传和新建知识库上传文件就会自动实现向量解析。

开始使用

- 新建知识库

- 使用知识库

LLM大模型配置(必需)

想要解锁对话功能,需要对接大模型,我们使用阿波罗AI(提供一站式大模型对接服务,稳定快速可靠) 进行对接。阿波罗AI的代理能够支持Open-WebUI全部能力。

阿波罗AI对接后几百种模型(DeepSeek、ChatGPT、Claude、通义千问、文言一心、谷歌等)你都可以使用,详情查看:模型列表

设置外部链接

1、进入管理员设置

2、设置外部链接

- 代理地址填 https://api.ablai.top/v1 (没有账号需要 注册)

- 密钥可以根据模型使用情况选择分组设置

- 可以手动添加模型

开始对话

1、选择模型对话即可

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)