五分钟搞定 DeepSeek 本地化部署亲测体验,自定义 Ollama 安装路径和模型存储路径

亲测5分钟本地化部署 Deepseek ,并自定义 Ollama 安装路径及其模型数据下载路径

目录

一、前言

最近看 deepseek 挺火的,而且可以本地化部署·,休假在外刚刚回家就找了最简单的教程亲自试了试,果然入门级的 deepseek-r1:1.5b 部署 5分钟就可以搞定了,同时因为不爽 5G 大的 Ollama 只能默认安装在 C 盘,所以顺便又捣鼓了几下,将它和下载的模型放到任意安装位置,怕以后忘记怎么操作的了,便以此文记录。

二、资料

对于我这种 AI 小白,要玩这个只能找参考资料了,于是搜到有用的资料如下:

1、https://baijiahao.baidu.com/s?id=1822532821196963902

3、https://baijiahao.baidu.com/s?id=1823746464216142915

4、【ollama安装】大模型部署工具之ollama的安装部署以及api调用-CSDN博客

看了以上四份资料,你就应该知道该怎么安装以及选择哪个 b 版本的模型来用了,所以安装过程和各版差异我就不再细说,只说我的体验以及安装路径的修改。

三、ollama 安装体验

1、下载 ollama:看了资料1 ,现在,ollama 网站不用翻墙就能打开了,但是安装包下载异常慢,于是有了资料 2 ,就能快速下载了,不然5分钟可搞不定 ollama 下载,下载完5秒安装好点击提示自动运行即可。

2、安装 ollama:看资料1 也说只能默认安装在 C 盘,但是这东西装好了有 5G 大,放 C 盘感觉不合理,于是安装好了测试了一下

ollama run deepseek-r1:1.5b

正常工作之后,我就删除了模型:

ollama rm deepseek-r1:1.5b看了下 ollama 的帮助信息,用了下它的 list 命令,发现看起来感觉它怎么有点 d 里 d 气的,看了下上面的参考资料,才知道它果然是 Docker 的亲戚!

![]()

这样的话,忽然想起来当初我应该是改过 Docker 的安装路径及容器存储路径 记录:Docker 安装记录-CSDN博客,这样的话,ollama 应该也可以用相同的方法设置任意位置的安装路径,于是想当然的直接弄 ollama 的安装路径:

C:\Users\youName>mklink /J "C:\Users\youName\AppData\Local\Programs\ollama" "G:\ollama"

为 C:\Users\youName\AppData\Local\Programs\ollama <<===>> G:\ollama 创建的联接

于是重新安装 ollama ,安装好了发现我的自定义并未生效,而且目录联接也失效了,应该是 ollama 安装时先清除了 "C:\Users\youName\AppData\Local\Programs\ollama" 的目录联接。

既然不行,那么就弄它的上层目录 "C:\Users\youName\AppData\Local\Programs" !同时顺手把模型存储目录也弄了,不然几十G的模型放 C 盘那是有毛病。但是后来更新 Ollama 时发现它会把老的目录整个删除,所以,模型数据存储不能放在 ollama 目录下,而且后面看参考资料4 发现模型存储目录还可以用环境变量 OLLAMA_MODELS 来设置,那么最终方案还是用环境变量设置更靠谱。例如:OLLAMA_MODELS 》》》 G:\Programs\Ollamadata

Rem 注意 mklink 命令中,前面的目录不能实际存在,后面的目录必须实际存在。

mklink /J "C:\Users\youName\AppData\Local\Programs" "G:\Programs"

rem 模型数据存储路径改为设置环境变量: OLLAMA_MODELS ,不再用目录联接: mklink /J "C:\Users\youName\.ollama" "G:\Programs\Ollamadata" 来设置

这样,安装的 ollama 和下载的模型都可以放到自定义目录去了,再次注意:模型数据不能放在 Ollama 安装目录下,否则 Ollama 更新时会删除整个 Ollama 安装目录连带下载模型数据就一起删除了,所以我上面图片中设置之后,更新了一次后模型数据完全被删除,只能重新爬。

自定义 Ollama 安装路径和模型数据存储路径后:

四、模型安装体验

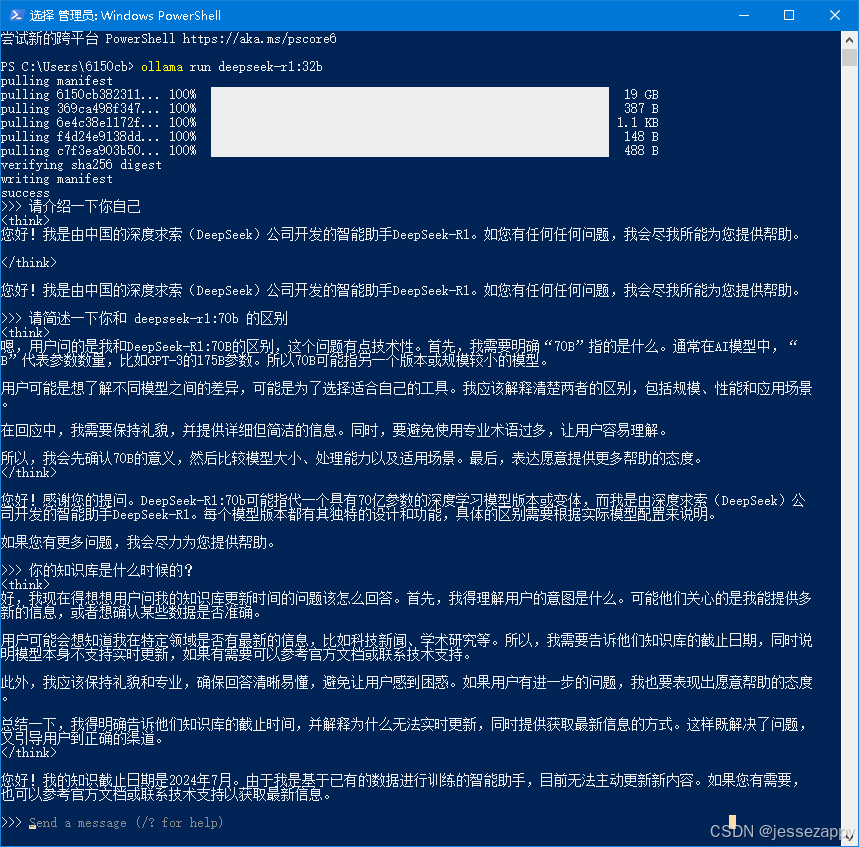

1、前面说了,deepseek-r1:1.5b 模型不到三分钟就下载完毕可用了,那么我就想试试 deepseek-r1:70b ,于是:

ollama run deepseek-r1:70b

看起来下载速度不错!42G 写的是30分钟下载完,但是实际下载花费了40多分钟,因为看起来是分块爬,所以最后的碎片查缺补漏很费时间:

本来是抱着试试看的心态下载的,结果真不行,内存不足,运行不了:

Error: llama runner process has terminated: error loading model: unable to allocate CUDA_Host buffer

错误:llama runner进程已终止:加载模型时出错:无法分配CUDA_Host缓冲区

看来公布的运行需求是有道理的:

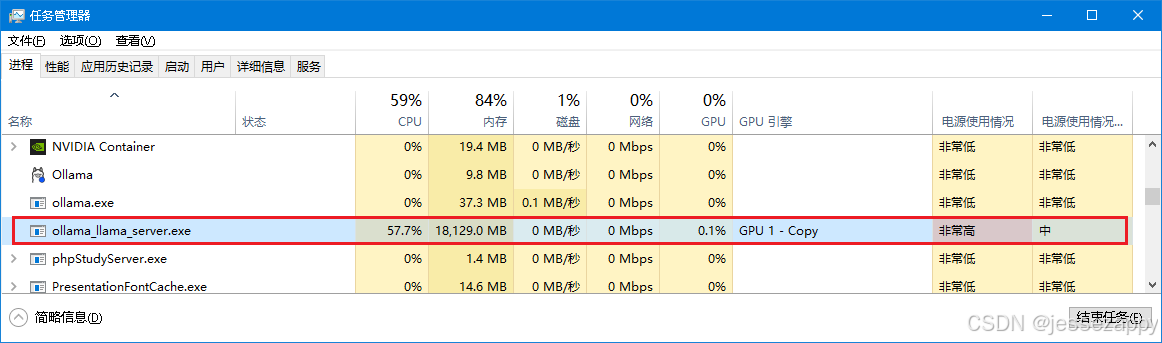

2、我家里台式机只有32G内存,不信邪,我又试了一下 32b,32b 的尺寸是 19G ,

按照上面表格说的,需要64G内存,但是我这机器居然可以运行起来,只是响应超级慢,提问后差不多一分钟才有动静

而且看了下内存占用,居然差不多就是模型体积那么大,看起来要运行起来的要求并不是表格上面说的那个,那个应该是勉强流畅使用的要求,而像我这种勉强能运行起来的应该只要内存大于模型体积一点点就可以了,

可以看到,它并未使用表格中的64G内存,只用了18.2G内存。也就是说,我另一台 64G 内存的机器可以勉强运行 70b 了,而之前我家里 32G 内存的机器远小于 70b 的 42G 体积,所以运行不起来 70b 。

以下是 9GB 的 14b 模型内存使用情况:

以下是 19Gb 的 32b 模型内存使用情况:

待机时

工作时

看 32b 的思考逻辑,它把我当成了不知道日期的人:

以下是 4.7G 的 openthinker 模型工作时内存使用情况:

等重新下载 70b 去那边运行测试了再来补充结论。

20250225, 70b 在 64G 内存的机器上真的可以运行:

看运行过程,是第一次提问时才将模型从硬盘加载到内存,所以加载过程超级慢,毕竟要读取 42G 的文件,所以花了差不多5分钟才加载完毕,然后慢悠悠的一个字一个字的输出出来。看来要流畅运行 70b 不是这破电脑能搞得定的,要花大价钱升级硬件才行了。

在这台能运行 70b 的机器上,重新测试运行 32b ,发现勉强能不太卡顿的运行,我把模型存储路径改到 SSD 后,启动时依然是要读取 19G 的模型文件,但是很快,启动时间约为 7 秒,简单问题思考时间约 1 秒,文字输出还是一个字一个字的慢慢跳出来,这样的话,勉强能用吧:

可能是因为显卡显存大了一点的原因,内存占用并没有另一台 32G 内存的机器那么大:

比那台少了差不多 5G :

另外发现一个情况,那就是开两个 Powershell 窗口后,一个启动模型对话,另一个查看运行状态,在查看状态那边执行:

ollama stop deepseek-r1:32b之后,对话这边并未用 /bye 命令推出对话界面,这时在另一边查看运行状态发现已无模型在运行,看内存也已经释放了占用的内存,但是在对话界面输入问题,依然会激活模型:

同时,如果你停留在对话窗口,不使用 /bye 命令推出对话,也不进行任何操作,那么过一段时间模型依然会自动终止运行并释放内存,直到你在对话窗口提交问题:

从思考过程和答案来看,和网友们评测的一样,最低还是得用 32b 的模型才行:

从上下图来看,32b 和 671b 的差距还是不小的:

3、查看目录联接是否成功设置的方法:

# CMD 中 #

fsutil reparsepoint query "C:\Users\youName\AppData\Local\Programs"

# powershell 中 #

Get-Item "C:\Users\youName\AppData\Local\Programs" | Select-Object LinkType, Target五、 总结

1、通过网友分享的网盘可以快速下载 ollama ,所以我刚刚更新后,就把它自动更新的安装包顺手分享了一下,需要的朋友请自行下载:

文件:OllamaSetup.exe

产品版本:0.6.5.0,https://pan.baidu.com/s/1ddqOLPqQTDRaY6EBLWJHnA?pwd=mcky

签名时间: 2025年4月7日 13:37:02 大小:0.97 GB (1,052,019,456 字节) Crc32:449b566a

2、在安装 Ollama 之前先利用目录联接 mklink 设置一个自定义的 ollama 安装路径,并设置系统环境变量自定义一下模型数据下载目录,否则全部扔在 C 盘怕是脑残。这样我就可以安装多个模型了:

3、根据网友的测试比较,建议最低都要使用 32b 这样才能基本实现 90% 的 671B 的性能,低于 32b 的那些只能算是儿童玩具说,再小尺寸的模型在基础能力方面有些过于薄弱,甚至输出结果不敌同尺寸其他模型。尤其是网络上大量的本地部署教程所推荐的1.5B、7B、8B尺寸模型,还是忘了它们吧……除了配置需求低、速度快,用起来并不理想。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)