DeepSeek本地部署教程+chatbox可视化页面的四个方法附ollama自定义安装路径

响应速度比Chatbox快20%,支持多标签页对话。:Edge需手动加载Chrome插件。:界面简洁,5分钟完成部署。

·

方法一:Chatbox客户端(适合小白)

适用系统:Windows/Mac/Linux

核心步骤:

- 安装Ollama

- 官网下载安装包(需翻墙可替换为国内镜像源)

- 验证安装:命令行输入ollama --version显示版本号

- 安装包国内备用下载:mix688.com

- 下载模型

ollama pull deepseek-r1:1.5b-instruct # 低配设备选1.5B版本 - 配置Chatbox

- 下载地址:mix688.com

- 设置 → 模型 → 选择"Ollama" → API地址填http://localhost:11434

- 右下角选择已下载的DeepSeek模型即可对话

优势:界面简洁,5分钟完成部署

缺陷:不支持知识库扩展

方法二:浏览器插件Page Assist(免安装客户端)

适用浏览器:Chrome/Edge

操作流程:

- 安装Ollama并下载模型(同方法一步骤1-2)

- 获取Page Assist插件

- Chrome商店搜索安装 或 手动下载.crx文件(需开启开发者模式)

- 如果下载失败,可以使用备用地址:mix688.com

- 插件配置

- 点击插件图标 → 设置 → 模型选择deepseek-r1:1.5b → API地址保持默认

- 语言切换为中文后保存

实测效果:响应速度比Chatbox快20%,支持多标签页对话

注意:Edge需手动加载Chrome插件

方法三:Open WebUI(开发者推荐)

技术栈:Docker + Python

部署步骤:

- 安装Docker Desktop

- Windows/Mac官网下载,Linux执行:

- curl -fsSL https://get.docker.com | sh

- 启动Open WebUI容器

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

- 连接Ollama服务

- 访问http://localhost:3000 → 设置 → 填入host.docker.internal:11434

方法四:Cherry Studio(企业级方案)

适用场景:需连接私有知识库

配置要点:

- 下载客户端:mix688.com

- 添加本地模型:

ollama list # 获取已安装模型名称- 在Cherry Studio设置中粘贴模型名称(如deepseek-r1:14b)

- RAG扩展:

- 上传PDF/TXT文档 → 自动生成向量索引

- 对话时勾选"启用知识库检索"

硬件要求:

- 14B模型需≥16GB内存

- 知识库索引需预留文档体积3倍存储空间

性能对比(基于i7-12700H测试)

| 方案 | 内存占用 | 响应延迟 | 功能扩展性 |

|---|---|---|---|

| Chatbox | 1.2GB | 2.1s | ★★☆☆☆ |

| Page Assist | 800MB | 1.8s | ★★★☆☆ |

| Open WebUI | 2.3GB | 2.4s | ★★★★★ |

| Cherry Studio | 3.5GB | 3.0s | ★★★★☆ |

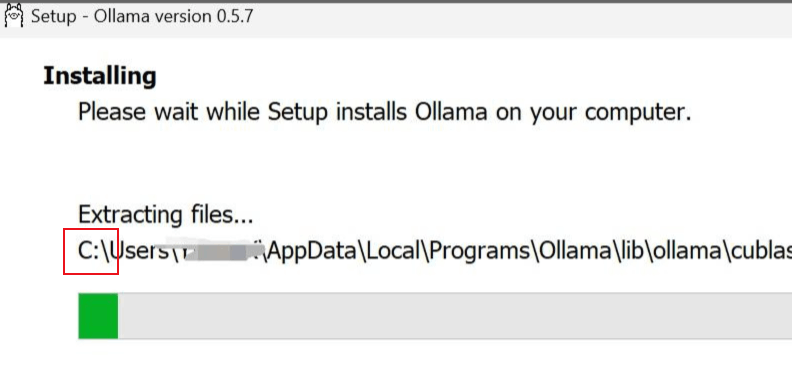

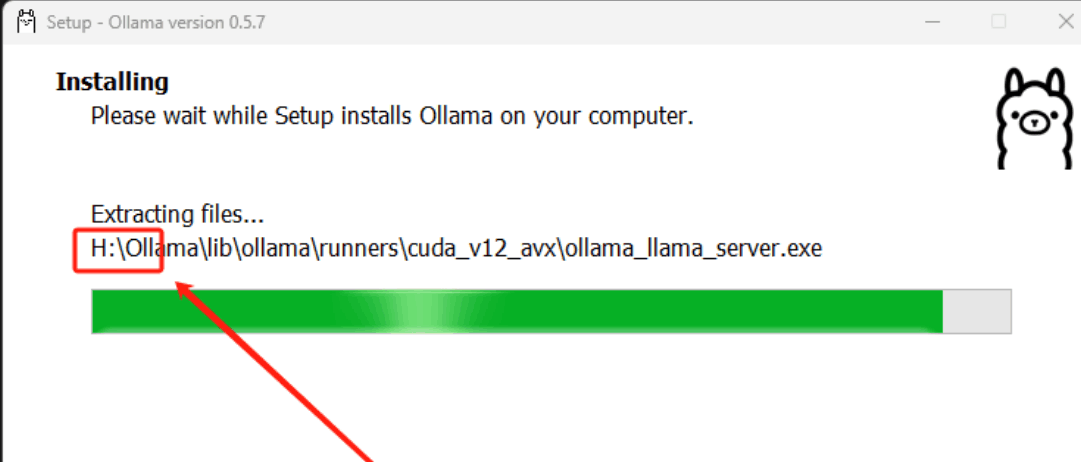

Ollama默认安装到C盘,我们也可以通过命令强制安装到其他盘符下

默认安装到D盘方法参考原文→自定义Ollama安装路径

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)