Linux服务器部署deepseek使用网站进行问答并开启联网搜索(含网盘资源)

Linux服务器部署deepseek使用网站进行问答并开启联网搜索

这两天一直在研究deepseek相关的东西,下面是之前帖子的传送门:

Windows系统安装docker(含网盘下载链接)-CSDN博客

本地部署deepseek (ollama简单使用方法,含网盘下载链接)-CSDN博客

通过ollama(modelfile)微调deepseek,制作自己的大模型-CSDN博客

在网上冲浪的了一段时间后,发现网上很少有Linux服务器使用ollama+open-webui来部署deepseek的。然后今天我来做一个相关的教程,我使用的系统是centos7的系统,用其他系统也一样照猫画虎就可以,比如用Ubuntu就把指令中yum换成apt。

使用Linux服务器部署也是十分方便,可以公网访问,使用4核心4g的云服务器就可以跑deepseek-r1:1.5b版本。如果安装中出现网络问题可以用下面的包↓↓↓

open-webui镜像,Windows的docker也可以用找个镜像:(访问密码:7360)

https://url57.ctfile.com/f/45223957-1459296034-f2bf35?p=7360

ollama Linux离线安装包:(访问密码:7360)

https://url57.ctfile.com/f/45223957-1459297906-ca2a84?p=7360

部署教程:

首先运行下面指令在服务器上安装ollama,安装慢的话可以找个代理服务器或者离线安装教。

curl -fsSL https://ollama.com/install.sh | sh如果安装出现网络问题可以用上面的离线安装包按照官方文档进行手动安装 。

下面是官方的安装文档,我就不演示了。

ollama/docs/linux.md at main · ollama/ollama · GitHub

如果出现CPU-only代表你得环境下只能用cpu去跑大模型

下载deepseek-r1:1.5b模型

ollama pull deepseek-r1:1.5b

然后修改ollama的配置文件,在service下添加

sudo vi /etc/systemd/system/ollama.service

Environment="OLLAMA_HOST=0.0.0.0" #添加添加完要 重启reboot一下

open-webui要用到docker,接下来安装docker

sudo yum update -y

yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

sudo yum install docker-ce docker-ce-cli containerd.io -y

docker安装完成后启动docker并设置开机自启

sudo systemctl start docker

systemctl enable docker

接下来拉取webui的镜像

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

#3000可以改成你要设置的端口

镜像下载失败就用网盘的镜像上传到服务器根目录然后导入docker

cd /

docker load -i webui.tar

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

#3000换成你自定义的端口镜像启动后运行docker ps查看容器是否成功启动

然后访问IP:端口 就可以访问了,之后输入信息创建用户

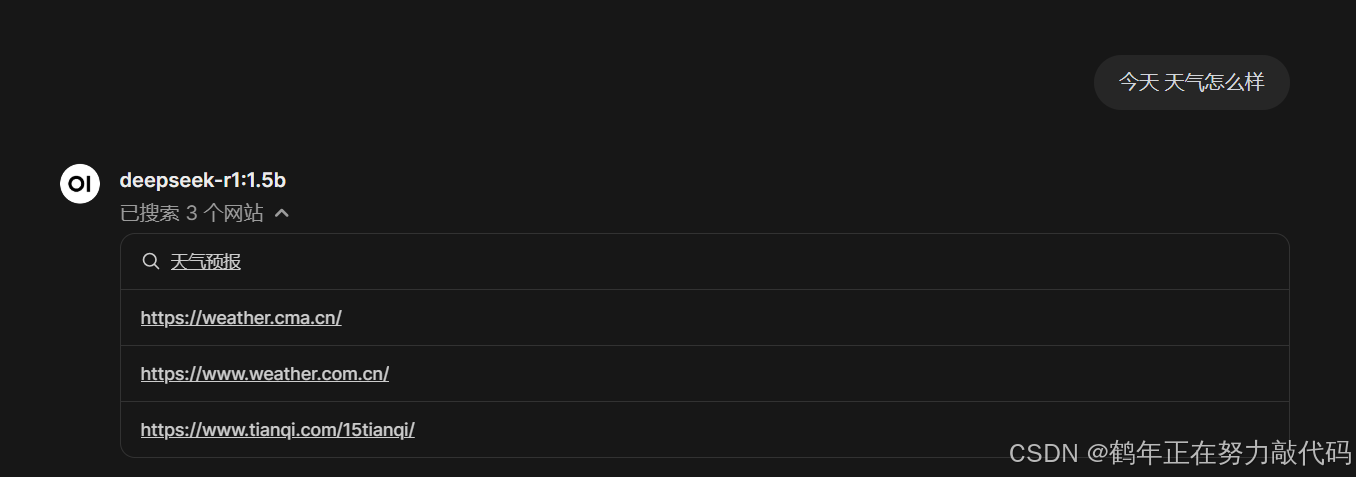

开启联网搜索:

点击右上角进入管理员面板,然后设置如图参数点击保存即可。

(条件允许的话可以用好一点的搜索引擎)

返回首页即可发现有了联网搜索的选项。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)