一键接入DeepSeek-R1智能新时代,SiliconCloud助您抢占AI先机

硅基流动与华为云携手推出的DeepSeek R1与V3推理服务,为AI开发者提供了一个强大的工具,让大模型的应用和开发变得更加便捷和高效。通过创新的技术加速、稳定的生产级服务和优惠的价格策略,开发者能够更加专注于应用创新,而不是底层架构的维护和优化,开启全新的开发体验!

DeepSeek R1 现已上线 SiliconCloud,访问 SiliconCloud 即可免费在线使用:cloud.siliconflow.cn

这个春节,你玩上 DeepSeek 了吗?

霸屏整个春节假期的 DeepSeek 不但成为了开发者们的新宠,隔壁大爷都学会了用 DeepSeek 给老友写春节吉祥话。这个来自杭州深度求索的推理模型无疑是国内大模型厂商重要的里程碑。

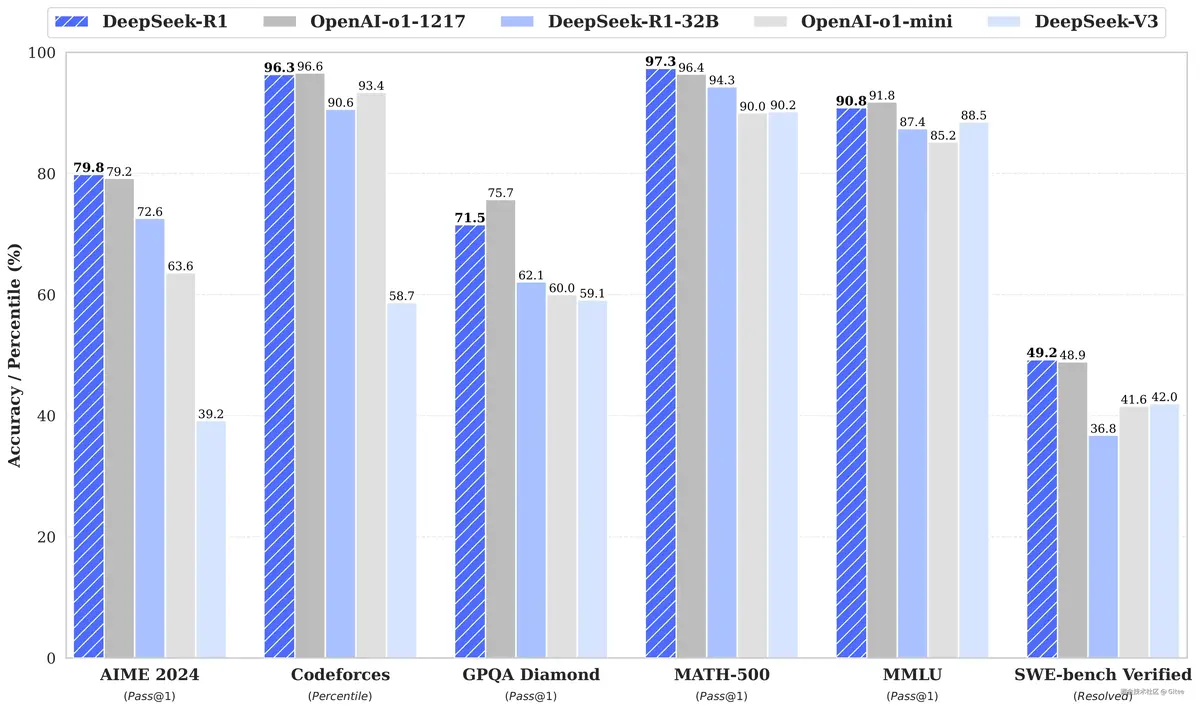

在关注 660B 开源大模型的同时,也开源的多个小尺寸蒸馏模型,尤其是DeepSeek-R1-Distill-Qwen-32B,它在多项能力上已经默默对标上了OpenAI-o1-mini。没错,就是那个几个月前“引领新纪元”的o1-mini。

蒸馏模型(Distinctive Distillation Model),通常称为知识蒸馏(Knowledge Distillation),是一种将复杂模型(教师模型)的知识迁移到更简单的小模型(学生模型)中的技术。其核心思想是通过模仿教师模型的输出或中间特征,让学生模型在保持较小规模的同时,尽可能接近教师模型的性能,广泛应用于工业部署和资源受限场景。

以更小的参数量的资源占用,实现了性能与大参数模型旗鼓相当,这对于普通开发者来说无疑是巨大利好。更低的资源消耗以及更快的响应速度能够让开发者们以更低的成本实现更高效的 AI 应用开发。

小模型更该“轻装上阵”

DeepSeek-R1-Distill-Qwen-32B作为一款轻量级模型,设计初衷就是高性价比的敏捷开发——但如果执着于本地部署,反而可能陷入“小模型大包袱”的困境:

本地部署模型看似零成本,实则需额外付出:

- 运维成本:需自建推理服务、监控日志、处理负载均衡

- 硬件成本:即使小模型也需持续占用 GPU/CPU 资源

- 机会成本:调试部署的时间,本可用于核心业务开发

为什么选择DeepSeek-R1?

全能型多模态模型:支持文本、图像、代码生成与解析,覆盖客服、营销、编程、数据分析等全场景。

行业级精准度:基于万亿级高质量数据训练,金融、医疗、法律等领域响应准确率超95%。

极致性价比:推理效率提升40%,成本仅为同类产品的60%(点击测试)。

SiliconCloud:三分钟极简接入,开启智能未来

作为国内领先的AI算力服务平台,SiliconCloud提供一站式模型部署解决方案:

✅ 无需代码:可视化控制台,API密钥即拿即用

✅ 弹性扩缩容:按需调用,零硬件投入

✅ 企业级安防:数据加密传输,合规审计全程护航

DeepSeek R1 & V3的在线体验链接

1、为了帮助开发者尽快体验这项新技术,SiliconCloud提供了免费的在线体验平台。你可以通过以下链接,直接体验DeepSeek R1与V3推理服务:

DeepSeek-R1体验链接:r1.siliconflow.cn

DeepSeek-V3体验链接:v3.siliconflow.cn

SiliconCloud接入实战:3步开启AI赋能

Step 1:注册即领2000万tokens免费额度,点击进入SiliconCloud官网

Step 2:创建DeepSeek-R1实例

选择适配场景的模型版本:

基础版:适合初创团队(5,000次/月免费调用)

企业版:支持私有化部署+定制微调

Step 3:API集成与效果验证

# 示例代码:快速调用文本生成接口

import requests

headers = {"Authorization": "Bearer YOUR_API_KEY"}

data = {

"prompt": "为智能手表撰写一则618促销文案,突出健康监测功能",

"max_tokens": 300

}

response = requests.post("https://api.siliconcloud.com/deepseek-r1", json=data, headers=headers)

print(response.json()["result"])

总结

硅基流动与华为云携手推出的DeepSeek R1与V3推理服务,为AI开发者提供了一个强大的工具,让大模型的应用和开发变得更加便捷和高效。通过创新的技术加速、稳定的生产级服务和优惠的价格策略,开发者能够更加专注于应用创新,而不是底层架构的维护和优化,开启全新的开发体验!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)