Ollama 介绍,搭建本地 AI 大模型 deepseek,并使用 Web 界面调用

Ollama 是一个基于 Go 语言的本地大语言模型运行框架,类 Docker产品(支持 list,pull,push,run 等命令),事实上它保留了 Docker 的操作习惯,支持上传大语言模型仓库(有 deepseek、llama 2,mistral,qwen 等模型,你也可以自定义模型上传)。在管理模型的同时,它还提供了一些 Api 接口,让你能够像调用 OpenAI 提供的接口那样进行交

Ollama 是一个基于 Go 语言的本地大语言模型运行框架,类 Docker产品(支持 list,pull,push,run 等命令),事实上它保留了 Docker 的操作习惯,支持上传大语言模型仓库(有 deepseek、llama 2,mistral,qwen 等模型,你也可以自定义模型上传)。

在管理模型的同时,它还提供了一些 Api 接口,让你能够像调用 OpenAI 提供的接口那样进行交互。

一、下载安装Ollama

Ollama 支持多平台部署,你可以在官网,选择适合的安装包。

下载地址:https://ollama.com

运行之后,访问localhost:11434,查看是否正常运行:

二、AI模型管理

ollama 安装之后,其同时还是一个命令,与模型交互就是通过命令来进行的。

ollama list:显示模型列表。ollama show:显示模型的信息ollama pull:拉取模型ollama push:推送模型ollama cp:拷贝一个模型ollama rm:删除一个模型ollama run:运行一个模型

官方提供了一个模型仓库,https://ollama.com/library, 你可以搜索你想要的模型。

官方建议:应该至少有 8 GB 可用 RAM 来运行 7 B 型号,16 GB 来运行 13 B 型号,32 GB 来运行 33 B 型号。

在这里我选择下载目前最火的开源 deepseek-r1 模型来做演示。模型地址为:https://ollama.com/library/deepseek-r1 ,因我的电脑有 32G,所以选择了 14b 的模型来调试。

ollama run deepseek-r1:14b

执行命令,如果本地没有该模型,则会先下载模型再运行。首次运行启动可能略慢。

三、简单交互

模型运行之后,会默认进入到交互状态,你可以按下Ctrl + D退出交互,但此时模型并不会退出,仍旧可以正常通过 Api 接口交互。

终端交互示例:

接口请求参考官方文档的介绍API文档,下边是简单的示例:

curl http://localhost:11434/api/generate -d "{\"model\":\"deepseek-r1:14b\", \"prompt\":\"介绍下JeecgBoot是什么项目\", \"stream\": false}"

接口请求支持 stream 模式,上边这个请求响应 10s 左右,如果使用 stream 模式,体验会提升不少。

四、通过Web界面调用大模型

这里介绍几个UI框架可以直接与ollama大模型对接。

项目一 :ollama-webui-lite

项目地址: https://github.com/ollama-webui/ollama-webui-lite

此项目是open-webui 的简化版,注意需:node >= 16。

git clone https://github.com/ollama-webui/ollama-webui-lite.git

cd ollama-webui-lite

yarn

yarn dev

运行之后,你可以对连接信息进行设置,默认是连接本机的http://localhost:11434/api,如果你也是本机部署,那就不用更改。然后界面选择启动的模型,就可以对话了。

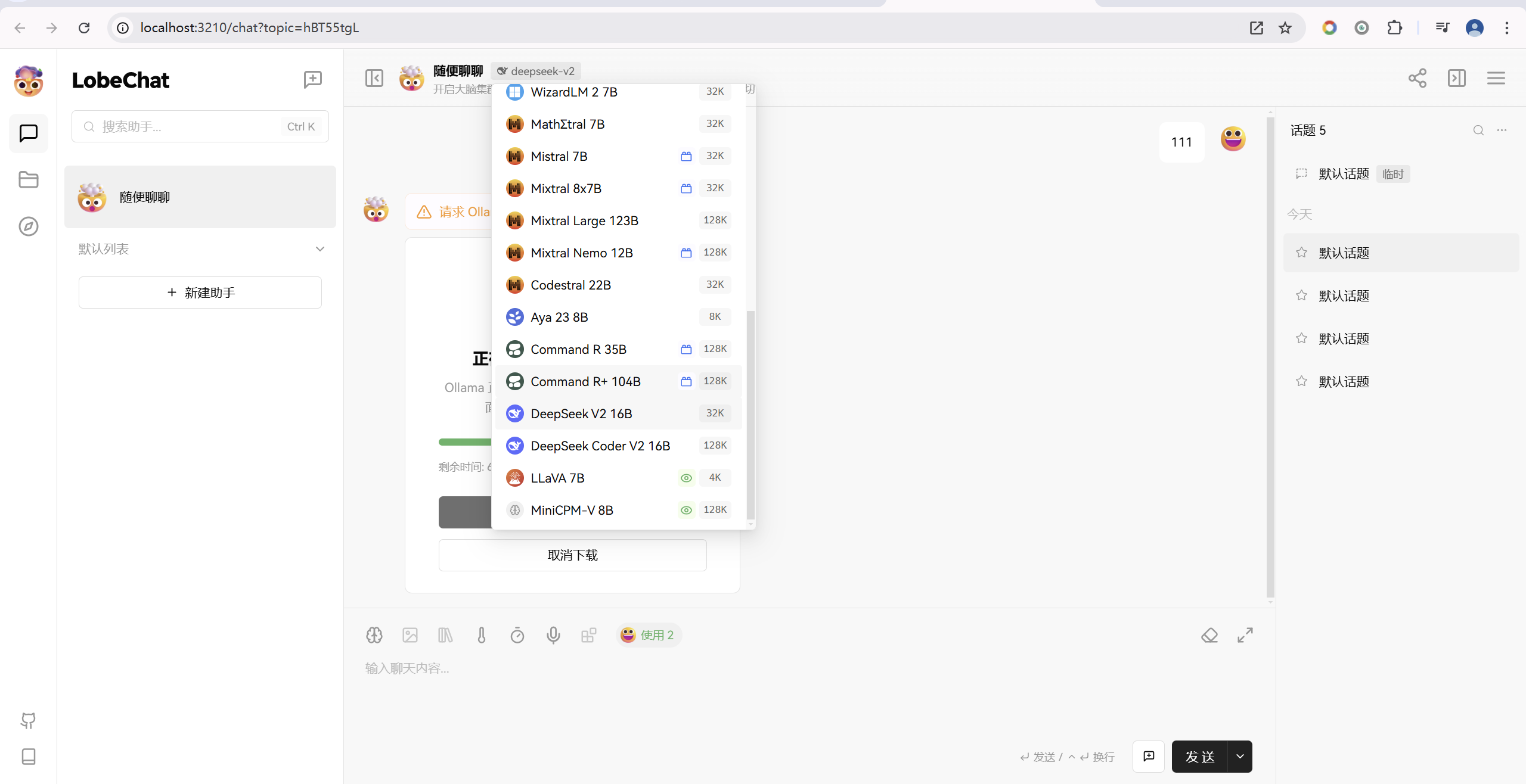

项目二 :lobe-chat

项目地址:https://github.com/lobehub/lobe-chat

这是一个集成多种模型能力的对话聊天UI,部署简单,界面酷炫。

Docker 部署命令:

docker run -itd --name=lobechat -p 3210:3210 registry.cn-hangzhou.aliyuncs.com/jeecgdocker/lobe-chat

如果你是本地 ollama 部署,启动之后,就可以在 web 界面进行交互了。

目前最新版还不支持deepseek v3,可以先用其他大模型测试下

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)