【亲测可行】本地部署deepseek & api免费部署满血版deepseek & python中配置api使用满血版deepseek-r1

本地部署时显卡不好的话根本带不动,如果显卡是4090的话,可以带动14B的,32B可能比较吃力.把复制的API粘贴到下面的地方,模型选择DeepSeek-R1,最后点击保存。deepseek-R1原始模型参数为671B (billion 十亿)deepseek最好的模型是deepseek-R1。下面三个客户端都可以,下面以chatbox为例。意思是该模型有6710亿个参数。

文章目录

🌕api免费部署deepseek

🌙注册账号,免费新建api密钥

注册账号: https://cloud.siliconflow.cn/models

点击新建API密钥

🌙方法一:客户端配置api使用满血版deepseek-r1

⭐下载客户端

下面三个客户端都可以,下面以chatbox为例

https://www.chatboxai.app/en#download

⭐安装之后配置api

把复制的API粘贴到下面的地方,模型选择DeepSeek-R1,最后点击保存

🌙方法二:网页中配置api使用满血版deepseek-r1

打开网页:https://web.chatboxai.app/

点击左下角的setting 然后配置key

model选择deepseek-r1

🌙方法三:python中配置api使用满血版deepseek-r1

运行该程序后,可在命令行中与deepseek-r1对话,无需安装上面的工具

pip isntall openai

from openai import OpenAI

url = 'https://api.siliconflow.cn/v1/'

api_key = '你的api key'

client = OpenAI(

base_url=url,

api_key=api_key

)

messages = []

try:

while True:

# 获取用户输入

try:

user_input = input("\nme:")

except KeyboardInterrupt:

print("\n对话结束")

break

# 添加用户消息到历史记录

messages.append({"role": "user", "content": user_input})

# 创建聊天补全请求

response = client.chat.completions.create(

model="deepseek-ai/DeepSeek-R1",

messages=messages,

stream=True,

max_tokens=4096

)

# 处理流式响应

assistant_response = []

print("deepseek-R1:", end="", flush=True)

for chunk in response:

content = chunk.choices[0].delta.content or ""

reasoning = chunk.choices[0].delta.reasoning_content or ""

# 优先显示content内容,如果没有则显示reasoning

if content:

print(content, end="", flush=True)

assistant_response.append(content)

elif reasoning:

print(reasoning, end="", flush=True)

assistant_response.append(reasoning)

# 添加助手回复到历史记录

if assistant_response:

messages.append({

"role": "assistant",

"content": "".join(assistant_response)

})

except KeyboardInterrupt:

print("\n程序已终止")

效果展示:

🌕本地部署方法

🌙deepseek最好的模型版本和下载地址

deepseek最好的模型是deepseek-R1

deepseek-R1原始模型参数为671B (billion 十亿)

意思是该模型有6710亿个参数

模型地址:https://github.com/deepseek-ai/DeepSeek-R1

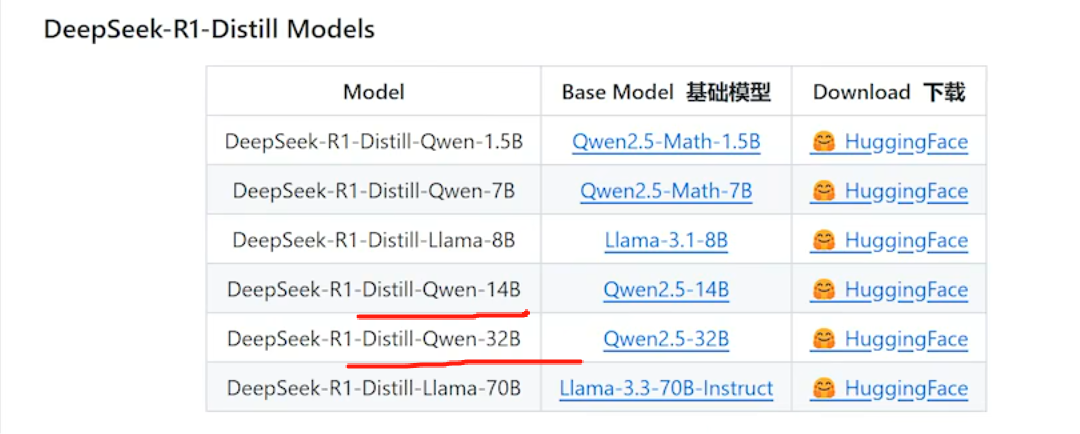

进入上面的网站,往下翻,画圈的地方就是它的参数:

🌙本地部署时推荐版本

本地部署时显卡不好的话根本带不动,如果显卡是4090的话,可以带动14B的,32B可能比较吃力.

🌙本地Ollama部署DeepSeek R1模型

本地Ollama部署DeepSeek R1模型 & 接入Word

🌕参考

🌙国产AI模型DeepSeek满血版本地运行

【保姆级教程】最强国产AI模型DeepSeek满血版本地运行,90岁老奶奶都能玩明白!

🌙DeepSeek+Ollama+AnythingLLM 本地部署完全指南,打造专属知识库

10分钟搞定!DeepSeek+Ollama+AnythingLLM 本地部署完全指南,打造专属知识库

🌙vscode接入deepseek

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)