Ubuntu、Windows 使用Ollama 本地部署deepseek,并在线访问可视化界面

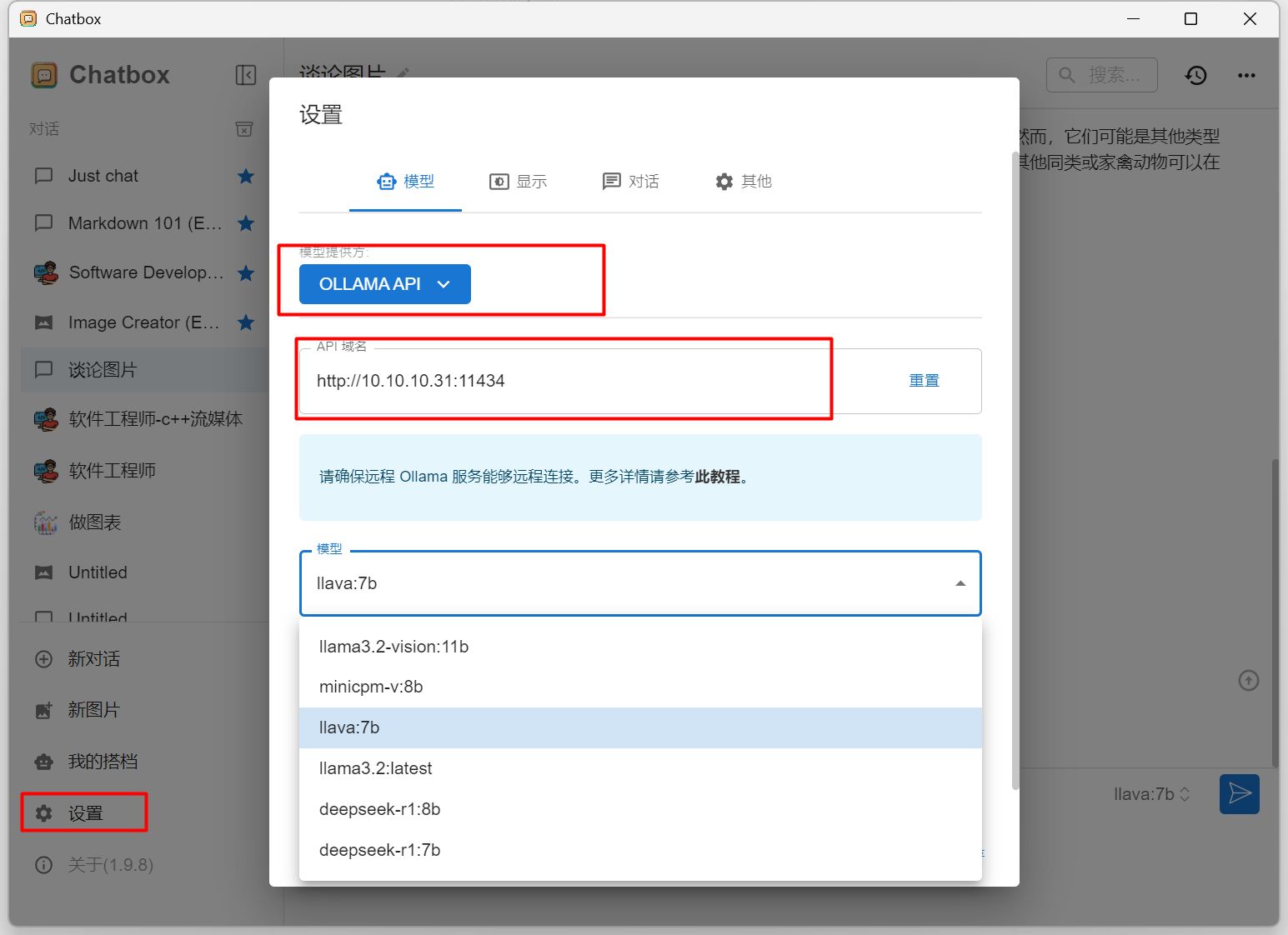

我是Ubuntu系统,NVIDIA 3070 8G显存 16G运行内存,全用cpu也行,运行内存要大一些。第一次进入会让你注册,注册一个即可。点击models即可进入模型列表,比如我们选择deepseek-r1。这里除了deepseek,其他模型也都是在ollama官网下载的。即可安装,安装失败的话就创建个虚拟环境,再pip装。在设置里,这样选择,记得修改你的ip,端口不用改。可以选择不同的模型,

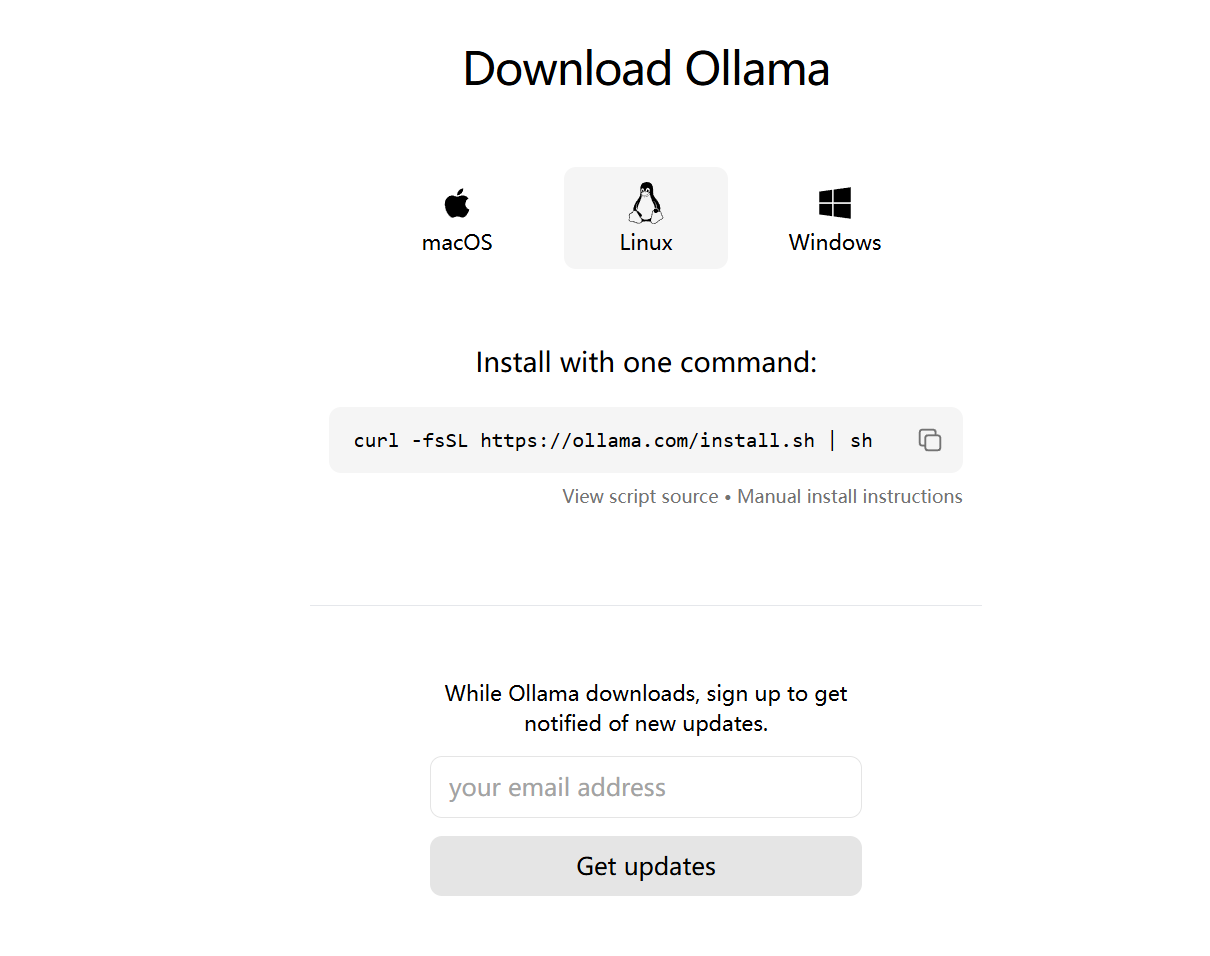

安装 ollama

进入ollama官网:https://ollama.com/

根据自己的系统选择安装

安装完成后,在终端输入以下命令,检查Ollama版本:

ollama --version

我是Ubuntu系统,NVIDIA 3070 8G显存 16G运行内存,全用cpu也行,运行内存要大一些

安装deepseek

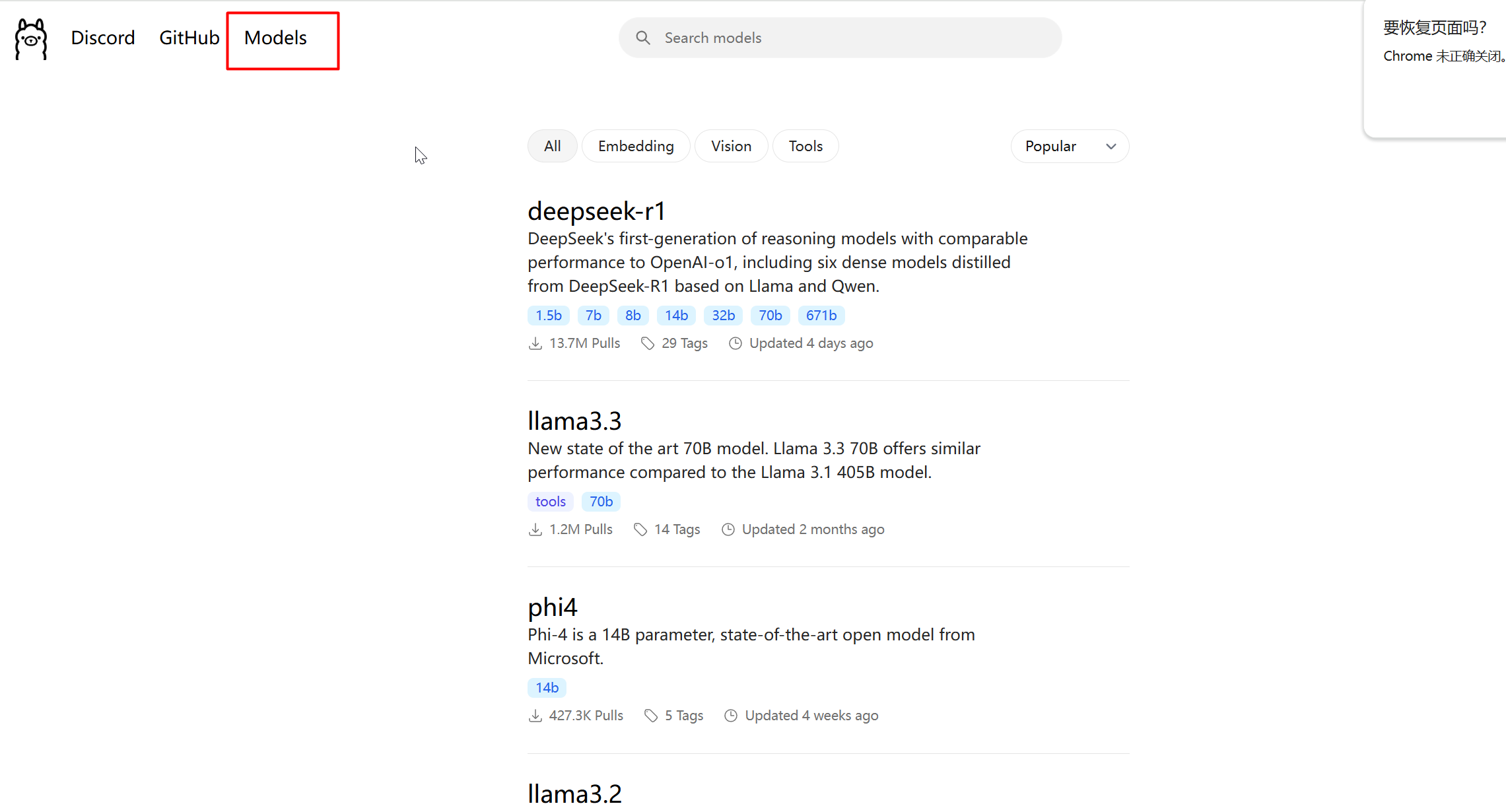

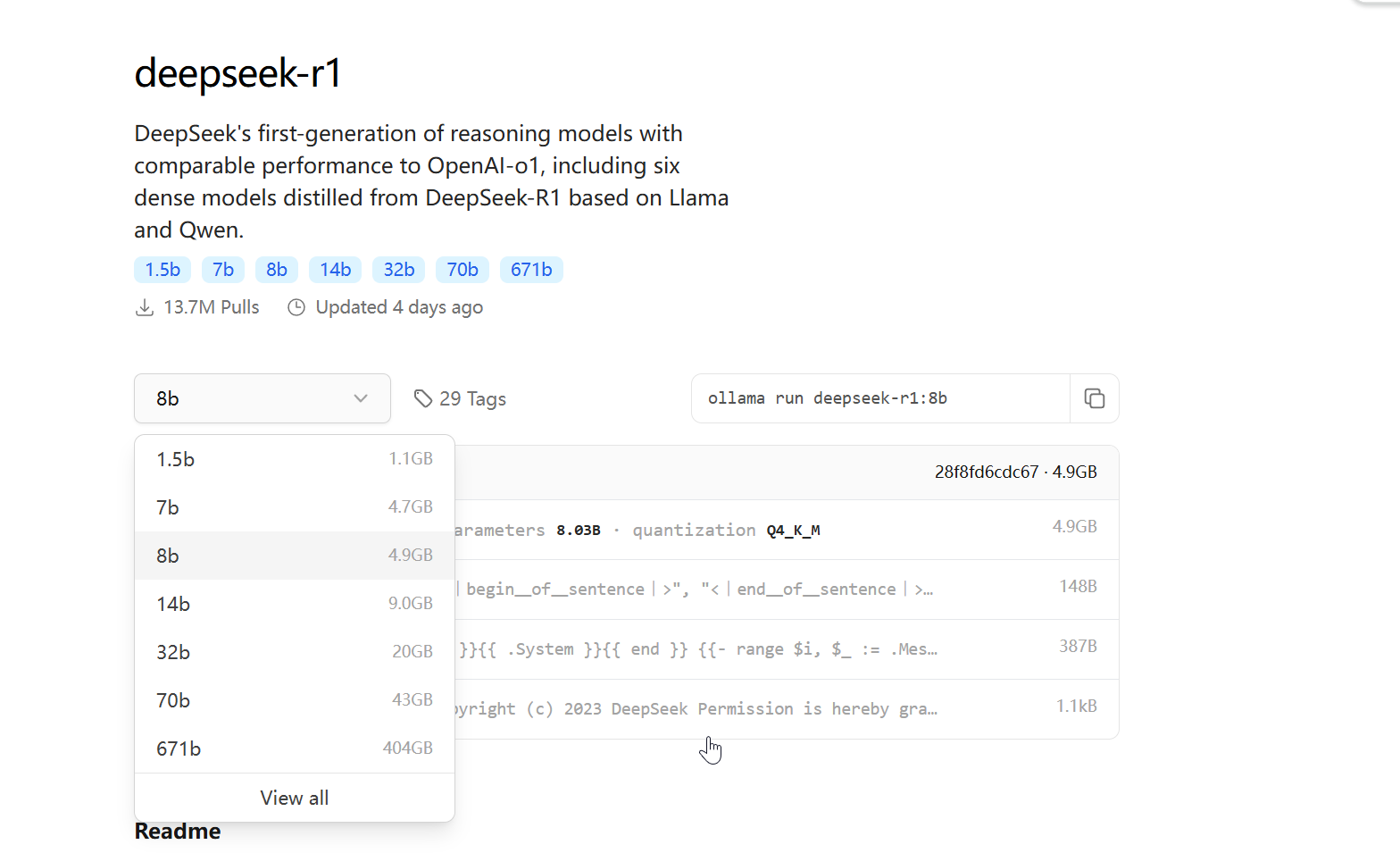

点击models即可进入模型列表,比如我们选择deepseek-r1

可以选择不同的模型,我选择了 8b的模型

在终端输入:

ollama run deepseek-r1:8b

即可自动下载模型

下载前期比较快,后面会慢,耐心等即可

下载完后会自动进入对话框

下载一次后面就不需要再下载了

安装open-webui

pip install open-webui

即可安装,安装失败的话就创建个虚拟环境,再pip装

安装后输入 open-webui serve

会出现Open-Webui界面:

在Windows浏览器中输入你的服务器ip的网址:http://your_ip:8080

即可打开界面

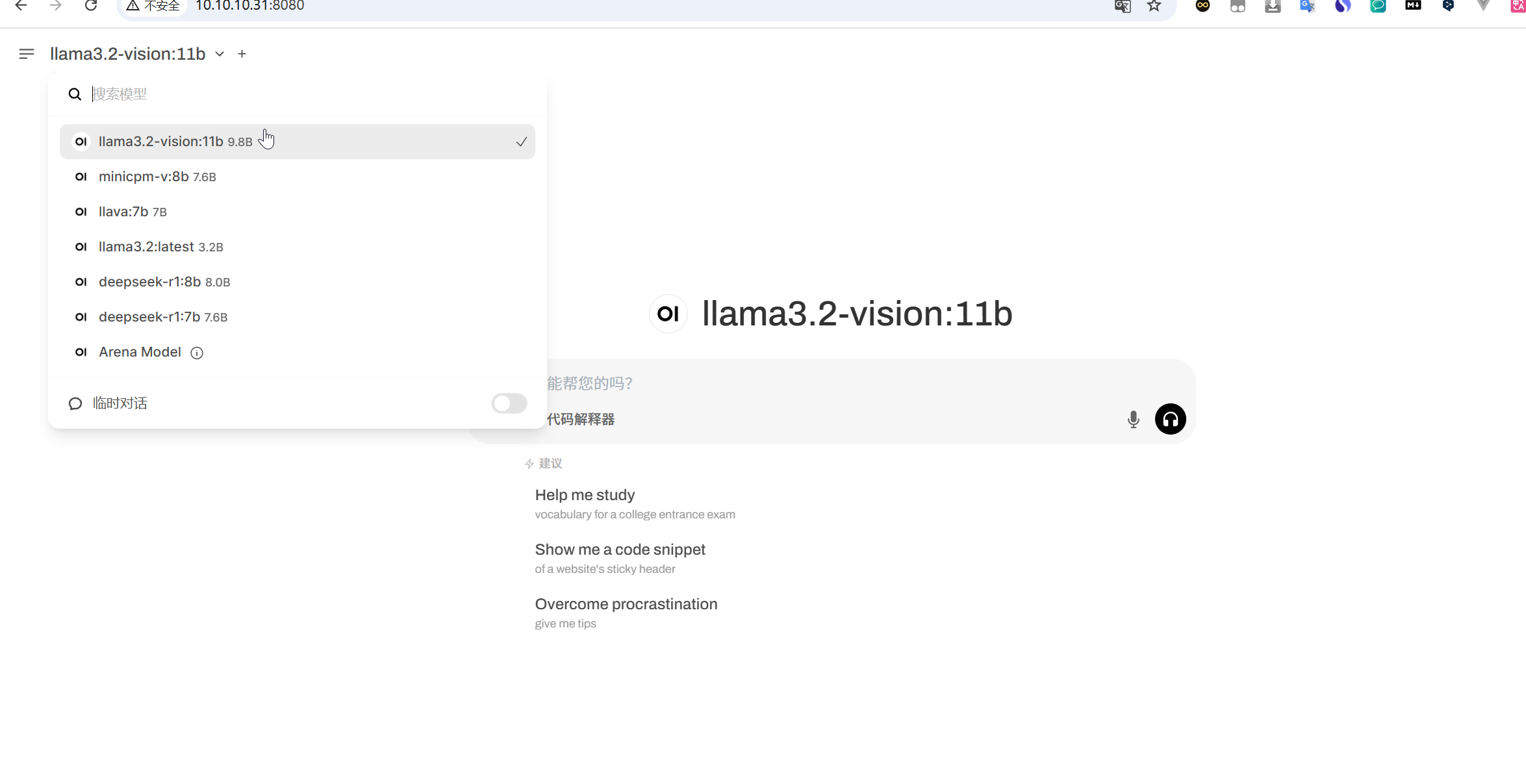

每次进入界面时都比较慢(主要看你服务器性能),等待一会即可。第一次进入会让你注册,注册一个即可

进入后会有你的模型列表,选择对应的

这里除了deepseek,其他模型也都是在ollama官网下载的。

llama3.2-vision是图片理解的模型(感觉不好用)

后面就可以输入内容玩了。

下载chatbox

chatbox要比open webui快很多

进不去就直接百度chatbox下载,下载安装好后

在设置里,这样选择,记得修改你的ip,端口不用改

然后在对话框就可以愉快的对话了

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)