【deepseek-r1】本地部署教程——基于Ollama,包括自定义安装目录

【deepseek-r1】本地部署教程——基于Ollama,包括自定义安装目录、自定义模型位置,模型选择、web-UI页面访问等

Ollama下载安装

Ollama是一个开源框架,专门设计用于在本地机器上快速部署和运行大型语言模型(LLM)

ollama官方网站 :https://ollama.com/

在官网下载适合自己系统的Ollama客户端。

下载完成后,如果直接安装,则默认安装位置在:C:\Users\XX\AppData\Local\Programs\Ollama

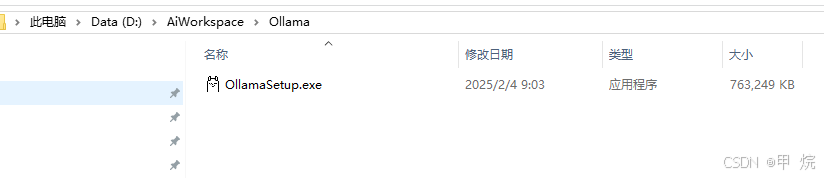

如果你像我一样,不想把软件安装在C盘,需要用命令行进行安装:

先创建好一个新文件夹,并把Ollama的安装包放在里面:

在文件路径上输入cmd回车后, 打开本目录下的命令行窗口,输入命令并回车:

OllamaSetup.exe /DIR=D:\AiWorkspace\Ollama

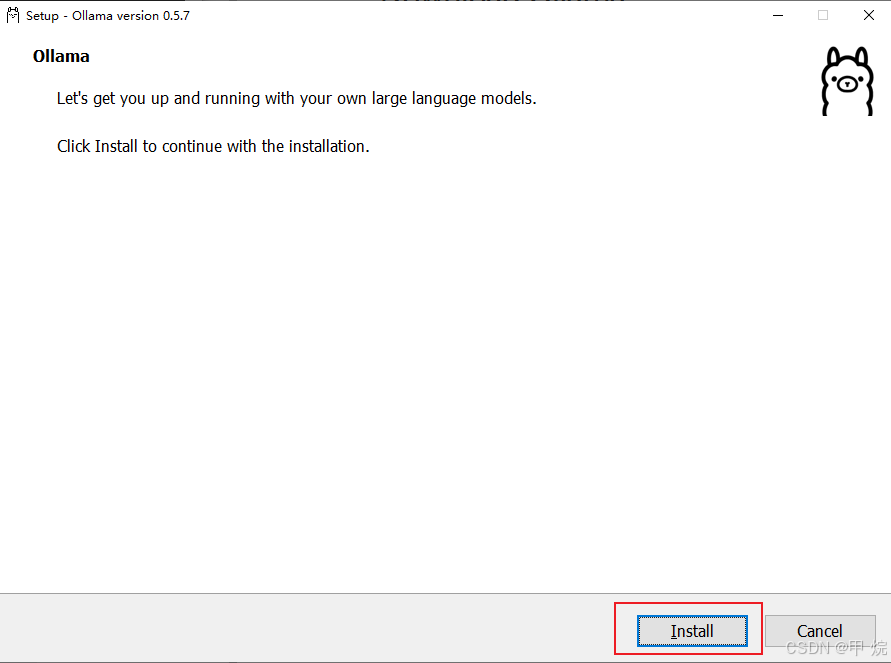

点击安装,之后 Ollama就会被安装在D:\AiWorkspace\Ollama文件夹下。

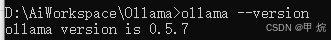

在命令行窗口运行命令以检查是否安装成功:

ollama --version

更改模型下载目录

如果直接在命令行运行 ollama run deepseek-r1:xxb的话,模型会被下载到默认路径:C:\Users\<用户名>\.ollama\models

我不想把模型放在C盘,可以通过设置环境变量OLLAMA_MODELS来更改模型的下载路径。

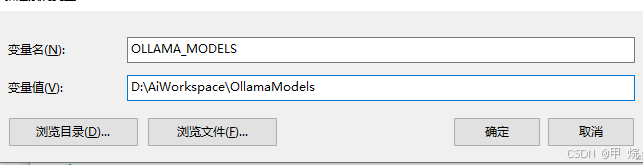

电脑左下角搜索环境变量,新增一个环境变量OLLAMA_MODELS,值为你希望模型安装的目录,例如我我的为:D:\AiWorkspace\OllamaModels

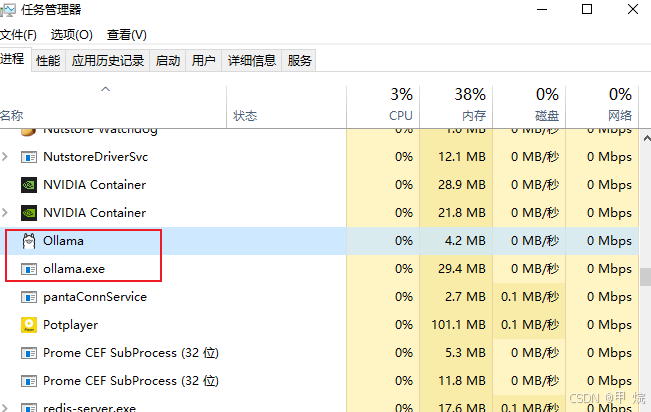

设置完环境变量后,需要重启Ollama以应用更改。可以通过任务管理器结束Ollama的进程,然后重新运行Ollama来实现重启。

模型下载部署

首先根据自己的电脑性能,选择对应大小的模型:

可参考:

| 模型大小 | GPU显存 |

|---|---|

| 1.5b | 4GB |

| 7b、8b | 8GB |

| 14b | 12GB |

| 32b | 24GB |

部署什么样的模型就运行哪个命令

# 1.5b 模型

ollama run deepseek-r1:1.5b

# 7b 模型

ollama run deepseek-r1:7b

# 8b 模型

ollama run deepseek-r1:8b

# 14b模型

ollama run deepseek-r1:14b

# 32b模型

ollama run deepseek-r1:32b

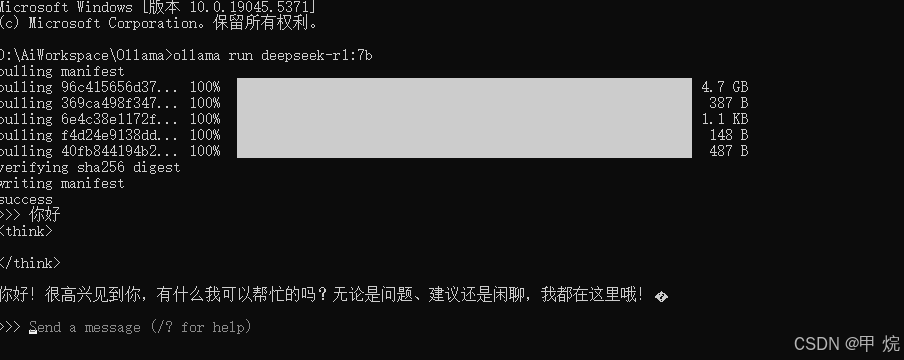

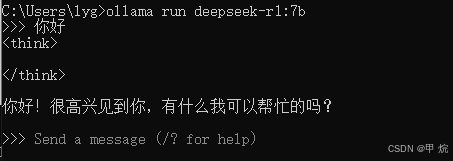

我的电脑显卡是4060,8G显存,因此我决定部署一个 7b的模型. 运行ollama run deepseek-r1:7b

模型回复速度还是很快的

如果你发现更改模型目录后,模型还是被下载到了C盘的C:\Users\<用户名>\.ollama\models目录下,可以把models文件夹中的全部内容拷贝到D盘想放置的目录,然后删除C:\Users\<用户名>\.ollama\models文件夹。

重新确认环境变量是否配置正常,并重启Ollama,然后输入命令,看能否正常找到模型:

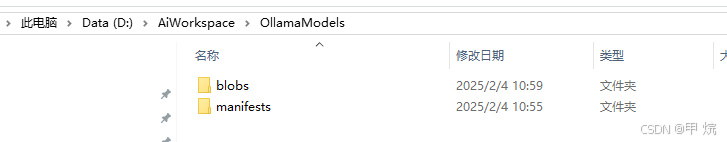

注意!模型文件在D盘应该是这样的:,目录注意和配置的环境变量OLLAMA_MODELS的值一致,不要多加一个models,

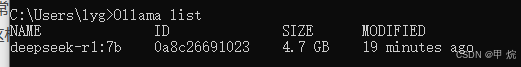

运行命令查看现有模型列表:

Ollama list

安装好模型后,再次运行run命令ollama run deepseek-r1:7b即可激活大模型:

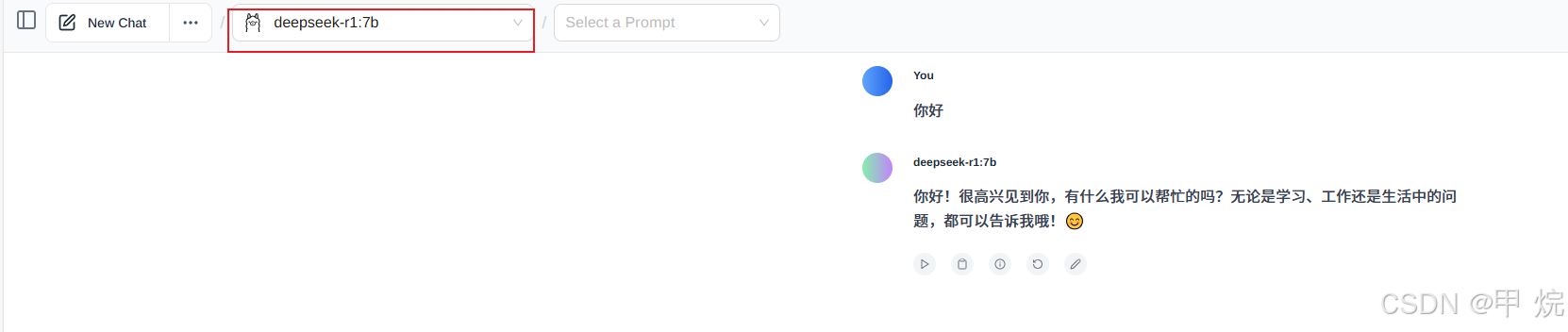

Web UI 控制端

上面的运行和测试都在终端实现,不太方便,如果想有个web页面使用本地大模型,可以使用一个插件:Page Assist - A Web UI for Local AI Models

直接浏览器搜索安装,我是在这里下载安装的:https://www.crxsoso.com/webstore/detail/jfgfiigpkhlkbnfnbobbkinehhfdhndo

浏览器地址访问:extension://jfgfiigpkhlkbnfnbobbkinehhfdhndo/options.html

选择本地部署的模型,即可在网页端使用。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)