【转载】单卡RTX 4090轻松部署Qwen QwQ-32B-AWQ!详细教程+性能实测-CSDN博客

本文转自:https://blog.csdn.net/scwang18/article/details/132996860🌟🌟听说用大模型做复杂任务很吃硬件?但今天我们要告诉你——不信?看完这篇教程,带你从环境配置到部署测试,分分钟体验320亿参数大模型的威力!

本文转自:https://blog.csdn.net/scwang18/article/details/132996860

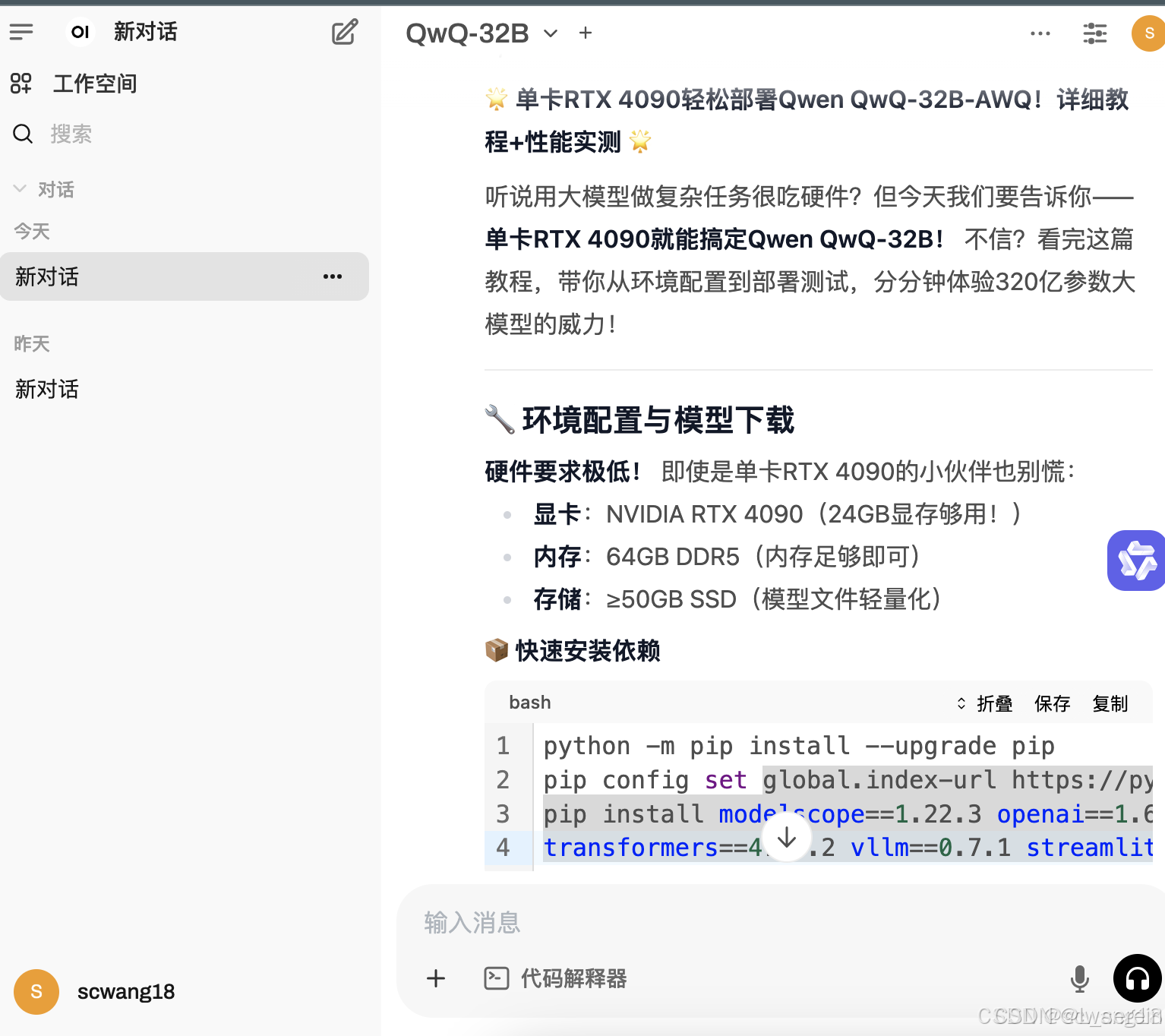

🌟 单卡RTX 4090轻松部署Qwen QwQ-32B-AWQ!详细教程+性能实测 🌟

听说用大模型做复杂任务很吃硬件?但今天我们要告诉你——单卡RTX 4090就能搞定Qwen QwQ-32B! 不信?看完这篇教程,带你从环境配置到部署测试,分分钟体验320亿参数大模型的威力!

🔧 环境配置与模型下载

硬件要求极低! 即使是单卡RTX 4090的小伙伴也别慌:

- 显卡:NVIDIA RTX 4090(24GB显存够用!)

- 内存:64GB DDR5(内存足够即可)

- 存储:≥50GB SSD(模型文件轻量化)

📦 快速安装依赖

python -m pip install --upgrade pip

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

pip install modelscope==1.22.3 openai==1.61.0 tqdm==4.67.1 \

transformers==4.48.2 vllm==0.7.1 streamlit==1.41.1

🚀 下载AWQ量化版模型

# 创建模型目录

mkdir /root/autodl-tmp/qwen-32b/ && cd /root/autodl-tmp/qwen-32b/

# 下载QWQ-32B-AWQ(显存仅需17.8GB,性能损失<3%!)

modelscope download --model qwen/QWQ-32B-AWQ

🌍 本地部署全流程

Step 1:使用vLLM启动API服务

创建启动脚本 start.sh:

#!/bin/bash

python -m vllm.entrypoints.openai.api_server \

--model /root/autodl-tmp/qwen-32b/QWQ-32B-AWQ \

--served-model-name QwQ-32B \

--max-model-len=4096 --port=8000

#--max-model-len=4096 --api-key scwang18 --port=8000

后台运行:

chmod +x start.sh

nohup ./start.sh >output.log 2>&1 &

Step 2:集成Open-WebUI进行可视化测试

安装并配置open-webui:

conda create

conda activate open-webui

pip install open-webui

创建 start.sh:

#!/bin/bash

export HF_ENDPOINT=https://hf-mirror.com

export ENABLE_OLLAMA_API=False

export OPENAI_API_BASE_URL=http://127.0.0.1:8000/v1

export DEFAULT_MODELS="QwQ-32B"

open-webui serve --port 6006

后台运行:

nohup ./start.sh >output.log _SCROLL 2>&1 &

💡 性能实测:速度与稳定性双杀!

登录 Open-Webui[http://localhost:6006],将这篇文章内容发给大模型,让他给我加工为一篇适合公众号发布的文章。效果如下:

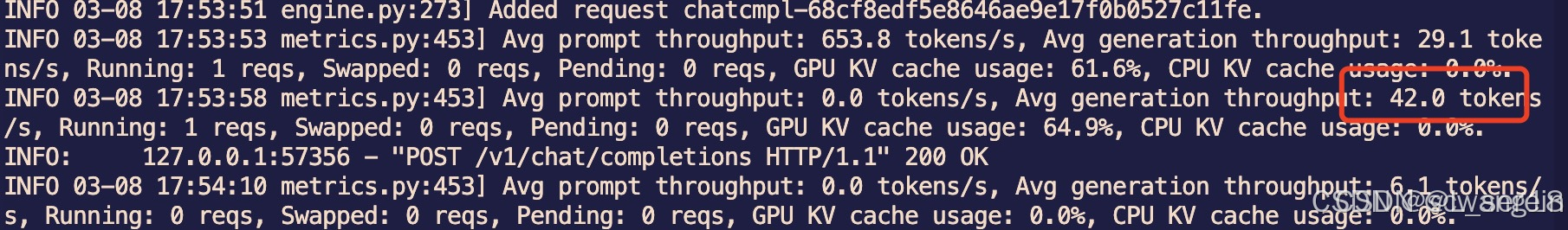

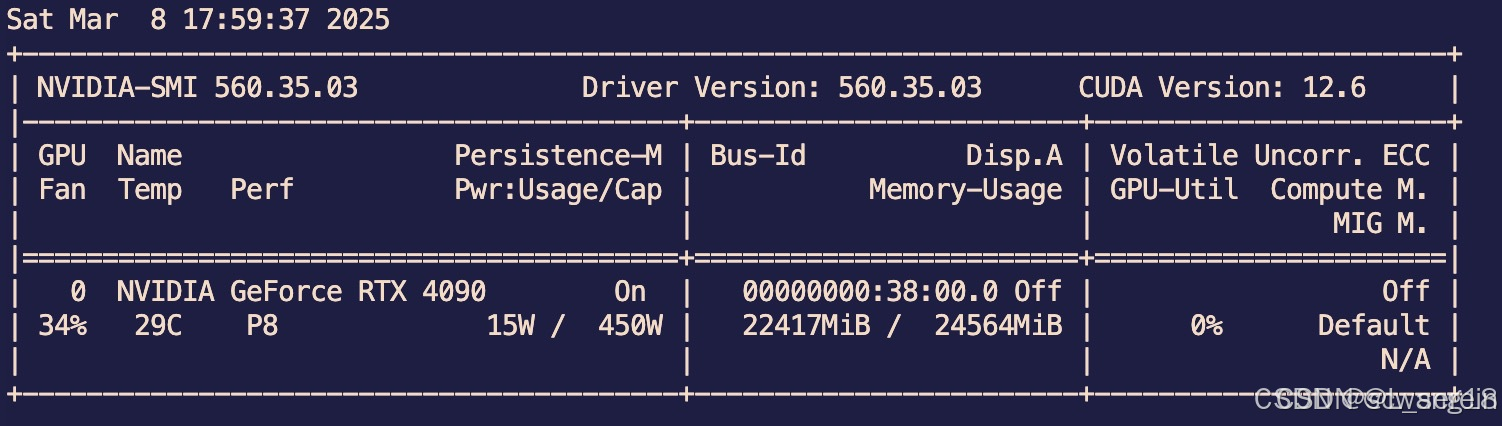

使用 vllm 部署qwen qwq-32b int4量化版的速度比较快,平均 token 达到 throughput: 42.0 tokens/s。如下图:

全部使用 GPU 进行运算,GPU 缓存用率 64.9%

🏆 结论:你的决策LLM不二之选!

单卡4090+QWQ-32B-AWQ这波操作,堪称性价比封神!

- 适用场景:作为Advanced Agent架构的核心LLM!

- 分析用户复杂需求,智能拆解任务

- 调用多个小模型并行处理

- 统一汇总结果并优化输出

- 优势总结:

- 量化技术降低显存压力,无需8卡集群

- 性能与原生模型几乎无差异,性价比碾压

结尾彩蛋

🤖偷偷告诉你:这篇干货满满的教程,正是用本地部署的QwQ-32B亲自操刀生成的!从技术解析到性能报告,连最后的卖萌表情包都是AI本尊的即兴创作~ 这波"自己写自己"的神操作,算不算大型真香现场?💻✨

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)