【Enriched entity representation of knowledge graph for text generation】文本生成知识图谱的丰富实体表达,论文解析,

您好,我们是一群热情洋溢的探索者,致力于深耕AiGC应用领域。我们的目标是挖掘、分析并分享那些能够启迪思维、推动科学进步的优质学术论文。我们坚信,知识的传播和交流是促进创新和社会发展的关键力量。

自我介绍:

您好,我们是一群热情洋溢的探索者,致力于深耕AiGC应用领域。我们的目标是挖掘、分析并分享那些能够启迪思维、推动科学进步的优质学术论文。我们坚信,知识的传播和交流是促进创新和社会发展的关键力量。

论文标题

Enriched entity representation of knowledge graph for text generation

文本生成知识图谱的丰富实体表达

论文链接

> https://arxiv.org/abs/1904.02342

摘要

文本生成时自然语言应用中的关键工具,生成可以通过几个句子表达出丰富想法的文本需要其内容的结构化表示。目前许多作品都利用基于图的方法去做图到文本的生成,例如知识图谱到文本生成。但是知识图谱中生成文本仍面临着很多问题,例如并不能完整的利用表示和实体信息在生成文本方面。

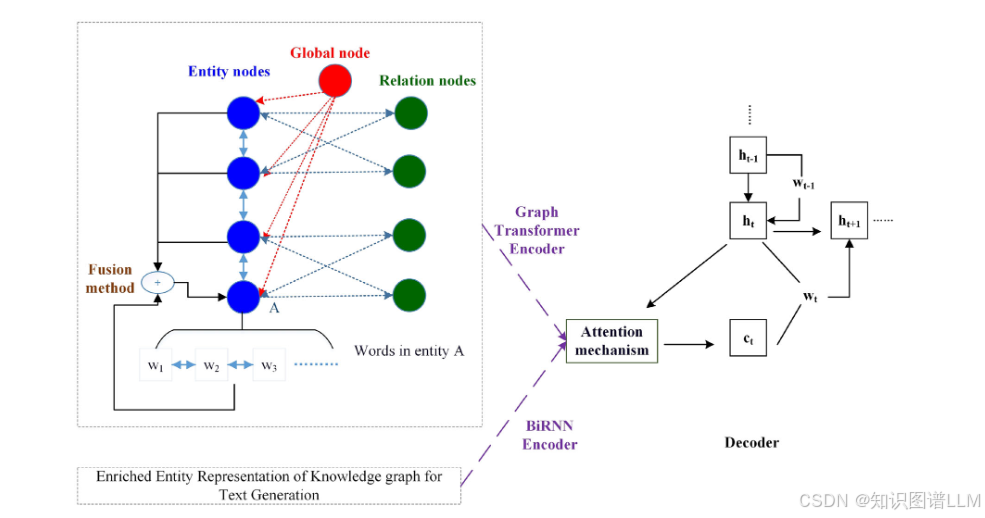

在本文中,我们聚焦于知识图谱到文本的生成,并且提出了一个多角度实体融合表示(MEFR)模型为解决上述这些问题,我们的模型引入了融合机制,该机制能够从单词级别和短语级别汇总节点表示形式,以获得知识图的丰富实体表示。采用Graph Transformer 来编码图并输出上下文节点表示,此外在解码阶段提出了基于 vanilla beam 搜索比较机制,该机制进一步考虑相似性以减少生成文本的重复信息。

介绍

根据输入文本的风格,可以分为以下三类:

- 文本到文本生成

- 数据到文本生成

- 图像到文本生成

在一些特殊领域,像是医学或者科学领域,很难去做表达合理且逻辑结构复杂的文本生成。一些研究想通过结构化的输入表达来为理解文章做贡献。这些方法有基于规则的方法或者基于模板的方法为结构化数据到文本生成做解决。由于其可解释性和可控性,这些方法通常很容易保证生成文本内容的正确性。

但是他们仍有一些局限性,高质量的模板往往需要手动构建;内容会有多样性、流利性和一致性方面的问题。基于神经网络的方法,人存在多种逻辑错误,幻觉问题。Graph Transformer作为Transformer的扩展对数据编码构建了基于图的注意力GAT,尽管这种结构已经捕获全局特征和局部结构提高生成表现能力,但充当关键实体仍未被表现出来。

主要贡献

- 多角度融合机制,即总和融合机制和选择融合机制,从单词级别和短语级别以获得实体表示。

- 提出了一种生成比较机制,在生成单词和未生成单词之间相似性,解决冗余的约束。

- 进行了研究,证明了有效性。

MEFR模型框架

模型的输入时与文档相对应的知识图,输入图和标题分别使用Graph Transformer和Bidirectional recurrent 网络编码。将标题视为附加节点,并在图形中用两个节点表示形式。解码时,使用基于注意力的RNN作为解码器并采用复制机制进行生成。

编码器

- 节点编码

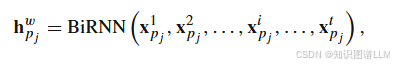

使用Birnn根据单词嵌入将每个实体的嵌入,使用以下公式:

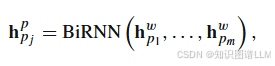

单词级别的实体嵌入,仍然使用BIRNN,应用于每个实体以捕获依赖性,并获得对实体的短语级表示:

-

融合机制

-

总和融合

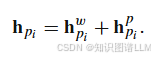

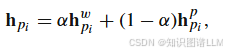

- 将上述单词级别和短语界别实体表示融合:

-

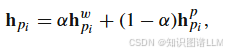

划分权重:

-

选择融合

-

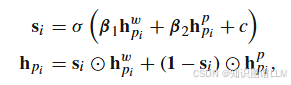

通过采用两个门控函数来融合特征,从而扩展并结合两个来源的隐藏状态。:

-

-

BIRNN和Graph Transformer编码

编码器的输入是一个知识图和一个标题,他们被编码使用BIRNN和Graph Transformer:标题采用BiRNN进行编码,知识图的节点使用Graph Transformer去编码,携带全局结构信息。

解码器

采用基于注意力的RNN作为模型的解码器。在每个解码时间步骤中,我们使用解码的隐藏状态分别计算上下文向量以获取知识图和标题。

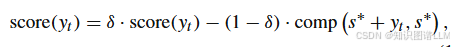

- 解码算法

PS:整理的PPT和资料稍后上传到公众号,直接回复论文名字,即可获取!

关注我们

欢迎大家关注我们的宫中皓,我们将会分享更多有关文本和AIGC相关的论文:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)