[特殊字符] 使用LLaMA-Factory快速训练你的专属大模型:从入门到“脑筋急转弯“大师

看完是不是手痒了?"听不如见,见不如做"——赶紧动手,才能真正掌握!遇到问题随时留言,我会化身AI急救员来帮你~ 💪。

大家好!我是每天分享AI大模型的顾潇✨!今天要带大家玩转一个超酷的开源框架——LLaMA-Factory,让你轻松打造属于自己的语言模型!

🌟 为什么选择LLaMA-Factory?

-

开箱即用:预置组件和模板,告别从零开始的痛苦

-

万能适配:支持多种框架和数据集,想怎么玩就怎么玩

-

专注创新:把时间花在创造价值上,而不是搭建环境

💻 环境准备:两条捷径任你选

本地安装

直接访问官网,跟着说明走就行~

云镜像懒人包(推荐新手)

我的云镜像开箱即用,已内置热门模型:

-

Yi-1.5-9B-Chat

-

Qwen2-7B

-

meta-llama-3.1-8b-instruct

-

glm-4-9b-chat

-

chatglm3-6b

🎯 实战开始:打造"脑筋急转弯"大师GLM-4

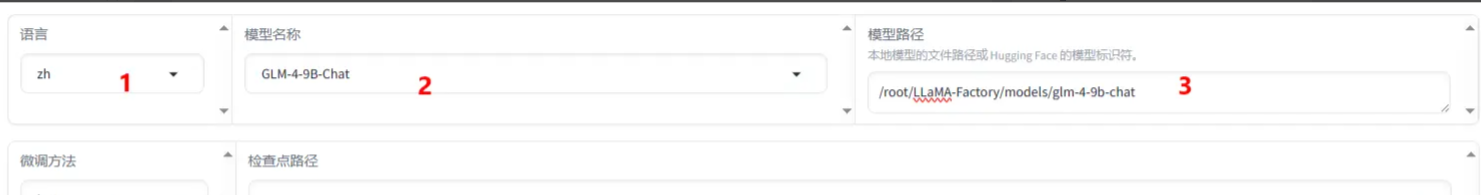

1️⃣ 选择基础模型

-

语言:zh(我们要调教中文模型)

-

模型选择:GLM-4-9B-Chat

-

模型路径:

/root/LLaMA-Factory/models/glm-4-9b-chat -

微调方法:LoRA(轻量又高效)

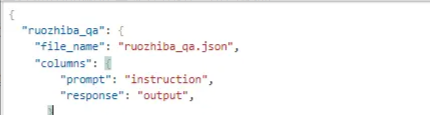

2️⃣ 准备训练数据

我们使用"弱智吧问答数据集"(名字很搞笑但内容很专业😆):

-

格式:alpaca

json

复制

// 数据集示例

{

"instruction": "什么车最长?",

"input": "",

"output": "堵车"

}

3️⃣ 训练参数设置(抄作业版)

| 参数 | 值 | 说明 |

|---|---|---|

| 数据集 | ruozhiba_qa | 我们自定义的数据集 |

| 学习率 | 1e-4 | 调大点学得快 |

| 计算类型 | bf16/fp16 | 新显卡选bf16 |

| 梯度累计 | 2 | 帮助模型更好学习 |

| LoRA+比例 | 16 | 效果比普通LoRA更佳 |

| LoRA作用模块 | all | 影响所有线性层 |

4️⃣ 开练!点击"开始"按钮

坐等进度条跑起来~(可以去泡杯咖啡☕)

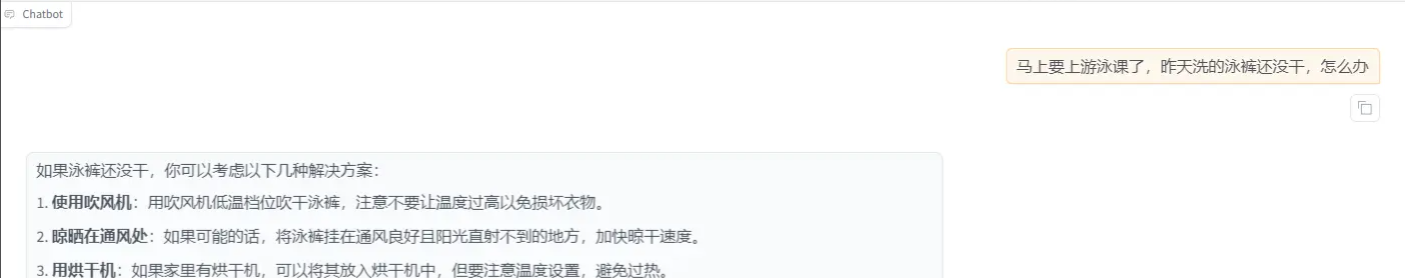

5️⃣ 效果对比测试

训练前:

用户:什么车最长? 模型:这个问题很有趣,根据我的知识...

训练后:

用户:什么车最长? 模型:堵车!因为可以堵好几公里呢!🚗💨

(这波是质的飞跃!)

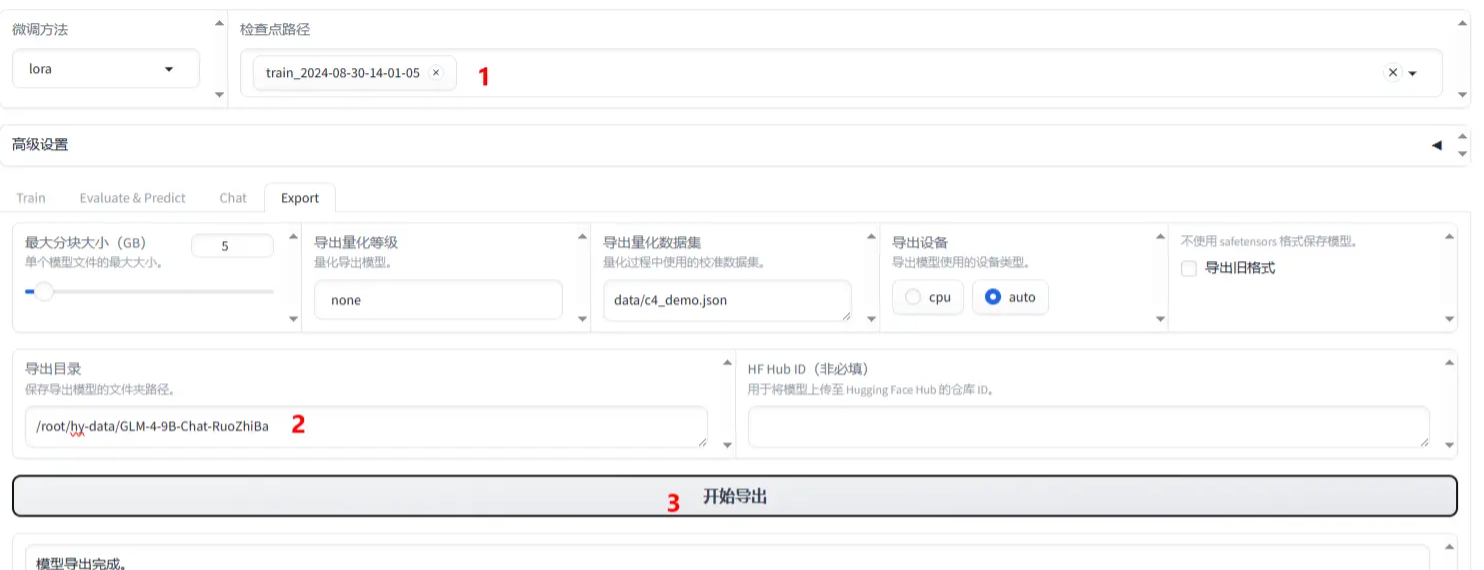

6️⃣ 导出完整模型

想把你的杰作带走?简单!

-

检查点路径:选你的LoRA模型

-

导出目录:服务器上的某个路径

-

点击"开始导出" → 搞定!

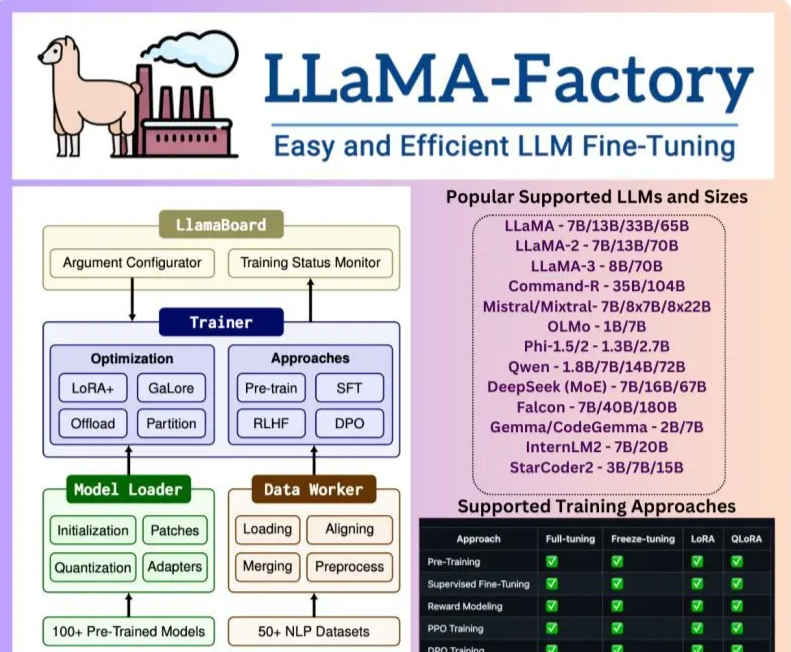

🏗️ LLaMA-Factory架构揭秘

四大核心组件:

-

LlamaBoard:控制中心,调参看状态

-

Trainer:训练方法任选(LoRA+/GaLoRe/DPO...)

-

Model Loader:模型加载处理专家

-

Data Worker:数据预处理小能手

支持的主流模型:

-

LLaMA全家桶(1/2/3代)

-

Mistral/Mixtral

-

Qwen

-

DeepSeek (MoE)

-

...等20+热门模型

🎉 结语

看完是不是手痒了?记住大师的名言:

"听不如见,见不如做"——赶紧动手,才能真正掌握!

遇到问题随时留言,我会化身AI急救员来帮你~ 💪

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)