强化学习两大应用方向:大模型训练与工业控制任务的核心算法解析

在OpenAI GPT系列模型的对齐训练中,PPO被用作基准算法,通过强化学习根据人类反馈(RLHF)优化模型输出,提升其安全性与生成质量。其核心思想是通过裁剪目标函数限制策略更新的幅度,从而避免训练过程中的剧烈波动。DPO是一种将强化学习问题转化为监督学习任务的算法,广泛用于大模型输出优化,如对话任务中安全性与一致性提升。强化学习在控制任务中可用于优化复杂系统中的动作决策,应对高维状态感知和连续

强化学习(Reinforcement Learning, RL)作为人工智能领域的重要技术,在生成式大模型和工业控制任务两大场景中展现了独特的价值。本文将深入剖析这两大领域的主流算法,聚焦其核心特点与设计思想,并结合关键公式和代表性应用进行详细分析。

一、控制任务的主流强化学习算法

强化学习在控制任务中可用于优化复杂系统中的动作决策,应对高维状态感知和连续动作空间的挑战,以实现精准、鲁棒的控制效果,即确保系统在动态环境中不仅能稳定运行,还能高效完成任务目标。以下,我们将介绍两种主流算法的特点及其应用:

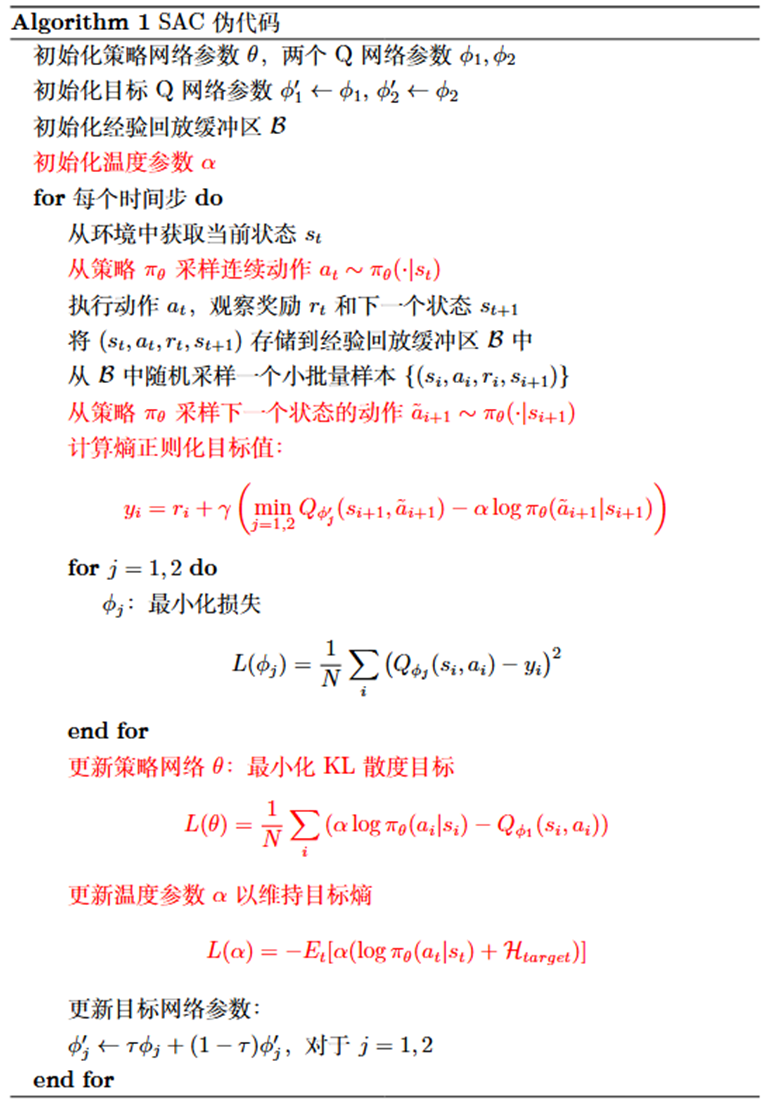

1、熵正则化与自适应探索:Soft Actor-Critic(SAC)[4]

SAC是一种off-policy强化学习算法,广泛应用于机器人控制,如机械臂操作和无人机导航。其将最大熵原理融入强化学习目标函数,实现探索与利用的自适应平衡,在复杂机器人控制任务中展现出卓越性能。其关键公式为:

核心特点

- 自适应探索:通过熵正则化技术,鼓励动作多样性,提升算法在复杂环境中的探索能力。

- 连续动作优化:支持高维连续动作空间的高效优化,适合物理控制任务

2、值分布建模新范式:Distributional Soft Actor-Critic(DSAC)[5]

DSAC在SAC基础上引入值分布建模,应用于风险敏感的物理控制任务,如自动驾驶中的风险感知与决策。其核心思想是捕捉回报不确定性,提供更全面的决策信息。其关键公式为:

- 值分布建模:用参数化高斯分布建模状态动作值函数的分布

,替代传统Q值期望估计,捕捉回报不确定性。

- 训练稳定:使用双值分布网络和基于方差调整梯度等技术,提升训练过程中的稳定性。

二、生成式大模型中的强化学习算法

生成式大模型通过强化学习优化其输出质量,通常利用人类反馈(Reinforcement Learning from Human Feedback, RLHF)来提升生成内容的质量与安全性,即确保输出不仅符合伦理规范,还能更好地满足用户需求。以下,我们将介绍三种主流算法的特点及其应用:

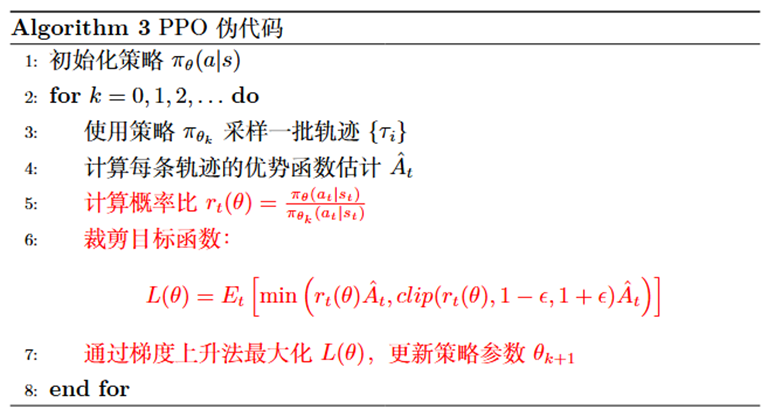

1、 近端策略优化:Proximal Policy Optimization(PPO)[1]

PPO 是一种on-policy的强化学习算法,以训练稳定性著称。在OpenAI GPT系列模型的对齐训练中,PPO被用作基准算法,通过强化学习根据人类反馈(RLHF)优化模型输出,提升其安全性与生成质量。其核心思想是通过裁剪目标函数限制策略更新的幅度,从而避免训练过程中的剧烈波动。其关键公式为:

其中,表示新旧策略的概率比,

为裁剪阈值。

核心特点

- 训练稳定:裁剪机制通过限制概率比的范围,通常为

,有效约束每次策略更新的步幅,使得训练过程更加平滑可控。

- 适合微调:其稳定性特别适合对预训练大模型进行微调,逐步优化输出对齐用户期望

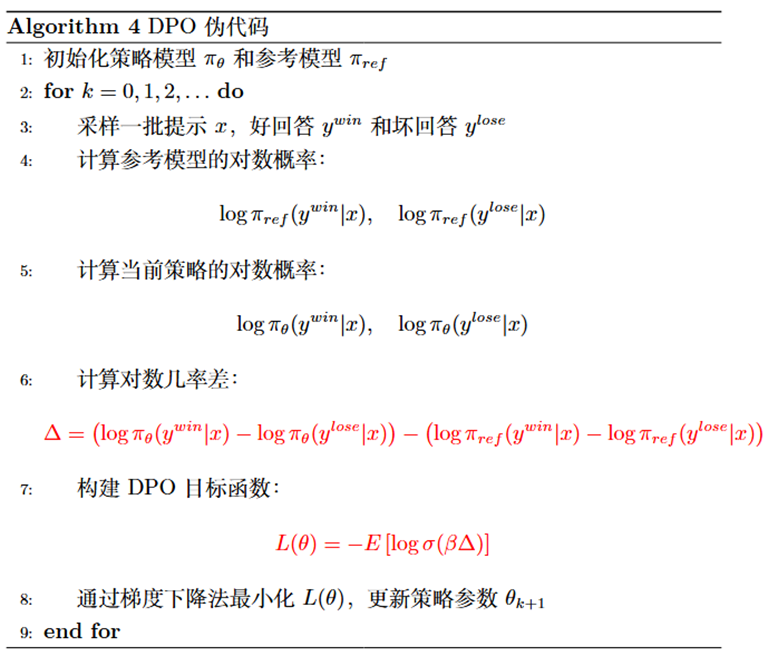

2、直接偏好优化:Direct Preference Optimization(DPO)[2]

DPO是一种将强化学习问题转化为监督学习任务的算法,广泛用于大模型输出优化,如对话任务中安全性与一致性提升。其核心思想是基于人类偏好标签数据直接调整策略,省去奖励模型和复杂优化步骤。在多项实验中,DPO表现优于PPO,其关键公式为:

核心特点

- 流程简化:无需显式奖励模型,直接利用偏好标签数据调整策略。

- 高效稳定:采用二元交叉熵损失,计算复杂度低。

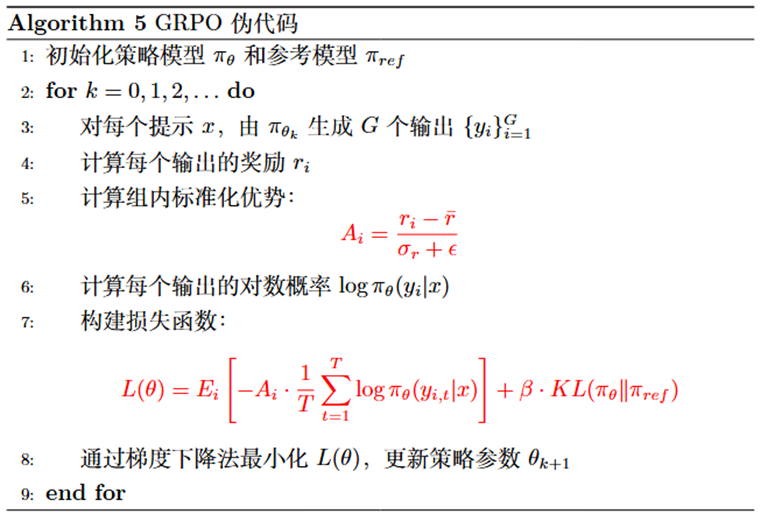

3、 组相对策略优化:Group Relative Policy Optimization(GRPO)[3]

GRPO是通过一组数据对比来优化策略,在DeepSeek-R1中显著提升了大模型的推理能力。其核心思想是生成多组回答并动态计算优势值,省去传统价值网络。其关键公式为:

核心特点

- 组内对比优化:通过生成多组回答并基于奖励均值和标准差计算标准化优势值,省去传统价值网络,降低训练复杂度的同时,提升样本利用效率。

- 高效策略更新:多输出对比机制充分利用每次采样数据,推动策略快速向高质量输出收敛,适合复杂推理任务。

参考文献

[1] Haarnoja T, Zhou A, Abbeel P, et al. Soft actor-critic: Off-policy maximum entropy deep reinforcement learning with a stochastic actor[C]//International conference on machine learning. Pmlr, 2018: 1861-1870.

[2] Duan J, Wang W, Xiao L, et al. Distributional Soft Actor-Critic With Three Refinements[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2025.

[3] Schulman J, Wolski F, Dhariwal P, et al. Proximal policy optimization algorithms[J]. arXiv preprint arXiv:1707.06347, 2017.

[4] Rafailov R, Sharma A, Mitchell E, et al. Direct preference optimization: Your language model is secretly a reward model[J]. Advances in Neural Information Processing Systems, 2023, 36: 53728-53741.

[5]Guo D, Yang D, Zhang H, et al. Deepseek-r1: Incentivizing reasoning capability in llms via reinforcement learning[J]. arXiv preprint arXiv:2501.12948, 2025.

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)