借微信小程序“AI发型魔方”,解密零代码智能体开发

这类智能体基于代理模式和 ReAct 范式(推理→行动→观察→下一步计划),执行路径充满不确定性,是一种动态的、由模型决策驱动的工作方式,与Dify这类可视化、预设的 “工作流引擎” 有着本质区别。在人工智能(AI)和计算机科学领域,智能体指的是一个存在于某种环境中的计算系统(可以是软件、也可以是软件与硬件的结合体),它能够感知环境的状态,并根据感知到的信息以及自身的目标/任务,自主地做出决策并执

上个月发布的微信小程序“AI发型魔方”,上线后收到了不少朋友的体验反馈,效果还不错!今天就带大家一探究竟,看看它究竟是如何诞生的!(感兴趣的小伙伴可以扫码体验,解锁专属发型推荐哦~)

这款小程序最大的亮点,在于它实现了完全零代码开发,而且能一键发布。如此高效的开发速度完全得益于当下炙手可热的AI智能体技术。借助AI智能体,业务逻辑搭建与用户页面设计都变得轻松简单。

许多科技巨头和创业公司都投入重金押注这一领域,比如前阵子火爆的“Manus”,其本质就是一个强大的智能体。虽然目前的智能体技术还不够完美,但它无疑是未来的大势所趋,是一场真正的技术革命。作为开发者,我们必须拥抱这股浪潮,必须要顺势而为。

首先,让我们明确智能体的官方定义:

在人工智能(AI)和计算机科学领域,智能体指的是一个存在于某种环境中的计算系统(可以是软件、也可以是软件与硬件的结合体),它能够感知环境的状态,并根据感知到的信息以及自身的目标/任务,自主地做出决策并执行动作,以最大限度地达成其目标或完成任务。

为了让大家更直观地感受智能体的开发过程,我想分享一下自己使用 Manus 的一次开发体验。虽然最终交付的成果未能完全达到我的预期,但这已经展现出智能体的雏形。

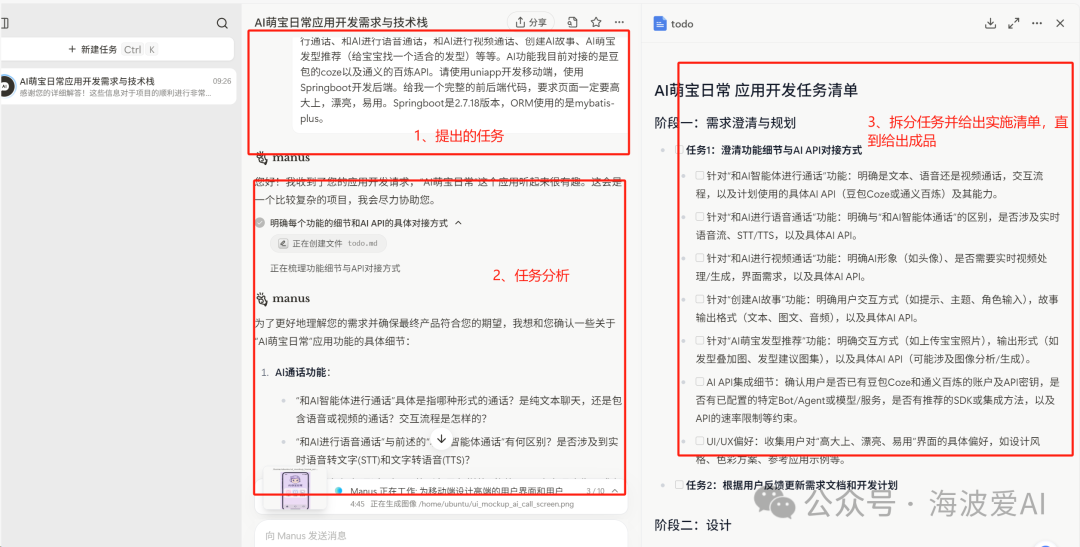

我首先向manus详细描述了我的需求,我想开发一个什么软件,我希望达到什么效果,都需要有哪些模块。manus在进行需求分析后,对任务进行了拆分,并给出了实施方案。

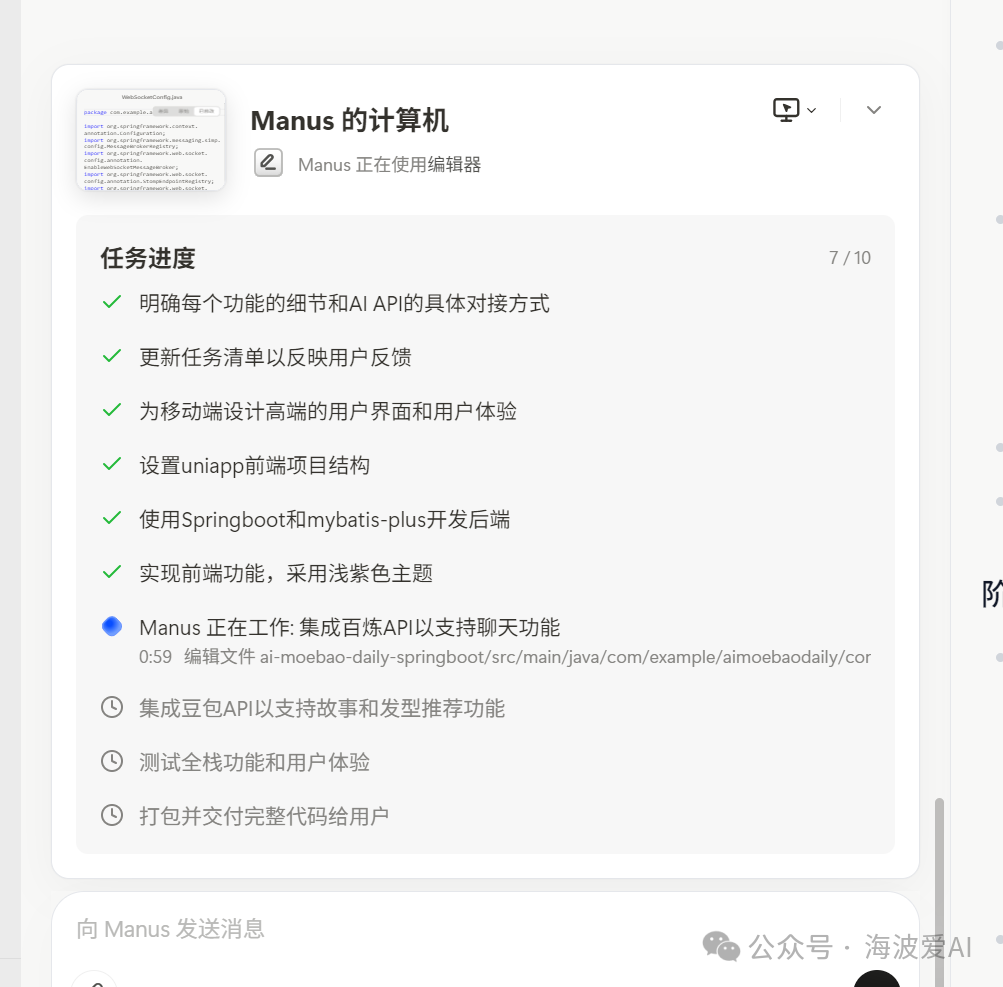

随后,Manus 要求我补充一些细节问题。得到信息后,它就开始工作,耗时约一小时,最终提供了一个软件包给我。

简单说,智能体的核心在于“自主决策执行”,成为用户与大模型之间的高效代理。 举个例子,以往我们用大模型开发一个简单抽奖系统,需要多次人工交互、逐步指导、不断调整。但有了智能体,这些繁杂的协调和执行过程就能大幅减少。

未来的理想状态是:用户只需作为“产品经理”提出需求,智能体便能自主完成需求分析、设计、开发、测试、部署等全流程,最终交付可用产品。 这将极大减少人力投入、大幅缩短开发周期。可以预见,未来公司的研发团队或许会更精简高效,也许只需要几个人的研发团队即可。看到这里,大家会发出灵魂拷问:大家未来都要失业吗?其实大可不必担忧!技术革命向来是淘汰旧岗位、催生新机遇。只要我们持续学习、与时俱进,就能拥抱这片蓝海。

了解了智能体的作用后,相信不少读者心中会有疑问:智能体究竟是如何实现的?它的自主决策能力又是怎样达成的呢?

当前开发智能体的主要方式是借助开源的工具和框架,比较著名的有Dify、ModelScope-Agent等工具,如果想用框架自己开发,可以选择LangChain、MetaGPT等。

像Dify这种工具,它提供了可视化的在线编排器,用户可以通过编排工作流来开发智能体。说到工作流,大家对BPM应该并不陌生。智能体工作流虽然和传统工作流看似相似,但前者主要依赖大语言模型(LLM)进行推理、决策与执行。

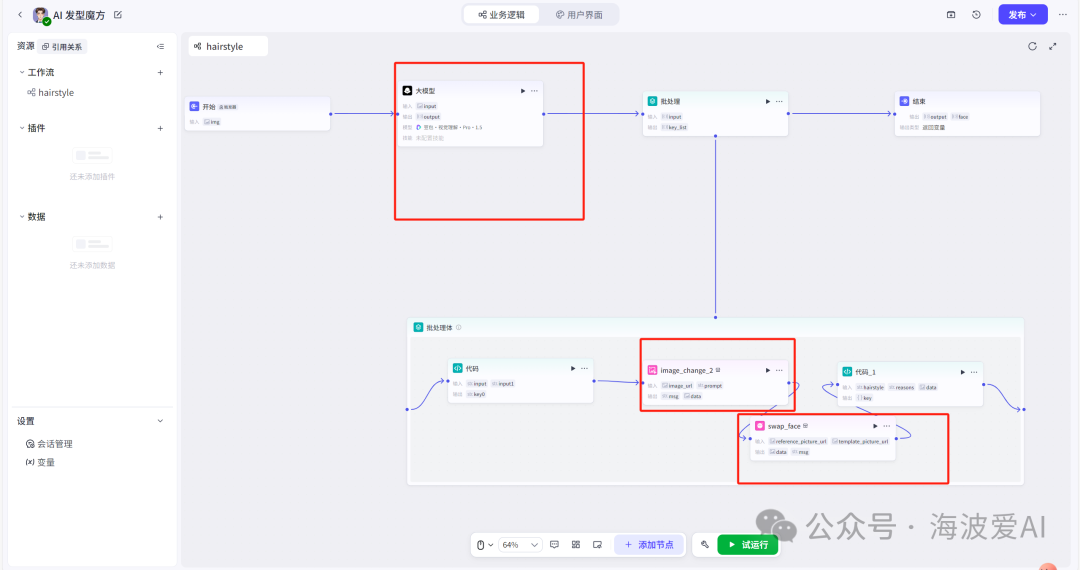

以我发布的“AI发型魔方”小程序为例子,红色框圈定的是涉及到LLM的地方。

该工作流简单的思想:用户上传图片后,大模型依据预设的系统提示词解析图片,并按照既定的数据结构输出结果;接着对输出数据进行批处理,生成四张推荐发型;若需继续处理任务,会再次调用大模型替换发型,最终返回包含四张替换发型数据的 List。

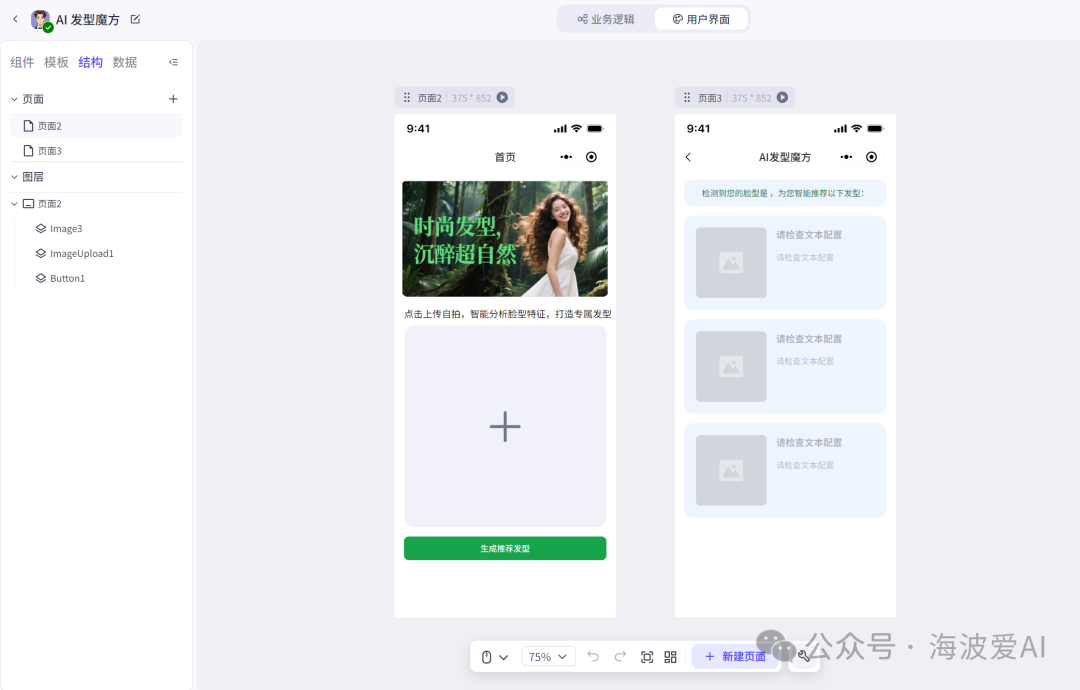

在前端页面开发上,同样无需编写代码,只需要通过拖拉拽完成乐高式搭建即可。产品经理对这个最熟悉了,当前主流的原型图画图工具如Figma、Axure RP都是这么干的。区别在于,这个画完了可以转成智能体前端代码。

也就是说,开发 “AI发型魔方”,我只做了两件事:编排工作流和拖拽搭建用户页面。

不过,通过可视化工具编排工作流只是智能体开发的其中一种方式。我们也可以直接使用Python框架,如LangChain、MetaGPT等进行编码开发。我认为,框架开发的智能体更能体现其本质。这类智能体基于代理模式和 ReAct 范式(推理→行动→观察→下一步计划),执行路径充满不确定性,是一种动态的、由模型决策驱动的工作方式,与Dify这类可视化、预设的 “工作流引擎” 有着本质区别。以LangChain为例,它的核心思想是:Agent分析用户输入后,由LLM自主决定下一步操作,比如调用外部工具(Function Call或MCP调用),最后将执行结果反馈给用户。

下面是一个简单的示例(该示例仅仅用来展示如何开发智能体)

from langchain_openai import ChatOpenAI

from langchain.agents import AgentExecutor, create_openai_tools_agent

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

from langchain_community.tools import DuckDuckGoSearchResults, ArxivQueryRun

from langchain_community.utilities import WikipediaAPIWrapper

# 初始化LLM模型

llm = ChatOpenAI(model="deepseek-R1", temperature=0, api_key="224442")

# 定义工具集

tools = [

DuckDuckGoSearchResults(name="web_search", description="搜索网络获取最新信息"),

ArxivQueryRun(name="arxiv_search", description="搜索学术论文和科研文章"),

WikipediaAPIWrapper(name="wikipedia", description="查询维基百科知识"),

]

# 定义Agent提示模板

prompt = ChatPromptTemplate.from_messages([

("system", """您是一个强大的AI助手,可以访问各种工具来解决问题。

请遵循以下规则:

1. 清晰解释您的思路

2. 使用工具获取必要信息

3. 根据工具结果给出最终答案"""),

MessagesPlaceholder("chat_history", optional=True),

("human", "{input}"),

MessagesPlaceholder("agent_scratchpad")

])

# 创建智能体

agent = create_openai_tools_agent(llm, tools, prompt)

# 创建执行器

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# 运行智能体

response = agent_executor.invoke({

"input": "请比较GPT-4和Llama3的最新技术差异,并总结一篇2025年关于ViT的顶会论文的核心贡献",

"chat_history": [] # 可添加历史对话

})

# 打印响应

print("最终回答:")

print(response["output"])今天的分享就到这里,洋洋洒洒写了1600多字。关于智能体的开发还有许多有趣的内容,下期我将为大家介绍新开发的AI小程序,记得持续关注哦!

欢迎关注我的微信公众号:海波爱AI

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)