“懒人“的深度学习:Keras如何让你少写代码多发Paper?

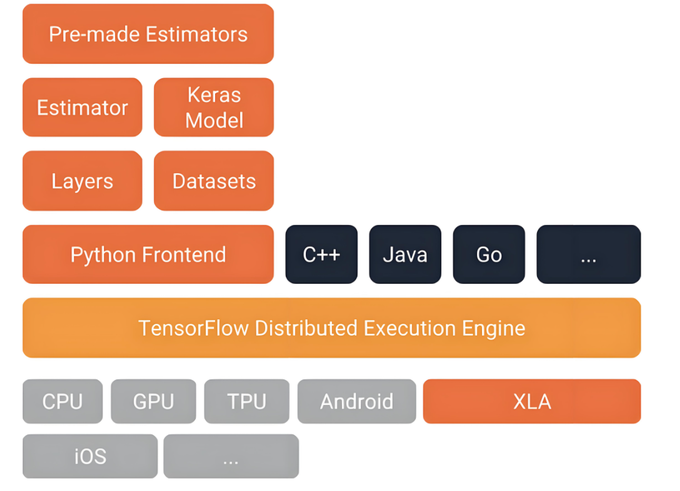

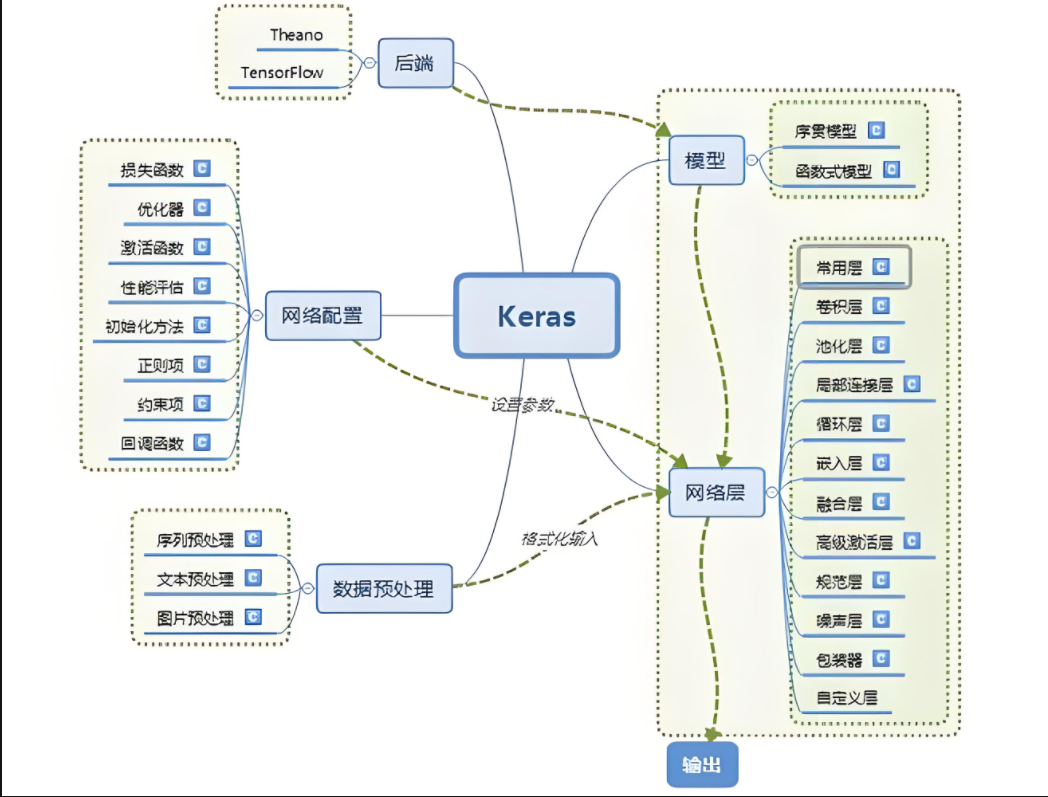

在深度学习领域,Keras作为TensorFlow的高层API,以其简洁优雅的接口设计和高效的模型构建能力,已成为众多AI开发者的首选工具。本文将深入探讨Keras高层API的核心技术特性,揭示其如何简化深度学习工作流程,同时保持足够的灵活性和性能。Keras高层API通过精心设计的抽象,成功平衡了易用性与灵活性,使开发者能够快速实现从原型到生产的过程。随着TensorFlow生态的不断演进,Ke

加关注不迷路。本文较长,建议点赞收藏以免遗失。由于文章篇幅有限,点击左下角阅读原文,可免费领取AI大模型高薪岗位必备技能资料,实力宠粉!

引言

在深度学习领域,Keras作为TensorFlow的高层API,以其简洁优雅的接口设计和高效的模型构建能力,已成为众多AI开发者的首选工具。本文将深入探讨Keras高层API的核心技术特性,揭示其如何简化深度学习工作流程,同时保持足够的灵活性和性能。

一、Keras高层API设计哲学

Keras遵循"用户友好、模块化、可扩展"的设计原则,其高层API体现了几个关键理念:

极简主义

:通过减少认知负担,让开发者专注于模型设计而非实现细节

渐进式复杂度

:从简单到复杂的模型构建路径平滑过渡

约定优于配置

:提供合理的默认值,减少样板代码

# 典型Keras模型构建示例from tensorflow.keras import layersmodel = tf.keras.Sequential([ layers.Dense(64, activation='relu'), layers.Dense(10, activation='softmax')])二、核心API组件解析

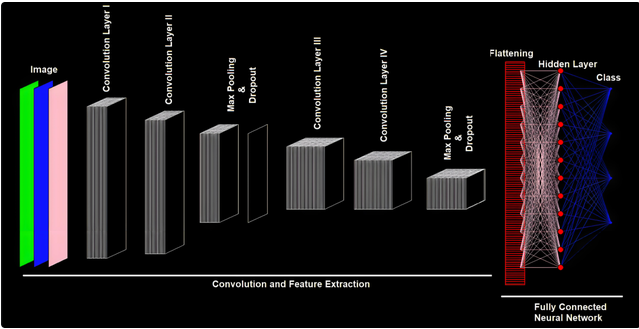

1. Layers API:构建模型的基础模块

Keras提供了丰富的预定义层类型,涵盖从基础的全连接层到复杂的注意力机制:

# 各种层的使用示例conv_layer = layers.Conv2D(32, (3, 3), activation='relu')lstm_layer = layers.LSTM(64, return_sequences=True)attention_layer = layers.MultiHeadAttention(num_heads=2, key_dim=2)高级技巧:自定义层通过继承tf.keras.layers.Layer

实现:

class CustomLayer(layers.Layer): def __init__(self, units=32): super().__init__() self.units = units def build(self, input_shape): self.w = self.add_weight( shape=(input_shape[-1], self.units), initializer="random_normal", trainable=True, ) self.b = self.add_weight( shape=(self.units,), initializer="random_normal", trainable=True ) def call(self, inputs): return tf.matmul(inputs, self.w) + self.b2. Models API:模型构建的两种范式

(1) Sequential API

model = tf.keras.Sequential([ layers.Dense(64, activation='relu', input_shape=(784,)), layers.Dense(64, activation='relu'), layers.Dense(10)])

(2) Functional API

inputs = tf.keras.Input(shape=(784,))x = layers.Dense(64, activation='relu')(inputs)x = layers.Dense(64, activation='relu')(x)outputs = layers.Dense(10)(x)model = tf.keras.Model(inputs=inputs, outputs=outputs)

性能对比:Functional API支持更复杂的拓扑结构,如多输入/输出、共享层等。

3. 训练与评估API

Keras将训练过程抽象为几个关键组件:

model.compile( optimizer=tf.keras.optimizers.Adam(learning_rate=1e-3), loss=tf.keras.losses.SparseCategoricalCrossentropy(from_logits=True), metrics=[tf.keras.metrics.SparseCategoricalAccuracy()],)history = model.fit( train_dataset, epochs=10, validation_data=val_dataset, callbacks=[tf.keras.callbacks.EarlyStopping(patience=3)])高级特性

自定义训练循环:

通过train_step和test_step方法覆盖

混合军共渡训练:tf.keras.mixed_precision.set_global_policy('mixed_float16')

分布式训练:

tf.distribute.MirroredStrategy()

三、Keras API的高级特性

1. 预构建模型与迁移学习

base_model = tf.keras.applications.EfficientNetB0(include_top=False)base_model.trainable = False # 冻结基础模型inputs = tf.keras.Input(shape=(224, 224, 3))x = base_model(inputs, training=False)x = layers.GlobalAveragePooling2D()(x)outputs = layers.Dense(10)(x)model = tf.keras.Model(inputs, outputs)

2. 自定义损失函数与指标

class CustomLoss(tf.keras.losses.Loss): def __init__(self, regularization_factor=0.1): super().__init__() self.regularization_factor = regularization_factor def call(self, y_true, y_pred): mse_loss = tf.reduce_mean(tf.square(y_true - y_pred)) reg_loss = tf.reduce_sum(self.regularization_factor * tf.abs(y_pred)) return mse_loss + reg_loss

3. 模型保存与部署

# 保存完整模型model.save('path_to_model')# 保存为TensorFlow Serving格式tf.saved_model.save(model, 'path_to_saved_model')# 转换为TFLiteconverter = tf.lite.TFLiteConverter.from_keras_model(model)tflite_model = converter.convert()

四、性能优化技巧

数据管道优化:

dataset = tf.data.Dataset.from_tensor_slices((x_train, y_train))dataset = dataset.shuffle(buffer_size=1024).batch(64).prefetch(tf.data.AUTOTUNE)混合精度训练:

tf.keras.mixed_precision.set_global_policy('mixed_float16')XLA加速

tf.config.optimizer.set_jit(True)模型剪枝与量化

import tensorflow_model_optimization as tfmotprune_low_magnitude = tfmot.sparsity.keras.prune_low_magnitude五、Keras与TensorFlow生态的集成

-

TensorBoard集成:

tensorboard_callback = tf.keras.callbacks.TensorBoard(log_dir='./logs')model.fit(..., callbacks=[tensorboard_callback]) -

TFX管道集成:

from tfx.components import Trainertrainer = Trainer( module_file=module_file, examples=example_gen.outputs['examples'], train_args=trainer_pb2.TrainArgs(num_steps=10000), eval_args=trainer_pb2.EvalArgs(num_steps=5000)) -

TensorFlow.js转换:

tensorflowjs_converter --input_format keras model.h5 model_js

六、实战案例:构建端到端图像分类系统

# 1. 数据准备train_ds = tf.keras.preprocessing.image_dataset_from_directory( 'data/train', image_size=(180, 180), batch_size=32)# 2. 构建模型base_model = tf.keras.applications.Xception( weights='imagenet', input_shape=(180, 180, 3), include_top=False)base_model.trainable = Falseinputs = tf.keras.Input(shape=(180, 180, 3))x = tf.keras.applications.xception.preprocess_input(inputs)x = base_model(x, training=False)x = layers.GlobalAveragePooling2D()(x)x = layers.Dropout(0.2)(x)outputs = layers.Dense(5)(x)model = tf.keras.Model(inputs, outputs)# 3. 训练配置model.compile( optimizer=keras.optimizers.Adam(), loss=keras.losses.SparseCategoricalCrossentropy(from_logits=True), metrics=[keras.metrics.SparseCategoricalAccuracy()],)# 4. 训练与评估model.fit(train_ds, epochs=20, validation_data=val_ds)# 5. 微调base_model.trainable = Truemodel.compile( optimizer=keras.optimizers.Adam(1e-5), # 更低的学习率 loss=keras.losses.SparseCategoricalCrossentropy(from_logits=True), metrics=[keras.metrics.SparseCategoricalAccuracy()],)model.fit(train_ds, epochs=10, validation_data=val_ds)

七、Keras API的未来发展

-

Keras 3.0特性前瞻:

多后端支持(TensorFlow、JAX、PyTorch)

更灵活的模型导出格式

增强的动态形状支持

-

与AI研究前沿的集成:

内置扩散模型支持

改进的Transformer API

强化学习工具包

结语

Keras高层API通过精心设计的抽象,成功平衡了易用性与灵活性,使开发者能够快速实现从原型到生产的过程。随着TensorFlow生态的不断演进,Keras将继续作为深度学习应用开发的重要入口点。掌握其核心技术特性,将帮助开发者在AI项目中事半功倍。

最佳实践建议:

-

从Sequential API开始,逐步过渡到Functional API

-

充分利用预训练模型和迁移学习

-

使用回调机制实现训练过程的可观测性

-

重视数据管道的优化

-

https://ai.guangjuke.com/

阅读上方原文链接获取更多涨薪知识点

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)