什么是大模型应用两大框架(LlamaIndex、LangChain)和四大核心技术(提示词工程、RAG、MCP、智能体)

在AI大模型技术井喷的今天,如何高效构建智能应用成为开发者关注的焦点。无论是企业级知识库的搭建,还是复杂工作流的自动化,LlamaIndex和LangChain两大框架,以及提示词工程、RAG、MCP、智能体四大核心技术,正在成为开发者手中的“利器”。本文将系统梳理这些工具与技术的核心逻辑,助你快速掌握大模型落地的关键能力。

一、前言

在AI大模型技术井喷的今天,如何高效构建智能应用成为开发者关注的焦点。无论是企业级知识库的搭建,还是复杂工作流的自动化,LlamaIndex和LangChain两大框架,以及提示词工程、RAG、MCP、智能体四大核心技术,正在成为开发者手中的“利器”。本文将系统梳理这些工具与技术的核心逻辑,助你快速掌握大模型落地的关键能力。

二、两大框架:LlamaIndex vs LangChain

1. LlamaIndex:企业级大模型应用的“瑞士军刀”

1)背景与定位

LlamaIndex(原名GPT Index)是一个专为企业级大模型应用设计的开源框架。它的核心目标是简化大模型的访问、管理和集成,专为增强大模型的检索能力而生,其核心在于高效的数据索引与语义搜索,支持开发者快速构建基于LLM的复杂应用。

通过模块化设计和统一接口,LlamaIndex降低了开发门槛,成为企业落地大模型的首选工具。

LlamaIndex是构建领域知识检索的引擎,成为数据检索的“专家”,它通过以下步骤实现领域知识的精准问答:

索引阶段:将结构化、非结构化数据(如PDF、数据库)转化为向量索引,支持快速语义匹配;

查询阶段:用户提问时,系统检索最相关的数据片段,结合大模型生成答案。

2)核心功能

- 统一接口:LlamaIndex定义了一套标准化接口(如BaseLLM),开发者可以通过一致的方式调用不同模型(如OpenAI、Llama、本地部署模型),并灵活切换模型参数。

- 模块化架构:框架分为索引层(Index)、检索层(Retriever)、查询引擎层(Query Engine)等模块,支持开发者按需组合功能。例如,通过索引层构建向量数据库,通过查询引擎实现多步骤推理。

- 企业级适配:LlamaIndex支持私有数据的接入(如企业知识库),并通过安全机制(如权限控制)保障数据隐私。例如,企业可以将内部文档转化为向量数据,结合LLM生成定制化回答。

3)技术架构与实现原理

LlamaIndex 的核心架构围绕高效索引与语义检索展开,其技术实现可分为三个层次:

-

数据连接层:支持 PDF、数据库、API 等 20+ 数据源接入,通过数据连接器(Connectors)将异构数据统一转化为文本节点(Nodes)。

-

索引管理层:提供多种索引类型,包括:

-

向量存储索引:基于嵌入向量实现语义检索,适合大规模非结构化数据;

-

树状索引:通过层次化摘要构建文档结构树,提升长文本处理效率;

-

关键词表索引:结合正则表达式和 LLM 提取关键词,实现快速路由查询。

-

检索增强层:在查询时动态生成嵌入向量,结合相似度算法(如余弦相似度)筛选相关片段,再通过 LLM 生成答案。

4)技术突破

- 延迟嵌入生成:仅在查询时生成嵌入,避免预计算海量数据的存储开销;

- 混合索引策略:支持多索引组合(如树索引+列表索引),解决复杂查询场景下的信息融合问题。

5)典型应用场景

- 企业内部知识库问答(如技术文档、产品手册);

- 基于长文本的摘要生成(如法律合同分析)。

6)代码示例(构建文档问答系统)

2. LangChain:构建AI应用的“乐高积木”

1)背景与定位

LangChain是一个面向开发者的编程框架,旨在帮助开发者更高效地构建基于LLM的应用。它通过模块化组件和链式逻辑,将LLM的能力与外部工具(如数据库、API、代码解释器)无缝连接,形成完整的应用链路。

LangChain以模块化设计和链式流程著称,支持开发者将大模型与外部工具(如API、数据库)灵活组合。其核心组件包括:

- 提示模板:标准化模型输入,提升响应质量;

- 智能体(Agents):调用工具执行多步骤任务(如数据分析、邮件发送);

- 记忆机制:支持会话状态的持久化。

2)核心功能

- 组件化设计: LangChain提供了丰富的组件库(如Prompt模板、LLM调用器、数据库连接器),开发者可以像搭积木一样组合这些组件,快速构建应用。

- 链式逻辑: 通过Chain`机制,开发者可以将多个步骤(如检索、生成、验证)串联起来,形成\自动化流程。例如,先通过Prompt模板构造查询,再调用数据库检索,最后用LLM生成最终答案。

- 工具集成: LangChain支持与外部工具(如Google搜索、SQL数据库)的集成,扩展LLM的能力边界。例如,通过调用搜索引擎实时获取最新数据,避免模型“知识固化”的问题。

3)技术架构

LangChain是模块化工作流的神经中枢,复杂工作流的“指挥官”,它采用链式架构(Chain-of-Thought Architecture),其核心模块包括:

- 组件容器:

- 提示模板:标准化指令输入(如“用 Markdown 表格总结以下内容”),确保模型输出结构化。

- 工具接口:封装 200+ 外部工具(如 Python 解释器、API 调用器),通过智能体(Agent)实现自动化调用。

- 记忆存储:采用向量数据库(如 Chroma)实现会话状态持久化。

- 执行引擎:

- 链式编排:将工具调用、数据处理、模型生成等步骤串联为工作流(如“数据库查询→数据分析→图表生成→报告撰写”)。

- 动态路由:根据输入内容自动选择执行路径(如用户提问涉及代码时优先调用代码解释器)。

4)实现原理

- 工具抽象化:通过 JSON Schema 定义工具输入输出格式,实现跨工具的统一调用接口。

- 反射式执行:智能体根据执行结果动态调整后续动作(如 SQL 查询失败时自动切换为 API 调用)。

5)典型应用场景

- 自动化报表生成(结合数据库查询与图表工具)

- 智能客服(集成业务系统实时获取订单信息)

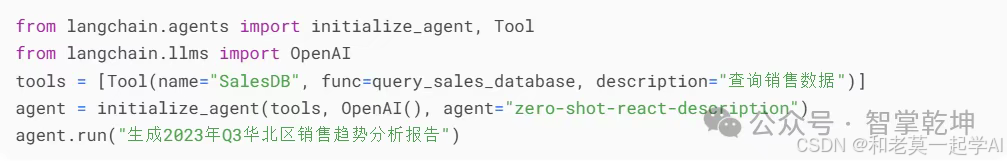

6)代码示例(构建自动化流程)

三、四大核心技术:驱动大模型能力进阶

1. Prompt(提示词工程):让模型“听懂人话”

1)介绍

提示词是大模型理解的“钥匙”,从人工设计到自动化优化,与模型的“对话艺术”,设计原则包括:

- 明确指令:避免模糊问题(如“怎么做?”),改为具体任务(如“用Python提取网页标题并保存为CSV”);

- 结构化示例:提供输入输出模板,引导模型遵循格式;

- 异常处理:预设边界条件(如“若数据缺失,返回‘暂无信息’”)。

案例:某旅游App通过优化提示词,将行程建议从“推荐景点”升级为“推荐3家人均100元以下的故宫周边餐厅,附地址与招牌菜”,用户满意度提升40%。

2)技术架构

- 自动提示生成(APE):利用 LLM 生成候选提示词,通过评估模型(Evaluator LLM)筛选最优方案。

- 优化策略:包括随机搜索、贝叶斯优化(OPRO)等,模拟超参数调优过程。

3)实现原理

- 元提示设计:通过指令模板(如“请改进以下提示词以提升分类准确率”)引导 LLM 迭代优化。

- 反馈闭环:将模型输出与标注数据对比,计算准确率/F1值作为优化目标。

2. RAG(检索增强生成):给模型“装外脑”

1)介绍

RAG是检索与生成的深度耦合,解决“知识固化”的利器,大模型的“幻觉问题”可通过RAG技术缓解,其流程分为两步:

- 建索引:将企业私有数据(如产品手册、客户案例)转化为可检索的向量库;

- 查资料:回答前先检索相关片段,作为生成答案的依据。

其优势主要包括:

- 避免重新训练模型,支持知识库动态更新;

- 提供答案引用来源,增强可信度。

2)技术架构

- 双塔模型:使用 BERT 等编码器分别处理查询和文档,映射到同一向量空间实现快速匹配。

- 混合检索:结合关键词匹配(BM25)与语义检索(向量搜索),提升召回率。

3)实现原理

- 上下文注入:将检索到的文档片段作为前缀插入生成模型的输入(如“参考以下资料:…”),强制模型基于事实生成。

- 动态知识更新:通过增量索引技术实现知识库实时更新,无需重新训练模型。

3. MCP(模型上下文协议):模型与外部系统的通用接口

1)介绍

MCP(Model Context Protocol)是一种标准化的通信协议,是大模型访问本地与外部数据的“万能接口”,打通数据的“任督二脉”,是AI与工具的“通用语言”,旨在解决LLM与外部工具(如API、数据库)之间的交互问题。包括:

- 安全连接:授权模型访问企业内部系统(如CRM、ERP)。

- **标准化协议**:统一不同数据源的调用方式(如API、数据库)。

2)技术架构:

- Host:运行 LLM 的应用主体(如智能客服系统),提供AI任务执行环境。

- Client:负责协议转换,将 Host 请求转发至 Server,管理主机与服务器之间的通信。

- Server:封装具体工具逻辑(如数据库查询、邮件发送),提供工具、资源和提示能力,支持双向数据交换。

- 通信协议:基于 JSON-RPC 实现双向消息传递,支持 HTTP/WebSocket 等多种传输层。

3)实现原理:

- 权限隔离:通过 OAuth 2.0 控制模型对敏感数据的访问范围。

- 状态管理:使用会话 ID 追踪多轮交互的上下文,避免信息丢失。

*4)技术优势*

- 无缝集成:通过标准协议,实现LLM与任意工具的连接。

- 实时反馈:服务器可主动推送状态更新(如任务进度、错误信息)。

- 安全性:支持权限控制和数据加密,保障通信安全。

*5)应用场景*

- 智能代理(Agent):通过MCP调用外部API(如天气查询、航班预订),完成复杂任务。

- 开发工具集成:在IDE中嵌入LLM,通过MCP实时调用代码解释器。

- 跨平台协作:支持多团队共享工具资源,提升开发效率。

- 金融风控:模型实时查询用户征信数据;

- 医疗诊断:调取患者历史病历辅助决策。

*6)技术挑战*

- 协议兼容性:需适配不同厂商的工具和模型。

- 性能优化:减少通信延迟,提升实时性。

- 生态扩展:推动更多工具和平台加入MCP生态。

4.Agent(智能体):AI的“行动力”

1)介绍

智能体(Agent)是具备自主决策和任务分解能力的AI系统,是下一代AI的自主进化,与传统LLM不同,智能体能够:

-

主动感知环境:通过传感器或API获取实时数据。

-

任务规划与分解:将复杂任务拆解为子任务,逐步执行。

-

自我学习:通过试错和反馈优化策略,提升适应性。

-

工具调用:自动使用编程接口(如调用Python脚本处理数据)。

*2)技术架构*

- 任务分解器:将复杂问题拆解为子任务(如“分析销售数据→生成趋势图→撰写结论”)。

- 工具调度器:根据任务需求动态调用工具链(如 Pandas 处理数据 + Matplotlib 绘图)。

*3)实现原理*

- *反射推理*:通过 ReAct 框架(Reasoning + Acting)实现“思考-行动-观察”循环。

- *异常处理*:预设 fallback 机制(如 API 调用超时后切换备用数据源)。

*4)技术优势*

- *跨场景泛化:从固定场景扩展到多任务、多场景。*

- *自主性:无需人工干预,自主完成任务。*

- *可解释性:通过任务分解和日志记录,提升决策透明度。*

*5)应用场景*

- *智能家居:通过环境感知和任务规划,自动调节温度、灯光。*

- *自动驾驶:结合传感器数据,实时决策路径规划。*

- *企业运营:自动生成报告、分析数据并提出优化建议。*

6)典型案例

- 自动化运营:智能体监控社交媒体舆情,发现负面评论后自动生成应对方案;

- 科研辅助:自动检索文献、设计实验并记录结果。

四、演进趋势:技术融合

1.演进路线

-

框架轻量化

- LlamaIndex 正探索量化压缩技术,将向量索引体积减少 70%。

-

LangChain 推出轻量版 LangChain Lite,剥离非核心组件以降低内存占用。

-

协议标准化

- MCP 计划支持 Serverless 架构,实现无状态服务动态扩展

-

RAG 社区推动 OpenRAG 标准,统一检索模块的接口规范

*2.演进形式*

- *Prompt工程+RAG*:通过动态Prompt引导模型结合实时检索结果,生成更精准答案。

- *MCP+智能体*:标准化协议为智能体提供稳定的工具接口,加速自主决策能力。

- *框架协同*:LlamaIndex与LangChain的结合,可构建更复杂的混合应用(如企业级智能代理)。

**3.技术融合:构建企业级智能系统****

*1)框架与技术的组合逻辑*

- 基础层:用LlamaIndex构建知识库,通过RAG增强问答准确性;

- 执行层:通过LangChain串联智能体,调用MCP接口获取实时数据;

- 交互层:优化提示词工程,提升用户体验。

*2)真实场景案例*

需求:基于季度销售数据与客户反馈,生成改进提案。**

**

实现流程:

- RAG检索:从企业知识库中提取历史销售报告与产品文档;

- 智能体调度:自动分析数据趋势,调用可视化工具生成图表;**

** - MCP接入:从CRM系统获取客户投诉详情;

- 提示词优化:要求模型“先总结问题,再按优先级提出建议”

五、未来挑战:生态共建

- 标准化:推动Prompt模板、MCP协议等技术的行业标准化。

- 数据安全:在开放生态中平衡数据共享与隐私保护。

- 开发者教育:培养更多掌握框架与核心技术的开发者,降低技术门槛。

- 安全增强:智能体增加沙盒机制,限制对系统资源的直接访问,MCP 引入零信任网络(Zero Trust),每次数据请求需二次鉴权。

六、结语

AI大模型的落地并非一蹴而就,而是需要框架支撑、技术驱动和生态共建的长期过程。LlamaIndex与LangChain作为两大框架,为开发者提供了从数据到应用的全链路工具支持;而提示词工程(Prompt)、RAG、MCP、智能体四大技术则像“齿轮”一样,为模型能力的进阶提供了方向,驱动大模型从实验室走向真实业务场景。

未来,随着技术的融合与生态的完善以及开源生态与算法优化的深化,大模型也在更多领域释放潜力,让AI应用的开发将更高效、更普惠,真正成为推动社会进步的“超级大脑”。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

如果你真的想学习大模型,请不要去网上找那些零零碎碎的教程,真的很难学懂!你可以根据我这个学习路线和系统资料,制定一套学习计划,只要你肯花时间沉下心去学习,它们一定能帮到你!

大模型全套学习资料领取

这里我整理了一份AI大模型入门到进阶全套学习包,包含学习路线+实战案例+视频+书籍PDF+面试题+DeepSeek部署包和技巧,需要的小伙伴文在下方免费领取哦,真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

部分资料展示

一、 AI大模型学习路线图

整个学习分为7个阶段

二、AI大模型实战案例

涵盖AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,皆可用。

三、视频和书籍PDF合集

从入门到进阶这里都有,跟着老师学习事半功倍。

四、LLM面试题

五、AI产品经理面试题

六、deepseek部署包+技巧大全

😝朋友们如果有需要的话,可以V扫描下方二维码联系领取~

更多推荐

已为社区贡献152条内容

已为社区贡献152条内容

所有评论(0)