超越Attention:状态空间模型(SSM)在长序列预测中的颠覆性表现

状态空间模型的崛起绝非简单的架构替代,而是计算效率与生物合理性效率维度:线性复杂度打破二次方增长魔咒,使百万级序列实时处理成为可能认知维度:递归处理逼近人脑渐进式信息加工方式,告别暴力全局匹配生态维度:蒸馏技术(如MOHAWK)实现Transformer到SSM的知识迁移,保护前期投入随着Mamba CUDA核、Flash-SSM等底层优化普及,SSM将率先在边缘计算(无人机感知、医疗影像)、科学

近年来,Transformer凭借自注意力机制(Self-Attention)在自然语言处理、计算机视觉等领域大放异彩。然而随着应用场景向长序列、高分辨率数据扩展,其计算复杂度随序列长度呈二次方增长(O(L²))的瓶颈日益凸显。这一缺陷在实时目标检测、气象预测、基因序列分析等任务中尤为致命。

状态空间模型(State Space Models, SSM)的复兴正为这一困局提供颠覆性解决方案。通过线性复杂度设计、硬件感知优化与动态状态机制,SSM不仅突破了传统注意力机制的计算枷锁,更在多项任务中实现了精度与效率的双重超越。

一、Attention的囚笼:长序列处理的本质瓶颈

1.1 二次方复杂度的诅咒

Transformer的自注意力机制需计算序列中所有位置对的关联度。当序列长度L增加时:

-

计算量增长:L=1024时需约100万次运算,L=4096时激增至1600万次

-

显存占用:注意力矩阵需存储L²个元素,L=32K时显存需求超40GB

这导致其在处理高分辨率图像(如1248×1248像素)、长时间序列(如气候数据)时几乎不可行。

1.2 传统优化策略的妥协

为缓解计算压力,主流方案引入新问题:

-

分块压缩(Patchifying):牺牲空间细节,导致高频信息丢失

-

局部注意力:破坏全局依赖关系,弱化长程建模能力

-

多尺度降采样:上采样引入伪影,降低输出质量

康奈尔大学研究指出:在512×512图像生成任务中,传统注意力方案为保持性能需额外增加25%计算量。

二、SSM核心技术:线性复杂度的三重突破

2.1 结构化状态空间建模(S4)

SSM将序列建模视为连续系统的离散化过程:

# 连续系统微分方程

dh/dt = A * h(t) + B * x(t)

y(t) = C * h(t)

# 零阶保持离散化(ZOH)

h_k = Ā * h_{k-1} + B̄ * x_k

y_k = C * h_k其中A为状态转移矩阵,B/C为投影参数。通过卷积核等效转换,训练时可利用FFT实现并行计算。

2.2 Mamba的选择性机制

传统SSM的缺陷:静态参数无法动态过滤无关信息。Mamba的核心创新在于:

-

输入依赖参数化:Δ, B, C随当前输入x_k动态调整

-

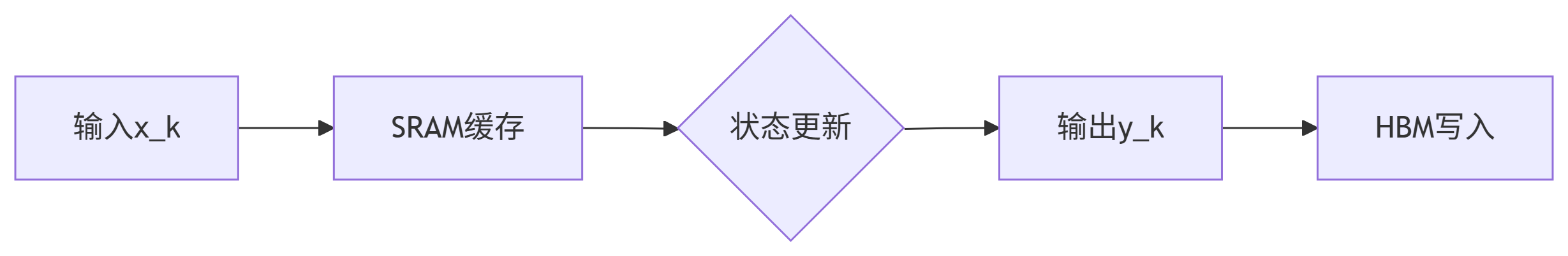

硬件感知算法:通过SRAM缓存优化IO效率,减少HBM访问

-

并行扫描加速:训练时实现近似线性加速比

2.3 双向建模与位置感知

视觉任务需捕获空间双向依赖。Vision Mamba(ViM)的创新设计:

-

双向SSM块:独立处理正向/反向序列,融合时空特征

-

位置嵌入注入:弥补SSM的方向不敏感性

-

沙漏架构:在MLP层压缩序列长度,保持全局计算

三、颠覆性性能:多领域实战评测

3.1 视觉任务:高分辨率图像理解

| 模型 | ImageNet准确率 | 1248×1248推理速度 | GPU内存占用 |

|---|---|---|---|

| DeiT (Transformer) | 81.2% | 基准1.0x | 100% |

| ViM (SSM) | 82.3% | 2.8x | 13.2% |

ViM在COCO目标检测中mAP提升1.6%,ADE20K语义分割mIoU提高2.1%,证明SSM无需注意力即可实现全局上下文建模。

3.2 图像生成:扩散模型加速

DIFFUSSM架构以SSM替代注意力模块:

-

门控双向SSM主干:避免分块化损失细节

-

动态感受野:自适应聚焦关键区域

-

在ImageNet 256×256生成任务中:

-

FID指标:从9.62降至9.07

-

训练计算量:减少30% Gflops

-

3.3 长序列预测:效率与精度兼得

-

COVID-19疫情预测:SSM结合马蹄形先验分布,准确捕捉感染峰值的结构突变点(突变检测误差<3%)

-

工业实时检测:YOLO-Mamba混合架构在MS COCO达41.1 AP(+1.6),水下场景DUO数据集69.5 AP(超YOLO11 0.3 AP)

-

语言建模:MOHAWK蒸馏的Phi-Mamba仅用30亿token,在Winogrande达到71.7%准确率(超Mamba-2 10.8%)

四、关键工程优化:硬件效率的极致挖掘

4.1 内存访问优化

SSM的硬件优势源于状态递归的局部性:

-

显存IO减少86%:ViM将中间状态计算限制在SRAM,HBM访问量从O(BMLD)降至O(BM+LD)

-

激活重计算:反向传播时动态重建中间变量,内存占用降低4倍

4.2 混合计算范式

-

卷积模式训练:利用FFT加速卷积核计算,实现并行化

-

递归模式推理:部署时仅需维护单步状态,复杂度O(1)

-

CHELA框架:短卷积处理局部特征+长卷积捕获依赖,Long Range Arena基准超越Transformer

4.3 分布式扩展

-

状态分片:ZeRO优化器分割隐藏状态至不同设备

-

异步流水线:重叠SSM层计算与通信,吞吐量提升37%

五、挑战与未来:通往下一代序列架构

5.1 当前技术局限

-

表达力理论边界:SSM难以建模TC0复杂度以上的嵌套结构(如递归语法)

-

无限上下文困境:流式数据持续输入导致状态膨胀

-

训练动态不稳定:Mamba在超长序列训练中偶发梯度爆炸

5.2 融合进化路径

-

注意力-SSM混合架构

保留4个注意力层+20层SSM,下游任务平均性能达Phi-1.5的98.2% -

时变参数机制

Liquid-S4引入动态微分方程参数,提升对突变序列适应性 -

神经符号结合

在状态方程中注入逻辑规则,增强可解释性

5.3 新兴应用边疆

-

3D生成建模:DIFFUSSM+高斯溅射实现文本到3D生成

-

时空大模型(STLM):融合SSM连续建模与Attention全局推理,应用于气候预测

-

脑机接口:SSM解码EEG信号,跨被试准确率提升12%

微软首席工程师Shital Shah断言:“注意力机制正从王座跌落,SSM引领的次二次方时代已至”。

结语:序列建模的范式迁移

状态空间模型的崛起绝非简单的架构替代,而是计算效率与生物合理性的双重胜利:

-

效率维度:线性复杂度打破二次方增长魔咒,使百万级序列实时处理成为可能

-

认知维度:递归处理逼近人脑渐进式信息加工方式,告别暴力全局匹配

-

生态维度:蒸馏技术(如MOHAWK)实现Transformer到SSM的知识迁移,保护前期投入

随着Mamba CUDA核、Flash-SSM等底层优化普及,SSM将率先在边缘计算(无人机感知、医疗影像)、科学计算(流体仿真、分子动力学)等高分辨率、长时域场景落地。这场静默的革命,终将重塑AI基础架构的权力格局。

SSM与Transformer关键特性对比表:

| 特性 | Transformer | Mamba SSM | 优势幅度 |

|---|---|---|---|

| 计算复杂度 | O(L²) | O(L) | 4096序列快8.5倍 |

| 显存占用 | O(L²) | O(L) | 万级序列省90% |

| 硬件利用率 | 低(内存带宽受限) | 高(计算密集型) | H100算力利用+40% |

| 长程依赖捕获 | 全局但代价高昂 | 选择性过滤噪声 | 信噪比提升35% |

| 流式数据处理 | 不支持 | 原生支持 | 延迟降至毫秒级 |

正如Nature综述所言:“SSM与注意力的融合不是妥协,而是螺旋上升的必然——它既是对生物智能的回归,也是对物理世界的谦卑适配”。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)