国内首创!SophNet重磅发布DeepSeek API极速版,推理速度超100 Tokens/s,直翻5倍!

推理速度飙升至100+Tokens/s,较市场平均水平直接翻5倍!

在 AI 大模型全面落地的时代浪潮下,医疗问诊、金融风控、AI 实时对讲等场景,对推理速度的要求愈发严苛。SophNet 迎难而上,凭借硬核技术实力,重磅推出DeepSeek-V3 API 极速版,一举刷新国产推理速度天花板!

SophNet再度破局,重新定义国产推理速度极限!

SophNet全新发布DeepSeek-V3 API 极速版——DeepSeek V3 0324 版本的高TPS极速版,满血非量化(671B,FP8),代码与数学能力更强,响应更快!

推理速度飙升至100+Tokens/s,较市场平均水平直接翻5倍!这不仅是数字上的飞跃,更是技术层面的重大突破,真正实现 “即时响应”,完美契合低延迟、高速度的商业需求。

🔥实测演示:录屏秒出,响应如风!

SophNet平台DeepSeek推理速度超100TPS

扫码体验:SophNet DeepSeek V3极速版

国产算力赋能:SC11 FP300,普惠智算,疾速赋能

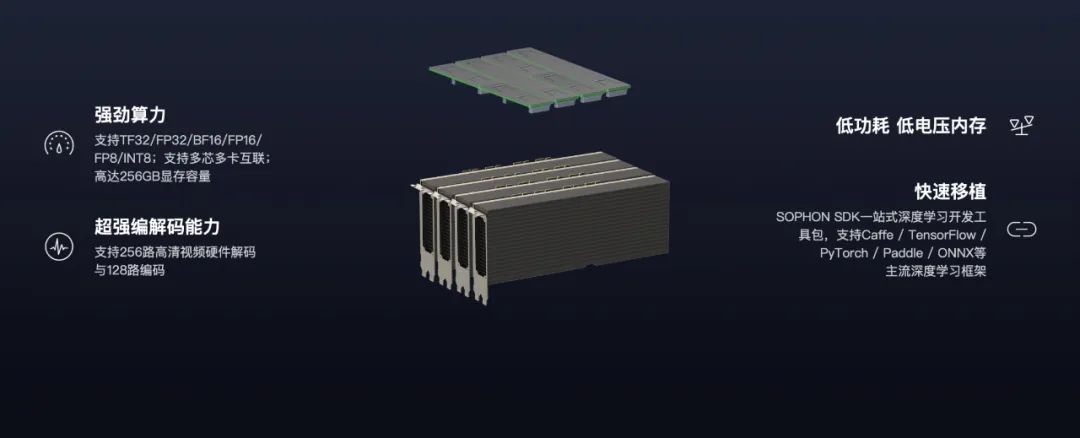

这场速度革命的核心,是算能背后自研的智算卡SC11 FP300。区别于依赖进口GPU的传统方案,SophNet凭借全链条自主可控的国产TPU架构,实现更高速度、更低成本。

我们已率先完成SC11 FP300的规模化集群部署,为各类大模型应用提供坚实的国产算力底座:

-

✅ 超大容量,原生FP8算力

SC11 FP300单卡集成256GB LPDDR5X高带宽内存,内置原生FP8算力单元,结合Per-Group Quantization和无缝格式转换技术,充分释放FP8低精度计算的高效潜力,有效应对大模型参数存储与计算需求。

-

✅ 极致带宽,极速互联

板载高达1.1TB/s的内存带宽,配合PCIe Gen5主机接口及256GB/s的多卡间高速互联,为模型训练和推理环节提供充足的数据流通能力,显著降低带宽瓶颈带来的性能损耗。

-

✅ 硬件-算法协同,全面释放智算潜力

SC11 FP300以DSA架构为基础,内置64MB片内ScratchPad Memory,支持高效的转置、reshape等Tensor操作,极大加速GEMM等核心矩阵运算,满足大模型训练与推理的极致性能需求。

-

✅ 自研深度算子,精准适配前沿模型

针对Transformer、MoE等主流大模型,SC11 FP300深度优化并自研Attention与MoE算子,结合独立Reduce Engine和CUBE计算引擎,显著提升稀疏计算和专家路由等关键环节的效率。

高 TPS 场景价值全面爆发

凭借 SC11 FP300的硬核技术,DeepSeek-V3 API 极速版火力全开,为各领域注入强劲动能:

-

🏥 医疗:AI 问诊秒级响应,大幅提升患者就诊体验

-

💹 金融:极速解读市场行情,实时输出投顾策略

-

🎙️ 直播:智能伴聊实时互动,同步完成多语言翻译

-

💬 对话系统:告别卡顿延迟,客服沟通流畅无阻

未来,SophNet将持续以稳定高速的推理服务为使命,不断优化云算力服务体验,助力企业和开发者轻松接入全球顶尖AI模型,加速实现AI计算普惠人类。

CSDN与算能合作,为开发者提供专属邀请链接,点击下方链接注册SophNet平台,立即得20元注册奖励金,绑定CSDN邀请链接,充值再享88折优惠!👇

平台介绍

SophNet | 云算力平台(网址:sophnet.com)—— 依托算能自研TPU处理器的强劲算力,致力于打造更快、更稳、更省的一站式模型服务平台。

几行代码,接入全球顶尖的AI大模型。零代码,创建开箱即用智能体。

目前平台已接入 DeepSeek R1 满血版、DeepSeek V3 0324、Qwen3 等主流开源大模型,并支持私有模型托管。一键部署,让企业和开发者以超低成本畅享强大算力,实现真正的模型与算力自由,加速AI计算普惠人类。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)