Qwen3发布:今夜,见证目前最强的开源模型的诞生

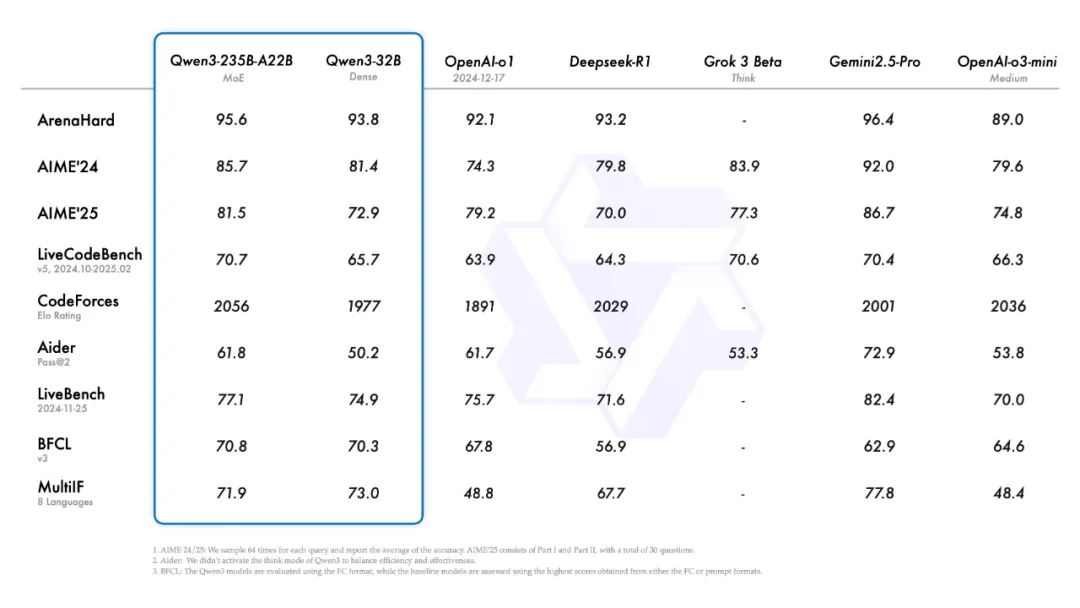

今夜无眠。一直写稿到现在,因为,那个源神杀回来了。今天凌晨5点,阿里发布了全新一代模型Qwen3(简称千问3)。这是它的测评基准。有多牛呢?与DeepSeek-R1、o1、o3-mini、Grok-3和Gemini-2.5-Pro等顶尖模型相比,旗舰模型Qwen3-235B-A22B在编码、数学和通用能力等基准测试中,取得了非常亮眼的成绩。更牛的是,Qwen3的小尺寸模型也很能打。比如Qwen3-

今夜无眠。

一直写稿到现在,因为,那个源神杀回来了。

今天凌晨5点,阿里发布了全新一代模型Qwen3(简称千问3)。

这是它的测评基准。

有多牛呢?与DeepSeek-R1、o1、o3-mini、Grok-3和Gemini-2.5-Pro等顶尖模型相比,旗舰模型Qwen3-235B-A22B在编码、数学和通用能力等基准测试中,取得了非常亮眼的成绩。

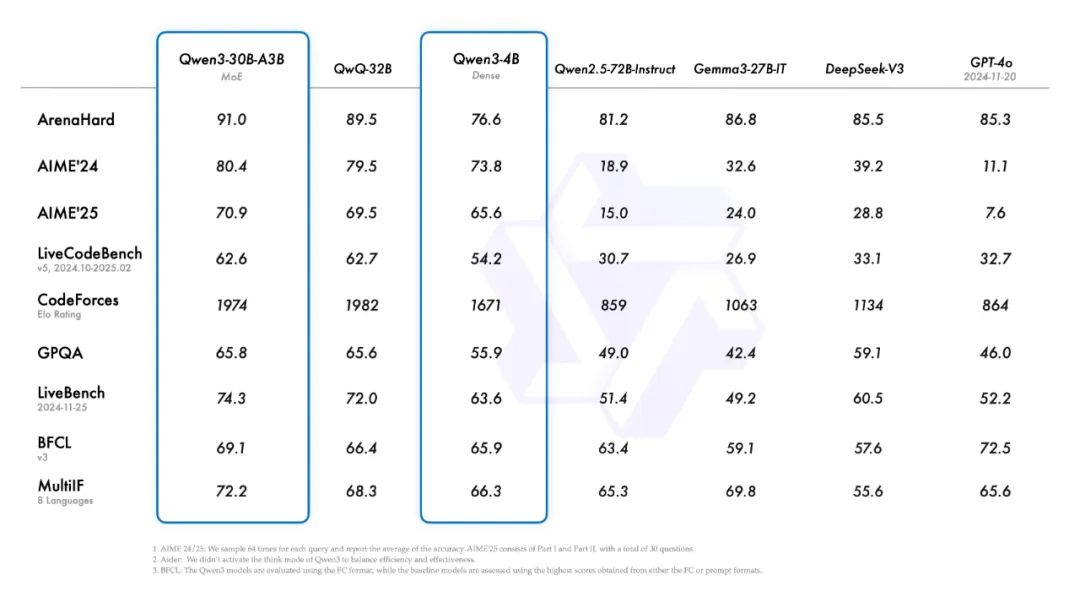

更牛的是,Qwen3的小尺寸模型也很能打。比如Qwen3-4B,性能竟然完全不输72B的Qwen2.5-72B-Instruct模型。

当然,更更更牛的是,千问3全系模型开源!包括旗舰模型Qwen3-235B-A22B在内的八款千问3家族模型,全部开源。

可以自信且大胆的说,这就是目前全球最强的开源模型,来自中国的阿里。

源神“八”仙过海

本次开源的千问3家族模型一共有8款:

-

6款Dense模型:0.6B、1.7B、4B、8B、14B、32B。

-

2款MoE模型:Qwen3-30B-A3B和旗舰版Qwen3-235B-A22B。

通常,简单问题用Dense模型,复杂问题用MoE模型。

关于各模型的参数和推荐配置,我简单整理了个表格。

自部署,优先推荐Qwen3-0.6B、Qwen3-14B及以上、Qwen3-30B-A3B和Qwen3-235B-A22B这几款模型。

-

Qwen3-0.6B,在手机端侧可跑。

-

Qwen3-30B-A3B,消费级显卡可跑,激活参数仅3B,整体性能堪比Qwen2.5-32B,实现了10倍性能的提升。

-

Qwen3-235B-A22B,Qwen3的旗舰模型,总参数235B(激活参数22B),只需4张H20即可部署。

以上8款开源模型,均采用宽松的Apache2.0协议(可自由修改、商用),支持119种语言。所有公司无论规模大小,所有AI开发者、科研机构不惧显卡门槛,大家都能够用得上、也用得起千问3模型。

Hugging Face:

https://huggingface.co/spaces/Qwen/Qwen3-Demo

ModelScope:

https://www.modelscope.cn/collections/Qwen3-9743180bdc6b48

GitHub:

https://github.com/QwenLM/Qwen3

如果嫌本地部署麻烦,也可以直接在他们的Qwen Chat官网体验。

网址是这个:https://chat.qwen.ai

进去后,左上角选择“Qwen3”系列模型,即可体验。

当然,也支持API调用,大家可在阿里云百炼调用API服务(正在上线中)。

上周六,某高端局会议提到,“人工智能可以是造福人类的国际公共产品。要广泛开展人工智能国际合作,帮助全球南方国家加强技术能力建设,为弥合全球智能鸿沟作出中国贡献。”

这款千问3模型,就是最好的代表。

千问3的“特异”功能

新一代千问3模型,有些不一样的地方。

1)国内首款“混合推理模型”

千问3既非单模态的语言模型,也非专注CoT的推理模型,而是“混合推理模型”,原生支持推理模式与非推理模式两种工作模式。

在使用中,用户可通过enable_thinking=Ture硬开关机制方式,控制模型开启推理模式;同时也支持软开关机制,允许用户在enable_thinking=True时通过/think和/no_think指令来开启推理模式。

说人话就是,用户既可以通过功能键选择是否需要推理,也可以用大白话来命令模型是否进行推理。在简单任务场景中,关闭推理模式,可以实现更快响应和更低推理成本;在复杂任务场景中,启用逐步推理,可以带来更精准、严谨的结果。

from transformers import AutoModelForCausalLM, AutoTokenizerclass QwenChatbot:def __init__(self, model_name="Qwen/Qwen3-30B-A3B"):self.tokenizer = AutoTokenizer.from_pretrained(model_name)self.model = AutoModelForCausalLM.from_pretrained(model_name)self.history = []def generate_response(self, user_input):messages = self.history + [{"role": "user", "content": user_input}]text = self.tokenizer.apply_chat_template(messages,tokenize=False,add_generation_prompt=True)inputs = self.tokenizer(text, return_tensors="pt")response_ids = self.model.generate(**inputs, max_new_tokens=32768)[0][len(inputs.input_ids[0]):].tolist()response = self.tokenizer.decode(response_ids, skip_special_tokens=True)# Update historyself.history.append({"role": "user", "content": user_input})self.history.append({"role": "assistant", "content": response})return response# Example Usageif __name__ == "__main__":chatbot = QwenChatbot()# First input (without /think or /no_think tags, thinking mode is enabled by default)user_input_1 = "How many r's in strawberries?"print(f"User: {user_input_1}")response_1 = chatbot.generate_response(user_input_1)print(f"Bot: {response_1}")print("----------------------")# Second input with /no_thinkuser_input_2 = "Then, how many r's in blueberries? /no_think"print(f"User: {user_input_2}")response_2 = chatbot.generate_response(user_input_2)print(f"Bot: {response_2}")print("----------------------")# Third input with /thinkuser_input_3 = "Really? /think"print(f"User: {user_input_3}")response_3 = chatbot.generate_response(user_input_3)print(f"Bot: {response_3}")

这是继Claude 3.7 Sonnet、Gemini 2.5家族后全球唯三的混合推理模型,也是国内首款“混合推理模型”。

2)Agent的“好搭子”

千问3模型原生支持MCP协议,具备强大的工具调用(function calling)能力。

最近,大家都在说“大模型从对话走向执行”,Manus、Genspark、AutoGLM、飞猪AI问一问、扣子空间等通用智能体雏形不断涌现。但实际体验起来,你会发现,这些Agent还差点意思。

差的这个东西,其实就是底座模型。

千问3,全面适配AI Agent生态。其架构不再局限于“问答能力”,而是面向Agent架构优化的执行效率、响应结构与工具泛化能力。支持手机及电脑Agent操作等代理任务。

搭建Agent,强烈推荐用千问3来作底座模型。

附Agent示例。

from qwen_agent.agents import Assistant# Define LLMllm_cfg = {'model': 'Qwen3-30B-A3B',# Use the endpoint provided by Alibaba Model Studio:# 'model_type': 'qwen_dashscope',# 'api_key': os.getenv('DASHSCOPE_API_KEY'),# Use a custom endpoint compatible with OpenAI API:'model_server': 'http://localhost:8000/v1', # api_base'api_key': 'EMPTY',# Other parameters:# 'generate_cfg': {# # Add: When the response content is `<think>this is the thought</think>this is the answer;# # Do not add: When the response has been separated by reasoning_content and content.# 'thought_in_content': True,# },}# Define Toolstools = [{'mcpServers': { # You can specify the MCP configuration file'time': {'command': 'uvx','args': ['mcp-server-time', '--local-timezone=Asia/Shanghai']},"fetch": {"command": "uvx","args": ["mcp-server-fetch"]}}},'code_interpreter', # Built-in tools]# Define Agentbot = Assistant(llm=llm_cfg, function_list=tools)# Streaming generationmessages = [{'role': 'user', 'content': 'https://qwenlm.github.io/blog/ Introduce the latest developments of Qwen'}]for responses in bot.run(messages=messages):passprint(responses)

3)亚非拉的“好兄弟”

千问3模型的语言支持,多达119种。

不仅囊括了中、英、法、西、俄、阿拉伯等主要的联合国语言,还包含德、意、日、韩、泰、越南、尼泊尔、瑞典、波兰、匈牙利等各国官方语言,甚至连中国的粤语、非洲的斯瓦西里语、中东的意第绪语、西亚的亚美尼亚语、东南亚的爪哇语、美洲的海地语等地方性语言都支持。

上周六某高端局会议为什么要强调“帮助全球南方国家”?因为这些国家大多集中在亚洲、非洲、拉丁美洲和大洋洲,他们的总人口占了全球的70%,但经济却只有40%。

很多南方国家,根本没有能力开发自己语种的大模型。现在有了开源的千问3,这道题就很好解了——你只要有电脑、能上网,就能够部署自己的模型。

从技术平权这个角度来说,阿里是真的NB。

Qwen3一手实测

现在,所有人都可以在Qwen Chat中体验最新版千问3模型。

体验地址:https://chat.qwen.ai

我们来测几个Case,看看模型的表现。

先是网页设计能力,用的X上@AGI_FromWalmart 的Prompt。

Create a single HTML file containing CSS and JavaScript to generate an animated weather card. The card should visually represent the following weather conditions with distinct animations: Wind: (e.g., moving clouds, swaying trees, or wind lines) Rain: (e.g., falling raindrops, puddles forming) Sun: (e.g., shining rays, bright background) Snow: (e.g., falling snowflakes, snow accumulating) Show all the weather card side by side The card should have a dark background. Provide all the HTML, CSS, and JavaScript code within this single file. The JavaScript should include a way to switch between the different weather conditions (e.g., a function or a set of buttons) to demonstrate the animations for each.

这是一个测试模型代码能力的case,主要考验模型的编程、审美和推理能力。大概1分钟左右,Qwen3就给我们把代码写好了。

我们把Html代码下载下来,用浏览器打开看看效果,这质量真不错啊。比我之前用的QwQ-32B推理模型要提升不少。

再来看一个case,Prompt来自X网友@_akhaliq。

Write a p5.html script that simulates 25 particles in a vacuum space of a cylindrical container, bouncing within its boundaries. Use different colors for each ball and ensure they leave a trail showing their movement. Add a slow rotation of the container to give better view of what's going on in the scene. Make sure to create proper collision detection and physic rules to ensure particles remain in the container. Add an external spherical container. Add a slow zoom in and zoom out effect to the whole scene.

这效果太棒了,非常惊艳。最关键的是,模型的生成速度真的很快。这2个case,基本都在1分钟内完成任务。

接着,我们来看下数学能力。用了一道来自Putnam竞赛前500名人类选手都未能攻克的难题。

Qwen3先进行了解题,准确理解题目。我传给它的是一张图片,看来Qwen3多模态能力不错,而且也能理解La Tex数学公式。

有没有数学大佬,能不能帮忙看看,这道题Qwen3到底有没有答对。

测了代码、数学,我们再来看下文学创作吧。

还行,过得去。

最后,考验一下模型的工具调用能力(Qwen3独有的功能)。

Prompt:

制作 排序算法 (Sorting Algorithms),做成动态的效果图,每个算法单独一个子页面。

冒泡排序 (Bubble Sort): 元素像气泡一样“冒”到顶端,交换过程非常直观。

选择排序 (Selection Sort): 每次从未排序部分选出最小(或最大)元素放到已排序部分的末尾,这个“选择”和“放置”的过程清晰可见。

插入排序 (Insertion Sort): 像打扑克牌时整理手牌一样,将元素插入到已排序部分的正确位置,元素的“移动”和“插入”很形象。

归并排序 (Merge Sort): “分而治之”的思想可以通过递归地分割数组,然后清晰地展示两个已排序子数组如何“合并”成一个大数组来体现。合并步骤尤其适合可视化。

快速排序 (Quick Sort): 选取“基准”(pivot),然后将元素分区(小于基准的放一边,大于等于的放另一边)的过程非常适合可视化。递归调用也能通过颜色或区域划分展示。

堆排序 (Heap Sort): 将数组构建成堆(通常是二叉堆),然后不断取出堆顶元素的过程,可以通过树形结构和数组两种形式对照展示,非常直观。

不错啊,居然调用了这么多工具来回答我的问题。

写在最后

我们一直都说,人工智能是模拟、延伸和拓展人的智能。

但如果一个模型技术出来,总要我们人为去区分这模型、那模型,其实这样的模型并不智能,也一定不是人工智能的最终版本。

今年新出的混合推理模型,它结合了单一语言模型和推理模型的优势,能够自如切换两种模式。快速回答,模仿人类直觉反应;CoT逐步推理,模仿人类慢思考。

在混合推理模型下,无论简单问题还是复杂问题,模型都能够应对自如,实现速度与深度的平衡。理论说起来简单,但要真正实现起来非常困难,这会对模型的训练策略、数据设计和损失函数调度提出更高的要求。

在全球唯三的混合推理模型中,阿里Qwen3做到了。不仅做到,还大方开源。

只能说,源神NB,阿里NB。

之前,我们写过一篇文章(详细介绍),2024年中美顶级AI大模型性能差距接近抹平,阿里AI贡献全球第三。当时,阿里凭借6款重要模型入选。

今天,阿里发布的Qwen3一定也会入选2025年的年度AI大模型。这一夜,你我都是见证者。

两周前,我在另一家国产开源模型的文章里写到:“真正的技术进步不是闭源垄断,而是开放共享。”

今天,我想给这句话打上补丁——开源是技术实力的试金石,只有领先者才敢开源。

千问3,敢做,敢当。

一、大模型风口已至:月薪30K+的AI岗正在批量诞生

2025年大模型应用呈现爆发式增长,根据工信部最新数据:

国内大模型相关岗位缺口达47万

初级工程师平均薪资28K(数据来源:BOSS直聘报告)

70%企业存在"能用模型不会调优"的痛点

真实案例:某二本机械专业学员,通过4个月系统学习,成功拿到某AI医疗公司大模型优化岗offer,薪资直接翻3倍!

二、如何学习大模型 AI ?

🔥AI取代的不是人类,而是不会用AI的人!麦肯锡最新报告显示:掌握AI工具的从业者生产效率提升47%,薪资溢价达34%!🚀

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

1️⃣ 提示词工程:把ChatGPT从玩具变成生产工具

2️⃣ RAG系统:让大模型精准输出行业知识

3️⃣ 智能体开发:用AutoGPT打造24小时数字员工

📦熬了三个大夜整理的《AI进化工具包》送你:

✔️ 大厂内部LLM落地手册(含58个真实案例)

✔️ 提示词设计模板库(覆盖12大应用场景)

✔️ 私藏学习路径图(0基础到项目实战仅需90天)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

* 大模型 AI 能干什么?

* 大模型是怎样获得「智能」的?

* 用好 AI 的核心心法

* 大模型应用业务架构

* 大模型应用技术架构

* 代码示例:向 GPT-3.5 灌入新知识

* 提示工程的意义和核心思想

* Prompt 典型构成

* 指令调优方法论

* 思维链和思维树

* Prompt 攻击和防范

* …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

* 为什么要做 RAG

* 搭建一个简单的 ChatPDF

* 检索的基础概念

* 什么是向量表示(Embeddings)

* 向量数据库与向量检索

* 基于向量检索的 RAG

* 搭建 RAG 系统的扩展知识

* 混合检索与 RAG-Fusion 简介

* 向量模型本地部署

* …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

* 为什么要做 RAG

* 什么是模型

* 什么是模型训练

* 求解器 & 损失函数简介

* 小实验2:手写一个简单的神经网络并训练它

* 什么是训练/预训练/微调/轻量化微调

* Transformer结构简介

* 轻量化微调

* 实验数据集的构建

* …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

* 硬件选型

* 带你了解全球大模型

* 使用国产大模型服务

* 搭建 OpenAI 代理

* 热身:基于阿里云 PAI 部署 Stable Diffusion

* 在本地计算机运行大模型

* 大模型的私有化部署

* 基于 vLLM 部署大模型

* 案例:如何优雅地在阿里云私有部署开源大模型

* 部署一套开源 LLM 项目

* 内容安全

* 互联网信息服务算法备案

* …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献280条内容

已为社区贡献280条内容

所有评论(0)