Mac用户狂喜!手把手教你本地部署DeepSeek大模型

它清晰地表明,你的 Mac 的 M 芯片(特别是它的统一内存和集成的 GPU),正在被充分利用来执行 AI 的计算任务!就算你之前没怎么接触过终端,跟着我的步骤走,也能轻松搞定!DeepSeek 作为一款优秀的开源模型,能力也很不错,无论是写代码、写文章、翻译还是问答,都能胜任。作为一个技术宅,我一直在想,能不能把这些强大的 AI 能力,,无论是写代码、写文章、头脑风暴,DeepSeek 都能在你

玩 AI 大模型,你是不是经常遇到两个问题?一是要联网,网不好或者没网就抓瞎;二是有些好用的需要付费,比如 ChatGPT。作为一个技术宅,我一直在想,能不能把这些强大的 AI 能力,直接搬到我的 Mac 上,本地运行,而且完全免费、完全离线呢?!

好消息是,完全可以! 今天,我就要给大家介绍一个超级棒、超级有名气的开源大语言模型——DeepSeek!而且,我们要做的,就是把它部署到你的 Mac book上!

整个过程听起来好像有点技术含量,但相信我,它其实非常简单!咱们只需要安装两个小工具,然后在终端里敲几行命令,再配置一个友好的聊天界面就行了。就算你之前没怎么接触过终端,跟着我的步骤走,也能轻松搞定!

完成后,你的 Mac 就能变成一个离线 AI 工作站,无论是写代码、写文章、头脑风暴,DeepSeek 都能在你本地给你提供强大的帮助!

那咱们就直接开干吧!

第一步:请出“引擎”——安装 Ollama

要让 DeepSeek 这样的开源大模型在 Mac 上跑起来,我们需要一个“引擎”,这个引擎就叫做 Ollama!它专门负责在本地管理和运行各种大模型。

-

下载 Ollama:

- 打开你的浏览器,访问 Ollama 的官网:Ollama

- 网站会自动识别你是 Mac 用户,直接点那个大大的 “Download” 按钮,然后选择 “Download for macOS”。

- 下载下来的文件(通常是一个

.zip或.dmg),找到它,双击打开。

-

安装 Ollama 应用程序:

- 打开下载的文件后,你会看到 Ollama 的图标。就像安装其他 Mac 应用一样,把 Ollama 图标拖拽到“Applications”(应用程序)文件夹里。

- 然后,打开你的“Applications”文件夹,找到 Ollama,双击运行它。

- 第一次打开,系统可能会问“这个App是从互联网下载的,确定要打开吗?”,勇敢地点击**“打开”**!

-

安装 Ollama 命令行工具:

- Ollama 启动后,会弹出一个窗口,跟着向导走。点击 “Next”。

- 它会提示你需要安装命令行工具(Install command line Ollama)。点击**“Install”**。

- 这时候会让你输入你的 Mac 的开机密码。输入密码,点击“好”。

- 安装完成后,它可能会提示你运行第一个模型(比如

ollama run llama2)。这个命令先别急着敲,点一下旁边的**“Copy”按钮**,把它复制下来。

-

验证 Ollama 安装成功:

- 现在,我们需要打开 Mac 的终端。最快的方式是点击屏幕右上角的**“聚焦搜索”(Spotlight Search)图标**(放大镜)。

- 在搜索框里输入 “Terminal”,然后回车打开终端窗口。

- 在终端里,粘贴刚才复制的命令(比如

ollama run llama2),然后回车!

- Ollama 就会开始下载并运行 Llama 2 这个模型。这个过程可能会需要一点时间,终端会显示进度。等到它出现提示符,表示你可以开始和 Llama 2 聊天时,就说明 Ollama 已经成功安装并能运行模型了!

- 你可以先输入

/bye退出这个模型。

恭喜你!AI 的“引擎”已经在你的 Mac 上架设完毕!

第二步:请出主角——下载并运行 DeepSeek 大模型

Ollama 就像一个模型仓库,DeepSeek 就是仓库里的一个商品。现在仓库搭好了,咱们去把 DeepSeek “领”回来!

-

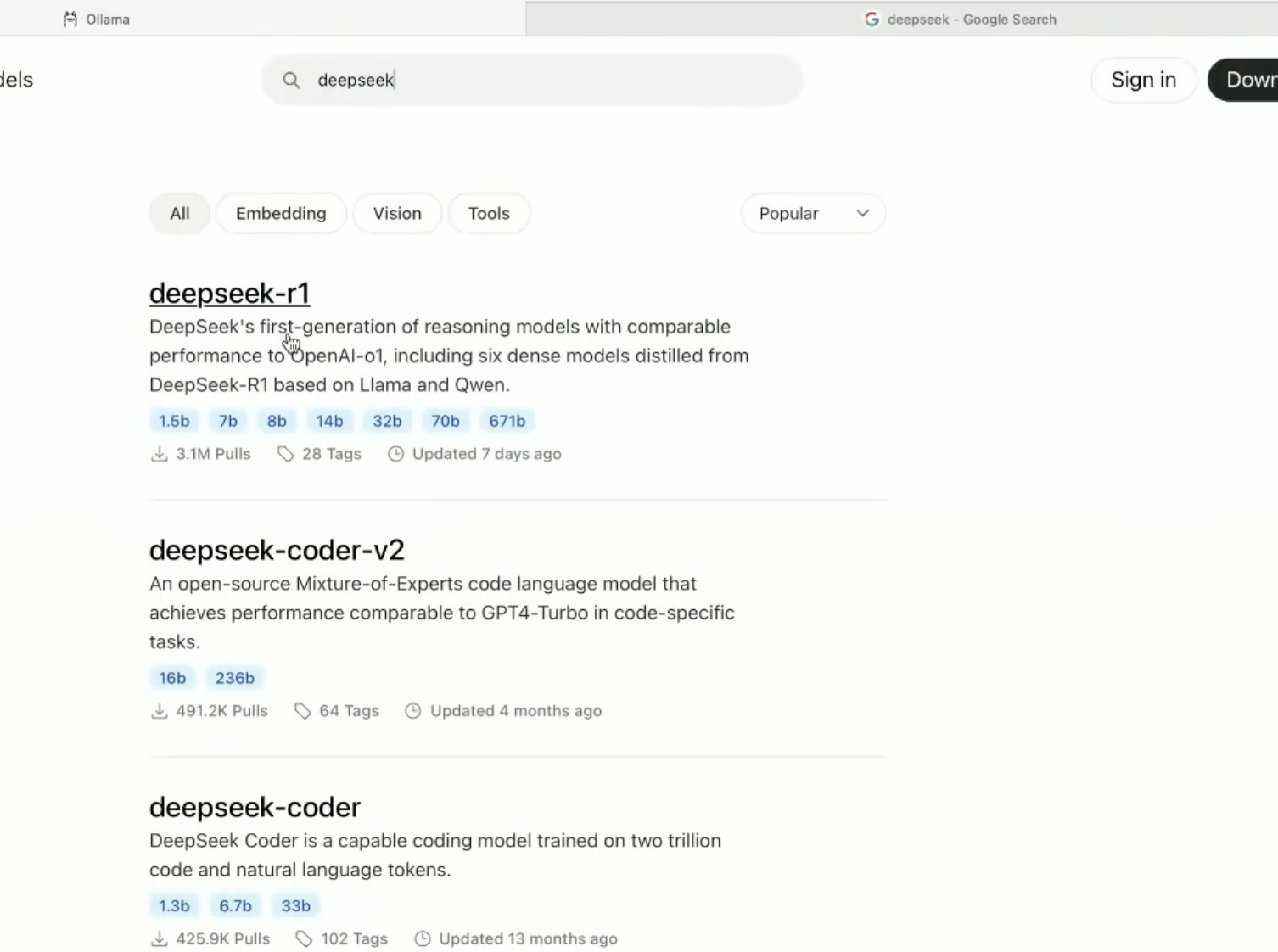

查找 DeepSeek 模型:

- 再次回到 Ollama 的官网:Ollama

- 在网站的搜索框里,搜索 “deep seek”。

- 你会看到 DeepSeek 的模型列表。我们要找的是那个专门为 Apple Silicon Mac 优化过的版本,通常名字里带 “R1” 的比较新。

-

选择模型大小:

- DeepSeek 有不同大小的版本(比如 7B、67B 等)。数字越大,模型越聪明、回答越准确,但也越吃电脑资源(内存/统一内存)!

- 对于大多数 Apple Silicon Mac 用户(特别是基础配置的),我强烈建议先从 7B 版本开始!它大概占用4.7GB 硬盘空间,对内存要求不高,大部分 M 芯片都能流畅跑起来。如果你是 M1 Max、M1 Ultra、M2 Max、M2 Ultra、M3 Max 等配置逆天的机器,可以大胆尝试更大的模型!

- 点击你选择的版本(比如 7B)。

-

复制 DeepSeek 运行命令:

- 进入模型详情页后,会看到一个命令,比如

ollama run deepseek(注意,具体的命令可能随着模型更新有变化,以官网显示的为准)。点击旁边的**“Copy”按钮**复制它。

- 进入模型详情页后,会看到一个命令,比如

-

下载并运行 DeepSeek:

- 回到终端窗口。为了保险起见,你可以关闭当前终端窗口,再重新打开一个(或者直接开个新窗口)。

- 在新的终端窗口里,粘贴刚才复制的命令(比如

ollama run deepseek),然后回车!

- 这时候,Ollama 就会开始下载 DeepSeek 模型文件(大概4.7GB)。这个过程取决于你的网速,耐心等待它下载完成。

- 下载完成后,终端会直接进入 DeepSeek 的交互界面!出现提示符,就说明 DeepSeek 已经在你的 Mac 上本地跑起来了!

-

和本地 DeepSeek 聊天:

- 在终端里,你就可以直接像和 ChatGPT 聊天一样,输入你的问题或指令了!

- 比如,你可以输入:“你好!” 然后回车。

- 或者输入:“你觉得本地运行 AI 有什么好处?” 然后回车,看看它怎么回答。

- 玩完后,输入

/bye并回车,就可以退出 DeepSeek 的命令行交互界面了。下次想再用,重新在终端里输入ollama run deepseek回车就行。

太棒了!你的 DeepSeek 大模型,现在正乖乖地在你的 Mac 里为你服务!

第三步:装个漂亮的“外壳”——使用 Chatbox AI (可选,但强烈推荐!)

虽然终端命令行能用,但总归没那么方便直观,特别是看长回答。咱们给 DeepSeek 穿个“马甲”,装一个图形界面的聊天应用!这里推荐一个免费的开源应用:Chatbox AI。

-

下载 Chatbox AI:

- 打开浏览器,访问 Chatbox AI 的官网:ChatBox

- 网站通常也会识别你的系统。找到并下载 Apple Silicon 版本(文件名可能带

arm64)。 - 下载完成后,找到文件,双击打开。

-

安装 Chatbox AI 应用程序:

- 把 Chatbox 图标拖拽到“Applications”(应用程序)文件夹里。

- 然后打开“Applications”文件夹,找到 Chatbox,双击运行。

- 同样,第一次打开可能会让你确认,点击**“打开”**。

-

配置 Chatbox 连接本地 DeepSeek:

- Chatbox 打开后,可能会让你选择模型或连接方式。我们不需要用它的付费功能。

- 选择使用**“本地模型”(Local Model)**。

- 在提供商(Model Provider)里,选择 “Ollama API”。

- 在模型列表里,你应该能看到你刚才通过 Ollama 安装的 DeepSeek 模型,比如 “deepseek-coder:7b” 或者 “deepseek”。选择它!

- 点击**“保存”(Save)**或确认。

搞定!现在,你打开 Chatbox,看到的界面就是和 ChatGPT 类似的聊天框,但它背后连接的,是你 Mac 上本地运行的 DeepSeek 模型!

第四步:见证奇迹——离线运行与 GPU 加速!

配置好了,咱们来点儿刺激的!看看它是不是真的在本地跑,而且是不是真的用上了你 Mac 的 M 芯片的性能!

-

断开网络,证明离线运行!

- 去你的 Mac 的**“系统设置”(System Settings),找到“网络”(Network)**。

- 把你当前连接的网络(Wi-Fi 或以太网)断开或者设为非活跃(Inactive),确保 Mac 彻底断网!

- 回到 Chatbox,问它一个需要联网才能知道的问题,比如:“今天北京的天气怎么样?”

- 你会发现,它无法给出答案,或者明确告诉你它无法获取实时信息。这完美地证明了它没有联网,是在完全离线状态下运行的!

-

监控 GPU,证明本地计算!

- 现在,咱们来证明它是在用 Mac 的硬件计算!

- 打开 Mac 的**“活动监视器”(Activity Monitor)**(可以在“应用程序”->“实用工具”里找到,或者用聚焦搜索)。

- 在活动监视器窗口里,点击顶部菜单栏的**“窗口”(Window),然后选择“GPU 历史记录”(GPU History)**。这会弹出一个小窗口,实时显示你的 Mac 图形芯片(GPU)的利用率曲线。

- 回到 Chatbox,给 DeepSeek 一个计算量比较大的指令,比如:“写一篇关于苹果芯片 Mac 玩游戏的 1000 字文章”、“用讽刺的语气写一篇关于某个热点事件的 500 字短文”。

- 当你发送指令后,立刻切换回“GPU 历史记录”窗口!你会惊奇地看到,在你 Mac 生成回复的过程中,那条 GPU 利用率曲线会猛烈地上升,甚至拉满!

It's cool! 它清晰地表明,你的 Mac 的 M 芯片(特别是它的统一内存和集成的 GPU),正在被充分利用来执行 AI 的计算任务!所有的推理过程都在你的本地硬件上完成,不联网,不花钱,纯靠自己的 Mac 性能!

总结:把 DeepSeek 搬回家,Mac 变身最强离线 AI 工作站!

经过这几步简单的操作,你已经成功地在你的 Apple Silicon Mac 上免费、离线地部署并运行了 DeepSeek 大语言模型,并且拥有了一个还算漂亮(勉强能用)的聊天界面!

相比于在线的 AI 服务,本地部署的优势太明显了:免费、保护隐私(数据不上传)、不依赖网络、还能充分利用你的 Mac 硬件性能! 特别是对于 M 芯片 Mac 用户来说,这些芯片在处理这类任务时效率非常高,体验丝滑。

DeepSeek 作为一款优秀的开源模型,能力也很不错,无论是写代码、写文章、翻译还是问答,都能胜任。

所以,如果你也是 Apple Silicon Mac 用户,并且对 AI 感兴趣,强烈建议你跟着这个教程,亲自尝试一下,随时随地发挥 AI 的力量!

好了,今天的分享就到这里!希望这个教程对大家有帮助!如果成功部署了,别忘了在评论区留言,交流一下使用体验!

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)