手把手指导您部署DeepSeek-R1模型(在线使用和API部署两个版本)

本来不打算发的来着,DeepSeek这波流量不蹭一蹭感觉有点可惜。

本来不打算发的来着,DeepSeek这波流量不蹭一蹭感觉有点可惜

在线使用版

腾讯官网地址:Cloud Studio(点击直达)

-

首先进行注册/登录,完成之后点击空间模板

-

接着在AI 模板中选择Ollama

-

选择基础型(免费)

-

接着就是此时出现正在创建环境,需要稍等一会儿

-

环境创建完毕,点击刚刚创建的环境,会跳转到vscode的开发界面

-

点击上方的终端,新建终端

之后就会在下方出现:

-

输入

ollama -v进行测试

-

输入

ollama run deepseek-r1:8b进行模型的部署,直到出现success证明部署成功

-

这之后就可以随意调教DeepSeek-R1了

API部署版

(希望你已经执行过之前的步骤了

以下图片中出现的链接全部无法访问,

有一些小提示

- 在vscode界面的操控中,

选中要复制的文字,进行右键是复制,Ctrl+Shift+v是粘贴- 不用在意为什么终端前面的符号和上面的教程不同,这是不需要GPU的运行环境,操作和在上面的操作环境(有GPU的)是一致的

部署Cpolar进行内网穿透

墙裂建议使用之前先注册一个

cpolar的账号:cpolar - secure introspectable tunnels to localhost(点击直达)(选择免费版套餐即可)(没有推广链接,可放心点击)

-

直接在打开的终端中输入:

sudo apt install nano curl wget aria2 -y

-

注册cpolar,复制下载地址

-

在终端输入:

wget <复制的链接>(记得把<和>也一起替换了)

-

解压程序,输入:

unzip cpolar之后按Tab键进行补全

-

进行连接,在cpolar网站找到3,复制下面一串代码(注意:不要复制"$"符号)

-

在终端右侧找到**+**号,新建一个终端

在新终端中输入:python -m http.server

这时候不要管右下角的弹框:

我们切回执行unzip操作的终端

执行:./cpolar http 8000进行测试是否可以访问

复制出现的链接:https://15c4c61b.r18.cpolar.top (替换为自己的链接),在浏览器页面中打开

如果出现如下,则穿透部署正确,可以把之前打开python的终端关闭了。

部署Ollama的API服务

-

输入

ollama -v检查部署 -

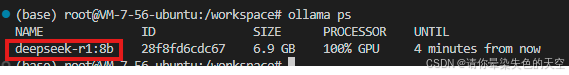

检查是否有模型在后台运行:

ollama ps

-

(如果没有运行的话,运行了就不需要执行了)开启DeepSeek-R1,输入:

ollama run deepseek-r1:8b

-

新建一个终端,开启Ollama的API服务,输入:

ollama serve

后面出现的6399就是要访问的端口号

- 再新建一个终端,输入:

./cpolar http 6399启动https服务

出现:

则说明部署成功,现在这个就是可以访问的API地址。

随便搞一个客户端

一个简单的Python客户端

客户端的一些提示:

- 这只是一个简单的用于测试的客户端

- 这个简易的客户端需要Python

随便写一个用来接收返回值的脚本

需要执行:pip install requests

# testAPI.py

import requests

import json

# url 要替换为自己网站的url

url = "http://3d51d189.r18.cpolar.top/api/generate"

# 参数中model可以在终端中使用`ollama ps`进行查看(见下图)

payload = {

"model": "deepseek-r1:8b",

"prompt": "Why is the sky blue?",

"stream": True,

}

response = requests.post(url, json=payload, stream=True)

if response.status_code == 200:

full_response = ""

for line in response.iter_lines():

if line:

chunk = json.loads(line.decode('utf-8'))

full_response += chunk.get("response", "")

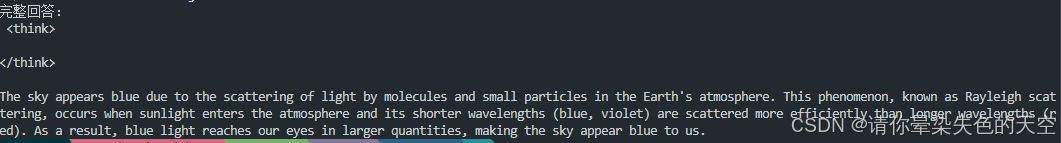

print("完整回答:\n", full_response)

else:

print(f"请求失败,状态码: {response.status_code}")

print("响应内容:", response.text)

运行:python testAPI.py

返回值为:

一个简单的NodeJS客户端

客户端的一些提示:

- 这只是一个简单的用于测试的客户端

- 这个简易的客户端需要NodeJS

随便写一个用来接收返回值的脚本

需要执行: npm install axios

const axios = require('axios');

async function generateResponse() {

// url 要替换为自己网站的url

const url = 'http://3d51d189.r18.cpolar.top/api/generate';

// 参数中model可以在终端中使用`ollama ps`进行查看

const payload = {

model: "deepseek-r1:8b",

prompt: "Why is the sky blue?",

stream: true,

};

try {

const response = await axios({

method: 'post',

url,

data: payload,

responseType: 'stream'

});

if (response.status !== 200) {

throw new Error(`请求失败,状态码: ${response.status}`);

}

let fullResponse = '';

let buffer = '';

response.data.on('data', (chunk) => {

buffer += chunk.toString();

const lines = buffer.split('\n');

buffer = lines.pop();

lines.forEach(line => {

if (line.trim()) {

try {

const data = JSON.parse(line);

fullResponse += data.response || '';

} catch (err) {

console.error('JSON解析错误:', err);

}

}

});

});

response.data.on('end', () => {

console.log('完整回答:\n', fullResponse);

});

response.data.on('error', (err) => {

console.error('流处理错误:', err);

});

} catch (err) {

console.error('请求失败:', err.message);

if (err.response) {

console.error('错误响应内容:', err.response.data);

}

}

}

generateResponse();

运行:node testAPI.js

返回值为:

接入ChatBox

ChatBox 官网链接:Chatbox AI(点击直达)(没有推广链接,可放心点击)

也可以在Github Releases上下载

打开ChatBox App

linux的部分用户注意:

在使用AppImage的时候可能会出现无法打开的情况

需要执行./Chatbox-xxx.AppImage --no-sandbox打开

点击侧边栏的设置按钮,点击特定模型设置,选择提供方为Ollama API,接着把链接粘贴进去,点击保存即可使用.

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)