(本地化部署)快速使用DeepSeekR1教程

设置启动端口:配置环境变量OLLAMA_HOST 值为端口号默认情况下安装在:C:\Users\用户.ollama\models 目录下新建一个环境变量 OLLAMA_MODELS ,值为一个你想存储模型的磁盘文件夹先关闭ollama在到:C:\Users\用户\AppData\Roaming\Microsoft\Windows\Start Menu\Programs删除ollama.exe。

·

1、下载ollama

https://ollama.com/download

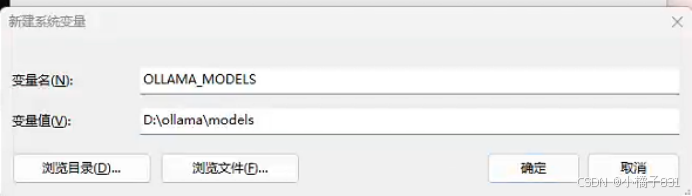

2、设置ollama的模型环境变量(可选)

设置启动端口:配置环境变量OLLAMA_HOST 值为端口号

默认情况下安装在:C:\Users\用户.ollama\models 目录下

新建一个环境变量 OLLAMA_MODELS ,值为一个你想存储模型的磁盘文件夹

3、关闭ollama开机自启动(可选)

先关闭ollama在到:

C:\Users\用户\AppData\Roaming\Microsoft\Windows\Start Menu\Programs

删除ollama.exe

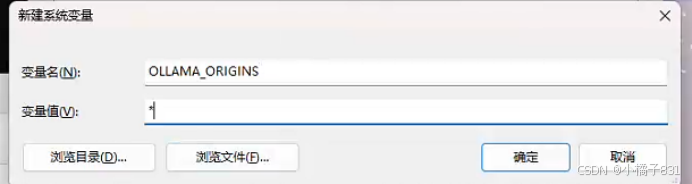

4、配置跨域请求(可选,要用可视化界面必选)

ollama默认只允许127.0.0.1 和 0.0.0.0 访问

设置环境变量OLLAMA_ORIGINS 值为 *

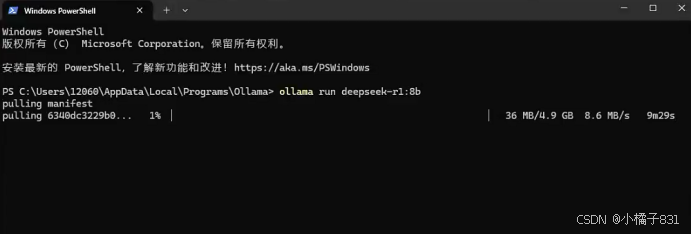

5、运行ollama

安装目录默认在 C:\Users\用户\AppData\Local\Programs\Ollama

在此目录右键打开命令行窗口 输入:

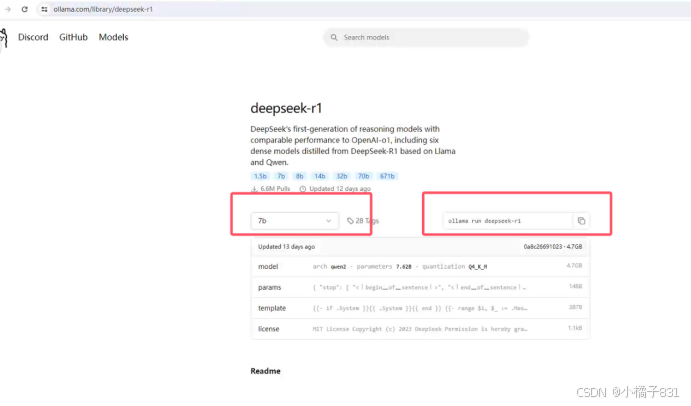

ollama run deepseek-r1:8b

具体模型可在https://ollama.com/search 中选择

6、安装可视化工具

https://chatboxai.app/zh

启动网页版

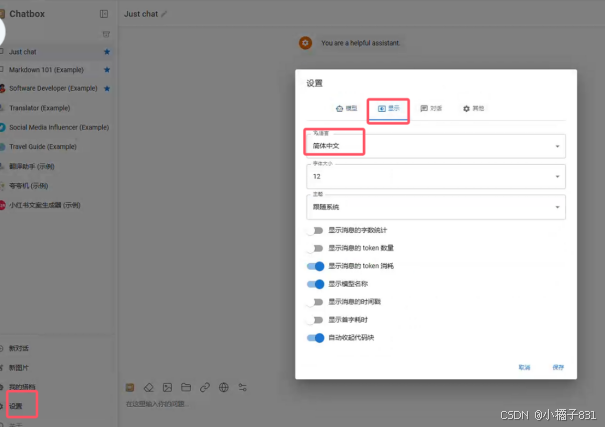

调整语言:

配置模型API:

完成对话:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)