超详细配置本地的DeepSeek模型

·

目录

配置流程

提前了解:

Ollama 是能让用户在本地下载、运行及共享各类大语言模型,保障数据隐私且无需依赖云端服务的工具;

Chatbox 是集成多个大语言模型 API,以统一界面供用户便捷切换模型交互的跨平台开源 AI 聊天客户端。

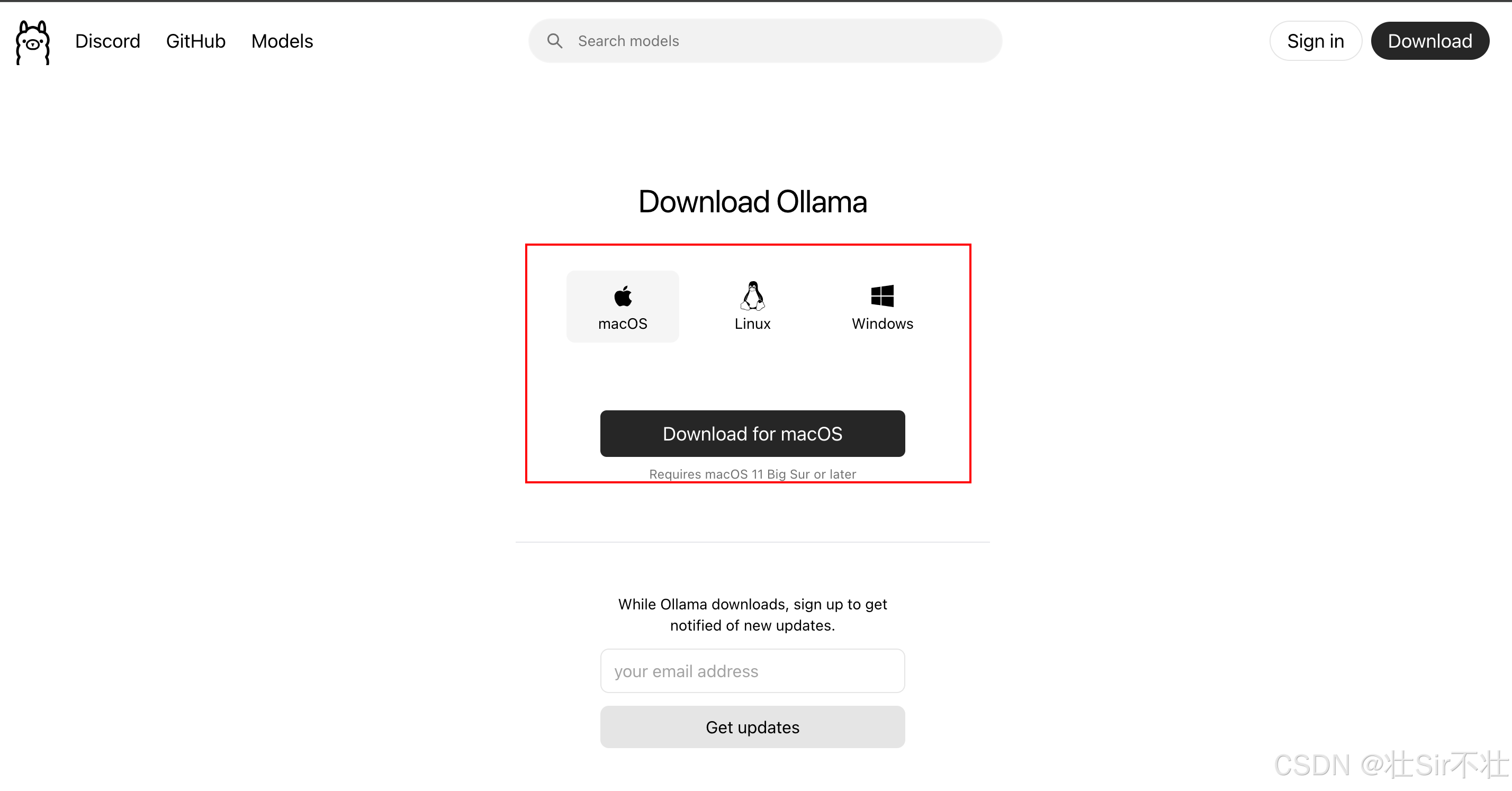

第一步:下载Ollama

网址:Ollama

根据自己的电脑选择:

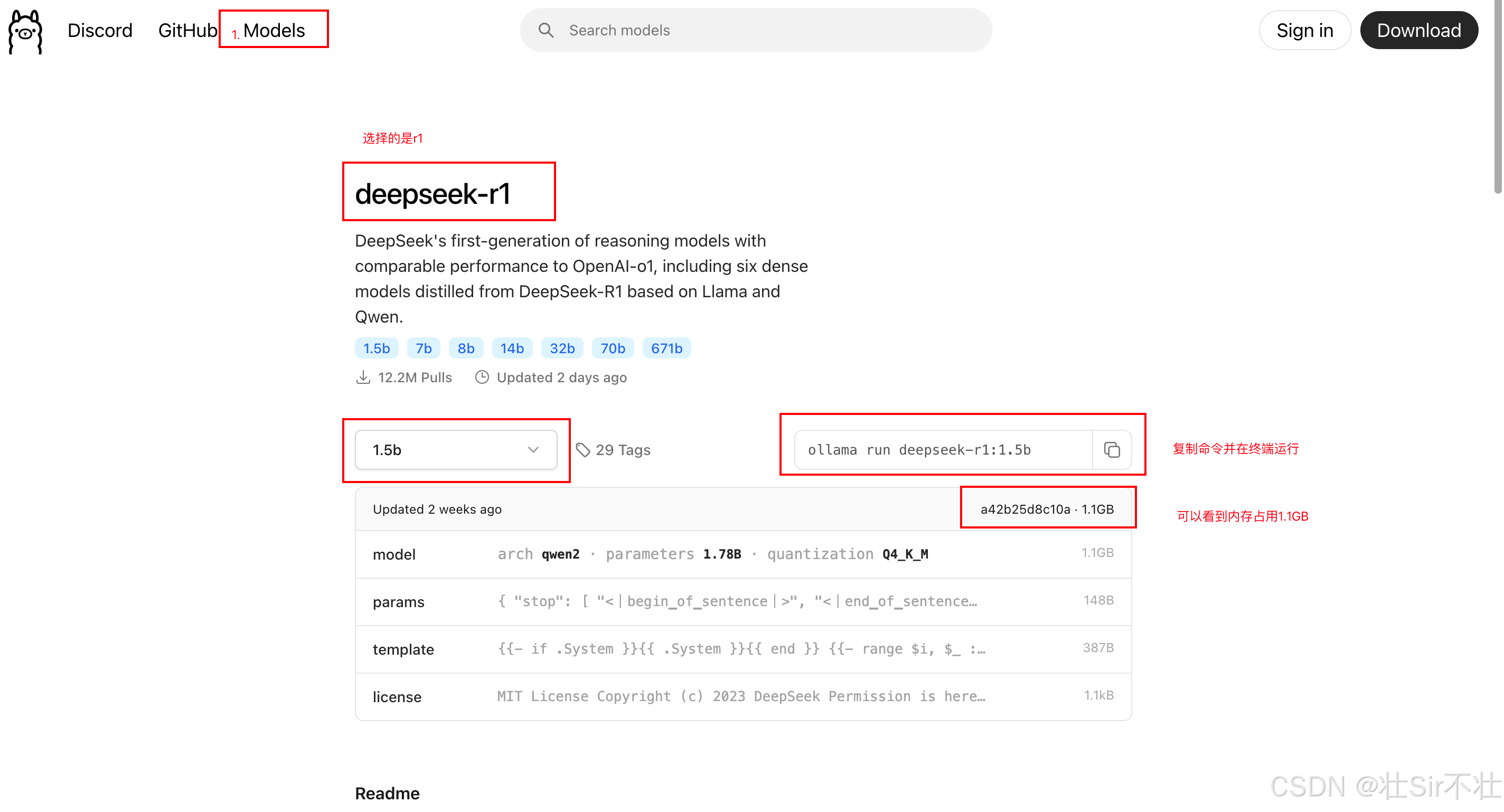

第二步:下载deepseek模型

我选择的是1.5b,在终端运行命令:

ollama run deepseek-r1:1.5b第一次运行该命令会下载 1.5b 的版本,下载完成以后,再执行该命令就无需下载,可以直接运行了。

下载结束后,查看是否已经成功下载:

$ ollama list

NAME ID SIZE MODIFIED

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 15 hours ago不同模型名称中的 1.5B、7B、14B 等数字代表模型的参数量,这里的 B 是“Billion”(十亿) 的缩写。参数量的多少直接影响模型的“聪明程度”、计算资源需求和适用场景,也不是说越多越好,因为越多其硬件的资源消耗也会越多,要根据自己电脑的情况来定。

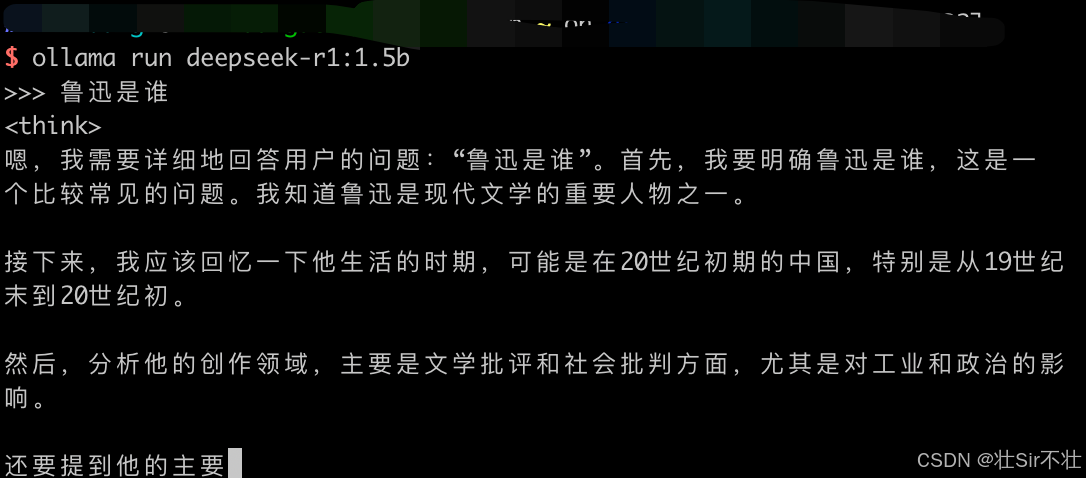

走到这里已经可以使用了,输入上面的命令(ollama run deepseek-r1:1.5b)即可:

但是这样似乎不太美观,为了有一个UI界面让它看起来更好看,我们进行第三步骤。

但是这样似乎不太美观,为了有一个UI界面让它看起来更好看,我们进行第三步骤。

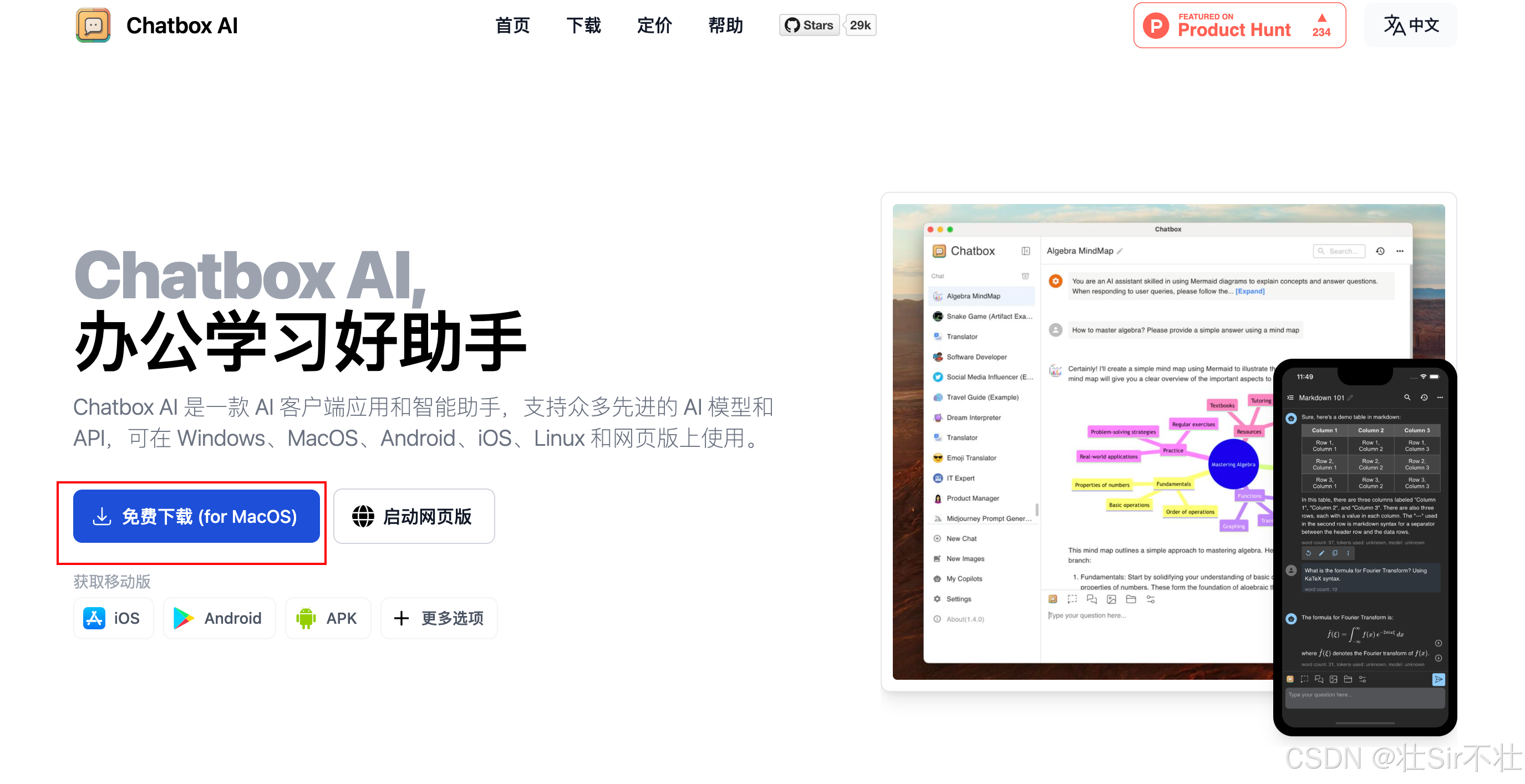

第三步:在Chatbox上配置deepseek模型

安装Chatbox AI(可视化操作界面):Chatbox AI官网:办公学习的AI好助手,全平台AI客户端,官方免费下载

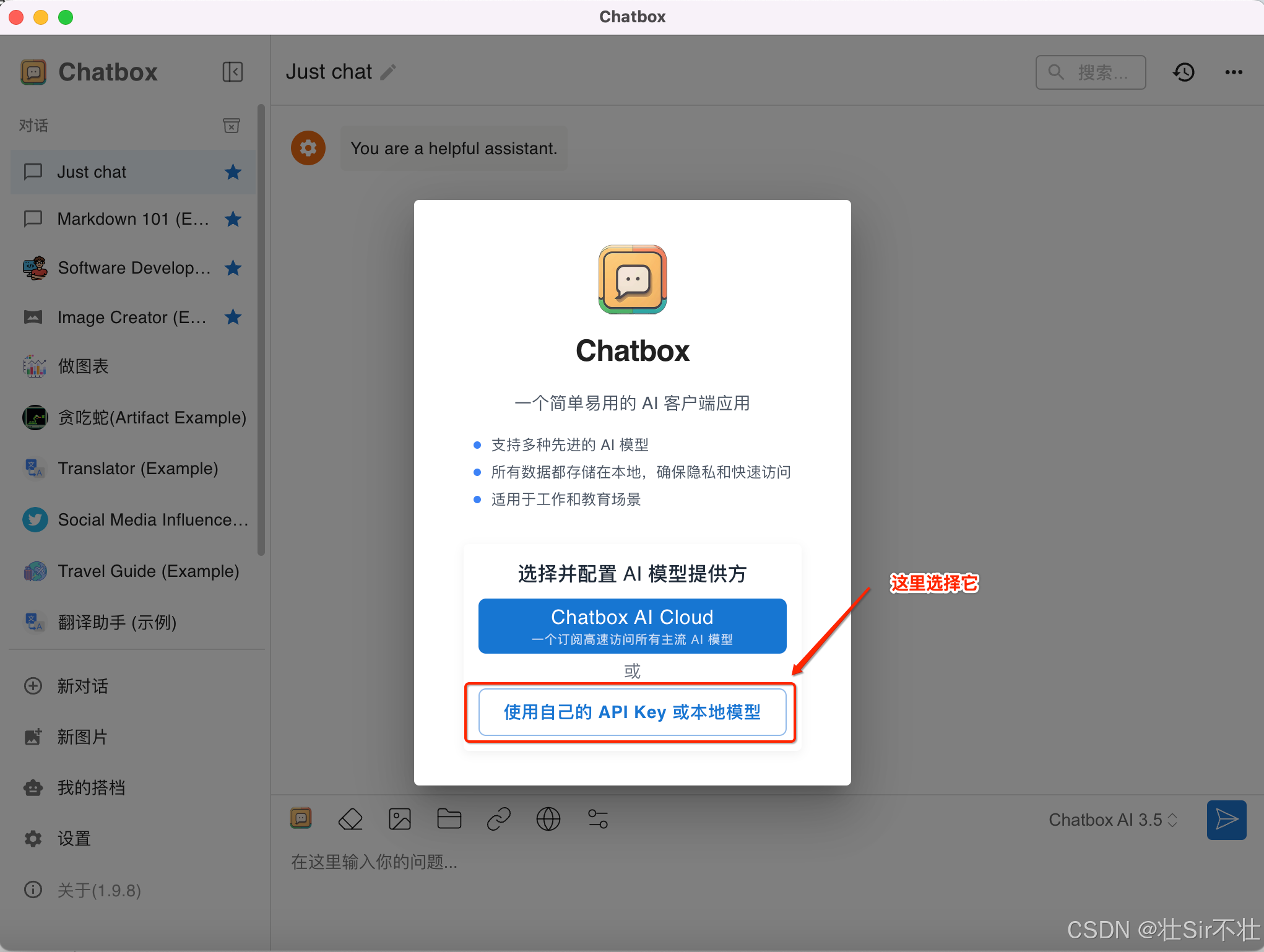

下载结束后,打开Chatbox,此时会让我们进行一个选择:

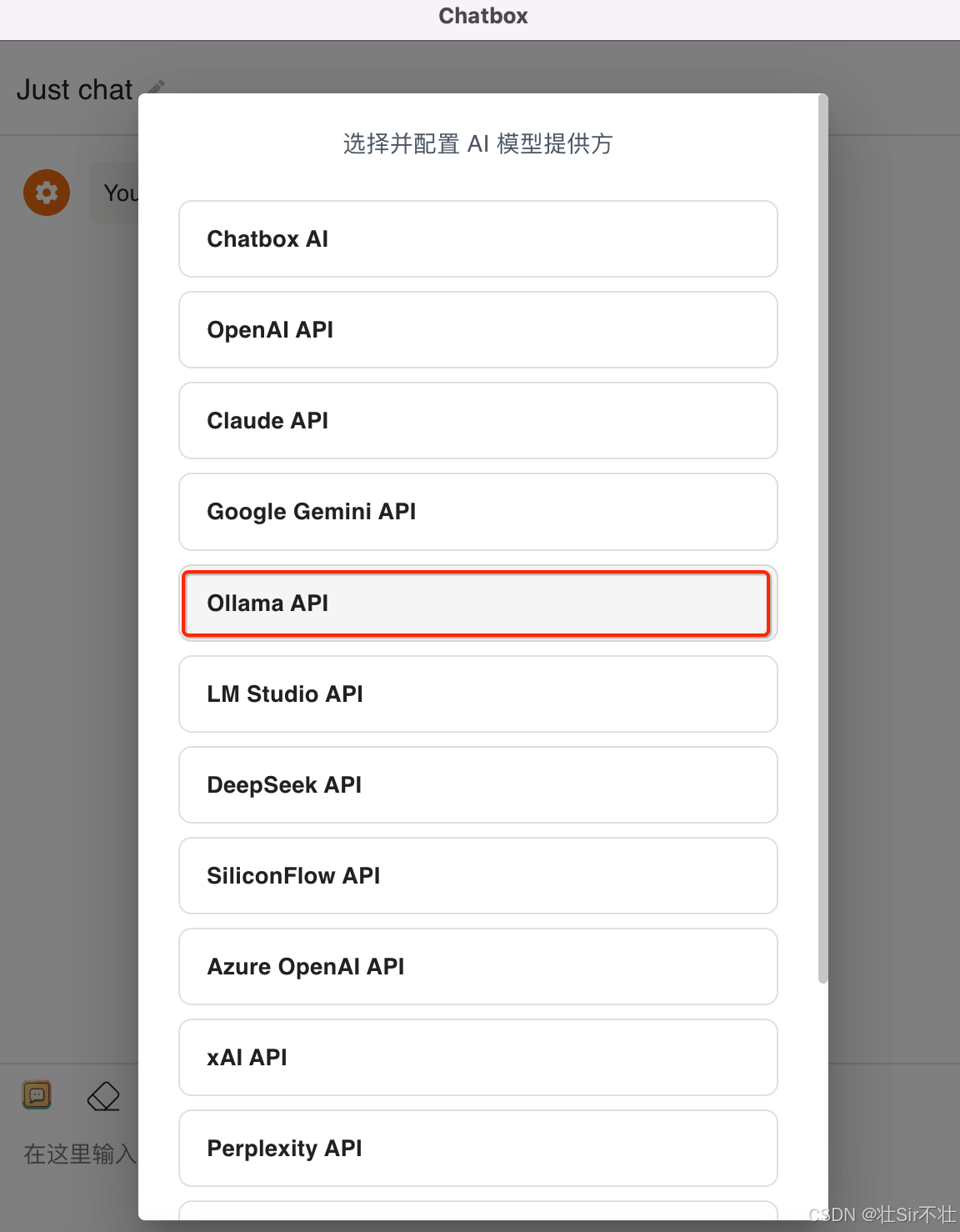

再一次选择:Ollama API

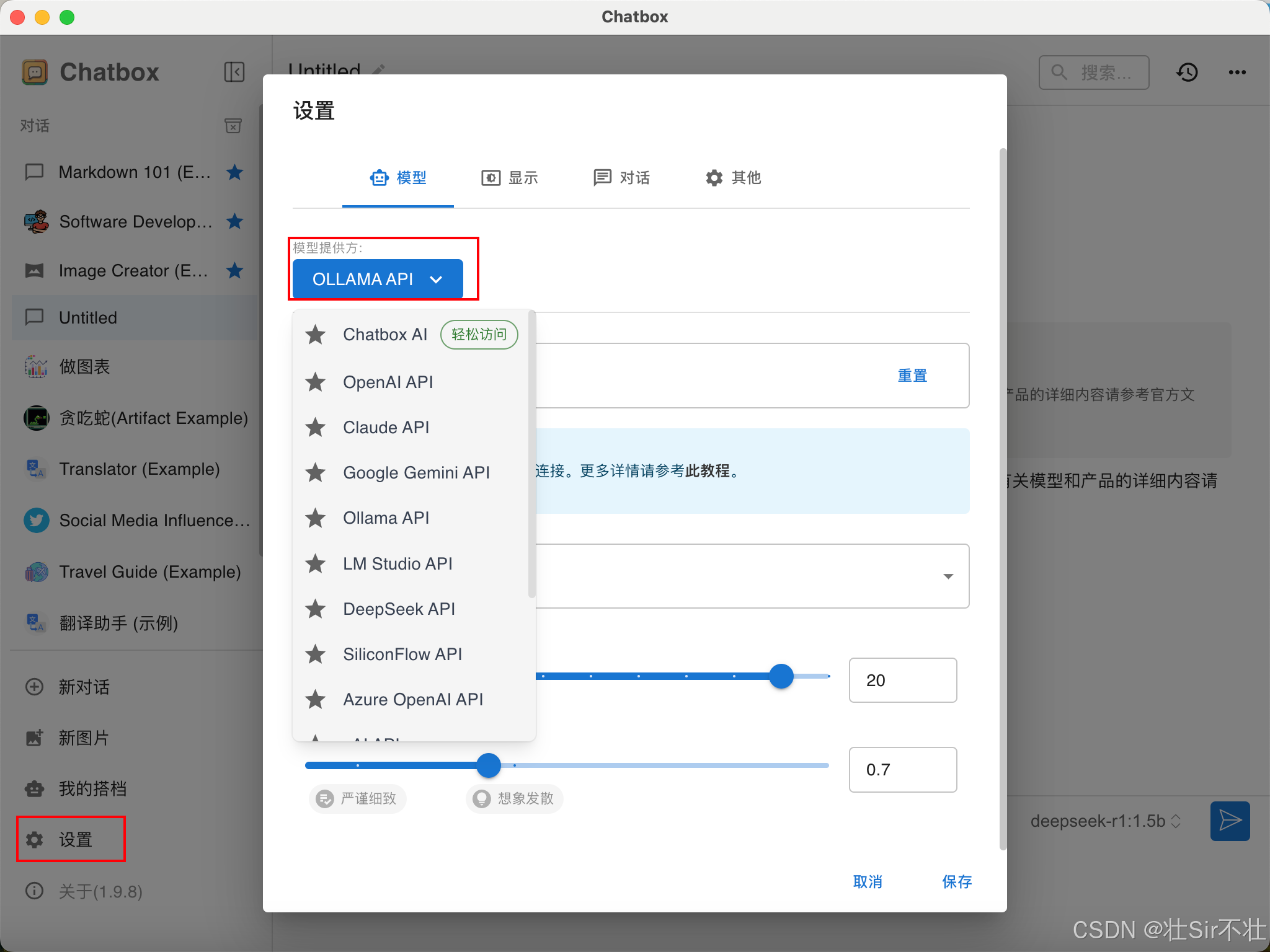

如果不小心选错了,也没关系,我们点击设置,选择模型提供方Ollama API:

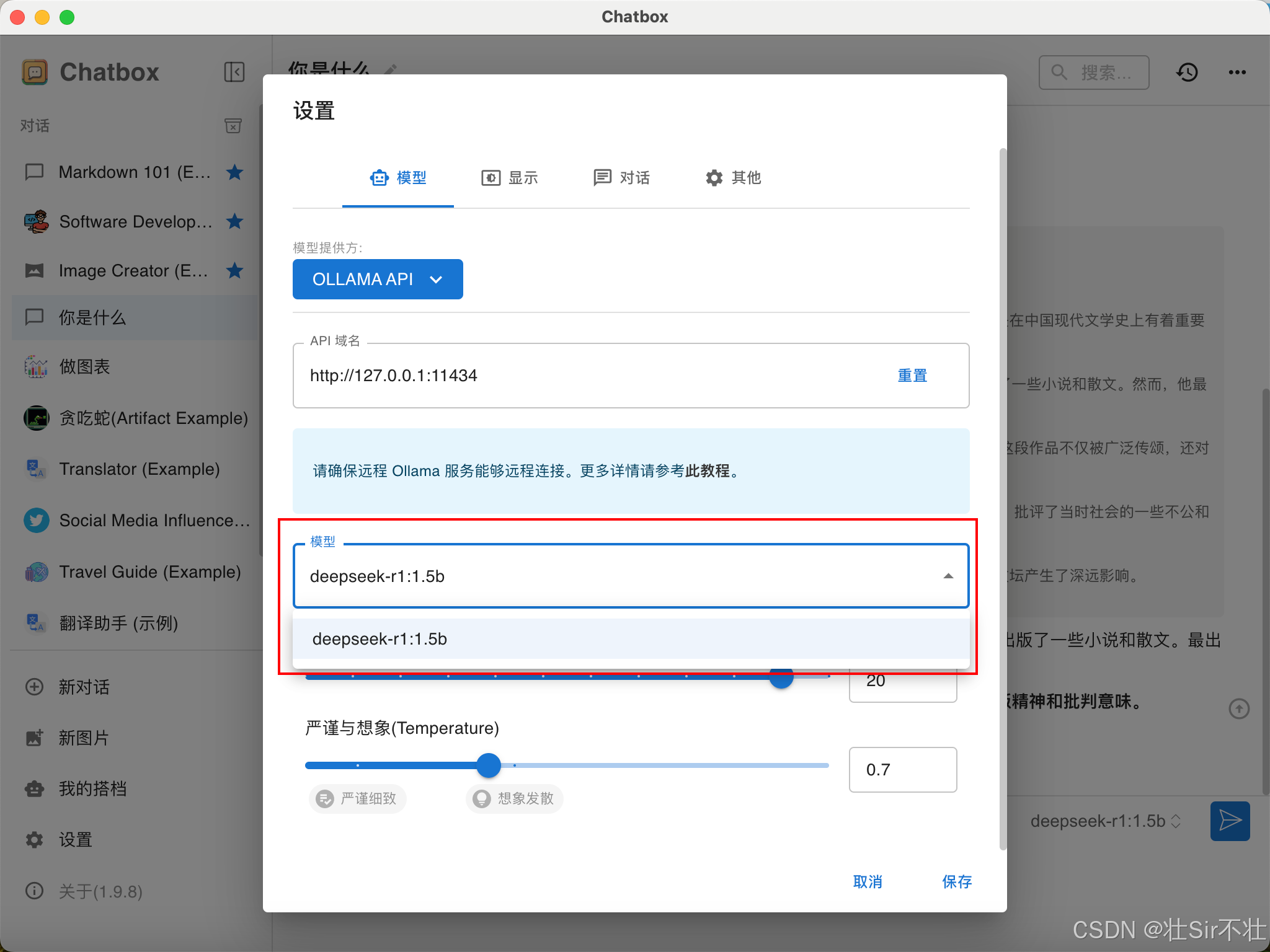

然后选择已经下载好的deepseek-r1模型,这里会自动识别我们已经安装的模型:

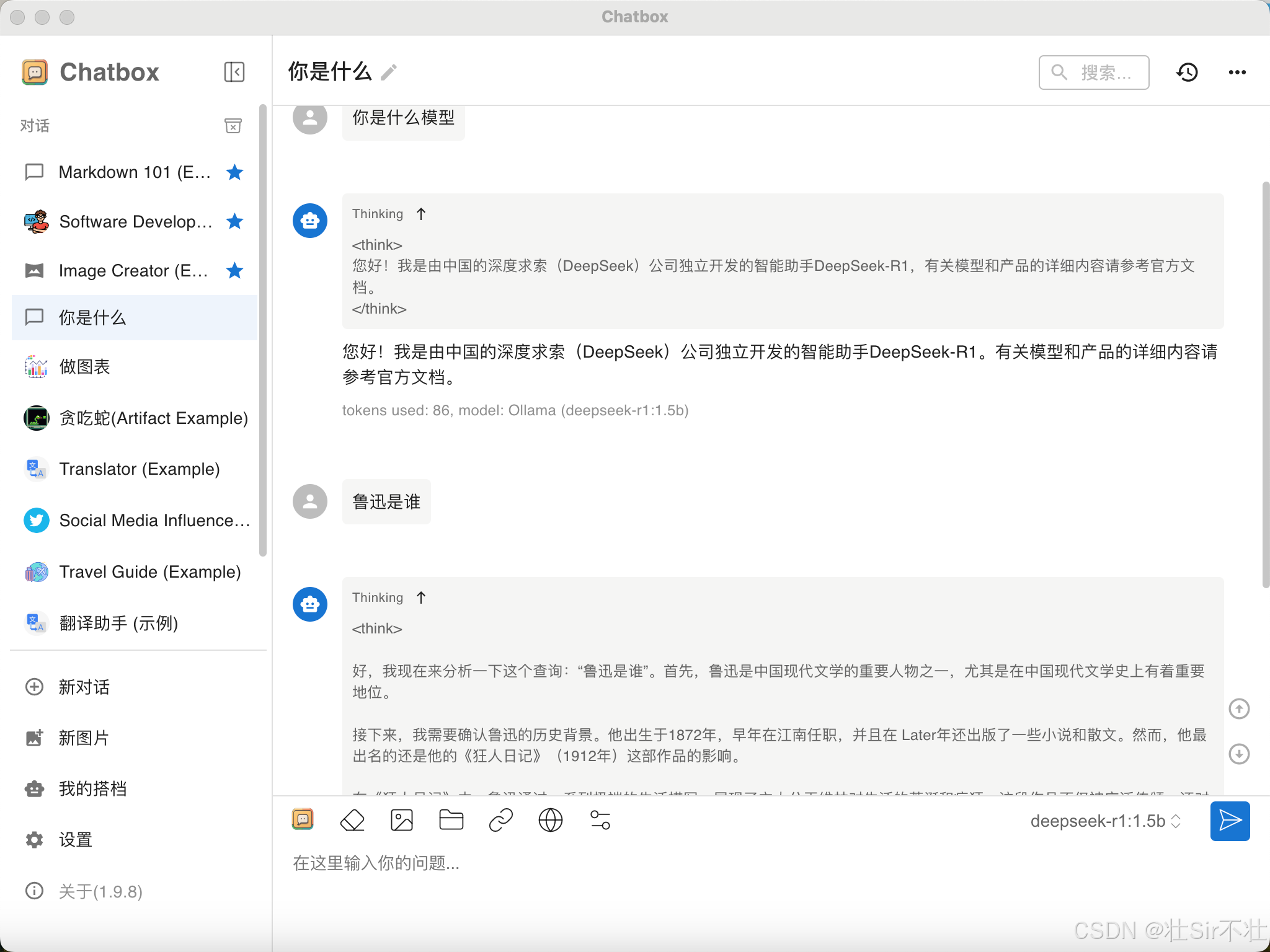

然后开启一个新对话就可以聊天了(关闭网络也可以进行聊天):

了解DeepSeek

DeepSeek的R1和V3模型

深度思考是R1模型,如果不选择深度思考则是V3模型:

区别如下:

区别如下:

- V3:基本上可以处理绝大多数种类的任务。

- R1:顾名思义,通过深度思考搜索的内容更加垂直,R1在需要逻辑推理的任务上更擅长,比如写代码,做数学题。同时R1的成本也会更高。

参考:

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)