DeepSeek满血复活,比GPT还爽!

教程有点长,大家耐心看完,并不会很难的喔~

啰嗦几句

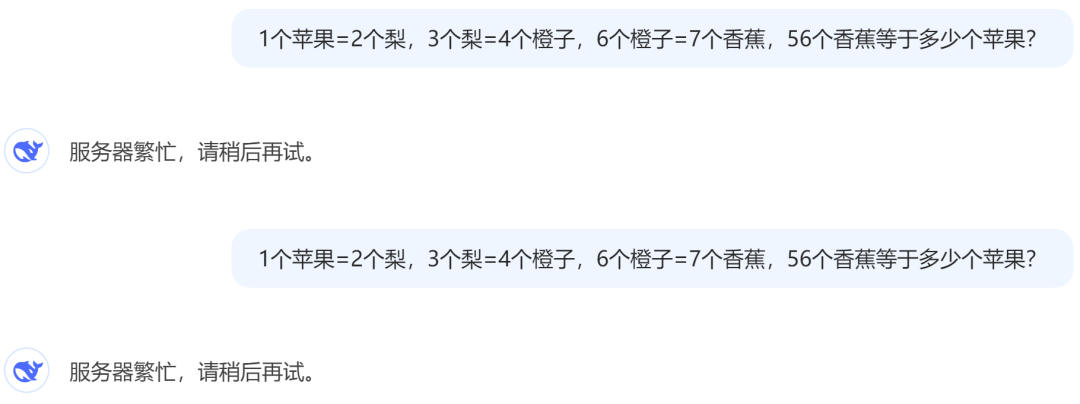

这两天有不少的小伙伴私信我要DeepSeek的安装教程,说网页版动不动就提示“服务器繁忙,请稍后再试”

本来我也测试好了准备成文,但是想写得更详细点,所以一直拖着没发上来。

求的人太多了,所以我在这里就给大家一一讲解,如果有不清楚的地方,大家可以文末留言,我尽量给大家解决。

软件介绍

教程有点长,大家耐心看完,并不会很难的喔~

第一步:安装Ollama

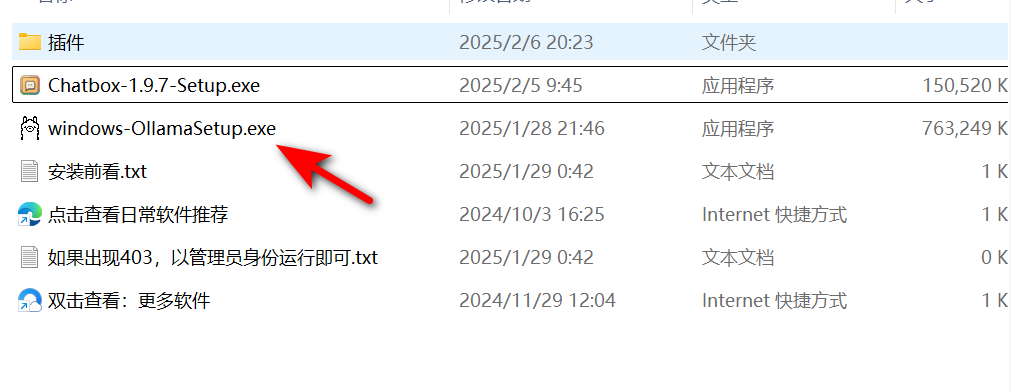

Ollama是一个支持大模型本地调用的工具,DeepSeek这种大模型的调用就是基于Ollama,所以大家首先双击“windows-OllamaSetup.exe”

我给大家提供的Ollama是Windows端,Mac端和Linux端可以自己去官网_https://ollama.com/download_下载。

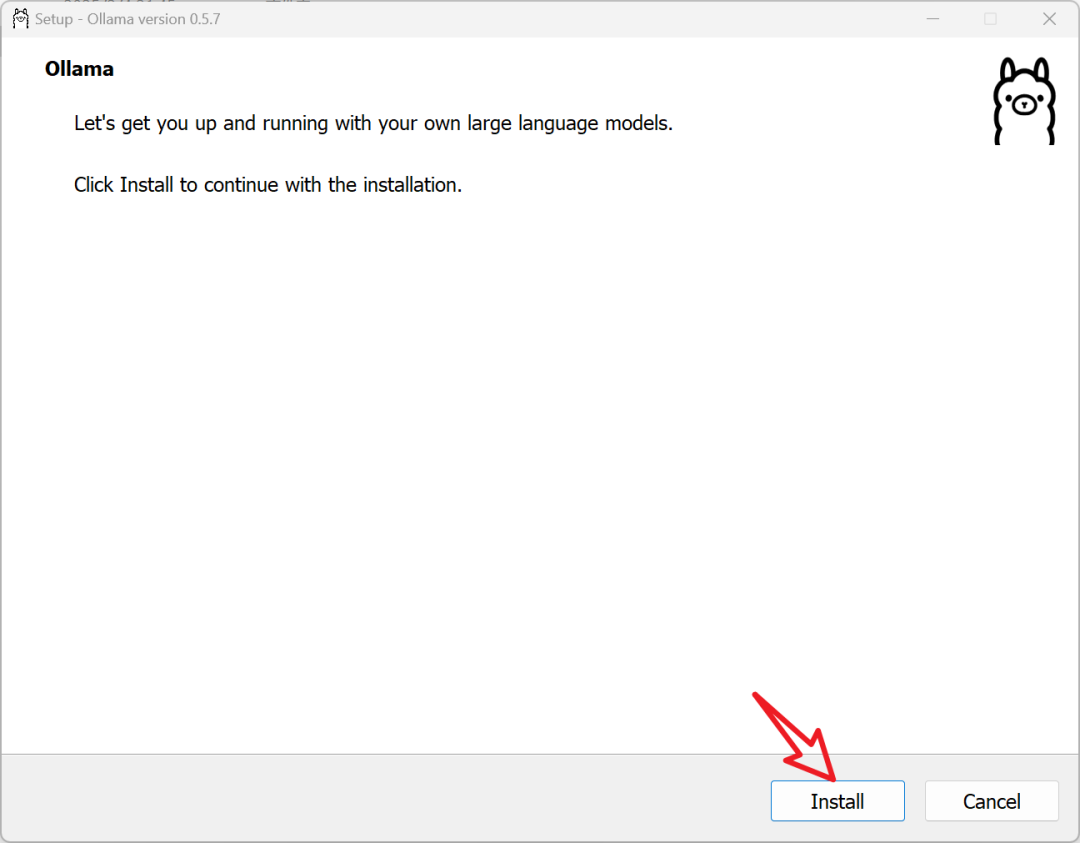

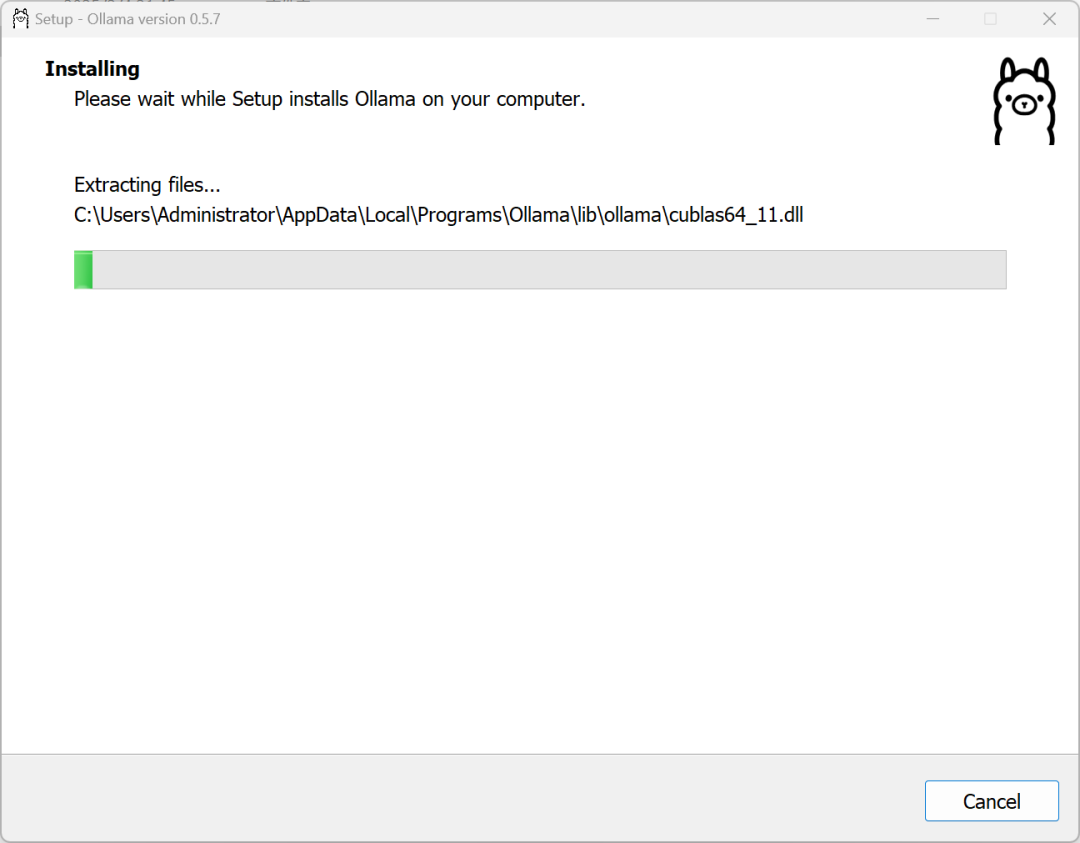

我以Windows为例,其安装过程是全英文,点击【Install】然后根据提示完成安装即可。

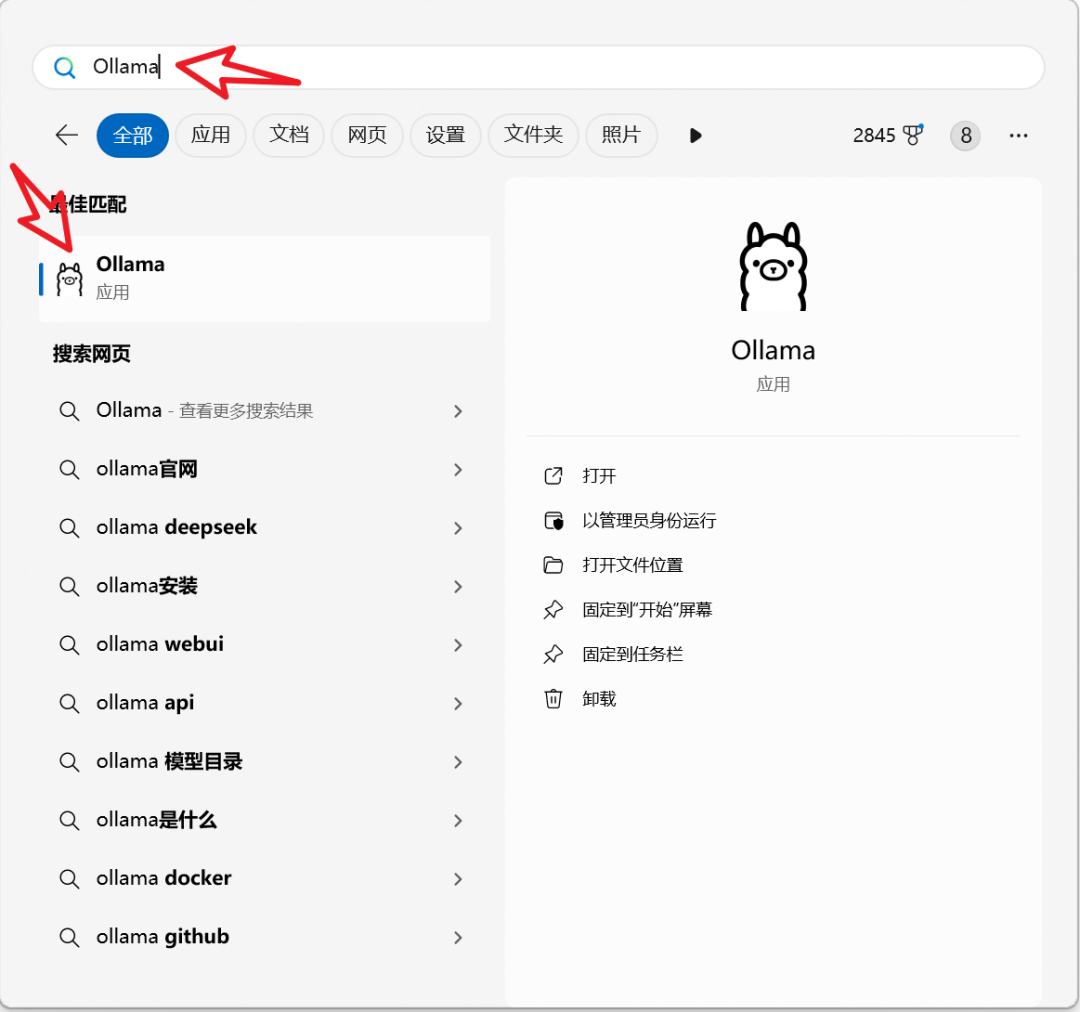

安装完成后,在电脑开始菜单,输入“Ollama”点击软件即可启动。

第二步:安装DeepSeek模型

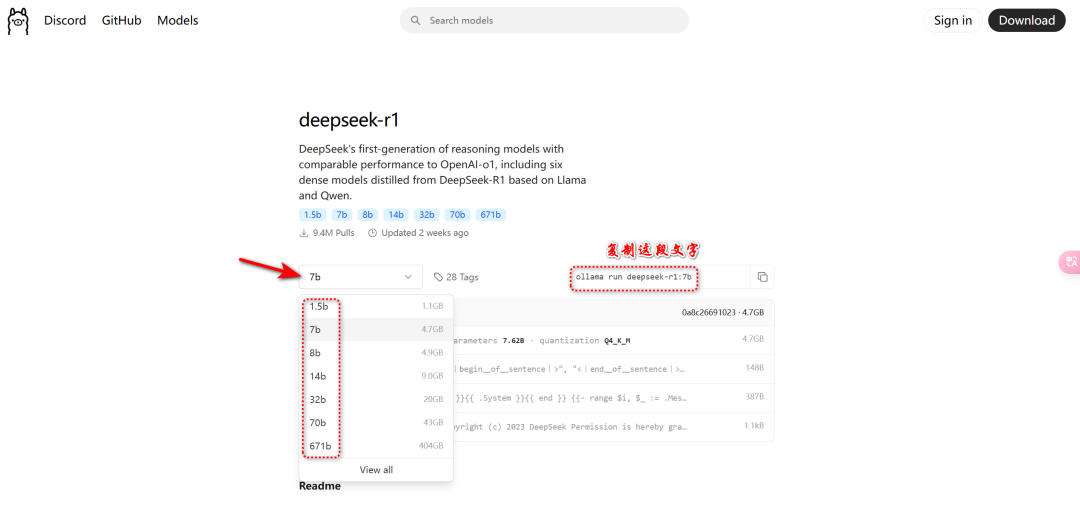

安装完Ollama以后,我们就要开始安装模型了。打开网页https://ollama.com/library/deepseek-r1,我们可以看到模型。

大家可以根据自己的电脑性能进行选择。

・1.5B:入门级别,硬件配置“4GB内存+核显”即可运行;

・7B:进阶级别,“8GB内存+4GB显存”可运行;

・32B:高性能设备推荐,“32GB内存+12GB显存”

这里推荐大家使用7B,绝大部分电脑都能运行。如果选择7B,则复制“ollama run deepseek-r1:7b”

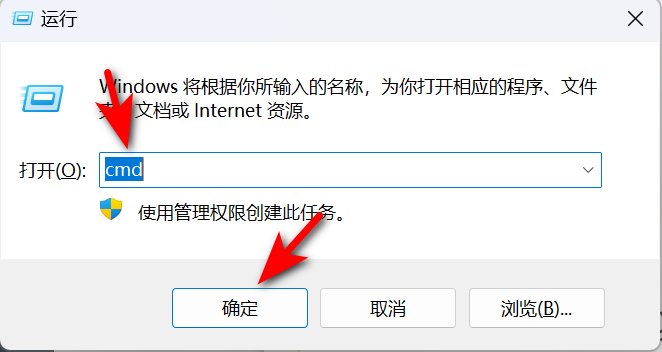

按下“Win键+R”,输入“cmd”打开命令行窗口。

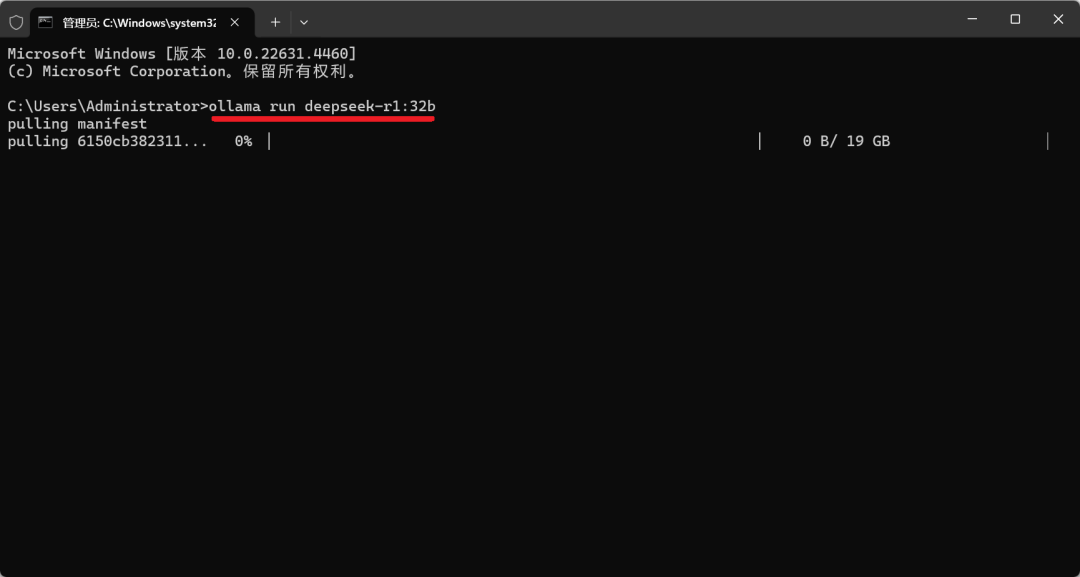

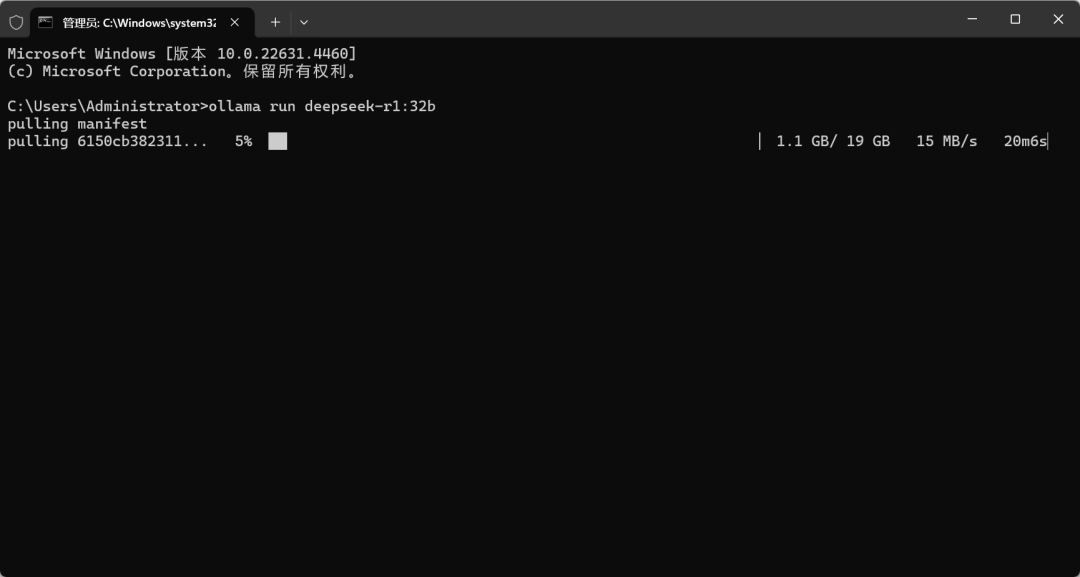

然后输入上面的那串文字“ollama run deepseek-r1:7b”,下图软妹电脑选择了32B,但事实是选择7B更好。

然后软件就开始下载大模型,我选择的32B需要下载19G的模型_(再强调,大家不要选择32B,一般性能的电脑用7B即可)_,下载的速度有点慢,大家耐心等待即可。

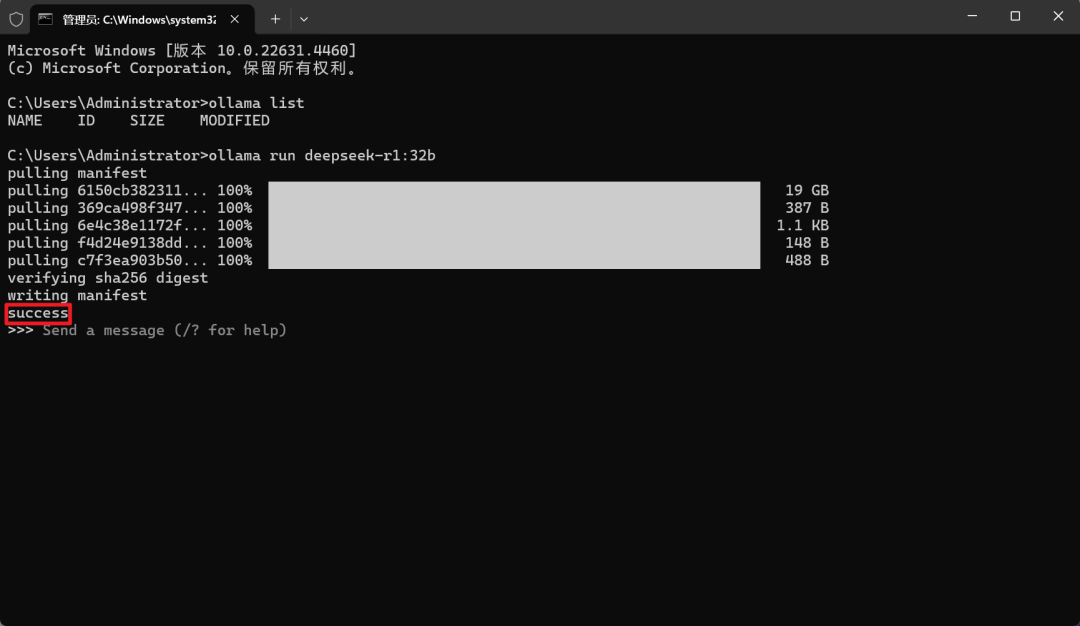

当出现“success”时,就代表下载安装成功了,就可以运行了。

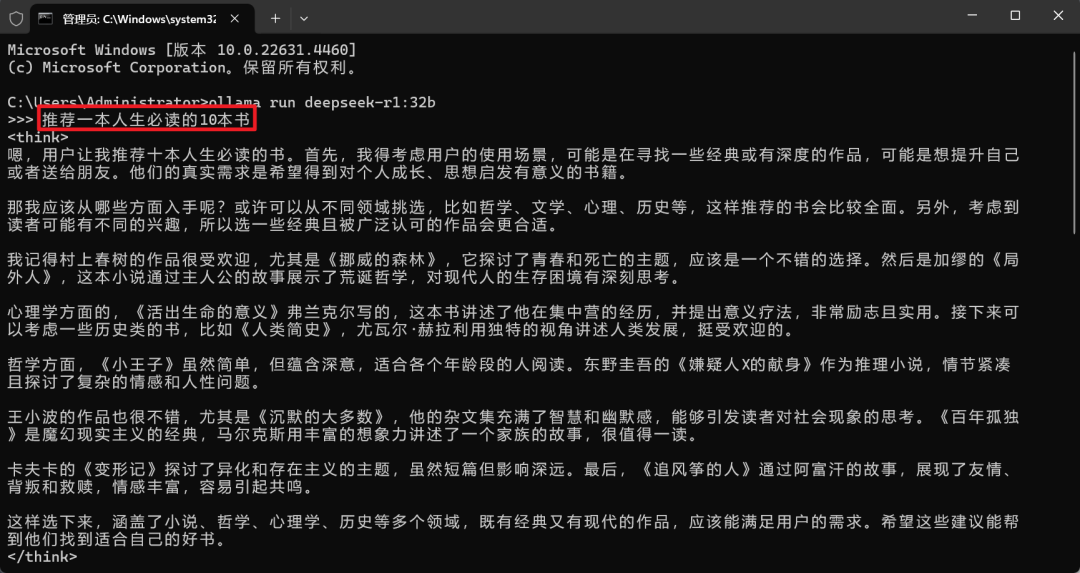

这时候你如果不要UI运行,则用命令窗口直接输入你想要的问题,DeepSeek就开始深度搜索,然后给出你想要的答案。

除了要调用cmd,输入你的模型的命令,操作有一丢丢麻烦。而且界面不好看,使用方面一点也不受影响!

如果不用界面,到这里大家部署完成,可以愉快的使用,下面的步骤都可以不用去安装了。

而如果想要界面,就得往下安装了。

第三步:安装ChatBox

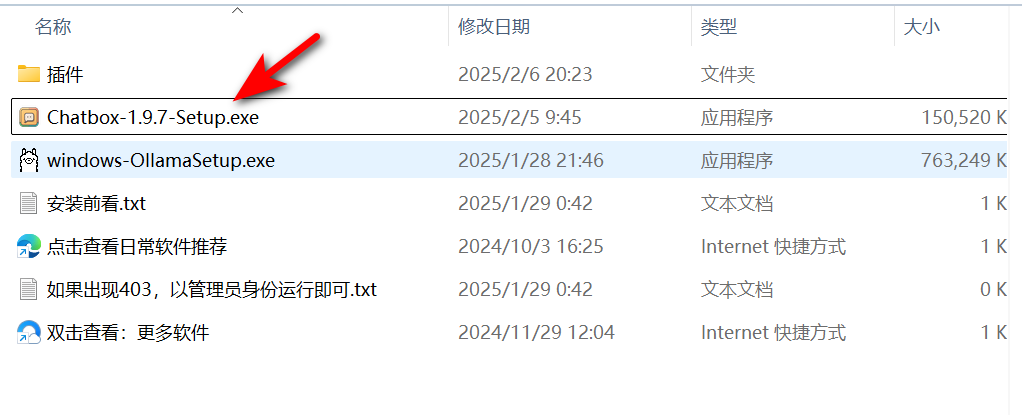

文末获取的软件中有Windows 64位的客户端,大家默认安装即可。

如果想要Mac端、Linux端,大家可以去官网:_https://www.chatboxai.app/zh#download_下载。

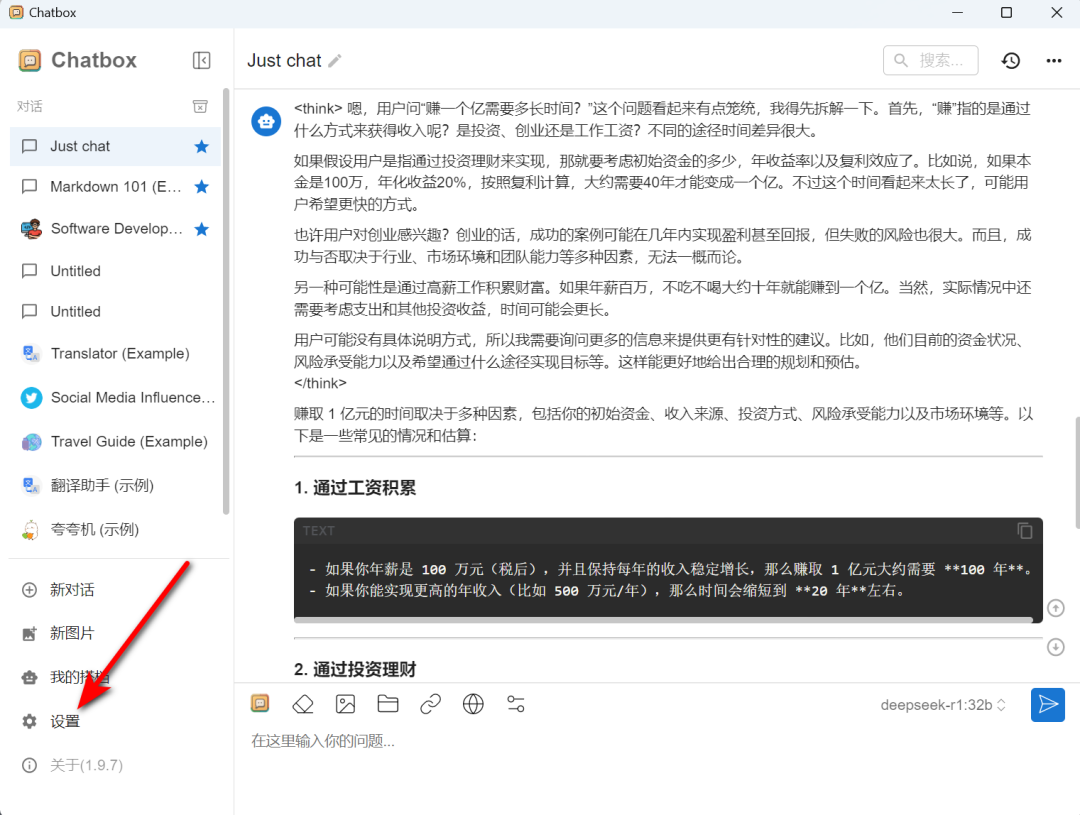

安装完成后,点击左边的【设置】

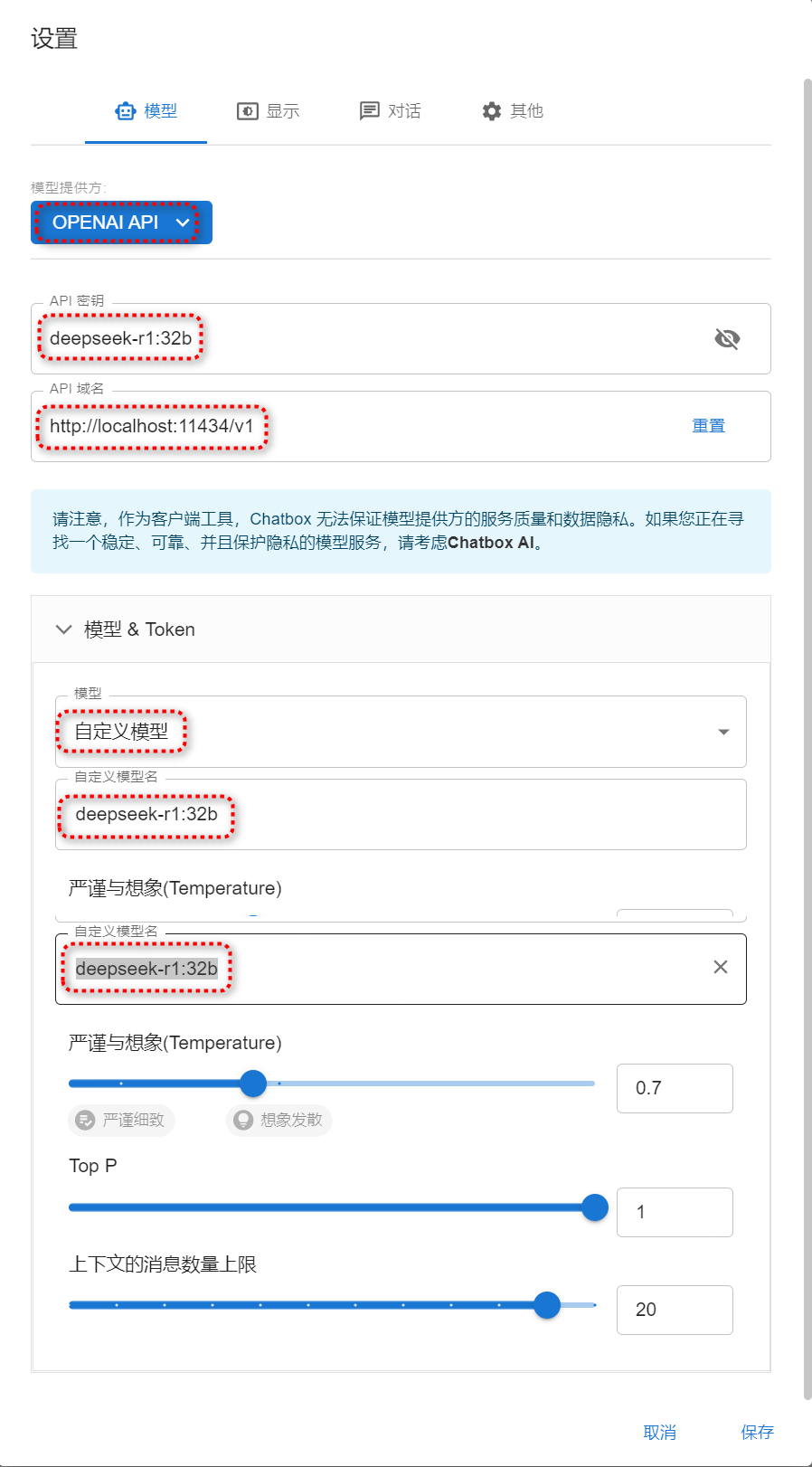

然后选择“OPENAI API”,依次填写API密钥、API域名、选择模型等等,注意我这里的是“32B”,填写的是“ollama run deepseek-r1:32b”,你们选择“7B”的要填写“ollama run deepseek-r1:7b”

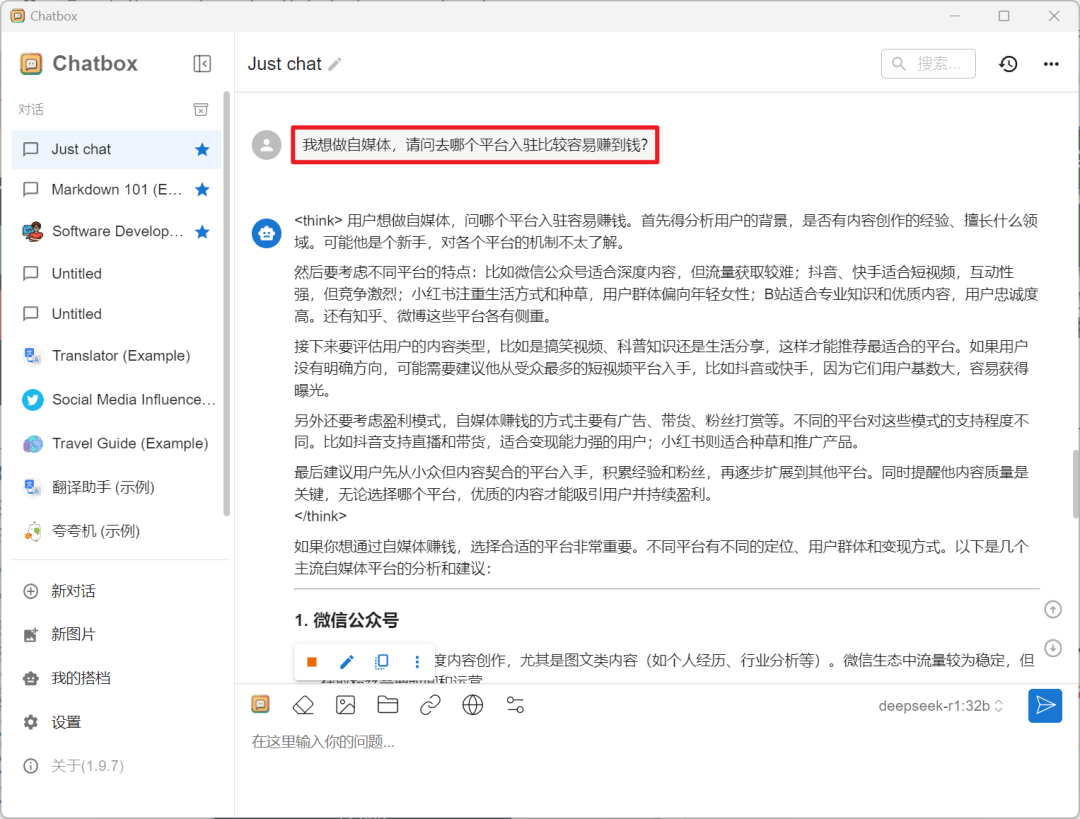

填写好后点【保存】,然后软件就可以调用DeepSeek进行对话了,输入你的问题,软件即给出你想要的答案。

说真的,有点吃配置,但是不会出现服务器繁忙的情况。

如果不要插件,那到第三步也就可以了,第四步不用安装了。

第四步:安装浏览器插件

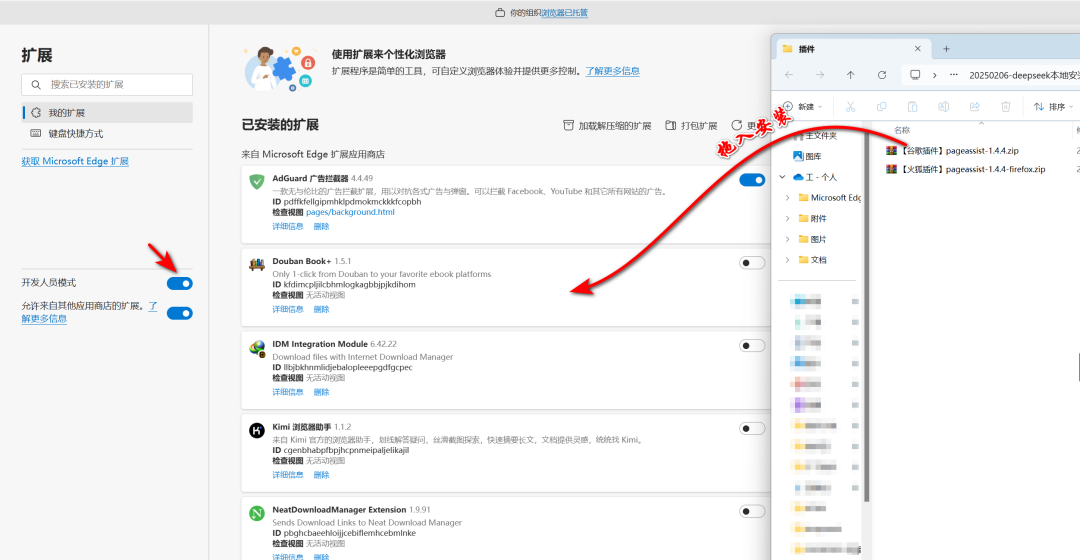

如果你不想安装第三步的ChatBox客户端,大家可以用浏览器插件,插件的安装是在扩展中心,打开【开发人员模式】,然后把压缩包直接拖入到扩展中心。

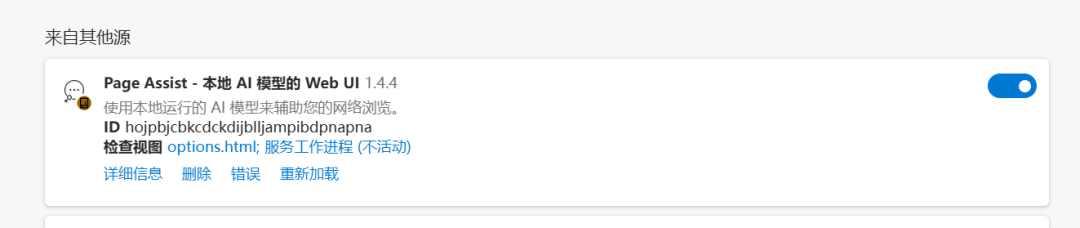

在插件中出现下面这个“Page Assist-本地AI模型的Web UI”时,代表插件安装成功。

我们在浏览器中点击插件图标,然后选择模型,输入问题,DeepSeek就开始给出你想要的答案。

通过插件的形式也挺好用的,可以不用安装第三步的ChatBox,还能有界面可使用。

聊一聊

写这个教程耗费了我好多时间,今天就不在这里聊了,拜里个拜拜拜~

👉👉【DeepSeek本地部署文档】

https://pan.quark.cn/s/7e0fa45596e4

最近,我的DeepSeek本地部署文章在CSDN阅读量意外小爆,评论区被两类留言淹没:一类是技术爱好者追问“如何用消费级显卡跑通大模型”,另一类是职场人焦虑“我的工作会被AI取代吗?”这两个问题的背后,折射出一个残酷的真相:大模型技术正在重构所有行业的生存法则,而掌握这项技术的人将获得通往未来的船票。

DeepSeek的火爆对普通人意味着什么?

DeepSeek的火爆并非偶然。它代表了一种技术趋势:大模型技术正在从实验室走向大众。过去,大模型技术似乎只属于科技巨头和学术机构,普通人很难接触到。而现在,随着开源社区的活跃和技术的普及,像DeepSeek这样的工具已经可以让普通用户在自己的设备上部署和使用大模型。

对于普通人来说,DeepSeek的火爆意味着:

-

技术门槛降低:大模型技术不再遥不可及。通过本地部署,普通人也可以体验到强大的AI能力,无论是文本生成、对话系统还是其他AI应用。

-

个性化需求得到满足:大模型可以根据用户的需求进行定制化调整,满足个性化的应用场景。比如,你可以训练一个专门用于写作、编程或翻译的模型。

-

未来职业机会:大模型技术的普及将催生大量新的职业机会。无论是AI工程师、数据科学家,还是AI产品经理,掌握大模型技术将成为未来职场的重要竞争力。

👉👉获取方式:

DeepSeek的底层逻辑:大模型技术的核心

DeepSeek的底层逻辑正是基于大模型技术。大模型,顾名思义,是指参数量巨大、训练数据丰富的深度学习模型。这类模型通过海量数据的训练,能够捕捉到复杂的语言模式和知识结构,从而在各种任务中表现出色。

一、大模型岗位薪资揭密:应届生年薪40万起,跨界人才溢价300%

根据智联招聘《2024人工智能人才发展报告》,大模型相关岗位薪资较传统IT岗位平均高出67%,且呈现三大特征:

1.应届生起薪碾压传统行业

大模型算法工程师:本科28-40万/年,硕士40-60万/年

AI产品经理(无经验):25-35万/年

(数据来源:猎聘2024校招季统计)

2.跨界人才溢价惊人

医疗+大模型复合人才:薪资较纯医疗背景提升200-300%

金融风控+大模型工程师:年薪可达80-150万

(案例:某三甲医院影像科医生转型AI医疗,薪资从25万跃升至75万)

3.中小企业重金抢人

二线城市AI初创公司开出“北上广深同薪”政策

某成都电商企业为AI推荐算法工程师开出百万年薪

二、行业大地震:这些岗位正在消失,这些岗位正在爆发

▍消失中的岗位(3年内高危职业)

- 基础数据标注员(已被AutoML取代90%工作量)

- 初级代码工程师(GPT-4可完成60%基础代码)

▍爆发中的黄金岗位

1.大模型训练师

- 某直播公司开出82万年薪招聘“带货大模型调教师”

- 核心技能:Prompt工程+垂直领域知识(如美妆/3C)

2.AI业务流程重构师

- 制造业龙头企业50万年薪招聘“生产流程AI化专家”

- 典型案例:富士康通过大模型优化生产线,减少30%人力成本

3.AI伦理合规官

- 金融机构新增岗位“大模型风控总监”,年薪超百万

- 职责:防止AI在信贷审核、投资建议中出现歧视性输出

三、普通人破局指南:无需代码基础,三步抢占AI红利

我整理了全网稀缺的《大模型落地应用实战资料包》包含:

1.LLM大模型学习大纲+路线图

2.152个大模型各行业结合的落地案例集

3.大模型必读书籍PDF电子版

4.大模型全套系统学习视频

5.真实大厂岗位面试题库

6.640套AI大模型行业白皮书

👉👉获取方式:

结语:你正在经历人类史上最大规模的生产力革命

当东莞工厂用大模型替代500个质检员,当律所AI助理处理80%合同审查,当小红书博主用AI生成90%的图文内容——这场变革不再关乎“是否会发生”,而是“你站在哪一边”。

记住两个数字:

- 2023年全球大模型应用市场规模:270亿美元

- 2027年预测市场规模:4070亿美元

这中间3700亿美元的增量市场,就是普通人改写命运的机会。4年后你会感谢今天的决定。

更多推荐

已为社区贡献104条内容

已为社区贡献104条内容

所有评论(0)