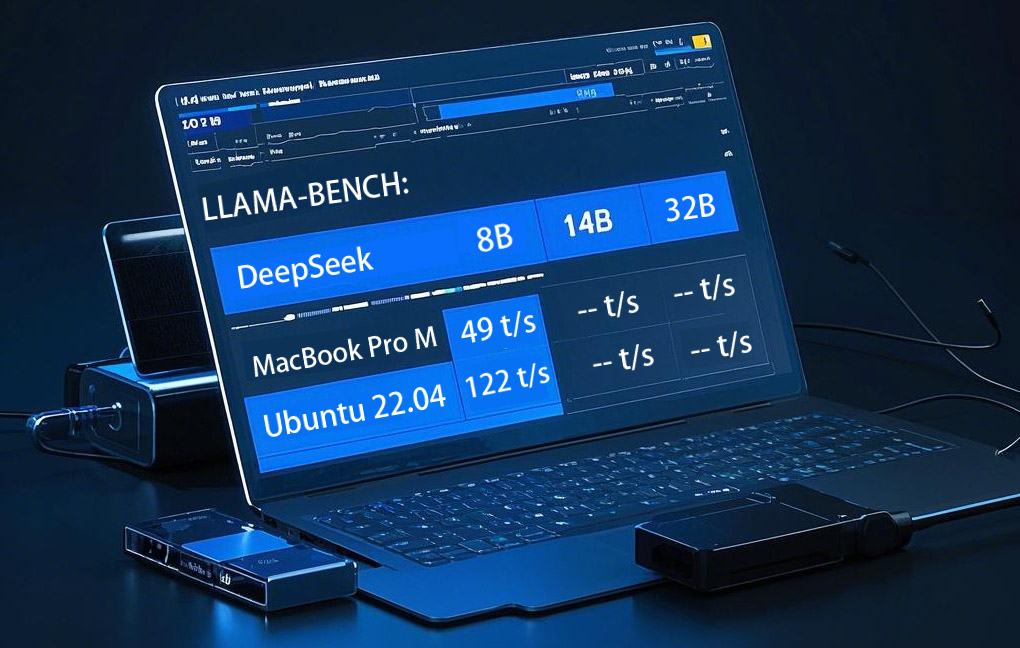

DeepSeek 8B,14B,32B,70B在ubuntu,mac上的性能测试结果

DeepSeek 8B,14B,32B,70B分别在ubuntu,mac上的性能测试结果

分别基于Ubuntu22.04, Macbook Pro M芯片模型测试:

| ubuntu配置: | Macbook Pro |

|---|---|

|

CPU: 13th Gen Intel(R) Core(TM) i7-13700KF 显卡: NVIDIA GeForce RTX 4070 Ti 12GB 内存:80G 系统版本:Window11 WSL Ubuntu 22.04.5 LTS |

CPU: Apple M1 Max 显卡:Apple M1 Max Metal 3 内存:32G 系统版本:14.6.1 |

Macbook Pro M芯片性能测试:

DeepSeek-R1-Distill-Qwen-8B-GGUF 测试结果:

| model | size | params | backend | threads | test | t/s |

|---|---|---|---|---|---|---|

| llama 8B Q2_K - Medium | 3.07 GiB | 8.03 B | Metal,BLAS | 8 | pp512 | 487.43 ± 0.24 |

| llama 8B Q2_K - Medium | 3.07 GiB | 8.03 B | Metal,BLAS | 8 | tg128 | 49.33 ± 0.09 |

DeepSeek-R1-Distill-Qwen-14B-GGUF 测试结果:

| model | size | params | backend | threads | test | t/s |

|---|---|---|---|---|---|---|

| qwen2 14B Q2_K - Medium | 5.37 GiB | 14.77 B | Metal,BLAS | 8 | pp512 | 257.18 ± 0.12 |

| qwen2 14B Q2_K - Medium | 5.37 GiB | 14.77 B | Metal,BLAS | 8 | tg128 | 27.45 ± 0.10 |

DeepSeek-R1-Distill-Qwen-32B-GGUF 测试结果:

| model | size | params | backend | threads | test | t/s |

|---|---|---|---|---|---|---|

| qwen2 32B IQ2_XXS - 2.0625 bpw | 8.40 GiB | 32.76 B | Metal,BLAS | 8 | pp512 | 99.51 ± 0.15 |

| qwen2 32B IQ2_XXS - 2.0625 bpw | 8.40 GiB | 32.76 B | Metal,BLAS | 8 | tg128 | 13.58 ± 0.01 |

DeepSeek-R1-Distill-Qwen-70B-GGUF 测试结果:

| Model | Size | Params | Backend | Threads | Test | t/s |

|---|---|---|---|---|---|---|

| LLaMA 70B Q2_K - Medium | 24.79 GiB | 70.55 B | Metal,BLAS | 8 | pp512 | 6.3 ± 0.08 |

| LLaMA 70B Q2_K - Medium | 24.79 GiB | 70.55 B | Metal,BLAS | 8 | tg128 | 00.00 ± 0.00 |

Ubuntu 22.04 性能测试:

DeepSeek-R1-Distill-Qwen-8B-GGUF 测试结果:

| Model | Size | Params | Backend | NGL | Test | T/s |

|---|---|---|---|---|---|---|

| llama 8B Q2_K - Medium | 3.07 GiB | 8.03 B | CUDA | 99 | pp512 | 4371.47 ± 8.21 |

| llama 8B Q2_K - Medium | 3.07 GiB | 8.03 B | CUDA | 99 | tg128 | 122.44 ± 0.09 |

DeepSeek-R1-Distill-Qwen-14B-GGUF 测试结果:

| Model | Size | Params | Backend | NGL | Test | T/s |

|---|---|---|---|---|---|---|

| qwen2 14B Q2_K - Medium | 5.37 GiB | 14.77 B | CUDA | 99 | pp512 | 2411.33 ± 6.56 |

| qwen2 14B Q2_K - Medium | 5.37 GiB | 14.77 B | CUDA | 99 | tg128 | 67.53 ± 0.15 |

DeepSeek-R1-Distill-Qwen-32B-GGUF 测试结果:

| Model | Size | Params | Backend | NGL | Test | T/s |

|---|---|---|---|---|---|---|

| qwen2 32B IQ2_XXS - 2.0625 bpw | 8.40 GiB | 32.76 B | CUDA | 99 | pp512 | 1204.93 ± 83.32 |

| qwen2 32B IQ2_XXS - 2.0625 bpw | 8.40 GiB | 32.76 B | CUDA | 99 | tg128 | 41.92 ± 0.17 |

DeepSeek-R1-Distill-Qwen-70B-GGUF 测试结果:

| Model | Size | Params | Backend | NGL | Test | T/s |

|---|---|---|---|---|---|---|

| llama 70B Q2_K - Medium | 24.79 GiB | 70.55 B | CUDA | 99 | pp512 | 37.18 ± 0.16 |

| llama 70B Q2_K - Medium | 24.79 GiB | 70.55 B | CUDA | 99 | tg128 | 1.31 ± 0.00 |

参数解释:

| 标题 | 解释 |

|---|---|

| 模型 (Model) | 使用的模型名称和版本 |

| 大小 (Size) | 模型的内存占用,单位是GiB (Gibibytes) |

| 参数 (Params) | 模型的参数数量,单位是B (Billion) |

| 后端 (Backend) | 模型运行所使用的计算后端 (例如Metal, BLAS) |

| 线程 (Threads) | 使用的线程数量 |

| GPU数量(NGL) | Number of GPU Layer,分给GPU的层数用来计算 |

| 测试 (Test) |

运行测试的类型,例如pp512 (测试512 token)或tg128 (测试128 token) pp512: Prompt Processing 处理512 token提示词 tg128: Text Generation 生成长度为128 token文本 |

| 每秒处理标记数 (t/s) | 每秒处理的token数量 (tokens per second) |

测试结果:

在两台机器上,DeepSeek-R1-Distill-Qwen-8B,14B, 32B 都可以正常使用,通过 T/s 结果可以看出来,只有70B 在两台机器上虽然可以运行,但根本无法使用。大家根据自己的机器配置,选择合适的模型。

模型资源下载地址:

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)