让VSCODE与Deepseek本地部署碰撞出高效火花

以开发上述 Flask 应用为例,原本需要花费 2 - 3 小时完成的基础框架搭建和路由功能实现,现在借助 Deepseek 的代码生成功能,只需要短短几分钟,就能生成一个可用的代码框架,开发者只需在此基础上进行少量的修改和完善,就能满足项目需求。在数据分析脚本编写方面,原本手动编写可能需要 1 - 2 小时的代码,现在通过 Deepseek 的辅助,半小时内即可完成,而且生成的代码结构清晰、逻辑

一、引言:解锁开发新利器

在当今 AI 技术迅猛发展的时代,人工智能辅助开发工具如雨后春笋般涌现,为开发者们打开了提高效率的新大门。其中,Deepseek 以其出色的性能和强大的功能,成为众多开发者关注的焦点。而将 Deepseek 进行本地部署,并与广受欢迎的代码编辑器 VSCODE 相结合,更是为开发者带来了前所未有的开发体验,让代码编写变得更加高效、智能。本文将详细介绍如何在 VSCODE 中实现 Deepseek 的本地部署,助力开发者开启高效开发之旅。

二、Deepseek:开源界的璀璨之星

(一)Deepseek 的魅力

Deepseek 是一款极具创新性的人工智能模型,以其卓越的性能和广泛的应用潜力,在开源领域熠熠生辉。它完全免费且开源,这一特性极大地降低了开发者的使用门槛,使得更多人能够参与到人工智能的开发与应用中。无论是个人开发者探索创意项目,还是企业寻求创新解决方案,都能从 Deepseek 的开源生态中受益。

在性能方面,Deepseek 表现卓越,在多种自然语言处理任务中展现出强大的能力。无论是文本生成、语义理解还是代码智能补全,它都能提供高质量的输出。以代码编写为例,Deepseek 能够理解上下文,快速生成准确且符合规范的代码片段,大大提高了开发效率。

Deepseek 提供了多种版本,以适配不同硬件配置的需求。从低配置的设备到高端服务器,都能找到适合的 Deepseek 版本。这使得开发者在不同的硬件环境下,都能享受到人工智能带来的便利。对于硬件资源有限的开发者,小版本的 Deepseek 也能提供不错的基础功能;而对于拥有强大计算资源的团队,则可以利用大版本的 Deepseek 挖掘其更强大的性能。

此外,Deepseek 的集成也非常便捷。它可以与多种主流的开发工具和平台无缝对接,其中与 VSCODE 的结合更是为开发者带来了极大的便利。通过简单的配置,开发者就能在熟悉的 VSCODE 环境中使用 Deepseek 的强大功能,无需在多个工具之间切换,提高了工作的连贯性和效率。同时,本地运行的特性使得数据安全性更高,也减少了对网络的依赖,降低了使用成本。

(二)模型选型攻略

在选择 Deepseek 模型时,需要根据自己的电脑配置来进行合理的决策。不同参数规模的模型对硬件的要求不同,适配的场景也有所差异。

- 1.5B 参数模型:适合电脑配置较低的用户,如内存为 8GB 及以下,显卡性能较弱甚至没有独立显卡的设备。这种模型虽然参数规模较小,但在一些简单的文本处理任务,如基础的代码注释生成、简单的文本摘要等方面,仍能发挥一定的作用。它对硬件资源的占用较少,能够在低配置设备上相对流畅地运行。

- 7B 参数模型:适用于中等配置的电脑,内存通常在 16GB 左右,显卡具备一定的计算能力,如 NVIDIA GTX 1660 及以上。这个模型在性能上有了显著提升,能够处理更复杂的任务,如一般的代码生成、多轮对话等。对于大多数普通开发者而言,如果没有特别高的性能要求,7B 参数模型是一个性价比很高的选择。

- 70B 参数模型:则需要高端配置的电脑才能发挥其最佳性能。通常需要 32GB 及以上的内存,以及高性能的显卡,如 NVIDIA RTX 3090、RTX 4090 等。这种模型适合处理大规模、高复杂度的任务,如大型项目的代码智能分析、复杂的自然语言推理等。但由于其对硬件要求较高,使用成本也相对较高,更适合专业的开发团队或对性能有极致追求的开发者。

三、本地部署全流程

(一)LM Studio 部署法

- 下载安装 LM Studio:访问 LM Studio 的官方网站(https://lmstudio.ai/ ),根据你的操作系统,如 Windows、MacOS 或 Linux,下载对应的安装包。下载完成后,双击安装包,按照安装向导的提示,一步一步完成安装。在安装过程中,你可以选择安装路径等选项。例如,Windows 系统下,默认安装路径可能为 C:\Users [用户名]\AppData\Local\Programs\lm - studio,若你想更改路径,可在安装过程中选择 “自定义安装” 进行设置。

- 下载 DeepSeek R1 模型:打开安装好的 LM Studio,在界面中找到 “Discover” 标签页。在搜索框中输入 “DeepSeek R1” 进行搜索。如果你使用的是配备 Apple 处理器的 MacBook,记得勾选 “MLX” 选项,这能让模型更好地适配你的硬件;若是 Windows 或 Linux 系统,则选择 “GGUF” 选项,然后根据你的电脑配置,选择合适的模型版本进行下载。比如,若你的电脑配置中等,可选择 7B 参数的模型版本。

- 加载模型:模型下载完成后,切换到 “Local Models” 标签页,在这里你可以找到刚刚下载的 DeepSeek R1 模型。点击模型右侧的 “Load” 按钮,开始加载模型。加载过程可能需要一些时间,具体时长取决于你的电脑性能和模型大小,耐心等待直至加载完成。

- 启动本地服务器:加载完成后,进入 “Developer” 标签页,点击 “Start Server” 按钮来启动本地服务器。当http://localhost:1234这个网址可以正常访问时,就说明你的模型已经成功运行起来了。此时,你可以在浏览器中输入该网址,进入模型的交互界面 。

(二)Ollama 部署法

- 安装 Ollama:从 Ollama 的官方网站(https://ollama.com/)下载适用于你操作系统的安装包。安装完成后,打开终端(Windows 系统可使用 PowerShell 或命令提示符),输入 “ollama --version” 命令。如果成功输出版本号,如 “ollama version is 0.5.6” ,则表明 Ollama 安装成功。

- 下载模型:在终端中执行 “ollama pull deepseek - r1” 命令,开始下载 DeepSeek R1 模型。Ollama 会从指定的源下载模型文件到本地。若你想下载更小版本的模型,可以到 Ollama 的模型库中查找对应的下载命令,比如针对一些量化版本的模型,会有特定的下载指令。

- 启动服务器:下载完成后,在终端运行 “ollama serve” 命令来启动服务器。当http://localhost:11434这个地址可以访问时,就意味着模型已经成功启动。你可以在浏览器中输入该地址,查看模型的运行状态,或者通过 Ollama 提供的命令行接口与模型进行交互 。

(三)Jan 部署法

- 下载安装 Jan:前往 Jan 的官方网站,根据你的操作系统,选择对应的版本进行下载。下载完成后,运行安装程序,按照提示完成安装过程。安装过程中,注意选择合适的安装路径和相关配置选项。

- 下载模型:由于 Jan 中无法直接搜索到 DeepSeek R1 模型,所以需要前往 Hugging Face 官网(https://huggingface.co/ )进行下载。在 Hugging Face 官网的搜索框中输入 “unsloth gguf deepseek r1” 进行搜索,找到对应的模型后,点击 “使用此模型” 按钮,然后在弹出的选项中选择 “Jan”,模型就会自动在 Jan 中打开并开始下载。

- 加载模型:模型下载完成后,在 Jan 的界面中找到刚刚下载的模型,选中它,然后点击 “Load” 按钮来加载模型。加载过程中,Jan 会对模型进行初始化等操作。

- 启动服务器:Jan 通常会自动在http://localhost:1337启动服务器。你可以在浏览器中输入该地址,进入模型的交互界面,开始使用 DeepSeek R1 模型。如果启动过程中遇到问题,检查端口是否被占用,或者查看 Jan 的日志文件以获取更多详细信息 。

四、与 VSCODE 的深度融合

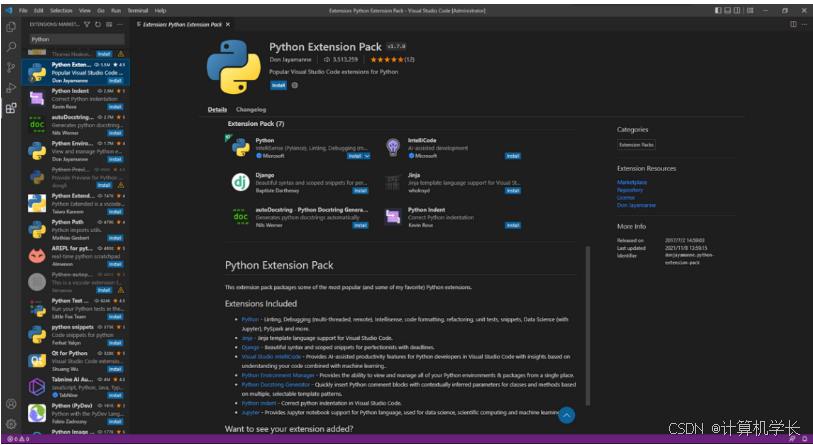

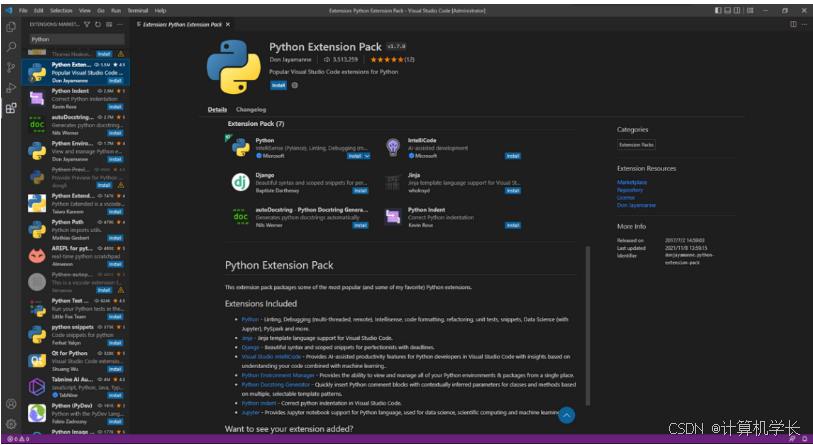

(一)安装扩展

当你完成了 Deepseek 的本地部署后,接下来就是将其与 VSCODE 进行集成,让它们协同工作,为你的开发带来更多便利。首先,打开 VS Code,点击左侧菜单栏中的 Extensions 标签页(或者使用快捷键 Ctrl+Shift+X ),在搜索框中输入 “Cline” 或 “Roo Code”,然后点击安装按钮,等待安装完成。这两个扩展都能帮助你在 VSCODE 中调用 Deepseek 模型,实现智能代码编写等功能 。比如,Cline 扩展可以在你编写代码时,根据你的输入和上下文,调用 Deepseek 模型提供代码补全和建议;Roo Code 则能以更直观的交互方式,让你与 Deepseek 模型进行对话,获取代码相关的帮助。

(二)配置扩展(LM Studio/Jan 适用)

安装完成后,点击扩展图标进入扩展的设置页面。在设置中,找到 “API Provider” 选项,将其选择为 “LM Studio” 。如果你使用的是 Jan 部署,同样选择 “LM Studio”,因为 Jan 也可以通过类似的接口与 VSCODE 扩展进行交互。然后,在 “Base URL” 栏中填写你在 LM Studio 或 Jan 中设置的 URL,一般来说,如果是默认设置,LM Studio 的 URL 为http://localhost:1234,Jan 的 URL 为http://localhost:1337。如果只有一个模型,“Model ID” 通常会自动填写正确;但如果有多个模型,你需要手动选择你下载好的 Deepseek 模型。完成这些设置后,点击 “Done” 保存设置 。这样,VSCODE 就能够通过扩展与 LM Studio 或 Jan 中的 Deepseek 模型建立连接,获取模型提供的服务。

(三)配置扩展(Ollama 适用)

针对使用 Ollama 部署 Deepseek 的情况,配置步骤稍有不同。同样点击扩展进入设置页面,在 “API Provider” 中选择 “Ollama” 。接着,在 “Base URL” 中填写 Ollama 设置的 URL,一般默认是http://localhost:11434。然后,根据你下载的模型数量,填写相应的 “Model ID”。如果只有一个模型,系统会自动识别;若有多个模型,你需要手动指定你想要使用的 Deepseek 模型的 ID。最后点击 “Done” 保存设置,完成 VSCODE 与 Ollama 中 Deepseek 模型的配置 。完成配置后,在 VSCODE 中进行代码编写时,就可以利用 Ollama 部署的 Deepseek 模型的智能功能,提高代码编写的效率和质量。

五、实战演练与效果展示

(一)代码生成示例

- 小型项目开发:假设我们要开发一个简单的 Flask Web 应用,用于展示用户信息。在集成了 Deepseek 的 VSCODE 中,我们打开一个新的 Python 文件,只需在注释中描述需求,如 “创建一个 Flask 应用,包含一个路由‘/user/[id]’,用于获取并展示对应 id 的用户信息,用户信息存储在一个字典中”。然后,通过 Cline 或 Roo Code 扩展调用 Deepseek 模型,模型就能根据这个描述,快速生成如下代码框架:

| from flask import Flask, jsonify app = Flask(__name__) # 模拟用户数据 users = { 1: {'name': 'Alice', 'age': 25}, 2: {'name': 'Bob', 'age': 30} } @app.route('/user/<int:id>') def get_user(id): if id in users: return jsonify(users[id]) else: return jsonify({'message': 'User not found'}), 404 if __name__ == '__main__': app.run(debug=True) |

这段代码定义了一个基本的 Flask 应用,包含一个获取用户信息的路由。通过这样的方式,开发者可以快速搭建项目的基础结构,大大节省了编写重复代码的时间。

- 数据分析脚本编写:在数据分析领域,我们经常需要处理大量的数据。比如,我们要对一个包含销售数据的 CSV 文件进行分析,计算每个月的总销售额,并绘制柱状图进行可视化展示。在 VSCODE 中,我们可以向 Deepseek 模型描述 “读取一个名为 sales.csv 的 CSV 文件,其中包含日期(格式为 YYYY - MM - DD)和销售额两列数据,计算每个月的总销售额,并使用 matplotlib 绘制柱状图展示”。Deepseek 模型会生成如下 Python 代码:

| import pandas as pd import matplotlib.pyplot as plt # 读取CSV文件 data = pd.read_csv('sales.csv') # 将日期列转换为datetime类型 data['date'] = pd.to_datetime(data['date']) # 提取月份并计算每个月的总销售额 data['month'] = data['date'].dt.to_period('M') monthly_sales = data.groupby('month')['sales_amount'].sum() # 绘制柱状图 plt.bar(monthly_sales.index.astype(str), monthly_sales.values) plt.xlabel('Month') plt.ylabel('Total Sales') plt.title('Monthly Sales') plt.xticks(rotation=45) plt.show() |

这段代码使用 pandas 库读取和处理数据,使用 matplotlib 库进行数据可视化。通过 Deepseek 的代码生成功能,我们可以快速完成数据分析脚本的编写,提高工作效率。

(二)对比优势

在未使用集成环境之前,开发者需要手动编写每一行代码,对于复杂的功能和逻辑,需要花费大量时间去思考和实现。例如,在开发一个稍微复杂的 Web 应用时,从搭建项目框架、配置路由到实现业务逻辑,可能需要数小时甚至数天的时间,而且在编写过程中,还容易出现语法错误和逻辑漏洞,需要不断地调试和修改。

而使用集成了 Deepseek 的 VSCODE 后,开发效率得到了显著提升。以开发上述 Flask 应用为例,原本需要花费 2 - 3 小时完成的基础框架搭建和路由功能实现,现在借助 Deepseek 的代码生成功能,只需要短短几分钟,就能生成一个可用的代码框架,开发者只需在此基础上进行少量的修改和完善,就能满足项目需求。在数据分析脚本编写方面,原本手动编写可能需要 1 - 2 小时的代码,现在通过 Deepseek 的辅助,半小时内即可完成,而且生成的代码结构清晰、逻辑严谨,大大减少了出错的概率。同时,在开发过程中,Deepseek 还能根据上下文提供实时的代码补全和建议,进一步提高了开发的流畅性和效率 。

六、常见问题与解决方案

(一)部署过程问题

- 下载慢:在下载 LM Studio、Ollama、Jan 或 Deepseek 模型时,可能会遇到下载速度缓慢的情况。这可能是由于网络不稳定、服务器负载过高或下载源的问题。解决方案是检查网络连接,尝试更换网络环境,比如从 Wi-Fi 切换到有线网络;也可以选择在网络相对空闲的时间段进行下载,减少网络拥塞的影响;还可以使用下载管理器,如 Internet Download Manager(IDM)或 Free Download Manager(FDM),它们能够优化网络连接,提高下载速度并支持断点续传。此外,若因访问国外服务器导致下载慢,可寻找国内的镜像站点进行下载,如在下载 VSCode 相关资源时,将下载链接中的部分内容替换为国内镜像地址(如vscode.cdn.azure.cn ),可显著提升下载速度。

- 模型加载失败:模型加载失败可能是由于模型文件损坏、路径设置错误或硬件资源不足等原因。首先,检查模型文件是否完整,可重新下载模型文件进行验证;其次,确认模型加载路径是否正确,在 LM Studio、Ollama 或 Jan 的配置中,仔细核对模型路径;若硬件资源不足,如内存或显存不够,可关闭其他占用资源的程序,释放更多系统资源,或者考虑升级硬件配置。对于一些对显存要求较高的大模型,如 70B 参数的 Deepseek 模型,若显存不足,可尝试使用量化版本的模型,以减少内存占用 。

(二)集成问题

- 扩展安装失败:在 VSCODE 中安装 Cline 或 Roo Code 扩展时,如果安装失败,可能是网络问题导致无法从扩展市场下载扩展,也可能是扩展与 VSCODE 版本不兼容,或者存在扩展冲突。对于网络问题,检查网络连接是否正常,尝试重启网络设备或更换网络;若怀疑是版本兼容性问题,查看扩展的官方文档,确认其支持的 VSCODE 版本范围,若不兼容,可考虑升级 VSCODE 或寻找替代扩展;若是扩展冲突,禁用其他已安装的扩展,然后再次尝试安装目标扩展,找出冲突的扩展并进行相应处理 。

- 配置无法生效:在配置 VSCODE 扩展以连接本地部署的 Deepseek 模型时,配置无法生效可能是由于配置参数错误,如 API Provider 选择错误、Base URL 填写不正确或 Model ID 不匹配等。仔细检查配置参数,确保与本地部署的设置一致。若使用 LM Studio 或 Jan 部署,确认 API Provider 选择为 “LM Studio”,Base URL 填写为对应的本地服务器地址(如http://localhost:1234 或http://localhost:1337 );若使用 Ollama 部署,API Provider 选择 “Ollama”,Base URL 填写为http://localhost:11434 。同时,根据模型的实际情况,正确填写 Model ID 。如果问题仍然存在,尝试重启 VSCODE,使配置重新生效 。

七、总结与展望

通过本文详细的步骤和方法,我们成功地在 VSCODE 中实现了 Deepseek 的本地部署,让这一强大的人工智能模型与我们日常使用的代码编辑器完美结合。从 Deepseek 的介绍、模型选型,到通过 LM Studio、Ollama、Jan 等工具进行本地部署,再到与 VSCODE 的集成以及实战应用,我们一步步探索了这一技术组合的魅力和优势。

在实际开发中,集成了 Deepseek 的 VSCODE 展现出了惊人的效率提升。无论是快速生成代码框架,还是为复杂的编程任务提供智能建议,Deepseek 都能成为开发者得力的助手,帮助我们节省大量的时间和精力,让开发过程更加流畅和高效。同时,本地部署的方式也保障了数据的安全性和隐私性,让我们无需担心数据泄露的风险。

对于广大开发者来说,不妨尝试一下这种全新的开发方式。无论你是经验丰富的编程高手,还是刚刚踏上开发之路的新手,Deepseek 与 VSCODE 的组合都能为你带来不一样的体验。它将为你的开发工作注入新的活力,让你在代码的世界中更加游刃有余。

展望未来,随着人工智能技术的不断发展,我们有理由相信,类似 Deepseek 这样的模型会变得更加智能和强大。它们将与各种开发工具深度融合,为开发者提供更加智能、高效的开发环境。也许在不久的将来,开发工作将变得更加轻松和有趣,让我们一起期待那一天的到来吧!

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)