惊爆了,本地部署deepseek可能是在裸奔!!

还记得在上一期的教程中,如果需要远程访问ollama服务,需要将ollama的服务监听ip从127.0.0.1修改为0.0.0.0,这样ollama服务才能够绑定宿主机上的所有可用ip,但是这也导致宿主机的ollama服务的11434端口直接暴露到公网或局域网(如果你有公网ip)。通过输入域名或者你的公网ip能直接访问到本地部署的ollama服务,而ollama服务没有鉴权机制,可以使得攻击者进行

前几天给大家分享了deepseek本地部署,远程访问的方案。相信有很多小伙伴已经完成了部署。最近本地部署deepseek的单位也不在少数。但是大家可能都忽略了一个安全问题,且由我娓娓道来。

还记得在上一期的教程中,如果需要远程访问ollama服务,需要将ollama的服务监听ip从127.0.0.1修改为0.0.0.0,这样ollama服务才能够绑定宿主机上的所有可用ip,但是这也导致宿主机的ollama服务的11434端口直接暴露到公网或局域网(如果你有公网ip)。这样会存在什么问题和现象呢?

通过输入域名或者你的公网ip能直接访问到本地部署的ollama服务,而ollama服务没有鉴权机制,可以使得攻击者进行一系列的攻击操作。例如:

1.模型删除:通过ollama公开的接口删除模型。

2.模型窃取:通过接口查看ollama模型,甚至进一步下载你的私有模型。

3.算力窃取:通过接口查看模型后,便可以使用请求进行对话,使用你部署的模型。

4.模型投毒:删除正常的模型,下载有毒的模型,让你使用效果大大折扣。

除此之外,ollama在去年爆发过远程命令执行漏洞,可能存在被攻击者利用的漏洞,暂时需要将ollama升级到最新版本。

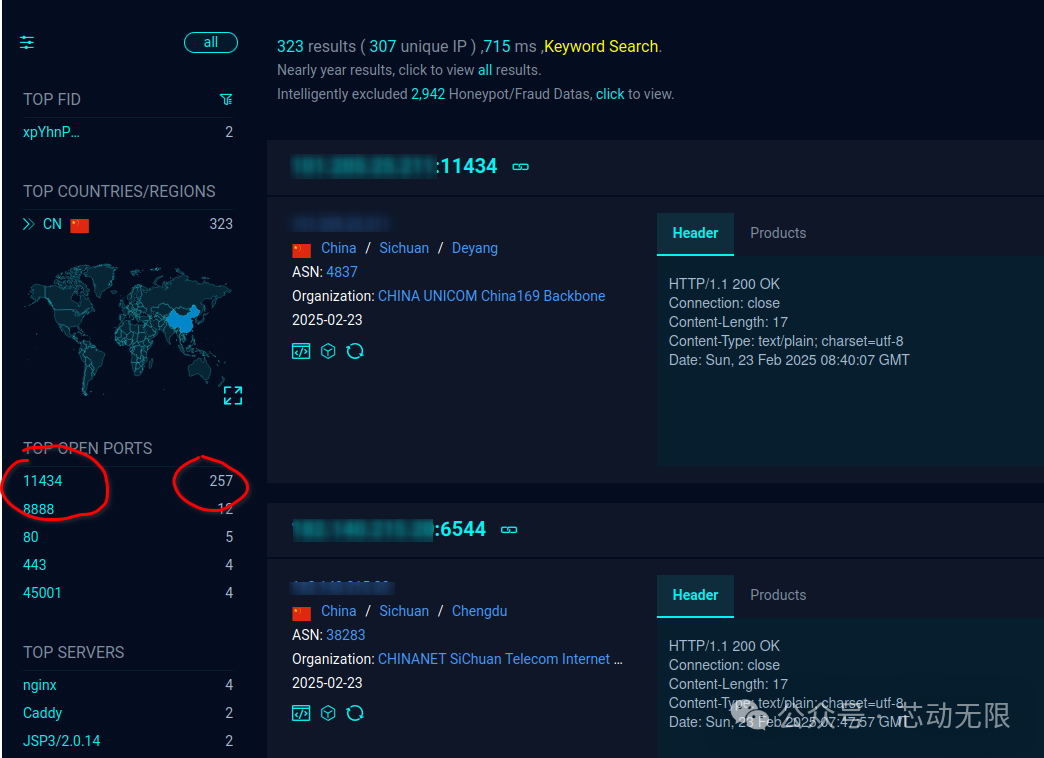

那你可能会问,如果我不告诉别人我的域名或者我的公网ip,攻击者是不是就找不到我了呢?那你可能把攻击者想得太简单了,攻击者可以定向扫描公网上开放的端口,从而利用开发端口进行攻击。

在网络空间地图上可以看到,仅sichuan就有几百个ollama服务的开放端口暴露到公网。你就说你自己本地部署的服务慌不慌,像不像是稚子怀金过市?

缓解方案:由于ollama暂未有鉴权方案,建议将ollama服务运行在本地,监听端口改为docker0的ip,并使用nginx进行反向代理,避免ollama服务被暴露到公网。

如果你只在局域网使用,无公网ip,那duck不必如此折腾。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)