Windows本地安装Ollama(修改默认路径C盘)

本篇文章介绍了如何安装和配置Ollama模型,并将其集成到本地AI智能体的开发中。首先,详细指导了如何下载Ollama并安装到本地磁盘。接着,介绍了如何修改模型存储路径和环境设置,以优化大模型的加载和运行。文章还展示了如何通过Docker容器部署Ollama,并通过Dify平台结合Ollama和DeepSeek模型,构建一个本地AI智能体。这一过程能够为用户提供简便、灵活的AI系统构建方案。

访问官方网站下载Ollama软件时,发现安装过程中未提供路径选择,系统默认将软件安装至C盘。安装完成后,软件本身占用约4.56GB的硬盘空间。在下载语言模型的过程中,所需存储空间逐渐增加,导致C盘迅速接近存储极限。尽管查阅了大量网络教程,但这些教程对于初学者而言过于简略,未能提供详尽指导,导致反复尝试后仍只能默认安装在C盘。

经过不懈努力,最终找到了方法,成功将Ollama和模型安装至E盘。接下来,将通过图解的方式详细说明哪些文件需要被移动至E盘指定文件夹。

一:下载Ollama

访问Ollama的官网:Download Ollama on macOS

将按照包下载到我指定的目录当中,该目录也是ollama后续安装和下载大模型的目录。提前创建好:E:\AppDownLoad\LLMs\ollama

下载完成之后如果直接点击安装包,会默认安装到C盘,这时候需要通过命令行的方式来进行安装。

下载完成之后如果直接点击安装包,会默认安装到C盘,这时候需要通过命令行的方式来进行安装。

二:安装Ollama到E盘

在E:\AppDownLoad\LLMs\ollama目录新建一个ollamaIntallPath文件夹来存放Ollama的安装位置;

## 打开CMD,进入到E:\AppDownLoad\LLMs\ollama目录

cd E:\AppDownLoad\LLMs\ollama

## 通过命令行来安装Ollama

.\OllamaSetup.exe /DIR=E:\AppDownLoad\LLMs\ollama\ollamaIntallPath

三:修改大模型存放路径

虽然Ollama安装成功在了E盘,但是默认的大模型存放路径还是在C盘,可以看到C:\Users\个人用户名\AppData\Local\Ollama 和 C:\Users\个人用户名\.ollama 目录多出来了Ollama的文件夹。

之后将 C:\Users\Administrator\AppData\Local\.ollama 文件夹移动到E盘E:\AppDownLoad\LLMs\ollama下

编辑环境变量修改修改大模型存储目录

添加系统环境变量

在环境变量中新建系统变量

将变量值填写为刚才从C盘移动到E盘的那个.ollama的目录!

变量名:OLLAMA_MODELS

变量值:E:\AppDownLoad\LLMs\ollama\.ollama (自定义大模型存放路径)

创建完成之后确定保存

环境变量修改完成之后重启电脑或者重启ollama生效!否则失败!!

四:下载大模型

重启之后来下载大模型确定是否生效;

## 在终端输入该命令查看模型,如果还没有模型则为空

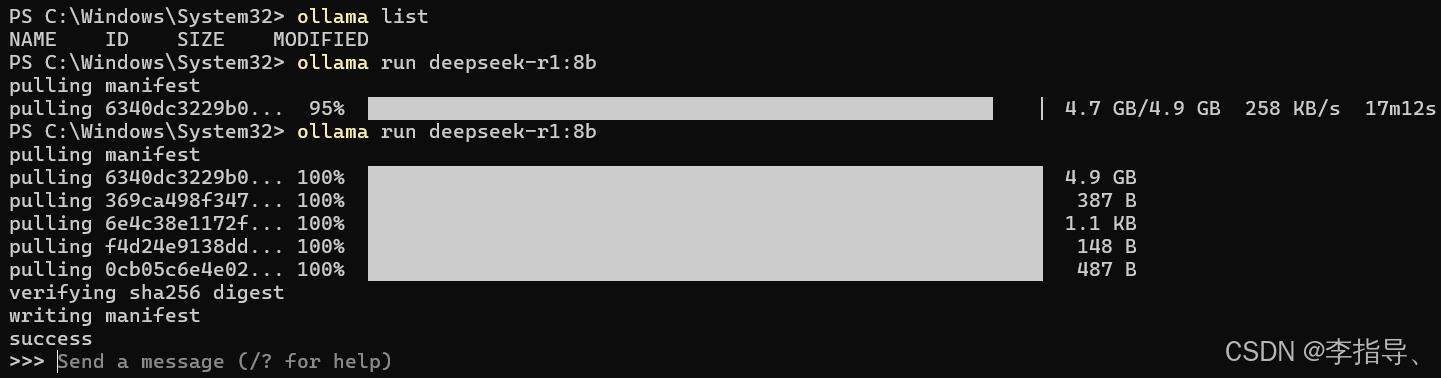

ollama list

## 在终端里输入下面模型代码回车,8b模型(4.9GB)开始下载,说明没问题的

ollama run deepseek-r1:8b

在安装模型阶段发现刚开始速度很快,到后面速度就会特别慢。这里有一个小技巧,就是当特别慢的时候直接Ctrl+C取消,因为取消后之前的下载记录保存在了缓存当中,所以不会有影响,这时候可以在重新输入上述命令来让下载速度提高。

在图中我在95%直接Ctrl+C取消后重新下载,速度提升很多。

可以看到将模型安装到了我们指定的位置

可以运行: ollama run deepseek-r1:8b 来运行模型

可以在官方链接中下载对应的模型:Ollama Search

学习阶段装1.5b、7b、8b都是OK的,版本选择的时候要根据自己电脑的资源配置来选择;

五:通过Docker部署ollama

如果本地有Docker的话可以直接用Docker来启动容器。

docker run -d `

>> --name ollama `

>> -p 11434:11434 `

>> -v "E:\AppDownLoad\LLMs\ollama\ollamaIntallPath:/opt/ollama" `

>> -v "E:\AppDownLoad\LLMs\ollama\.ollama:/root/.ollama" `

>> --restart always `

>> ollama/ollama:latest

六:根据Dify + Ollama + DeepSeek 构建本地 AI 智能体

AI智能体是基于大语言模型(LLM)构建的自主决策(自动化)系统,能通过感知环境、规划任务、调用工具完成复杂目标,例如自动化处理网页分析或跨系统操作。

而Dify是开源LLM应用开发平台,提供可视化工作流编排、RAG知识库集成、Agent代理框架等功能,支持快速搭建生产级AI应用并管理模型生命周期,让用户能够快速构建和部署智能应用。

结合Dify和Ollama,用户可以构建本地AI智能体,利用Ollama强大的语言模型和Dify的自动化能力,快速实现各种任务,如日常对话Web、自动客服、智能推荐、数据分析等,同时简化开发和部署过程,提高效率和灵活性,同时实现企业级的智能一体化操作。

后续 Dify + Ollama + DeepSeek 构建 AI 智能体操作请关注博主后续文章;持续更新

卸载Ollama教程:如何卸载ollama_ollama卸载-CSDN博客

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)