#Paper Reading# DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model

本文发布了DeepSeek-V2模型,使用了8.1T tokens去训练,属于236B的MoE模型,激活参数量是21B,特别经济高效。其主要创新点是MLA(Multi-head Latent Attention),相比DeepSeek 67B模型,节省了42.5%的训练花销,减少93.3%的KV cache。

论文题目: DeepSeek-V2: A Strong, Economical, and Efficient Mixture-of-Experts Language Model

论文地址: https://arxiv.org/pdf/2405.04434

论文发表于: arXiv 2024年5月

论文所属单位: DeepSeek

论文大体内容

本文发布了DeepSeek-V2模型,使用了8.1T tokens去训练,属于236B的MoE模型,激活参数量是21B,特别经济高效。其主要创新点是MLA(Multi-head Latent Attention),相比DeepSeek 67B模型,节省了42.5%的训练花销,减少93.3%的KV cache。

Motivation

一般而言,LLM的能力会随着参数量增大而提升,但正因如此,训练和推理的成本都比较大。因此本文提出新的方法降低训练成本,同时也能拿到很好的效果。

Contribution

①提出MLA(Multi-head Latent Attention),用于优化Transformer中的MHA,提升性能

②做了详细的实验验证,以及消融实验

③开源模型:https://github.com/deepseek-ai/DeepSeek-V2

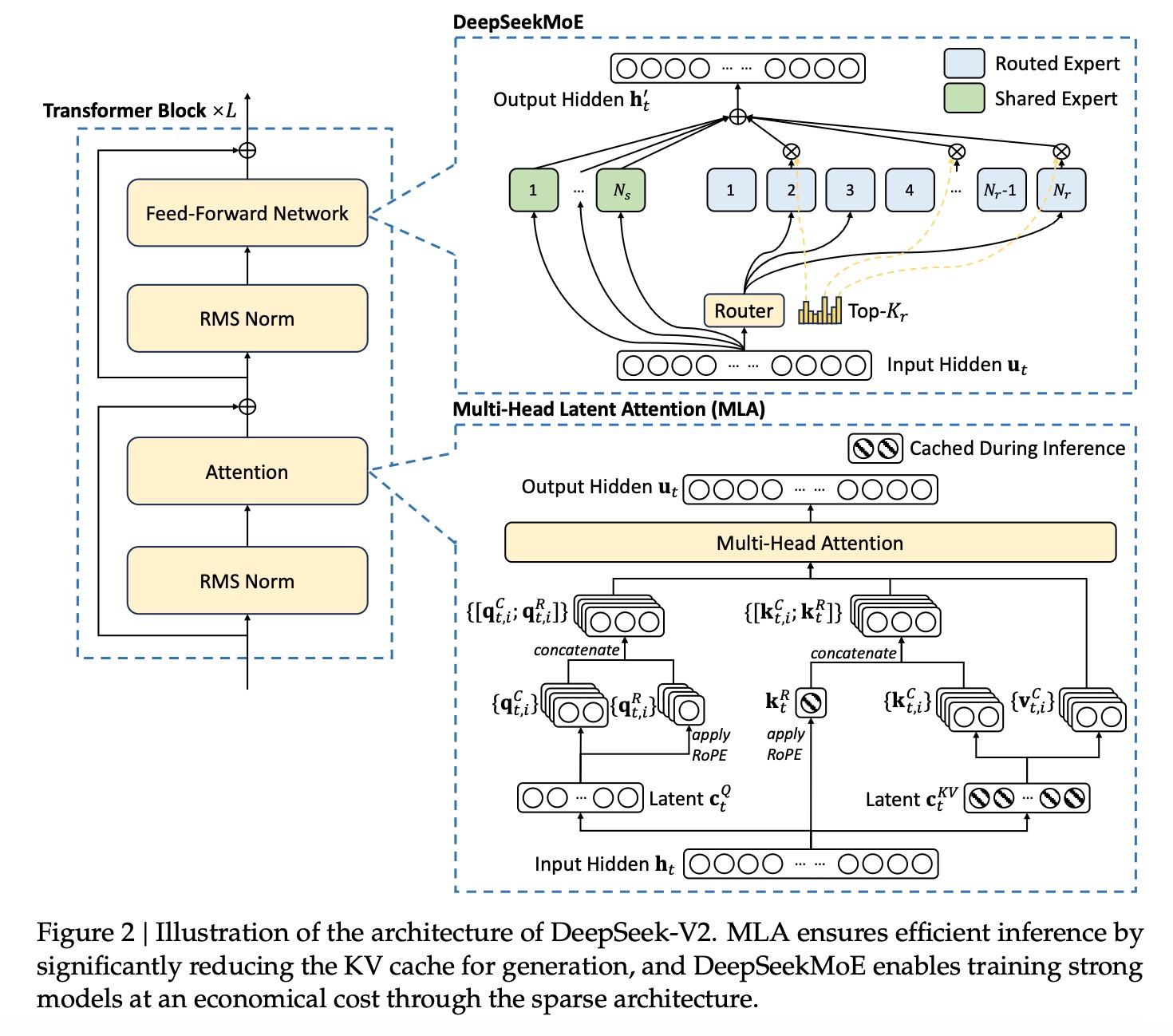

1. DeepSeek-V2整体的架构如图,整体是基于Transformer框架,主要的改进点包括:

①FFN改为了DeepSeek MoE

②MHA改为了MLA

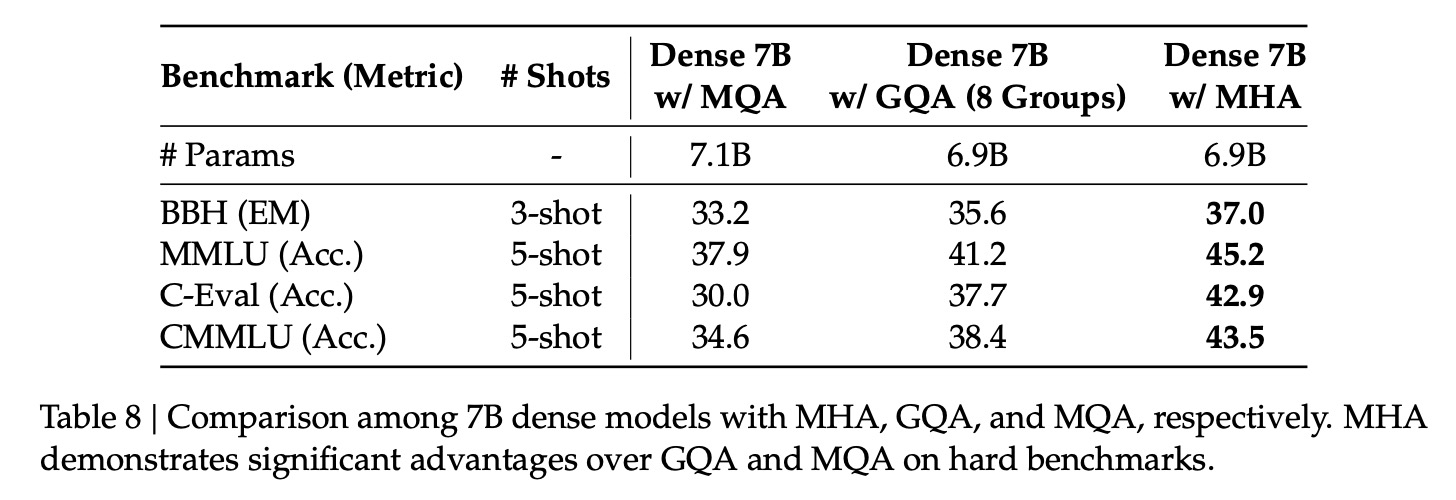

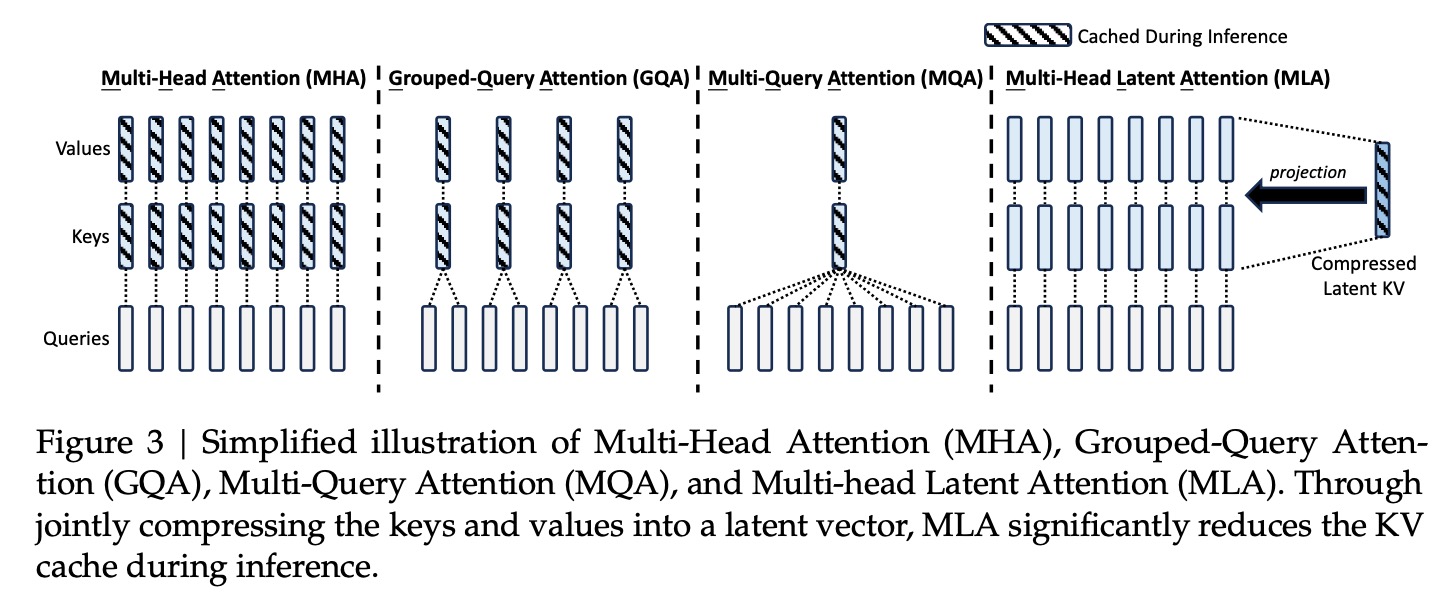

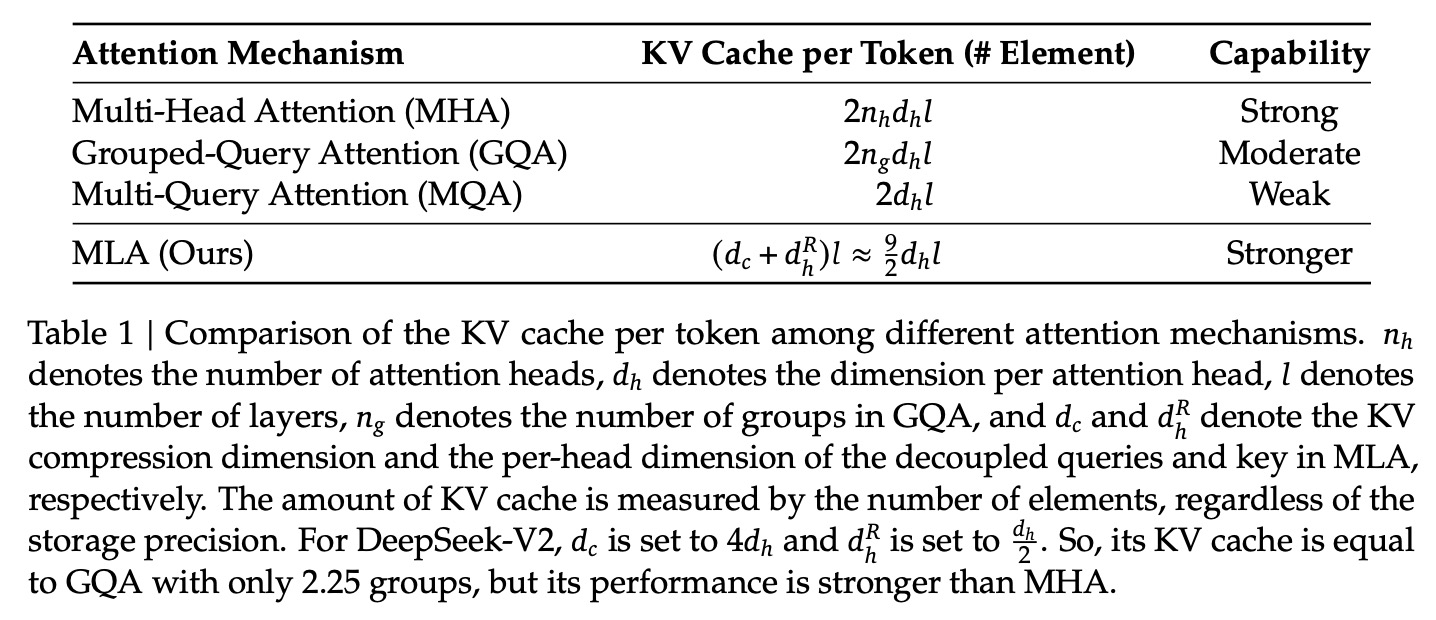

2. MHA的KV cache比较大,对其的优化有MQA(Multi-Query Attention)和GQA(Grouped-Query Attention),但是本文通过实验,发现这两者会降低模型的效果。

3. 本文提出用MLA优化MHA,通过压缩kv,去提升性能。

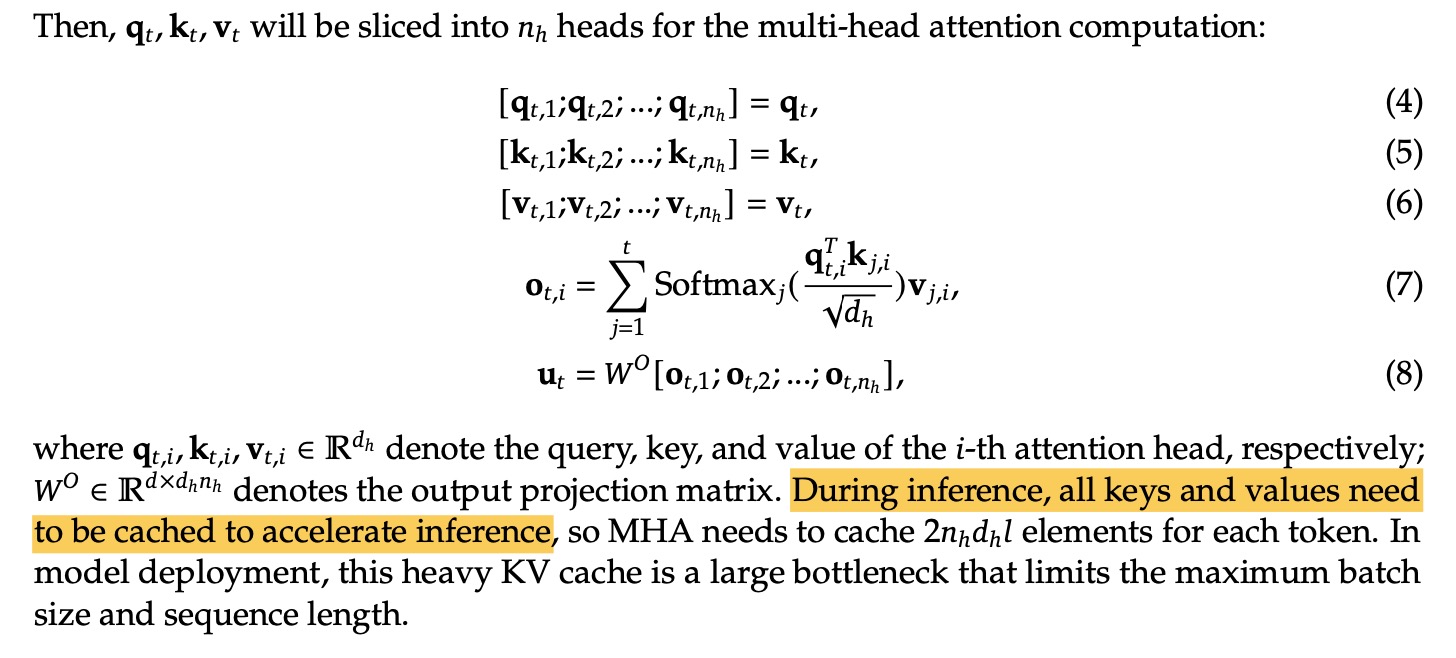

①MHA需要缓存kv用于推理,因此总共需要为每个token缓存「2*头的数量*每个头的维度*序列长度」的参数。

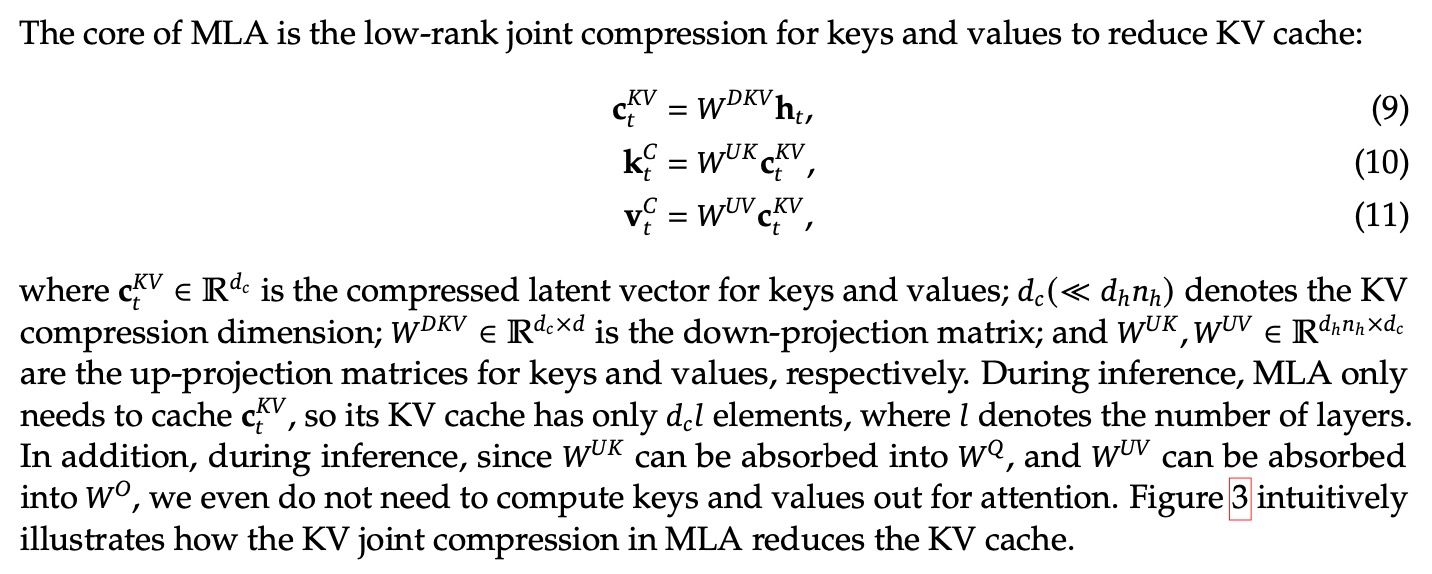

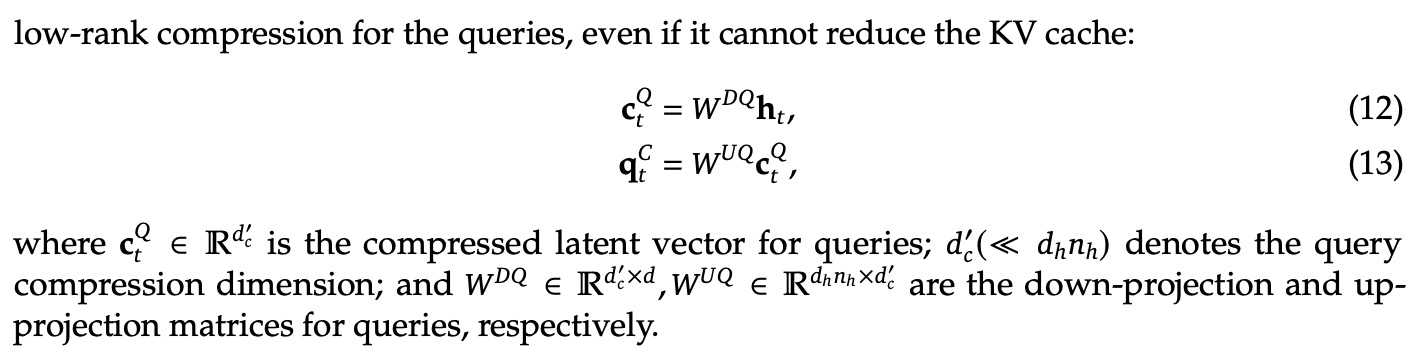

②Low-Rank方式压缩kv,通过高维投影到低维来压缩。

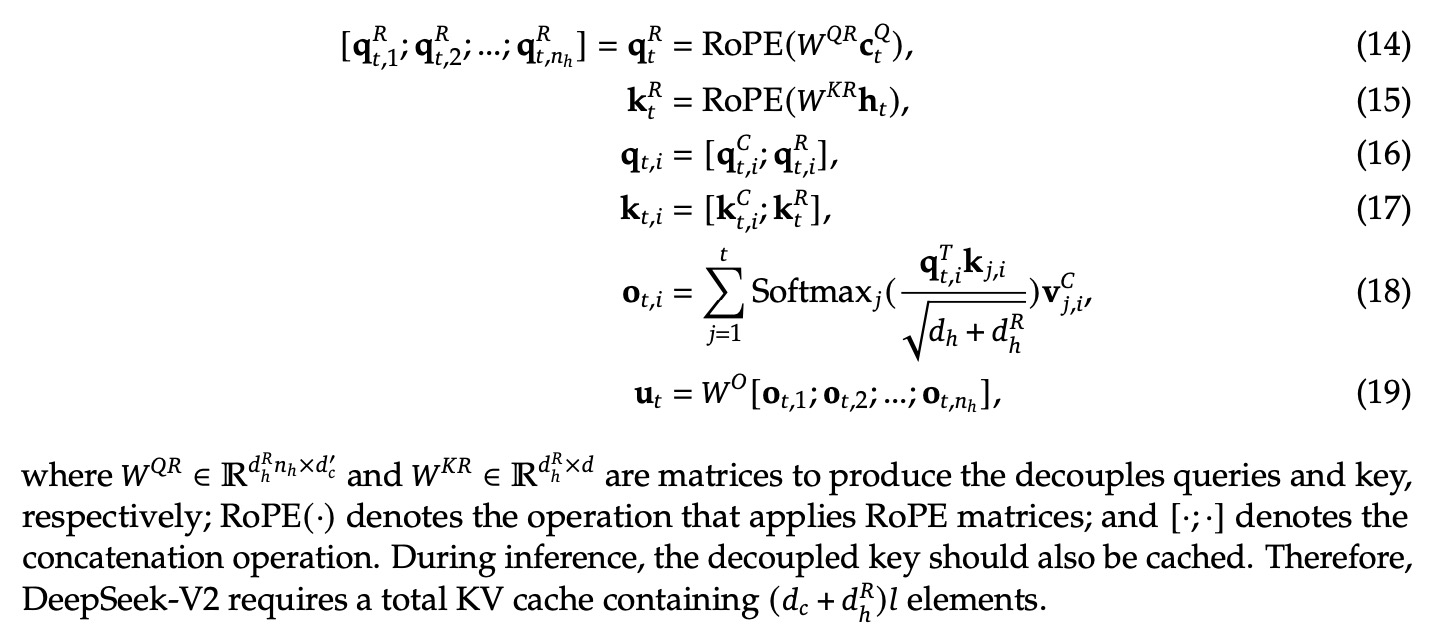

③加入RoPE(Rotary Position Embedding,旋转位置编码)。

④kv缓存的参数量对比如下。

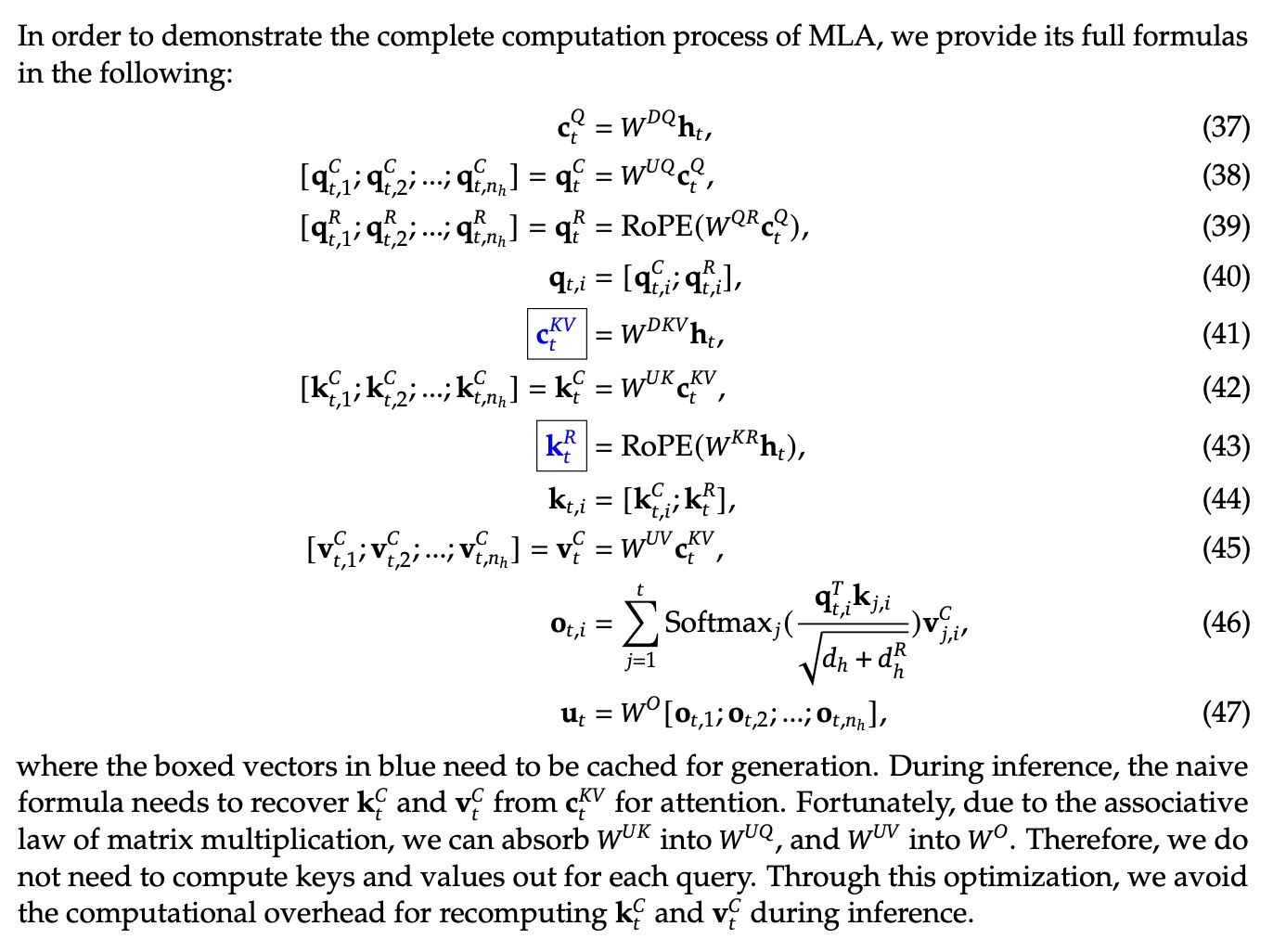

⑤MLA的完整公式如下。

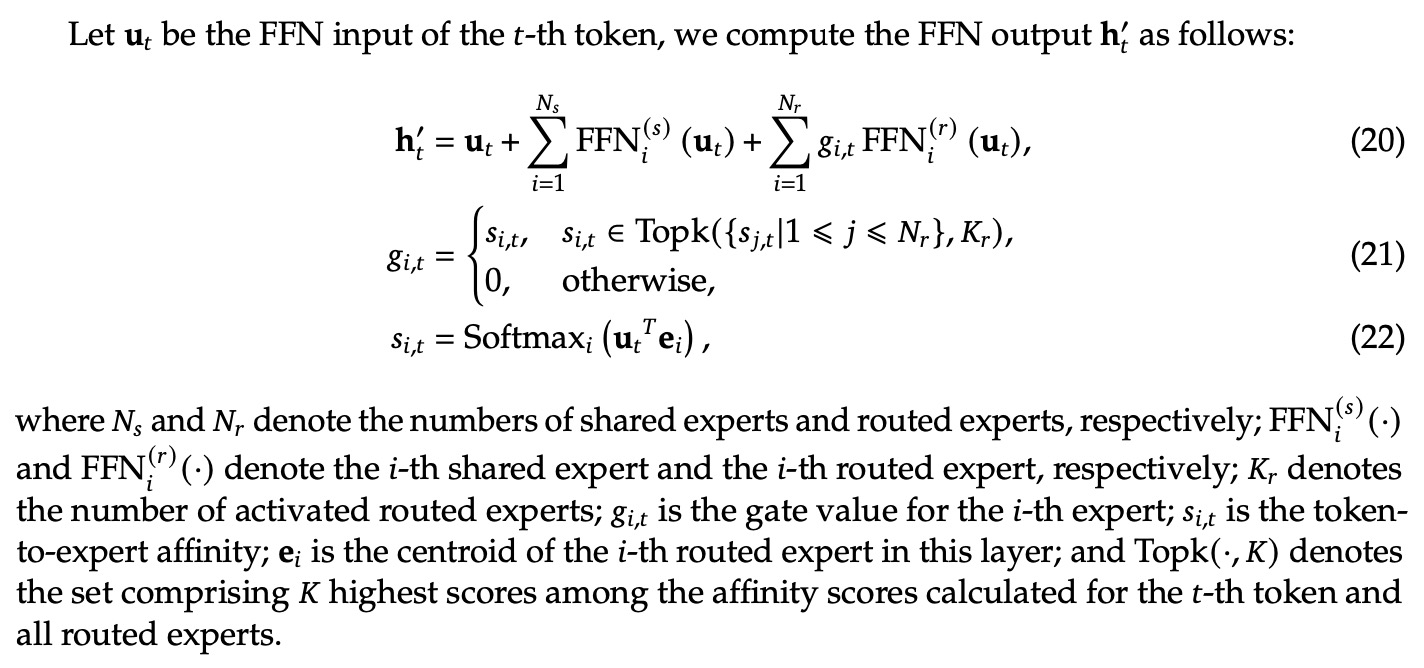

4. FFN改为DeepSeek MoE:

①DeepSeek MoE

②专家的平衡Loss

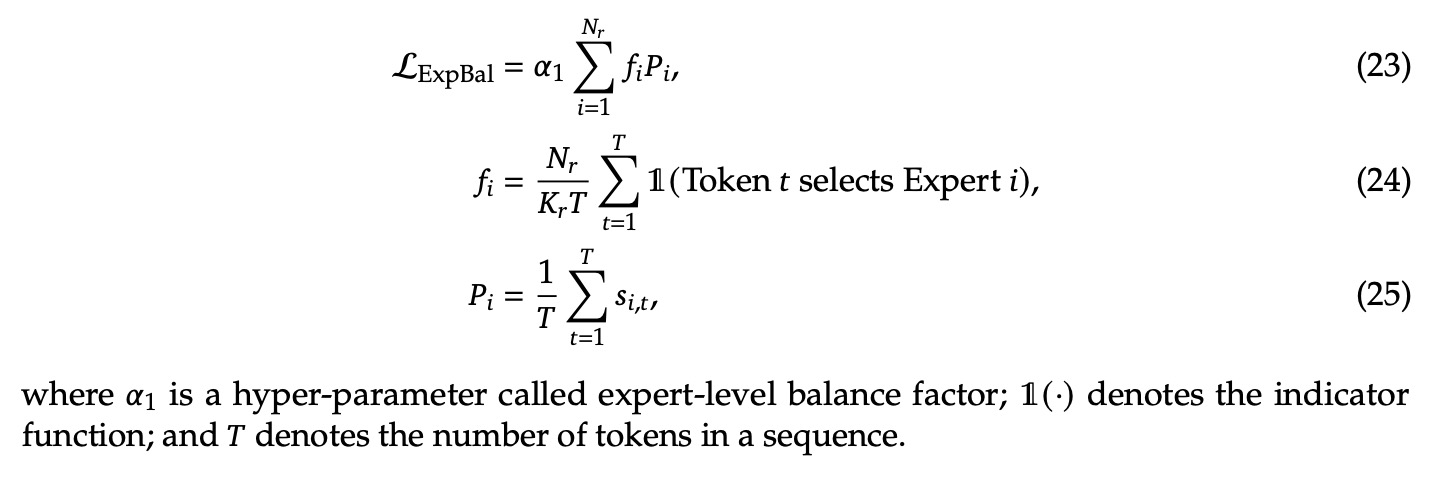

③设备的平衡Loss

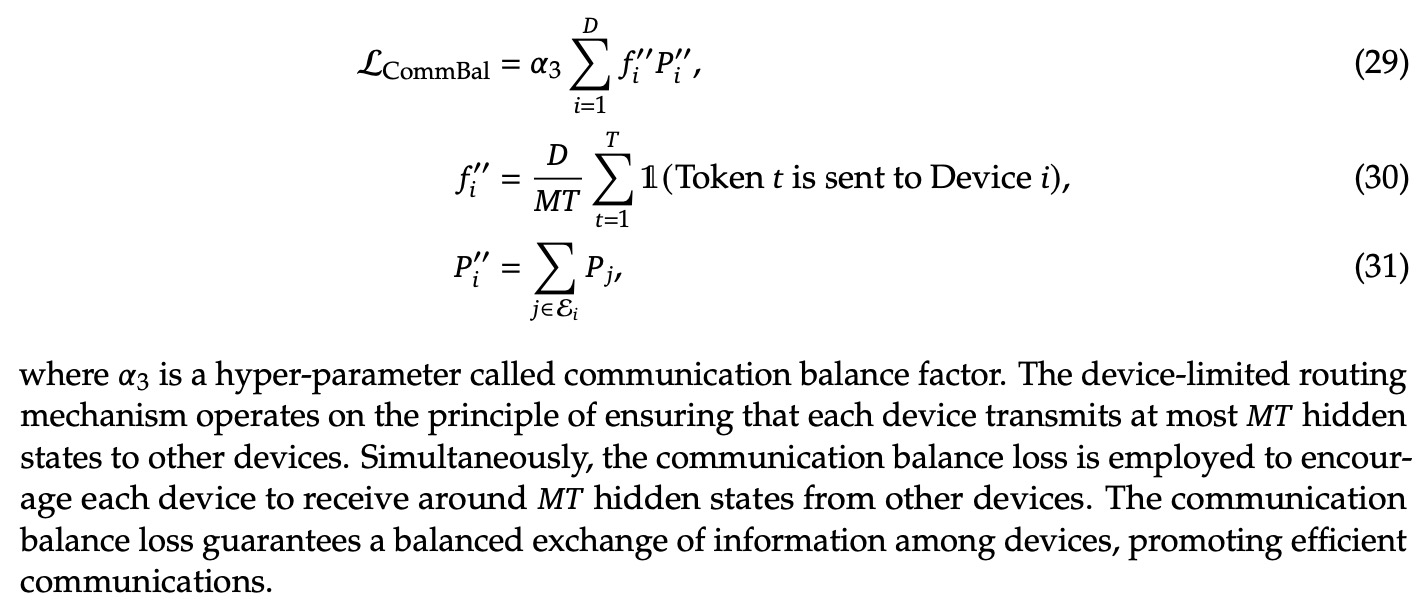

④通信的平衡Loss

⑤Token Dropping策略:避免设备间负载不均衡带来的计算浪费。

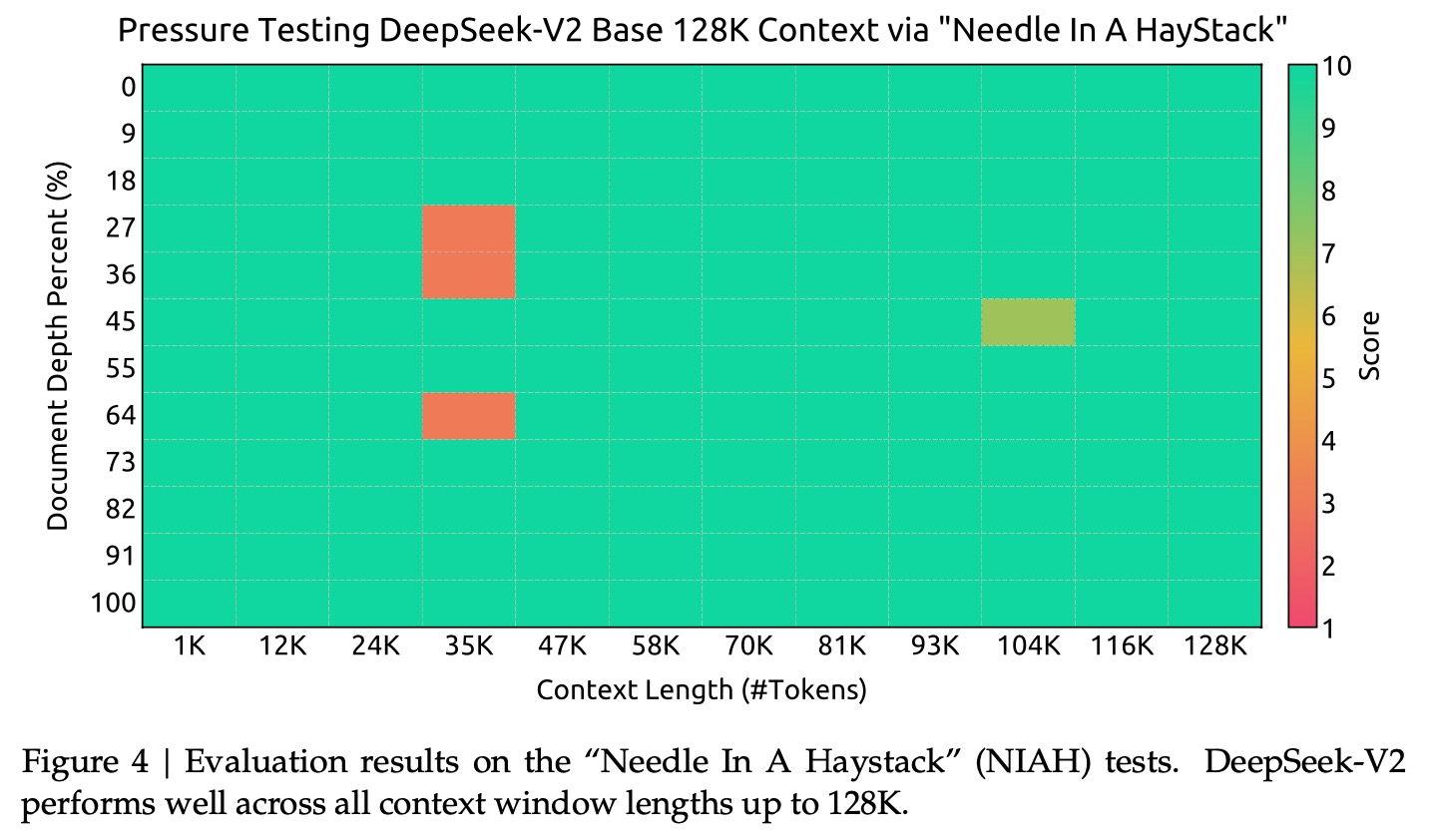

5. 长上下文的扩展:通过YaRN将上下文窗口从4k增加到128k,通过NIAH(Needle In A Haystack)测试表现良好。

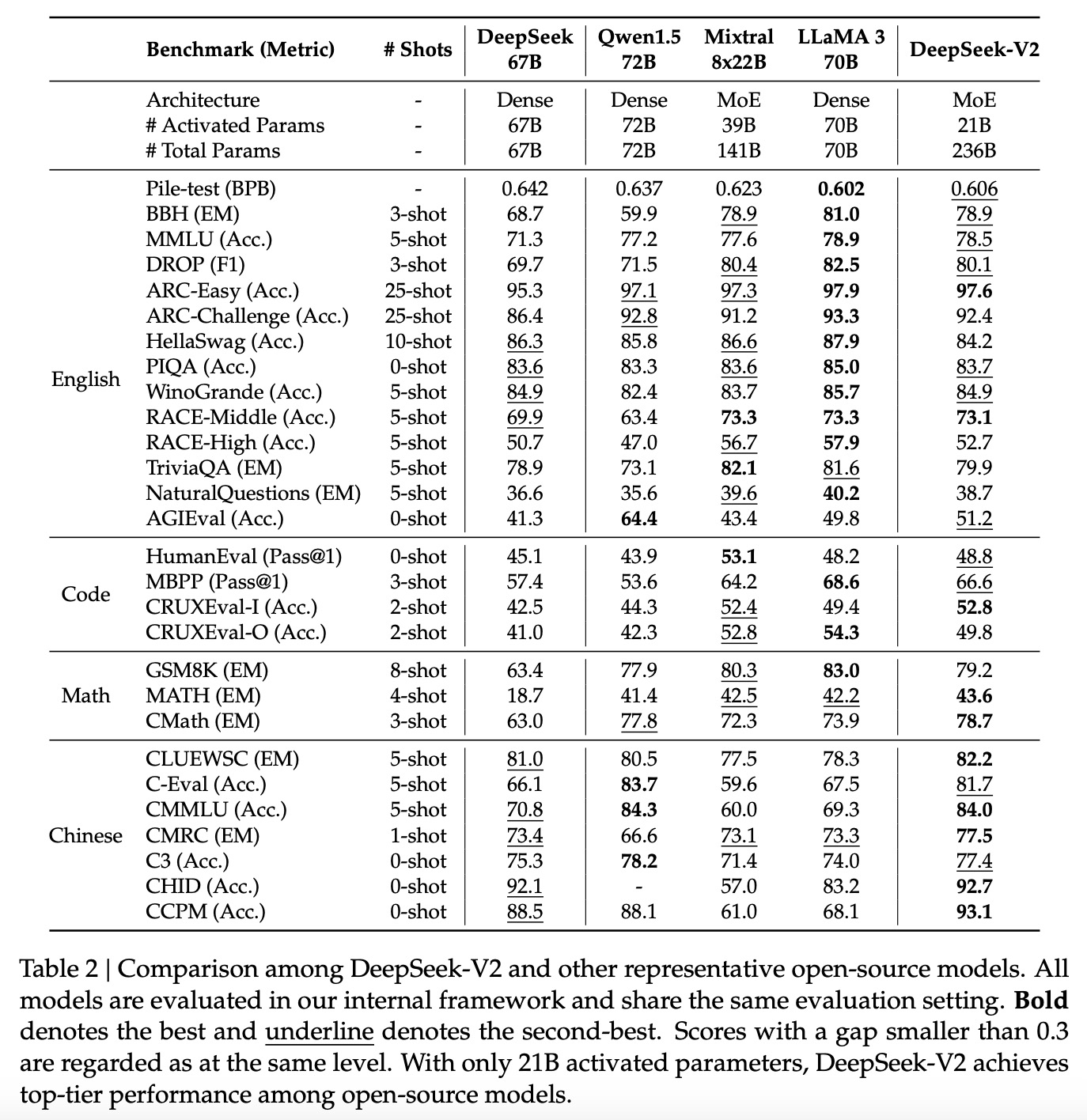

6. 评估

①多选题Multi-subject multiple-choice:MMLU、C-Eval、CMMLU

②语言理解和推理Language understanding and reasoning:HellaSwag、PIQA、ARC、OpenBookQA、BigBench Hard

③闭卷问答Closed-book question answering:TriviaQA、NaturalQuestions

④阅读理解Reading comprehension:RACE、DROP、C3

⑤消歧Reference disambiguation:WinoGrande、CLUEWSC

⑥语言建模Language modeling:Pile

⑦中文Chinese understanding and culture:CHID、CCPM

⑧数学Math:GSM8K、MATH、CMATH

⑨代码Code:HumanEval、MBPP

⑩考试Standardized exams:AGIEval

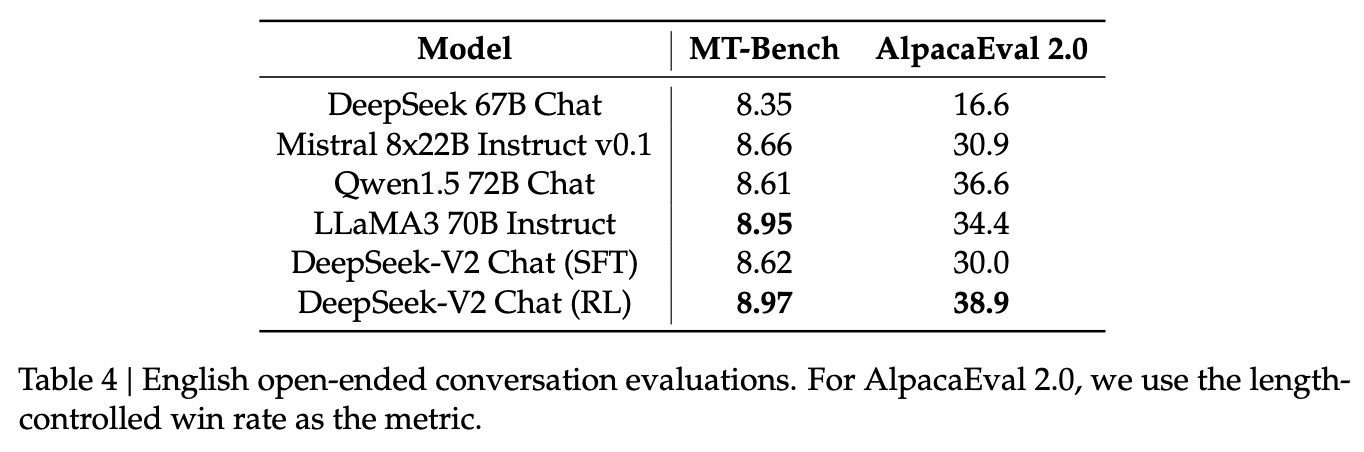

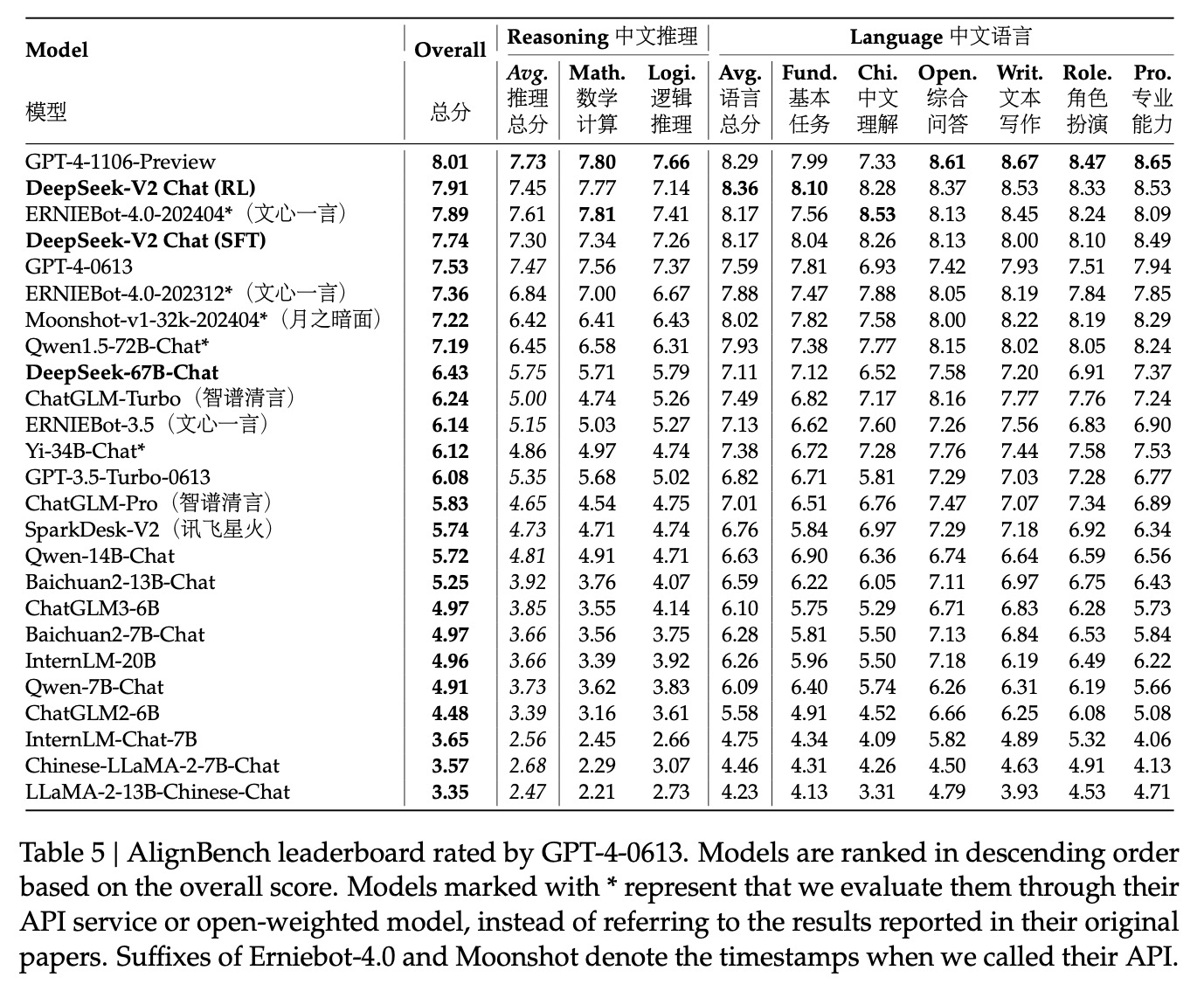

7. 评测结果

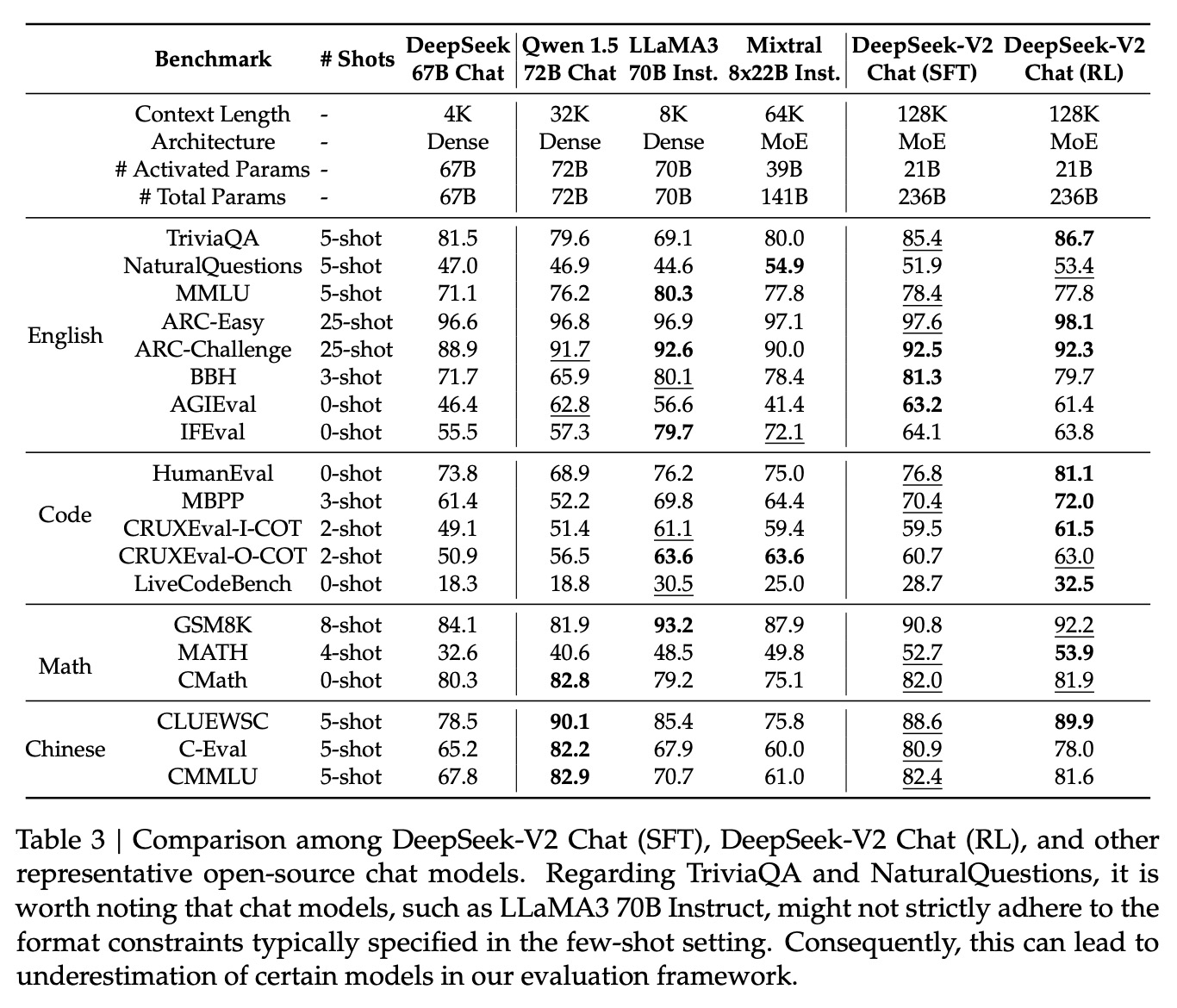

8. 模型对齐(后训练)

①SFT(Supervised Fine-Tuning)

②RL(Reinforcement Learning):使用了GRPO(Group Relative Policy Optimization)去进行RL(GRPO是在DeepSeekMath中提出的)

③评测结果

参考资料

[1] 深度求索DeepSeek背后的底层逻辑:https://zhuanlan.zhihu.com/p/29573646728

[2] 逐篇讲解DeepSeek关键9篇论文及创新点——“勇敢者的游戏”:https://www.bilibili.com/video/BV1xuK5eREJi/

[3] 十分钟读懂旋转编码(RoPE):https://www.zhihu.com/tardis/zm/art/647109286

[4] DeepSeek MoE:https://blog.csdn.net/John159151/article/details/147199203

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)