#Paper Reading# DeepSeekMoE: Towards Ultimate Expert Specialization in MoE Language Models

本文将DeepSeek LLM从Dense模型改为MoE模型,这也是follow了GPT的发展之路。主要工作是探索MoE的结构,包括增加专家的数量以及拆分为共享专家和独享专家。通过这样的操作,虽然模型参数量增大,但是实际infer的时候激活的参数量并不大,从而达到效果提升且成本降低的成效。

论文题目: DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models

论文地址: https://arxiv.org/pdf/2401.06066

论文发表于: arXiv 2024年1月

论文所属单位: DeepSeek

论文大体内容

本文将DeepSeek LLM从Dense模型改为MoE模型,这也是follow了GPT的发展之路。主要工作是探索MoE的结构,包括增加专家的数量以及拆分为共享专家和独享专家。通过这样的操作,虽然模型参数量增大,但是实际infer的时候激活的参数量并不大,从而达到效果提升且成本降低的成效。

Motivation

LLM模型从Dense改为MoE,提升模型效果且降低成本。

Contribution

①对LLM MoE框架的创新:更多的专家,并且拆分共享专家和独享专家

②本文做了详细的实验,去验证效果的收益

③可扩展性:DeepSeekMoE 16B只用了40%的计算量就能跟DeepSeek 7B和LLaMA2 7B达到一样的效果

④MoE的模型对齐

⑤模型开源

1. 本文探索了从Dense模型转向MoE模型的方法,以及做了2个改进,去拿到更好的效果。

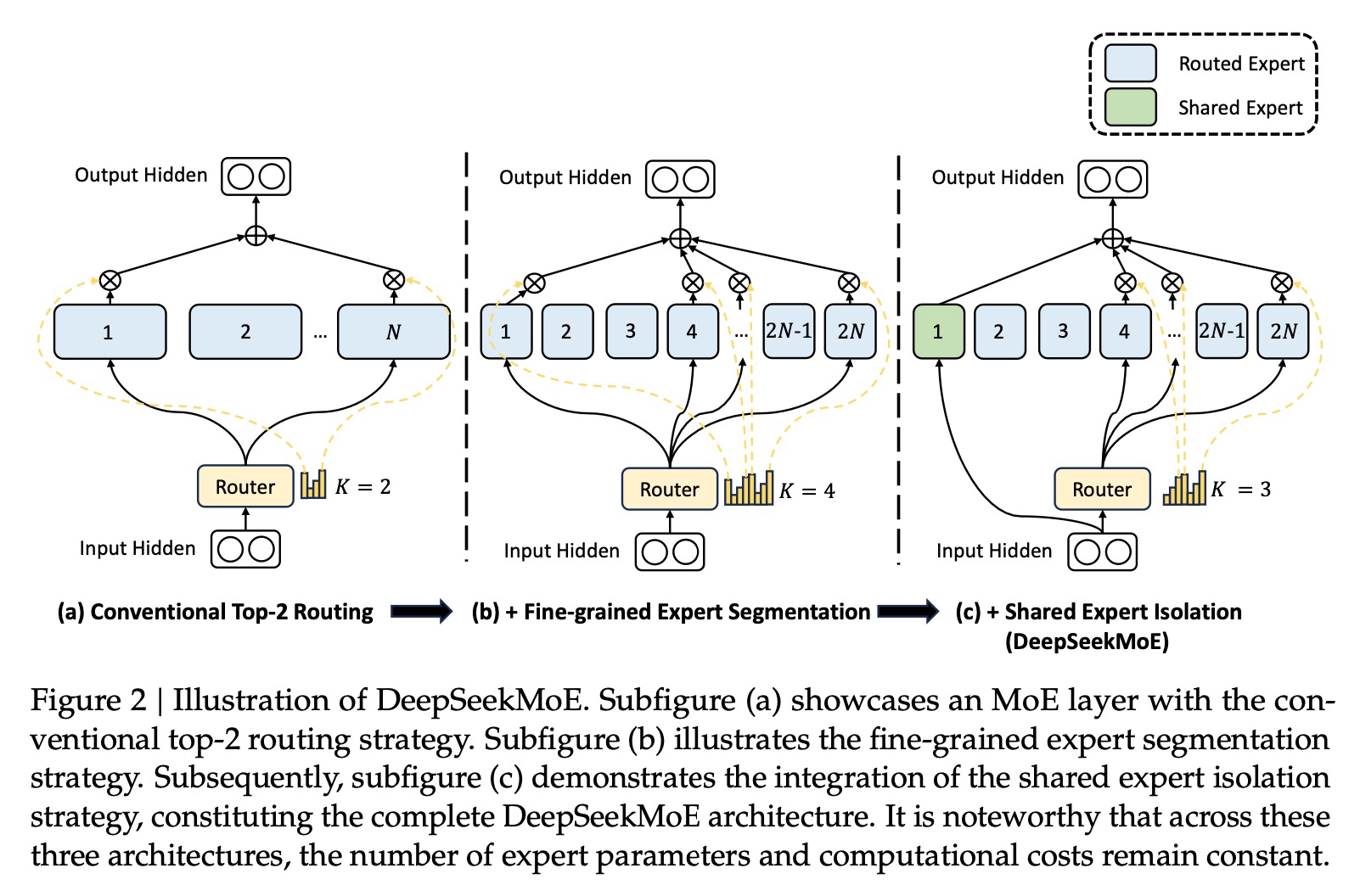

2. DeepSeek MoE的架构主要做了2个改进:

①细粒度的专家:将专家数量乘以m倍,每个专家的FFN的隐层维度除以m,每次使用的专家数量乘以m,这样保持了参数量一致,但是显著提升了专家之间的组合灵活性。当专家数量N=16,每次使用的专家数量K=2时,组合数量是C(16,2)=120。按m=4,那么专家数量N=16*4=64,每次使用的专家数量K=2*4=8,组合数量就变为了C(64,8)=442616536,极大的提升了组合量级。

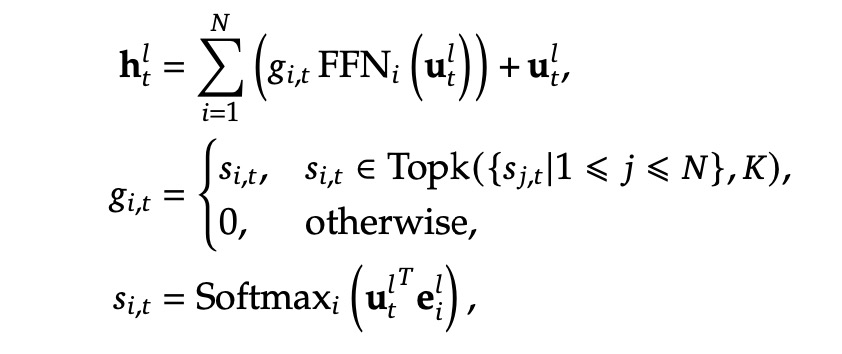

原有MoE计算方式:

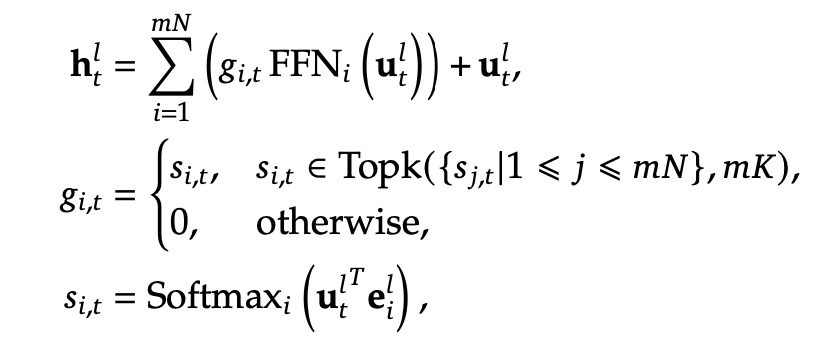

细粒度专家的计算方式:

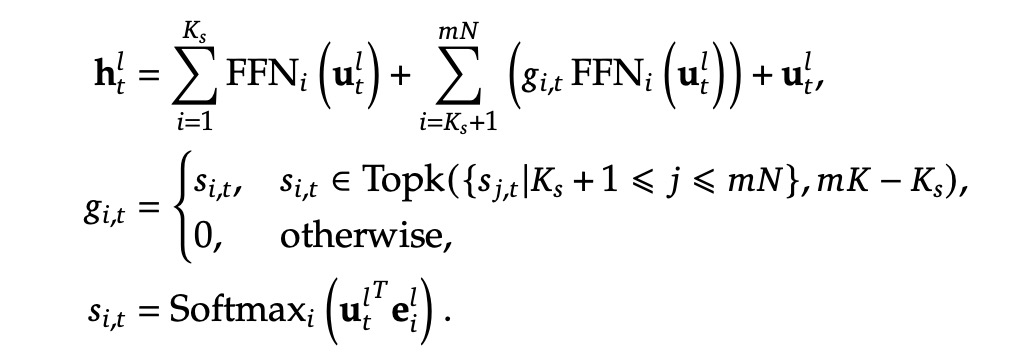

②共享专家隔离:本文希望共享专家可以学习到通识之类的知识,并且共享专家每次都会被路由到。

细粒度专家和共享专家的计算方式:

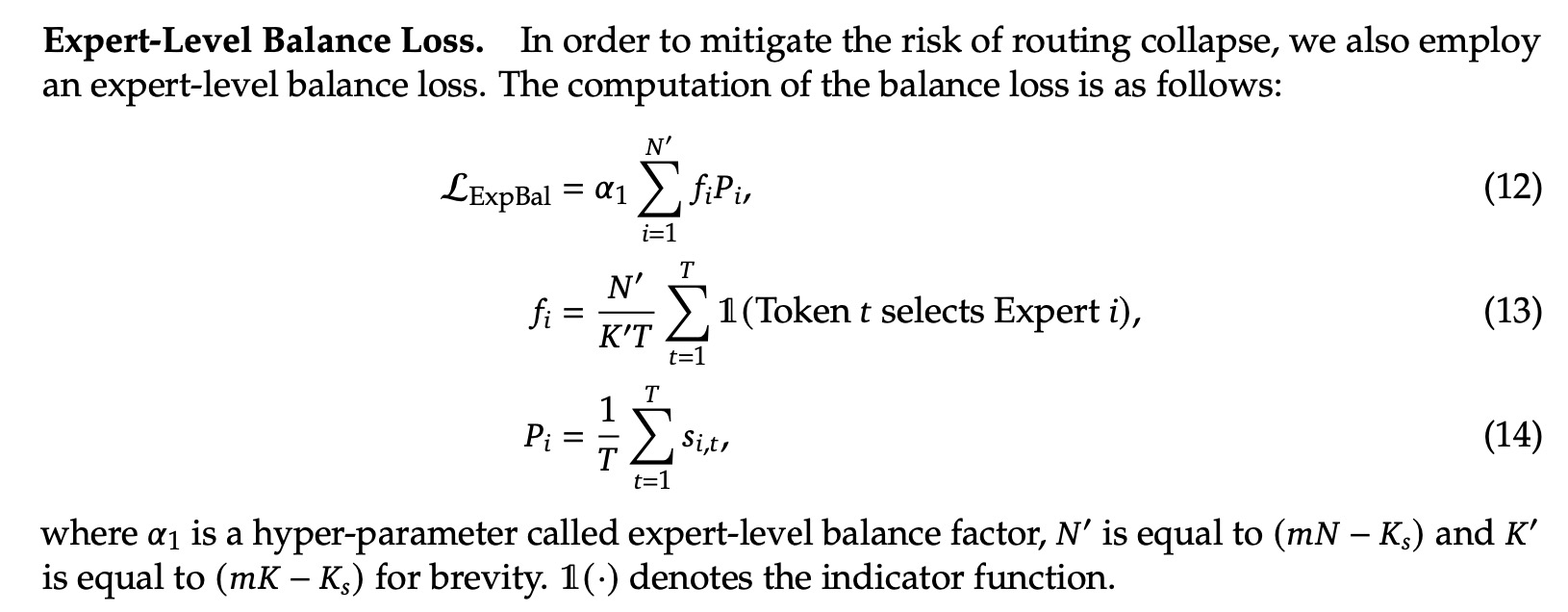

3. 为了避免模型学习的时候对专家使用的不均衡,本文增加了专家的平衡Loss,使用了较小的权重参数。

4. 为了提升计算的并行度,本文还增加了设备的平衡Loss,使用了较大的权重参数。

5. 评估

①语言建模Language modeling:Pile

②语言理解和推理Language understanding and reasoning:HellaSwag、PIQA、ARC-challenge、ARCeasy

③阅读理解Reading comprehension:RACE-high、RACE-middle

④代码Code:HumanEval、MBPP

⑤闭卷问答Closed-book question answering:TriviaQA、NaturalQuestions

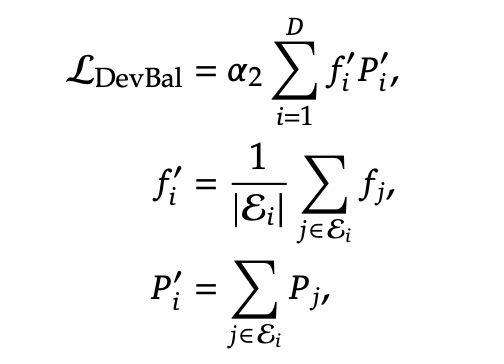

6. 评估结果

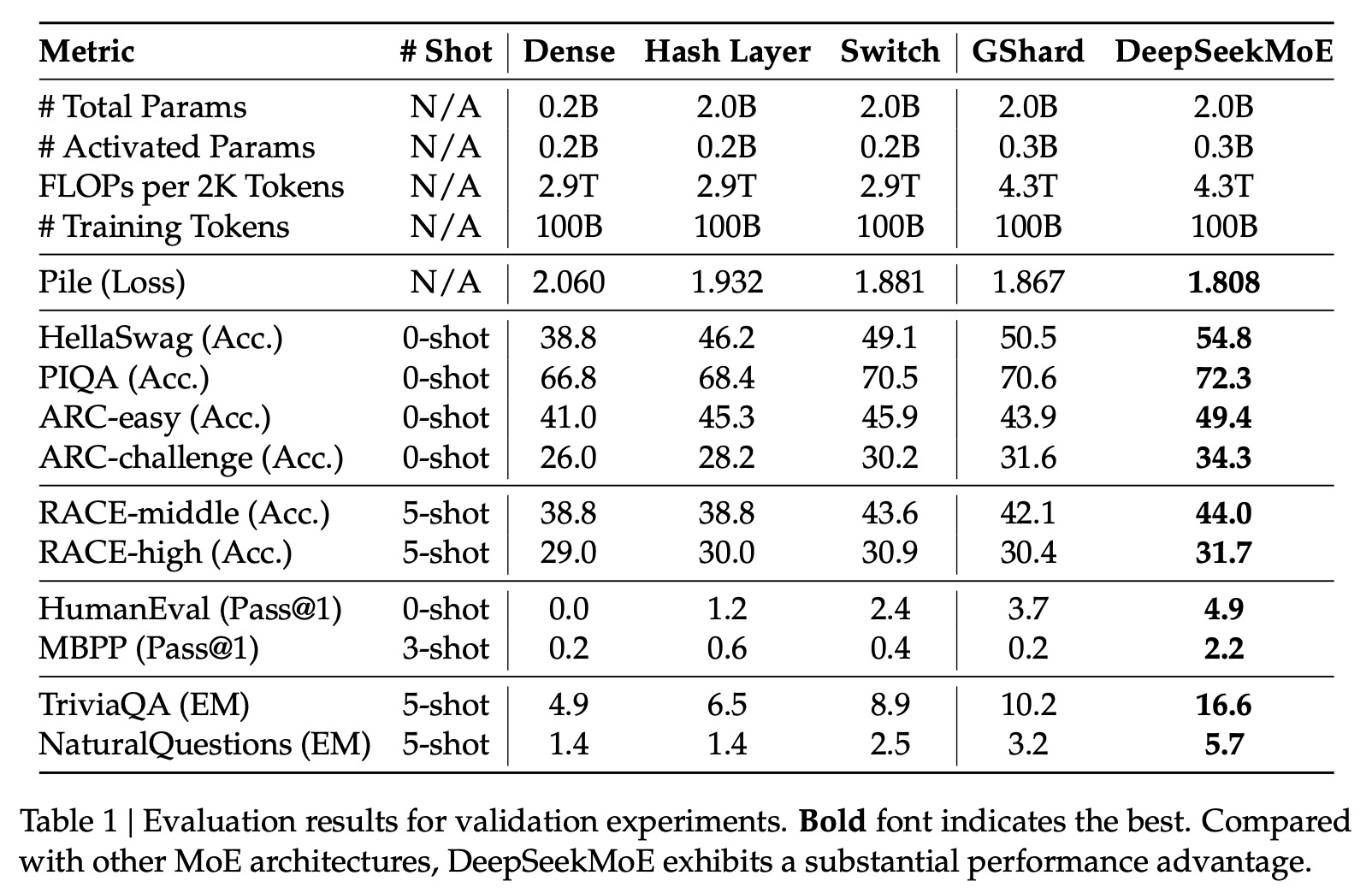

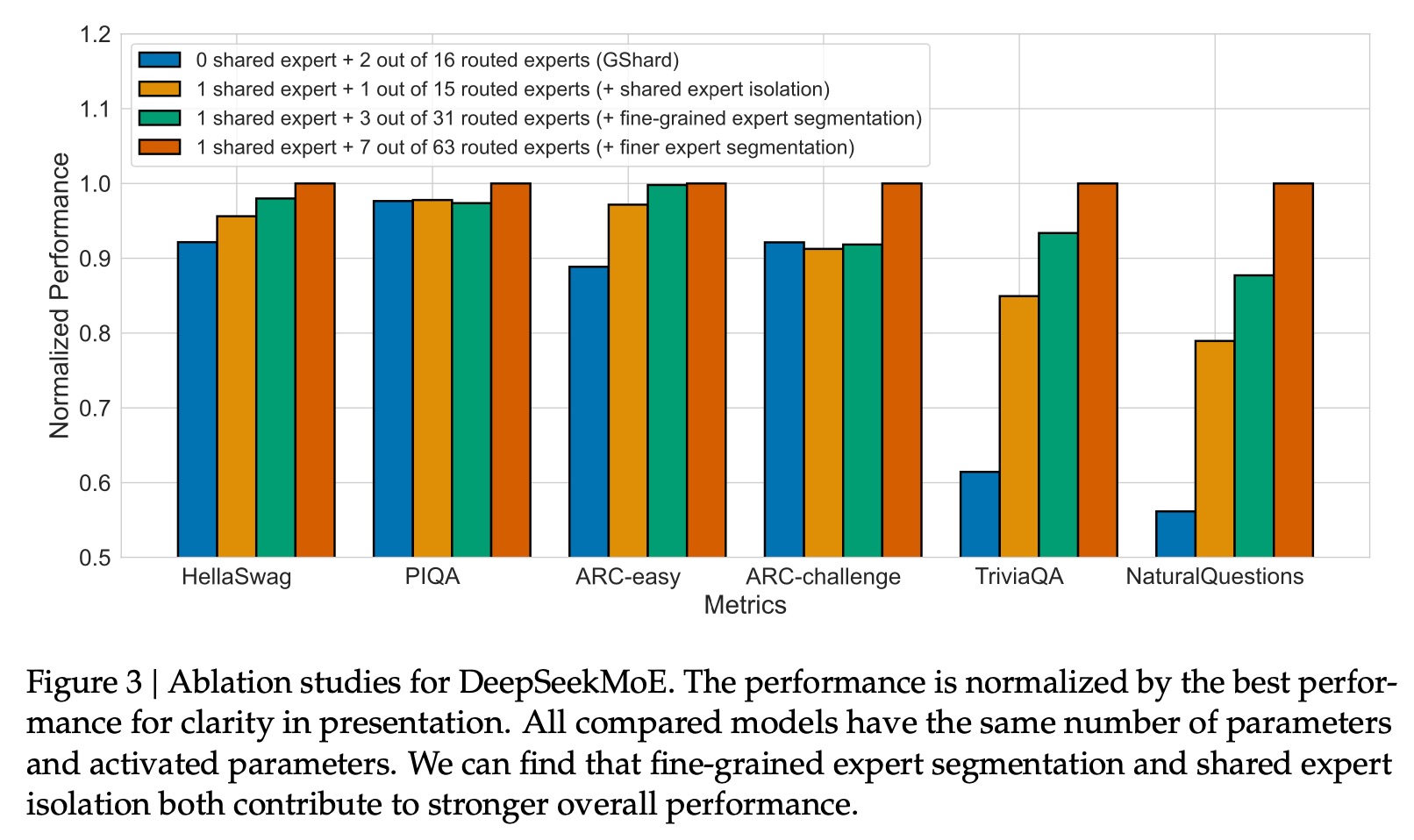

7. 消融实验:对比本文的细粒度专家和共享专家的收益

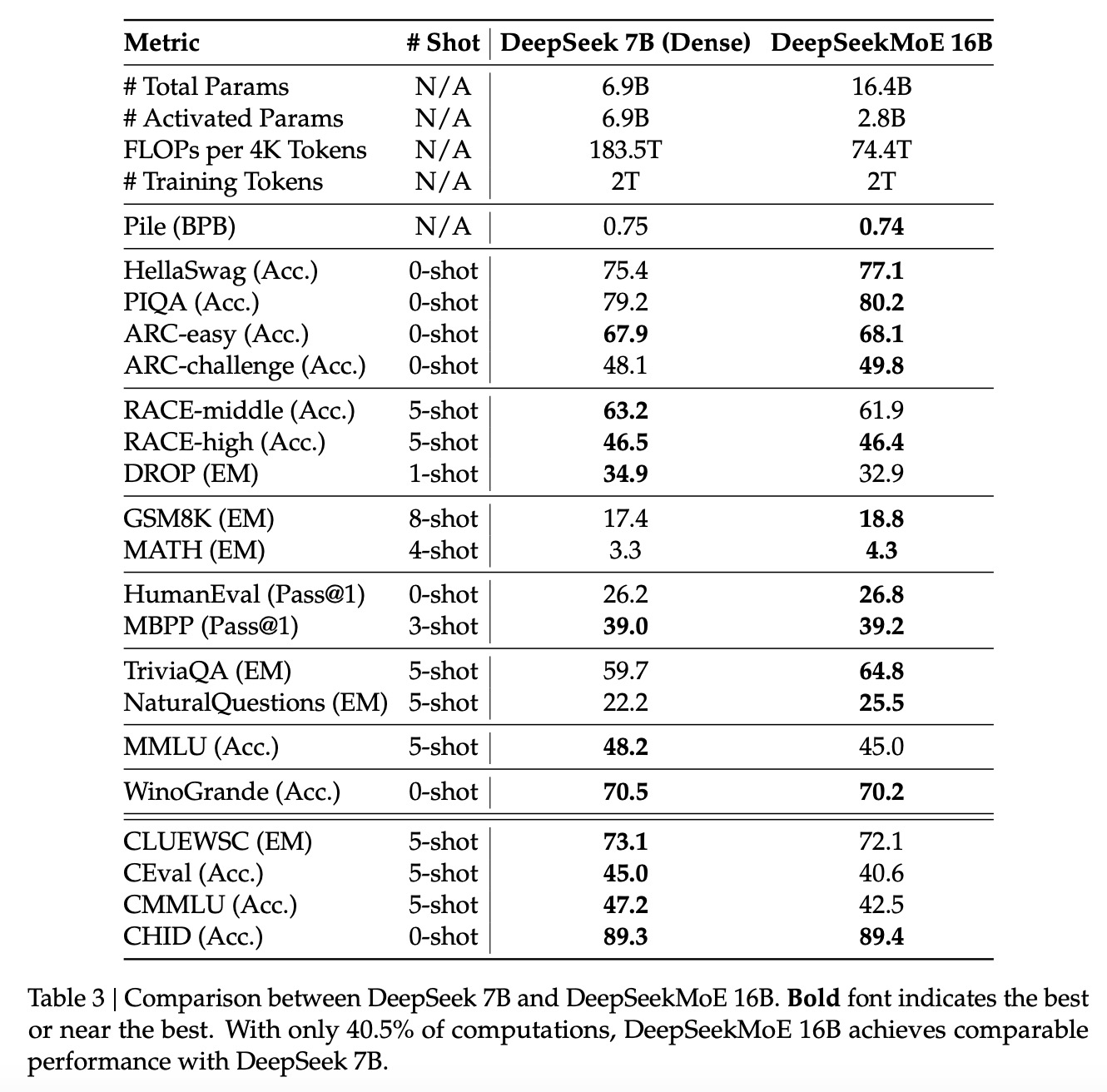

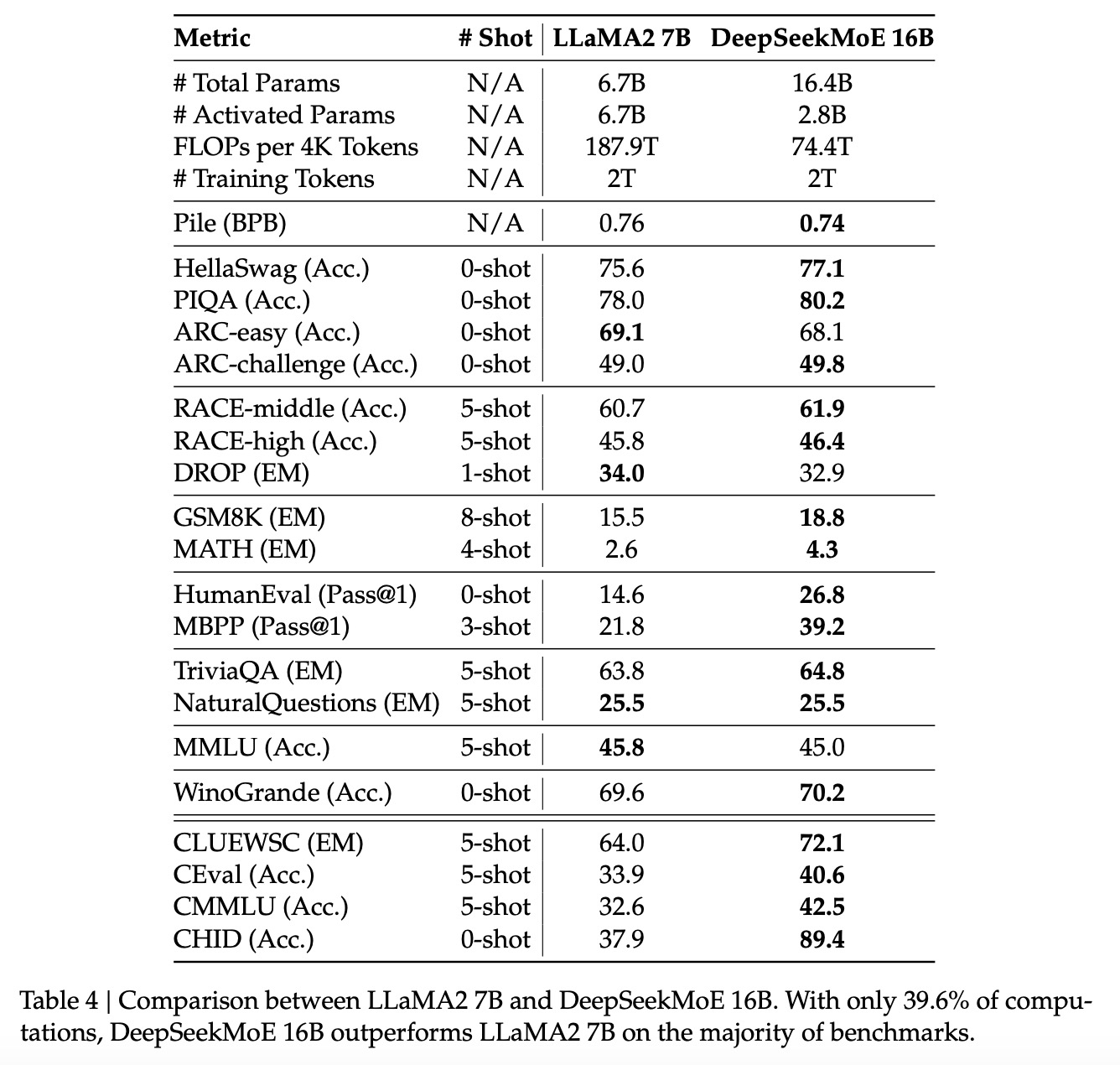

8. 上面是DeepSeek 2B的模型效果,这里扩充到16B模型,观察对比其效果,发现DeepSeekMoE 16B只用了40%的计算量就能跟DeepSeek 7B和LLaMA2 7B达到一样的效果

9. DeepSeek还在训练DeepSeek MoE 145B的模型,使用了245B的token去训练。

思考:

从开源界或者GPT传的消息,大家都是往MoE去优化模型的,所以DeepSeek调整方向也是合理的。这种方式其实正如文章所说,NLP领域也早有学者将FFN改为MoE。DeepSeek从本篇论文开始,就彻底从技术路线上抛弃Dense模型,走向MoE的道路。

备注:

Transformer中FFN的作用:

1. FFN是2层的MLP,一层升维,一层降维,去学习到更抽象的特征

2. 非线性变换:MHA是矩阵乘法,里面都是线性变换,需要增加一个非线性变换(Relu激活函数)去学习到更强的表达。虽然MHA中的softmax是非线性的,但是对于Value来说并没有非线性变换,整体还是线性的

3. FFN和ResNet同时生效,都很重要,FFN物理含义是信息提取和聚合(记忆功能),ResNet是增大了信息带宽

参考资料

[1] 深度求索DeepSeek背后的底层逻辑:https://zhuanlan.zhihu.com/p/29573646728

[2] 逐篇讲解DeepSeek关键9篇论文及创新点——“勇敢者的游戏”:https://www.bilibili.com/video/BV1xuK5eREJi/

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)