Llama 4 详细评测:开源模型的全面倒退?

那么,Llama 4到底是不是“开源模型的全面倒退”?从目前的测试结果来看,这种说法虽显极端,却并非毫无根据。在多个关键任务中,Maverick 勉强追平主流闭源模型的尾巴,而 Scout 则在小模型领域表现平平,甚至被自家的 Llama 3.3 70B 反超。相比之下,DeepSeek V3 的统治力更像是给所有开源模型泼了一盆冷水。但退一步看,开源的价值不止于性能指标,更在于长期可控性、社区生

“Llama 4 是开源模型的全面倒退。”——在Meta发布新一代大模型不到24小时内,这样的质疑声音已经出现在多个技术社区。

Llama 4 真的不如前代?还是它只是“看起来拉胯、实则有料”?

本文将基于 Artificial Analysis 的独立评估数据和社交媒体舆情,深入剖析 Llama 4 的技术亮点、实际表现与竞品差距,并探讨这款“争议中亮相”的新模型究竟是开源未来,还是开源瓶颈的缩影。

一、性能对比:差距不是一点,是一整条街

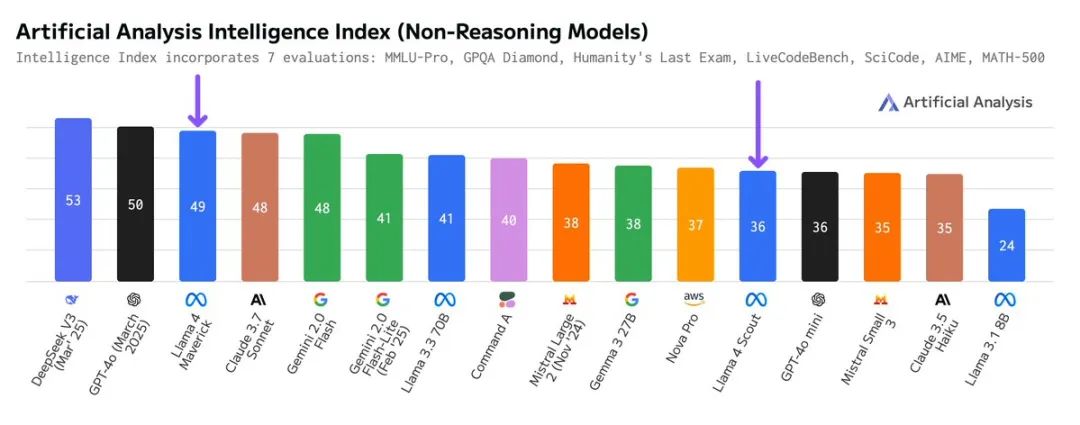

Artificial Analysis通过其Intelligence Index(涵盖MMLU-Pro、GPQA Diamond、HumanEval等非推理模型评估)对Llama 4进行了独立测试,具体结果如下:

1、总体性能(Intelligence Index)

从最新的 Artificial Analysis Intelligence Index 综合榜单来看,Llama 4 的表现让人大跌眼镜。

在这份集通用推理、科学推理、编码、数学等七项任务为一体的硬核评测中,Google 的 Gemini 2.5 Pro、xAI 的 Grok 3、以及 DeepSeek R1 牢牢占据前三,综合得分分别为 68、66 和 66,实力堪称天花板级别,属于开局即封神的选手。

而反观刚刚发布的 Llama 4 系列:

- Maverick 得分 49,不仅被前述三强甩出十几分的距离,连 OpenAI 的 GPT-4o和阿里的 QwQ-32B都没打过,未能进入第一梯队,只能勉强跻身中游。

- Scout 得分仅为 36,直接与 GPT-4o mini 打成平手,甚至被 Google 的 Gemma 3 27B按在地上摩擦,表现惨不忍睹。

这意味着,无论是旗舰定位的 Maverick 还是轻量版的 Scout,都未能在关键指标上与主流竞品拉开差距。特别是 Scout,不仅没展现出“小而强”的性价比,还在多项任务中落后于前代产品与同量级模型。

一句话总结:“看起来很强,打起来很虚”,是当前市场对 Llama 4 初版表现最真实的反馈。

在非推理任务的对比中,Llama 4 的表现可谓喜忧参半。Maverick在开源模型中算得上发挥稳定,成功超越部分闭源竞品,展示出一定的专业处理能力。然而与顶级模型如 DeepSeek V3 和 GPT-4o相比,依然存在明显差距,说明其综合实力尚未达到第一梯队的水平。

Scout则更为克制,没有惊喜也没有翻车,整体表现与GPT-4o mini相当,虽不具备突破性优势,但在资源受限场景下仍具备一定实用价值。

总体来看,Llama 4系列虽在非推理能力上具备一定基础,但距离“强通用、强专业”的开源标杆,还有一段路要走。它们更像是一次架构和方向的试水,而不是一举超车的终局之作。

2、具体任务表现

Artificial Analysis的评估数据(详见附图)涵盖了通用推理、科学推理、编码和数学等多个领域,我将相关任务合并分析,聚焦Llama 4(Scout和Maverick)的表现趋势,并与主要竞品DeepSeek V3、Claude 3.7 Sonnet、和GPT-4o mini对比,揭示其优势与不足。以下简要补充各指标的含义和重要性,帮助理解评估维度。

2.1、通用推理:稳中有位,但缺乏突破

通用推理评估模型在广泛知识和综合推理能力上的表现,MMLU-Pro覆盖57个学科的知识广度,Humanity’s Last Exam则测试复杂推理能力。这类指标对衡量模型在教育、问答等通用场景的适用性至关重要。

Maverick在通用推理任务中表现稳健,在MMLU-Pro中排名靠前,与GPT-4o、Claude 3.7 Sonnet等模型同等,但略逊于DeepSeek V3 V3(Mar 25)。Scout的表现则比较落后,低于Mistral Small 3和GPT-4o mini。

在Humanity’s Last Exam中,Maverick同样位列前茅,接近DeepSeek V3(Mar 25),优于GPT-4o 和Claude 3.7 Sonnet,Scout则排名中游,略高于Mistral Small 和GPT-4o mini。

结论:在通用推理相关任务中,Maverick 的表现整体可圈可点,尤其在知识广度和复杂推理方面接近一线闭源模型,虽然略逊于 DeepSeek V3,但基本站稳中上游位置。Scout 则明显吃力,整体排名不高,甚至落后于部分轻量模型,反映出其在处理广义知识类任务时的适应能力仍待加强。

2.2、科学推理:开源难题,Llama 4未解

科学推理通过GPQA Diamond测试模型在生物、物理、化学等领域的专业推理能力,强调多步推理和深度理解,对评估模型在学术研究、技术文档处理等专业场景的表现尤为重要。

Maverick在科学推理任务中的表现显著低于DeepSeek V3和Claude 3.7 Sonnet的水平,排名靠后,未能展现出与顶级模型竞争的能力。Scout的表现则稍显逊色,不仅远低于GPT-4o mini,甚至低于Meta自己的Llama 3.3 70B,显示其在专业领域推理上的明显不足。

结论:面对生物、物理、化学等专业领域的深度推理任务,Llama 4 表现疲软,尤其是 Maverick,虽为高配模型,却未能在多步逻辑和专业理解上展现出预期能力,明显落后于 Claude 和 DeepSeek。Scout 的表现则更加堪忧,不仅输给 GPT-4o mini,甚至被 Llama 3.3 70B 反超,显示其在学术和技术类场景中的适用性非常有限。

2.3、编码能力:基础乏力,高难勉强及格

Maverick在编码任务中的表现未达预期。在基础编码能力(HumanEval)上,Maverick远低于GPT-4o、Claude 3.7 Sonnet以及DeepSeek V3,仅达到GPT-4o mini的水平,显示其在基础代码生成上的竞争力不足。

在更具挑战性的竞赛级编码(LiveCodeBench)和科学编码(SciCode)任务中,Maverick的表现进一步回落,与DeepSeek V3和Claude 3.7 Sonnet的差距不太明显。

Scout在基础编码和科学编程任务中表现垫底,排名靠后,远低于大多数竞品。然而,在高难度编码任务(LiveCodeBench)中,Scout的表现意外接近中位值,与Claude 3.5 Haiku水平相当,展现了一定的潜力。

结论:Maverick 在代码生成任务中并未脱颖而出,基础编程任务的完成度不高,与领先模型存在明显差距。面对竞赛级和科学编程挑战时,其表现更为拉胯,难以支撑复杂开发需求。Scout 则在大部分编码任务中垫底,虽在高难度挑战中偶有亮点,但整体竞争力仍偏弱,不具备“开发者友好”的实用价值。

2.4、数学:基础尚可,高阶失守

数学任务评估模型的定量推理能力,MATH-500测试常规数学问题解决能力,AIME 2024则聚焦高难度竞赛级数学推理。这类指标对教育、科学研究和金融建模等需要强大数学能力的场景尤为关键。

Maverick在定量推理任务(MATH-500)中表现较为稳健,排名靠前,超越Claude 3.7 Sonnet,但与DeepSeek V3仍存在一定差距,显示其在常规数学问题解决上的竞争力。Scout的表现同样可圈可点,优于GPT-4o mini,并接近Claude 3.7 Sonnet的水平,展现了不错的基础数学能力。

然而,在高难度的竞赛级数学推理任务(AIME 2024)中,Maverick表现不佳,远落后于DeepSeek V3,仅略高于GPT-4o。

结论:在数学推理方面,Llama 4 两个版本表现出较为明显的分化。Maverick 在基础数学任务中稳健发挥,部分场景甚至可与主流闭源模型媲美,Scout 也展现出一定的定量推理能力,优于部分轻量模型。然而,进入竞赛级高难度数学任务后,两者均显得力不从心,与 DeepSeek V3 等强模型的差距明显拉大,暴露出复杂推理能力上的短板。

总结:差距不是一点,是一整条街

综合来看,Llama 4(Maverick 和 Scout)在非语言生成的关键能力维度上,与 DeepSeek V3 之间存在系统性差距。Maverick虽有部分亮点,但始终处于“差一点”的状态,在科学推理、编码和高阶数学上几乎全面落后。Scout的表现则更为惨烈,不仅被 DeepSeek V3 和 Claude 系列全面碾压,甚至在多个维度不敌小模型选手,令人质疑其在专业场景中的实际价值。

Llama 4 所展示的更多是架构层面的潜力,而非实打实的能力跃迁。除非在未来版本中针对专业推理、复杂任务场景进行重点优化,否则很难在真正需要“硬实力”的场合,成为开源替代品的第一选择。

二、模型效率

与DeepSeek V3相比,Llama 4 Maverick的活跃参数大约只有其一半(17B对37B),总参数也仅为其60%左右(402B对671B),这表明Maverick以更高的效率实现了其性能表现。此外,Maverick还支持图像输入,而DeepSeek V3则不具备这一功能。

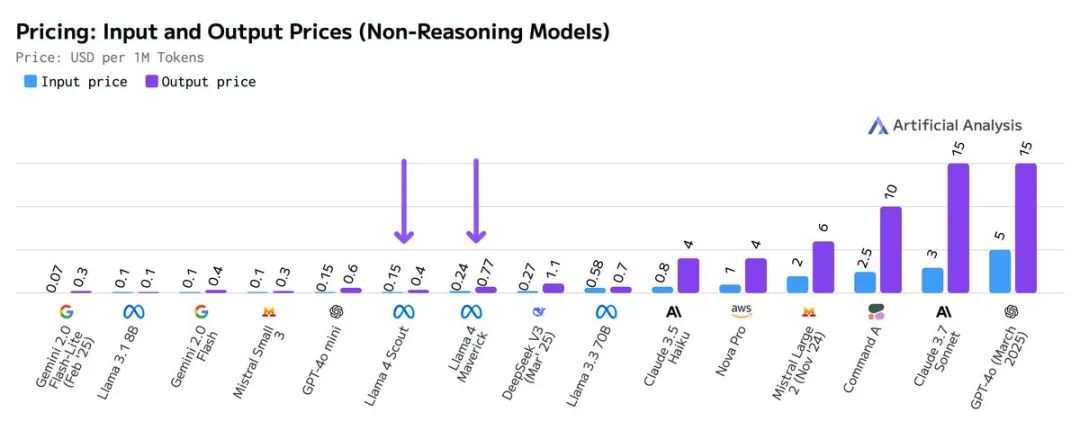

三、价格

Artificial Analysis追踪6家服务提供商,并对比评估了Maverick的中位价格为每百万输入/输出token 0.24美元/0.77美元,而Scout的定价为每百万输入/输出token 0.15美元/0.4美元,其价格不仅低于DeepSeek v3,相比OpenAI领先的GPT-4o接口更是便宜超过10倍。

四、 最后

那么,Llama 4到底是不是“开源模型的全面倒退”?从目前的测试结果来看,这种说法虽显极端,却并非毫无根据。

在多个关键任务中,Maverick 勉强追平主流闭源模型的尾巴,而 Scout 则在小模型领域表现平平,甚至被自家的 Llama 3.3 70B 反超。相比之下,DeepSeek V3 的统治力更像是给所有开源模型泼了一盆冷水。

但退一步看,开源的价值不止于性能指标,更在于长期可控性、社区生态与开放创新的累积潜力。Llama 4 的多模态架构、超长上下文和低廉定价,依然在为未来铺路——也许不是现在碾压闭源的“终极答案”,但可能是通往答案的那一步。

最终,它是倒退还是转折,要看 Meta 和整个开源社区,能否在质疑声中继续优化、快速迭代,把短板变成支点。真正的竞争,还远远没有结束。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

更多推荐

已为社区贡献71条内容

已为社区贡献71条内容

所有评论(0)