DeepSeek-R1 模型在 AWS 上全面上线,速通使用指南

Amazon Bedrock允许您通过单一的Serverless、统一API导入并使用定制化的模型,无需管理底层基础设施,这些模型可以与现有的基础模型一起使用,可以自定义导入参数规模在15亿到700亿之间的DeepSeek-R1-Distill Llama模型,可以利用6710亿参数的大型DeepSeek-R1模型,也可以蒸馏训练更小、更高效的模型,以模仿行为和推理模式。

在刚刚过去的 AWS,Amazon 首席执行官 Andy Jassy 分享了从 Amazon 自己在全公司开发近 1000 个生成式 AI 应用程序的经验中汲取的宝贵经验。从这种广泛的 AI 部署中,Jassy 提供了三个关键观察结果,这些观察结果塑造了 Amazon 的企业 AI 实施方法。

-

随着您开始扩展生成式 AI 应用程序,计算成本真的很重要。人们非常渴望更好的性价比。

-

实际上很难构建一个真正好的生成式 AI 应用程序。

-

当我们让建造者自由选择他们想要做的事情时,所使用的模型的多样性。这并不让我们感到惊讶,因为我们一遍又一遍地学习同样的教训,那就是永远不会有一种工具来统治世界。

Andy强调:亚马逊云科技提供的丰富且有深度的模型,让客户能够根据自身独特需求,精确选择最合适的解决方案。关注客户需求与技术发展,亚马逊云科技持续扩展模型选择,既要有潜力的新兴模型,也要有行业内的经典模型。

这让我们关注到中国的AI初创公司DeepSeek。DeepSeek于2024年12月推出了DeepSeek-V3,并于2025年1月20日相继发布了DeepSeek-R1、DeepSeek-R1-Zero(拥有6710亿参数)以及参数规模在15亿到700亿之间的DeepSeek-R1-Distill模型。2025年1月27日,他们又推出了基于视觉的Janus-Pro-7B模型。这些模型已向公众开放,据报道,其成本比同类模型低90%到95%,更具性价比。

今天,您可以在Amazon Bedrock和Amazon SageMaker AI中部署DeepSeek-R1模型。Amazon Bedrock最适合那些希望通过API快速集成预训练模型的团队;Amazon SageMaker AI则非常适合自己进行高级定制、训练和部署、调用基础设施的团队。

此外,您还可以通过Amazon EC2、Amazon SageMaker AI,使用Amazon Trainium和Amazon Inferentia,用更具性价比的方式部署DeepSeek-R1-Distill。

通过亚马逊云科技,您可以使用DeepSeek-R1模型,无需进行大量的基础设施投资,同时还可以享有亚马逊自建、自带的安全能力。强烈建议将DeepSeek-R1模型与Amazon Bedrock Guardrails集成,为您的生成式AI应用增加一层保护!

选择以下任一方式选择部署DeepSeek-R1模型:

-

在Amazon Bedrock Marketplace部署DeepSeek-R1模型;

-

在Amazon SageMaker JumpStart部署DeepSeek-R1模型;

-

通过Amazon Bedrock自定义导入DeepSeek-R1-Distill模型;

-

在Amazon EC2 Trn1实例上部署DeepSeek-R1-Distill模型。

无论您是首次构建AI应用,还是在扩展现有解决方案,这些方式都能根据团队的需求量身定制。可通过注册亚马逊云科技官网,了解更多内容。

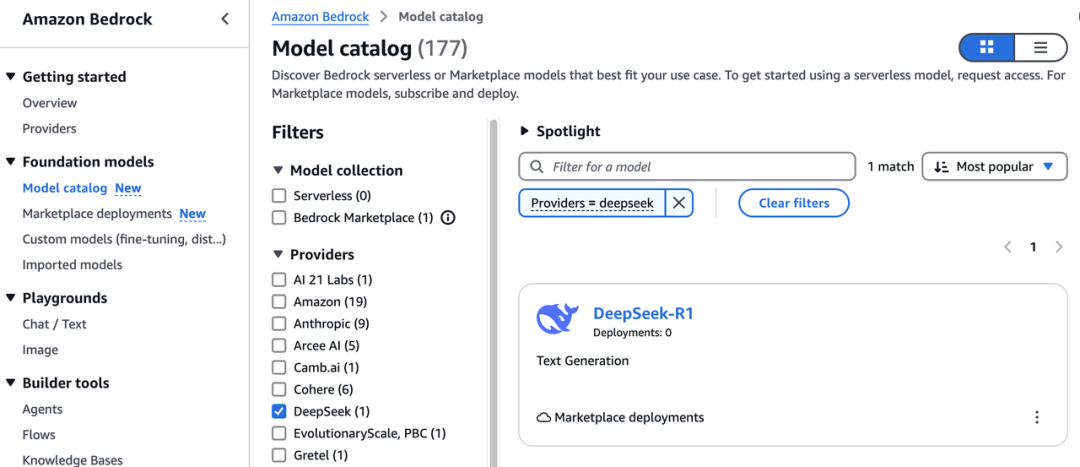

1.如何在Amazon Bedrock Marketplace中调用DeepSeek-R1模型

Amazon Bedrock Marketplace提供了超过100种流行的、新兴的以及专业化的基础模型。您可以在一个统一的目录中轻松发现、订阅模型。

第一步,请进入Amazon Bedrock控制台,并在“基础模型”部分选择“模型目录”,通过搜索或按模型提供商筛选,快速找到DeepSeek。

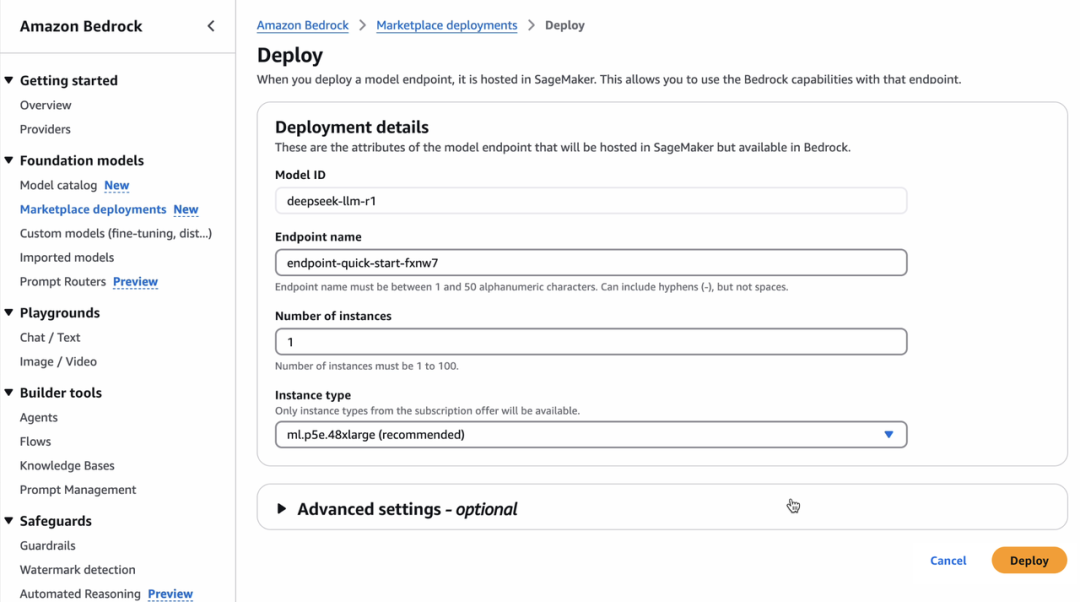

查看模型详情(包括模型的能力和实施指南)后,提供一个端点名称、选择实例数量、选择实例类型,然后直接部署该模型。

几个tips:

-

您可以配置高级选项,自定义DeepSeek-R1模型的安全性和基础设施设置:VPC网络、服务角色权限和加密设置。确保符合您组织的安全性和合规性要求。

-

通过Amazon Bedrock Guardrails,您可以独立评估用户输入和模型输出,可以通过过滤生成式AI应用中的不良和有害内容,使用定义的策略集来控制用户与DeepSeek-R1之间的交互。利用Amazon Bedrock上的ApplyGuardrail API,可以评估用户输入和模型响应。如需了解更多,请阅读《通过Amazon Bedrock Guardrails实施模型无关的安全措施》。

-

Amazon Bedrock Guardrails还可以与其他Amazon Bedrock工具(如Amazon Bedrock Agents和Amazon Bedrock Knowledge Bases)集成,以构建更安全、更符合负责任的AI政策的生成式AI应用。如需了解更多,请访问亚马逊云科技负责任的AI页面。

-

在使用DeepSeek-R1模型时,如果通过 Amazon Bedrock的InvokeModel API或Playground Console进行调用,请使用DeepSeek的聊天模板以获得最佳效果。

<|begin▁of▁sentence|><|User|>content for inference<|Assistant|>

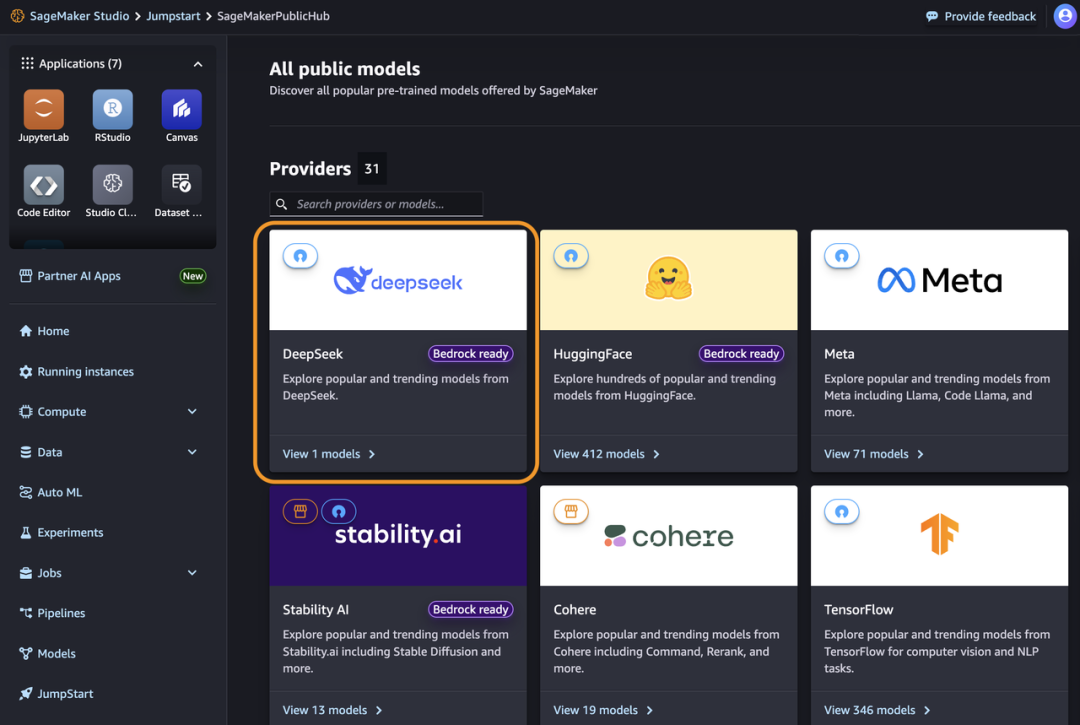

2.如何在Amazon SageMaker JumpStart中部署DeepSeek-R1模型

Amazon SageMaker JumpStart是一个机器学习中心,提供基础模型、内置算法以及预构建的机器学习解决方案,您只需点击几次即可完成部署。要在Amazon SageMaker JumpStart中部署DeepSeek-R1模型,您可以在Amazon SageMaker Unified Studio、Amazon SageMaker Studio、Amazon SageMaker AI控制台中找到DeepSeek-R1模型,或者通过Amazon SageMaker Python SDK以编程方式进行部署。

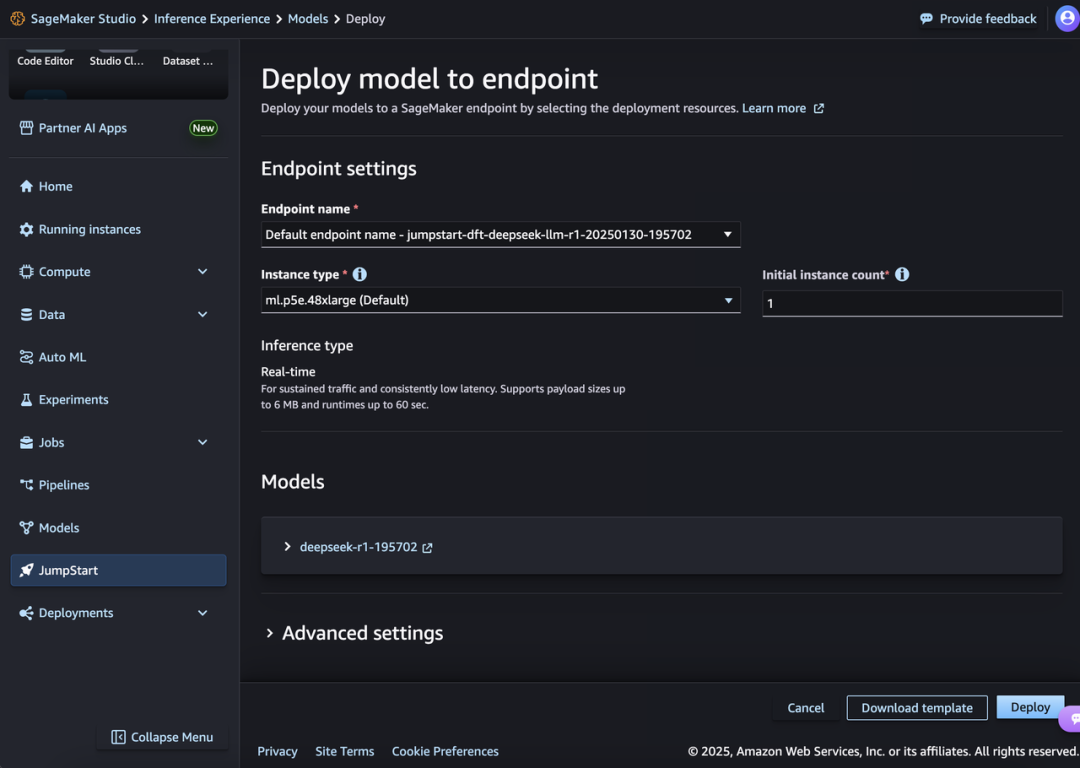

在Amazon SageMaker AI控制台中,打开Amazon SageMaker Unified Studio或Amazon SageMaker Studio。如果是Amazon SageMaker Studio,选择“JumpStart”,然后在“All public models”页面中搜索“DeepSeek-R1”。

您可以选择该模型并点击“部署”,使用默认设置创建一个端点。当端点处于“服务中”(InService)状态时,您可以通过向该端点发送请求来进行推理。

几个tips:

-

调整模型性能和机器学习的操控,可以利用Amazon SageMaker AI的功能,如Amazon SageMaker Pipelines、Amazon SageMaker Debugger或容器日志。

-

模型部署在亚马逊云科技的安全环境中,并且处于您私有网络(VPC)之下,所以数据更安全。

-

可以在Amazon SageMaker JumpStart中使用ApplyGuardrail API,将生成式AI应用的安全防护与DeepSeek-R1模型解耦。这样无论是否调用基础模型,您的应用也有安全防护,可以集成进标准的、经过充分测试的企业级安全防护。

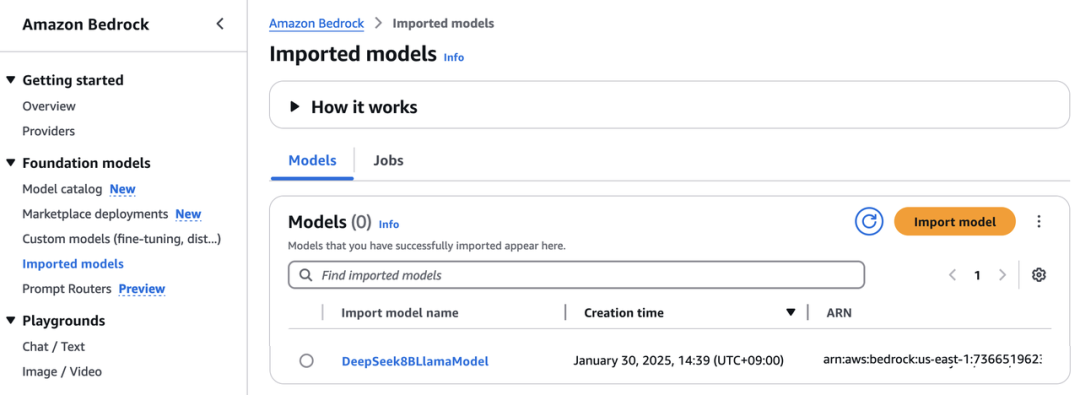

3.通过Amazon Bedrock自定义导入DeepSeek-R1-Distill模型

Amazon Bedrock允许您通过单一的Serverless、统一API导入并使用定制化的模型,无需管理底层基础设施,这些模型可以与现有的基础模型一起使用,可以自定义导入参数规模在15亿到700亿之间的DeepSeek-R1-Distill Llama模型,可以利用6710亿参数的大型DeepSeek-R1模型,也可以蒸馏训练更小、更高效的模型,以模仿行为和推理模式。

将这些公开可用的模型存储到Amazon S3存储桶或Amazon SageMaker模型注册表,然后进入Amazon Bedrock控制台中的“基础模型”部分下的“导入模型”,并通过Amazon Bedrock在完全托管且Serverless的环境中导入并部署它们。用Serverless消除对基础设施管理的需求,同时提供了企业级的安全性。

请参考这份关于如何使用Amazon Bedrock定制导入DeepSeek-R1模型的逐步指南

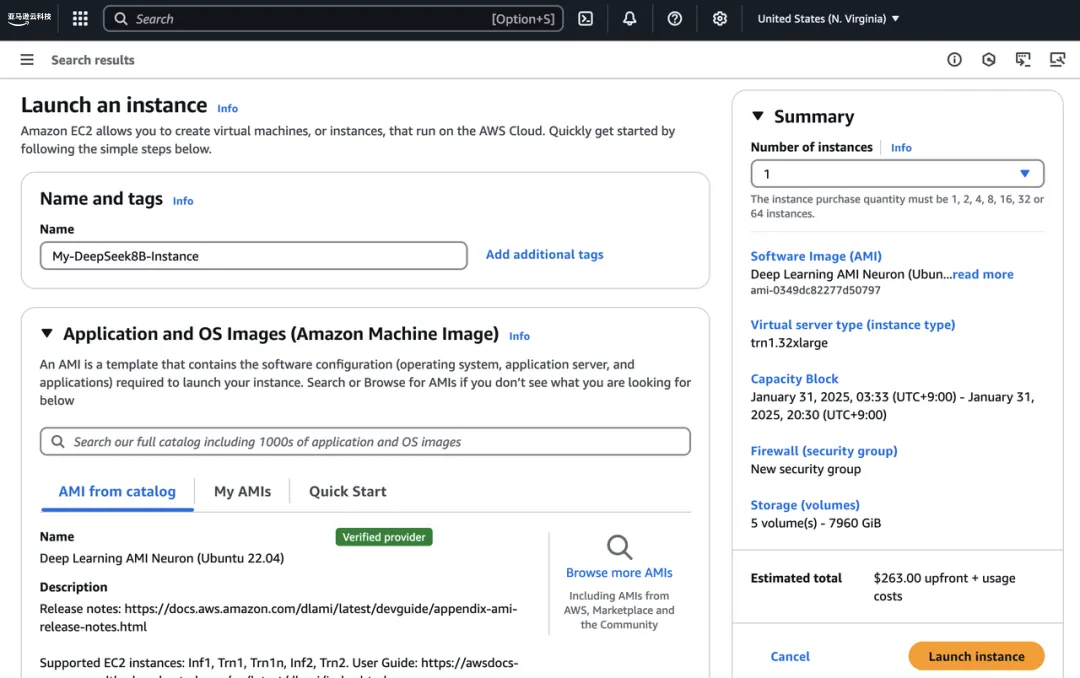

4.使用Amazon Trainium和Amazon Inferentia部署DeepSeek-R1-Distill模型

亚马逊云科技深度学习AMI(DLAMI)提供了定制化的镜像,您可以进行深度学习训练,Amazon EC2的各种实例类型,无论是仅配备CPU的小型实例,还是最新的高性能多GPU实例。获得最佳性价比的方法是:将DeepSeek-R1-Distill模型部署在Amazon Trainium1或Amazon Inferentia2实例上。

进入Amazon EC2控制台,启动一个trn1.32xlarge EC2实例,使用名为“Deep Learning AMI Neuron(Ubuntu 22.04)”的Neuron多框架DLAMI。

连接到已启动的EC2实例后,安装vLLM,这是一个提供大语言模型的开源工具,并从Hugging Face下载DeepSeek-R1-Distill模型。

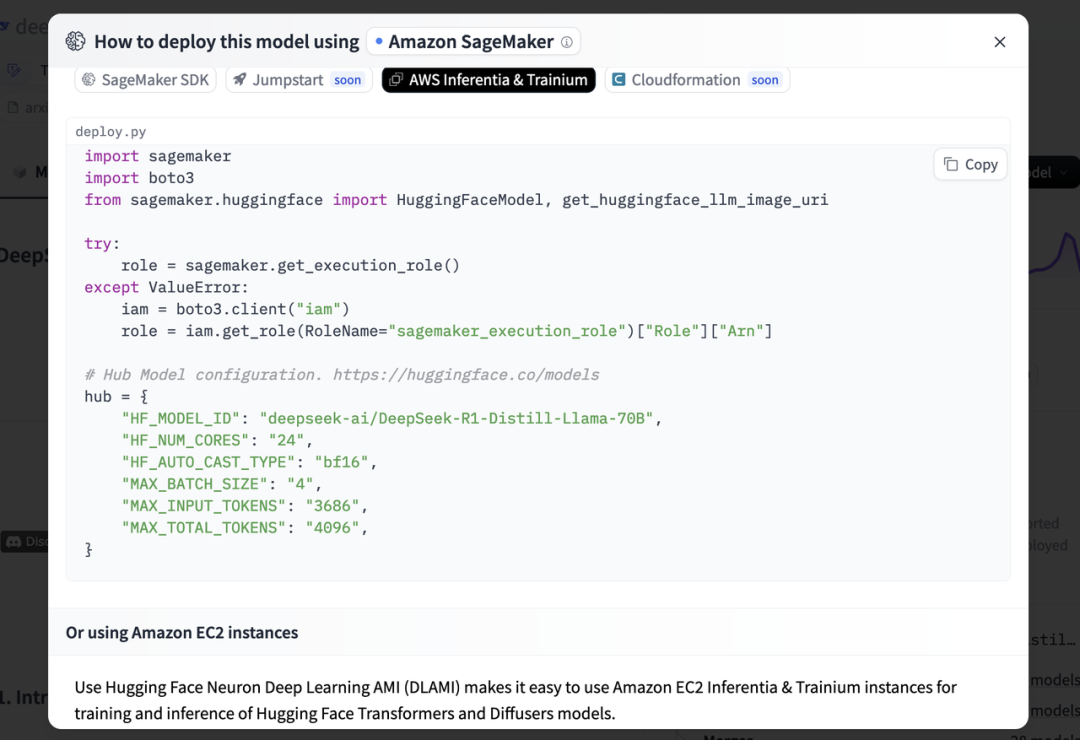

了解更多,请参考关于如何在Amazon Inferentia和Amazon Trainium上部署DeepSeek-R1-Distill Llama模型的逐步指南

还可以访问Hugging Face上的DeepSeek-R1-Distill-Llama-8B或deepseek-ai/DeepSeek-R1-Distill-Llama-70B模型卡片。选择“部署”,然后选择“Amazon SageMaker”。在“Amazon Inferentia和Amazon Trainium”标签页中,复制用于部署DeepSeek-R1-Distill Llama模型的示例代码。

可通过注册亚马逊云科技官网,了解更多内容。

1.《在亚马逊云科技上利用CPU和GPU选项使用DeepSeek-R1》——Daniel Wirjo

2.《在Amazon EC2实例上安装DeepSeek的好处》——Enrique Aguilar Martinez

3.《在Amazon EC2 Inferentia实例上部署DeepSeek Llama模型》——Irshad Chohan

4.《如何在亚马逊云科技上部署和微调DeepSeek模型》——Hugging Face

5.《在Amazon EKS自动模式下托管DeepSeek-R1》——Tiago Reichert

注意事项

定价

您仅需支付基于所选推理实例小时数的基础设施费用,这适用于Amazon Bedrock Marketplace、Amazon SageMaker JumpStart和Amazon EC2。对于Amazon Bedrock模型自定义导入,仅需为模型推理付费,根据自定义模型的活跃副本数量计算,并以5分钟为计费窗口。如需了解更多,请查看Amazon Bedrock定价、Amazon SageMaker AI定价和Amazon EC2定价页面。

数据安全

可以使用Amazon Bedrock和Amazon SageMaker中的企业级安全功能,以帮助确保数据和应用的安全性和隐私性。这意味着您的数据不会与模型提供商共享,也不会被用于改进模型。这一政策适用于所有模型!如需了解更多,请访问Amazon Bedrock安全与隐私以及Amazon SageMaker AI中的安全性和隐私。

现已可用

DeepSeek-R1模型已在Amazon Bedrock Marketplace和Amazon SageMaker JumpStart全面上线。

即刻在Amazon Bedrock控制台、Amazon SageMaker AI控制台以及Amazon EC2控制台中试用DeepSeek-R1模型,并通过您常用的亚马逊云科技渠道进行反馈。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)