DeepSeek R1+Ollama+Cherry Studio实现本地知识库的搭建

创建知识库,点击左侧知识库-添加,输入知识库名称,选择嵌入模型,如果配置了硅基流动,可选择自带的BAAI/beg-m3,或者可以选择本ollama安装的nomic-embed-text。打开Cherry Studio,点击左下角设置-模型服务,选择Ollama,点击管理按钮,在列出的模型后面点击加号添加模型,本地模型不需要配置API密钥,添加完成即配置成功。打开Cherry Studio,点击左下

1. 了解核心组件

● DeepSeek R1:一个开源的本地化部署的大型语言模型(LLM),提供自然语言理解和生成能力。

模型排行网站:

AI Model & API Providers Analysis | Artificial Analysis,AI Tools Directory: Find Top AI Tools & Statistics

模型测评网:https://lmarena.ai/

● Cherry Studio :是一款集多模型对话、知识库管理、AI 绘画、翻译等功能于一体的全能 AI 助手平台。

● 知识库核心功能:本地文档的存储、向量化、检索与问答。

2. 准备工作

(1) 硬件要求

● 显存:建议 16GB+(如 NVIDIA RTX 4090)以运行大模型。

● 内存:32GB+ 以保证数据处理流畅。

● 存储:至少 50GB 空闲空间(用于模型、文档、向量数据库)。

(2) 软件依赖

● Cherry Studio: Cherry Studio 官方网站 - 全能的AI助手

● Ollama:Ollama

● Embedding模型:nomic-embed-text,bge-m3

3. 部署流程

(1) 部署 DeepSeek R1,嵌入向量模型

安装Ollama

下载并安装ollama,地址:Ollama。

修改安装路径

ollama默认是安装到C盘,如果想要安装到D盘,则可以使用命令行进行安装。

在D盘新建一个文件夹,例如D:\ollama,用于存放ollama的安装文件和模型。打开命令行(Win+R,输入cmd),使用管理员权限运行,输入D:并回车,切换到D盘,执行命令。

OllamaSetup.exe /DIR="D:\ollama"安装完成后,打开CMD,输入ollama显式下面信息表示安装成功。

配置环境变量

如果希望模型下载到指定文件路径如D盘,需要配置环境变量。

首先在想要保存的盘符如D盘创建一个文件夹和子文件夹,名为ollama和ollama\models,如D:\ollama和D:\ollama\models

编辑path变量,添加该路径

新建一个名为OLLAMA_MODELS变量,值为D:\ollama\models。配置完之后需要重启ollama

下载模型并运行

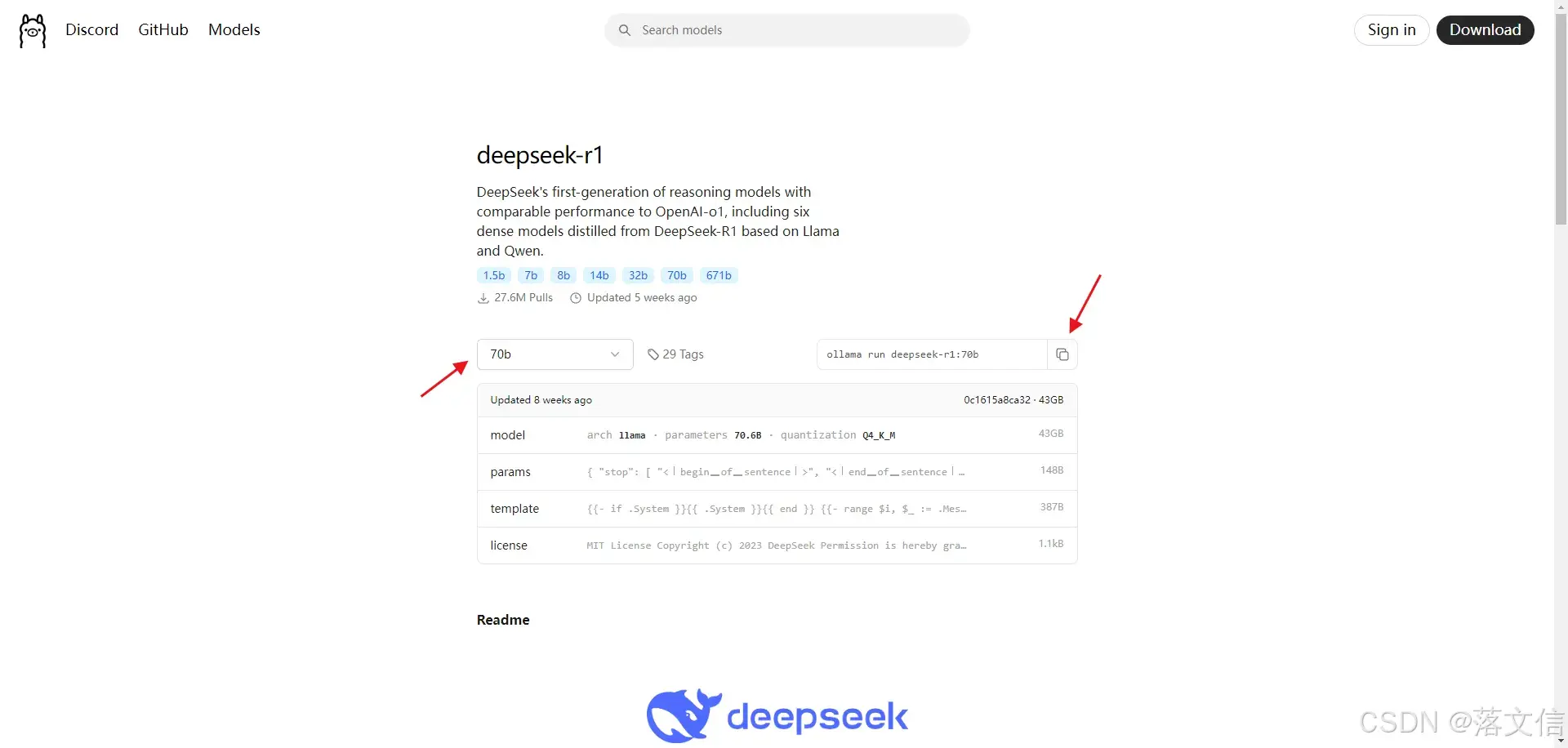

在官网Models里搜索并使用 ollama run deepseek-r1 命令直接下载和配置模型,可以指定版本如 deepseek-r1:1.5b。

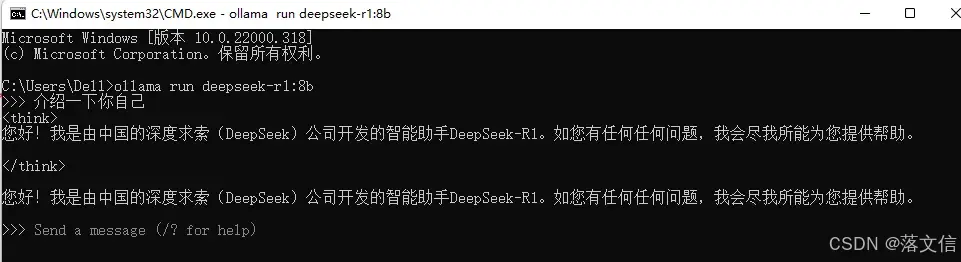

打开CMD,运行命令,下载模型并运行

ollama run deepseek-r1:1.5b模型下载中,可以查看下载进度

下载完成后显式success字样会自动开启对话>>>,可以输入文本测试模型是否正常运行,如“strawberry中有几个字母r?”,"9.8 和 9.11哪个数大?"收到回复表示模型成功运行。

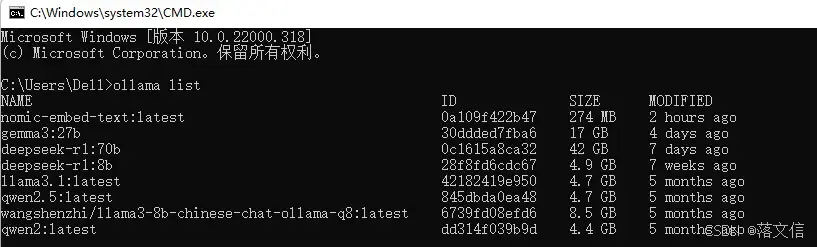

查看已经安装过的模型,命令ollama list

ollama list

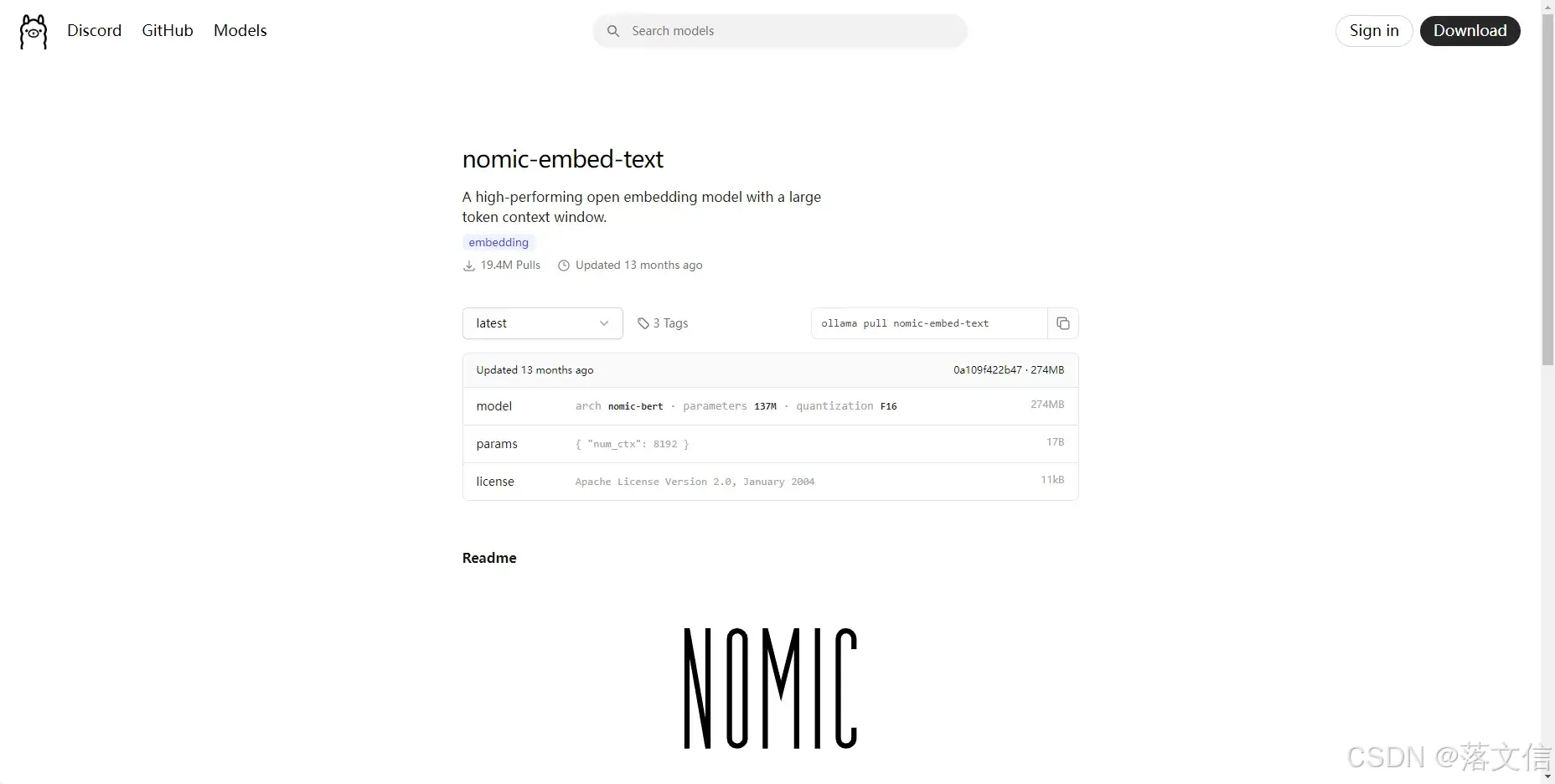

同样的方法下载Embedding模型 nomic-embed-text

ollama pull nomic-embed-text

本地启动模型 :

直接运行命令'ollama run 模型名'可以启动对应模型,查看已经下载的模型使用命令'ollama list'

验证模型:

(2) 部署 Cherry Studio

安装Cherry Studio

访问官网下载安装包,Cherry Studio 官方网站 - 全能的AI助手

安装后打开运行,可以看到默认界面如下

配置模型连接

本地模型连接

打开Cherry Studio,点击左下角设置-模型服务,选择Ollama,点击管理按钮,在列出的模型后面点击加号添加模型,本地模型不需要配置API密钥,添加完成即配置成功。

切换到对话窗口,在最上方可以切换模型,选择Ollama提供的配置好的模型进行对话。

成功对话,显式对应模型回复的结果。

调用线上模型连接

第三方服务商1-硅基流动

访问官网注册账号:硅基流动用户系统,统一登录 SSO,然后在左下角账户管理,新建API密钥。

打开Cherry Studio,点击左下角设置-模型服务,选择硅基流动,粘贴官网新建的API密钥,点击检查,出现绿色小勾则表示连接成功。

切换到对话窗口,在最上方可以切换模型,选择线上硅基流动提供的模型进行对话。

第三方服务商2-Open Router

注册Open Router账号OpenRouter,选择右上角个人账户找到Keys选项,进入后选择API Keys进行创建一个新的密钥,创建成功后复制密钥并保存在本地(密钥只会显式一次,需要妥善保存)

打开Cherry Studio,点击左下角设置-模型服务,选择OpenRouter,粘贴官网新建的API密钥,点击检查,出现绿色小勾则表示连接成功。

切换到对话窗口,在最上方可以切换模型,选择OpenRouter提供的模型进行对话。(该模型平台提供最新版本的deepseekv3-0324)

(3) 构建知识库

1. 创建知识库,点击左侧知识库-添加,输入知识库名称,选择嵌入模型,如果配置了硅基流动,可选择自带的BAAI/beg-m3,或者可以选择本ollama安装的nomic-embed-text。

点击创建的知识库,上传文件,此时上传部分格式文件如pdf可能会提示解析失败,此时我们需要到切换适合的嵌入向量模型库来处理。

添加完成后,可以在对话窗口引用向量模型进行提问

(4) 使用知识库

在对话问答框里选择对应的知识库进行提问,系统会根据知识库检索并做出回答

验证问答功能

在对话界面输入问题后,系统将自动执行以下流程:

1.问题向量化 → 2.从知识库检索相关内容 → 3.将结果拼接为Prompt → 4.调用模型生成答案。

让模型具有网络搜索能力

设置-网络搜索

在对话窗口打开网络搜索功能

Tavily 联网登录注册教程

Tavily 联网登录注册教程 | CherryStudio

更详细的知识库管理可以参考官方文档设置:

关于嵌入模型的概念说明:

嵌入模型 (Embedding Model)-Alibaba CloudSpring Cloud AlibabaOfficial Website

提示词优化工具-prompt-optimizer:

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)