DeepSeek本地部署| 看完即可搞定上手!

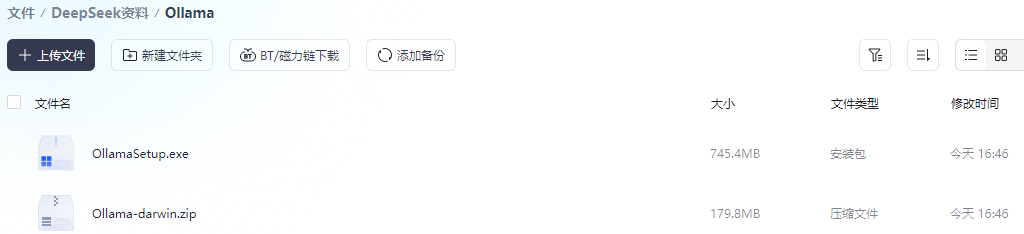

无需云端依赖的DeepSeek本地化部署教程现已就绪,通过完全离线运行架构实现数据零外泄,支持RTX 30系以上显卡灵活调参。我们提供开箱即用的资源整合包(含Ollama框架+模型权重+可视化工具链),解压后执行三步安装命令即可构建专属AI工作站,助您以最小硬件成本开启私有化智能时代,立即扫码获取部署密钥开启自主可控的AI小助手。1安装 OllamaOllama 是 DeepSeek 的基础工具,

前言

无需云端依赖的DeepSeek本地化部署教程现已就绪,通过完全离线运行架构实现数据零外泄,支持RTX 30系以上显卡灵活调参。

我们提供开箱即用的资源整合包(含Ollama框架+模型权重+可视化工具链),解压后执行三步安装命令即可构建专属AI工作站,助您以最小硬件成本开启私有化智能时代,立即扫码获取部署密钥开启自主可控的AI小助手。

1

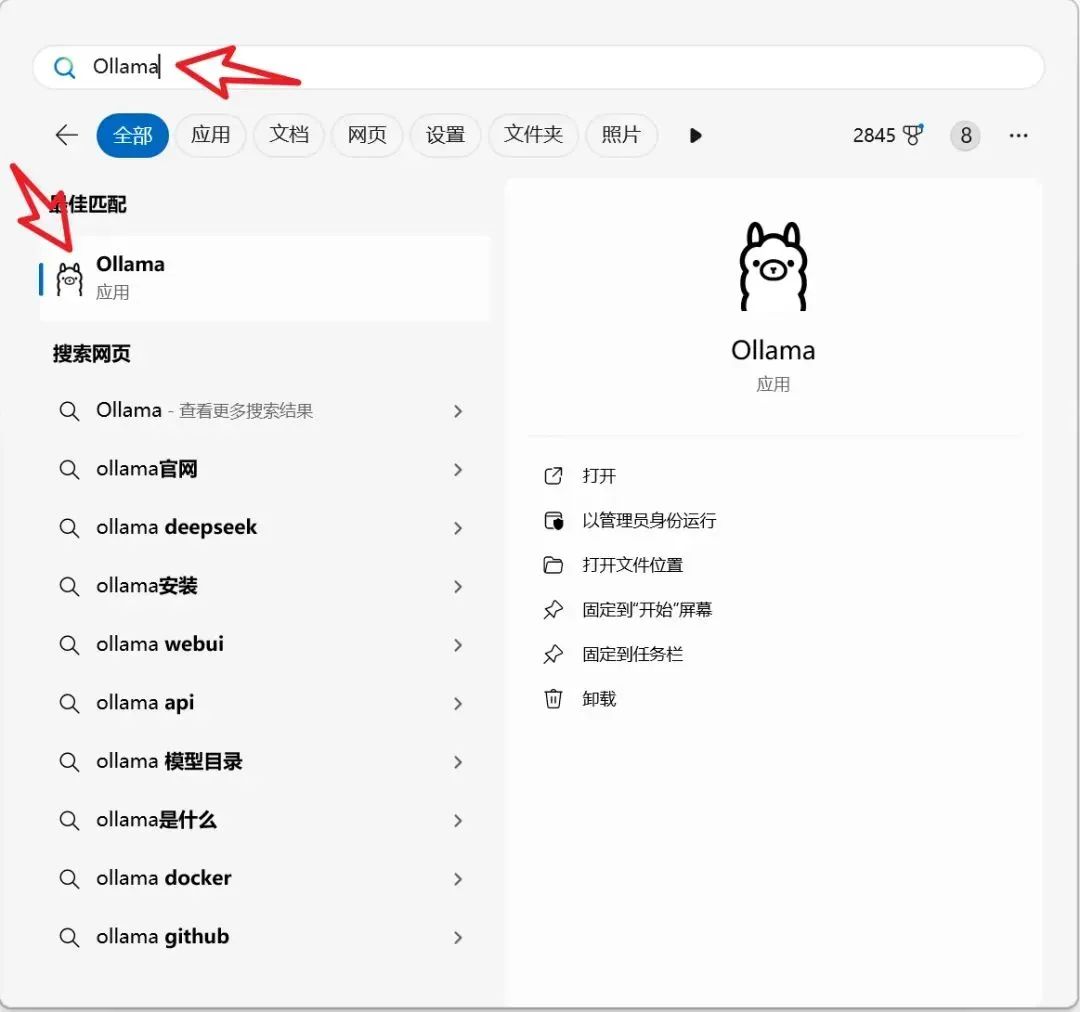

安装 Ollama

Ollama 是 DeepSeek 的基础工具,负责管理和运行你的 AI 模型。可以把它理解成 DeepSeek 模型的“守门员”,没有它,DeepSeek 根本无法启动。

下载 Ollama 的安装包,双击,安装向导跟着一步步点击即可,简单得像装个普通的 App 一样。安装完成后,打开命令行,输入 ollama --version,看一下是不是返回了版本号。若返回结果正确,表示安装成功!

2

安装 DeepSeek 模型

模型选择

1.5B:适合轻量级任务的用户,4GB 内存的机器就可以跑了。

7B:大部分主流电脑,8GB 内存,4GB 显存完全能驾驭。

32B:硬核玩家考虑,内存有 32GB,显卡有 12GB 显存,即可尝试

其他参数可以参考下图

打开模型的官网地址:https://ollama.com/library/deepseek-r1

温馨提示:1.5b、7b、8b、14b、32b、70b 是蒸馏后的小模型,适合不同内存配置的电脑,适用于不同复杂度的任务。 671b 是基础大模型,参数数量最多,模型容量极大,适合处理海量知识和复杂语言模式的任务,但对硬件要求极高。

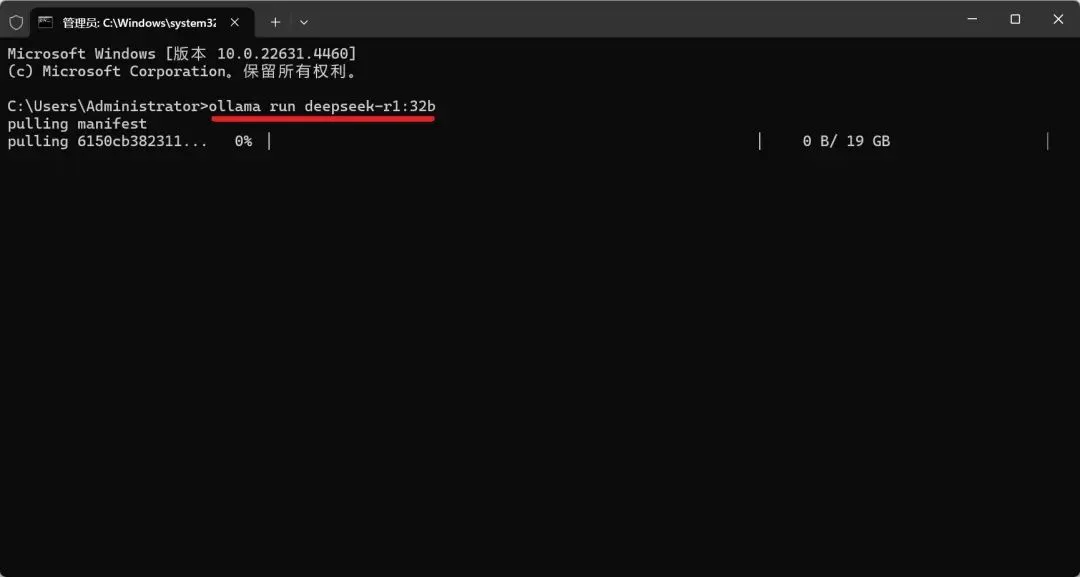

安装方法

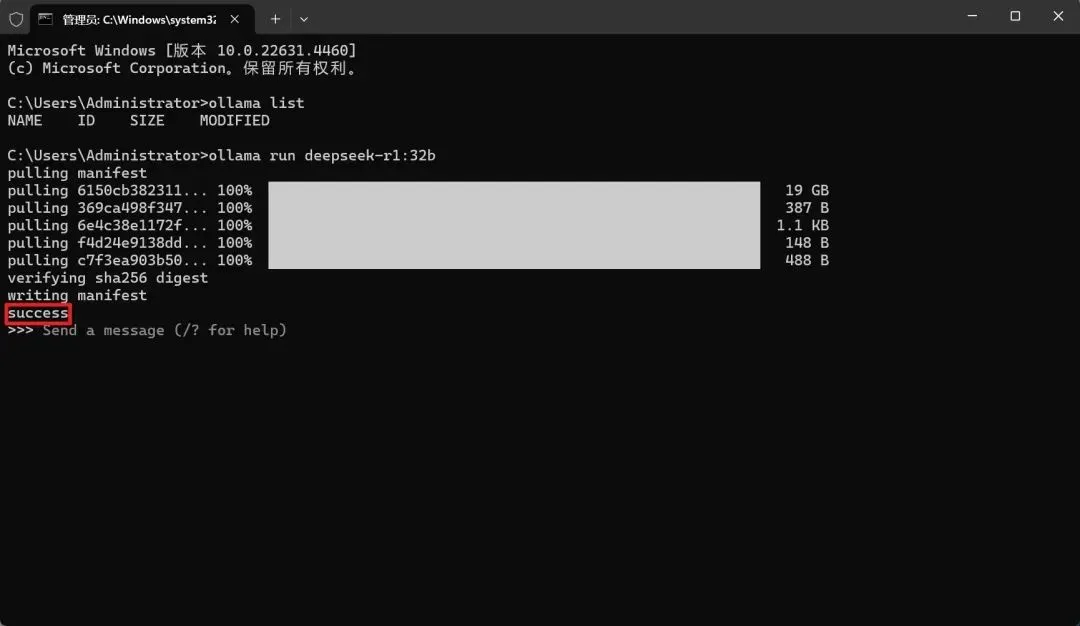

模型下载完成后,在终端中输入模型部署命令,对应模型命令可参考步骤模型版本说明(例如输入:ollama run deepseek-r1:1.5b)后在键盘上按【Enter】回车。

当界面显示【success】表示安装成功。可直接在【Send a message for help】输入问题进行对话,如需优化对话界面,继续后面的教程。

3

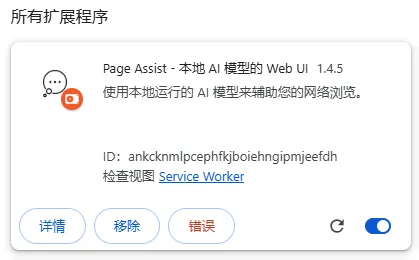

浏览器插件(选装)

DeepSeek 还提供了浏览器插件,在网页上和 AI 互动。在浏览器中输入问题,DeepSeek 就会为你提供答案。

安装方法

启用 Chrome 浏览器的开发者模式,下载并解压插件文件;将插件文件拖入 Chrome 扩展中心,这样插件就安装完成啦。

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)