听说 Qwen2.5-Max 比 DeepSeek 还牛,这是真的吗?

结果显示,在 Arena-Hard、LiveBench、LiveCodeBench、GPQA-Diamond 等基准测试中,Qwen2.5-Max 的表现超越了。,共同完成复杂的项目,效率和效果都更上一层楼。这使得模型在问答、总结等任务上表现得更加出色,更能理解人类的意图和偏好,生成更符合我们需求的回答。,逐步扩展上下文长度,最终支持高达 128K 的上下文长度,能够更好地处理长文本和复杂任务。

近期,AI 大模型领域新品频出,竞争堪称 “百模大战”。

大年初一,阿里云通义千问团队推出 Qwen2.5-Max 。

听说它比 DeepSeek 还要好,成功吸引了业界的关注,这究竟是怎么回事呢?

别急,接着往下看,或许就是你要的答案!

我们先来实测一下。

我们先来看看知识库截止日期,可以看到知识库的信息非常新。

接着我们问问马斯克和奥特曼的生日相差几天,可以看到还是非常有逻辑的。

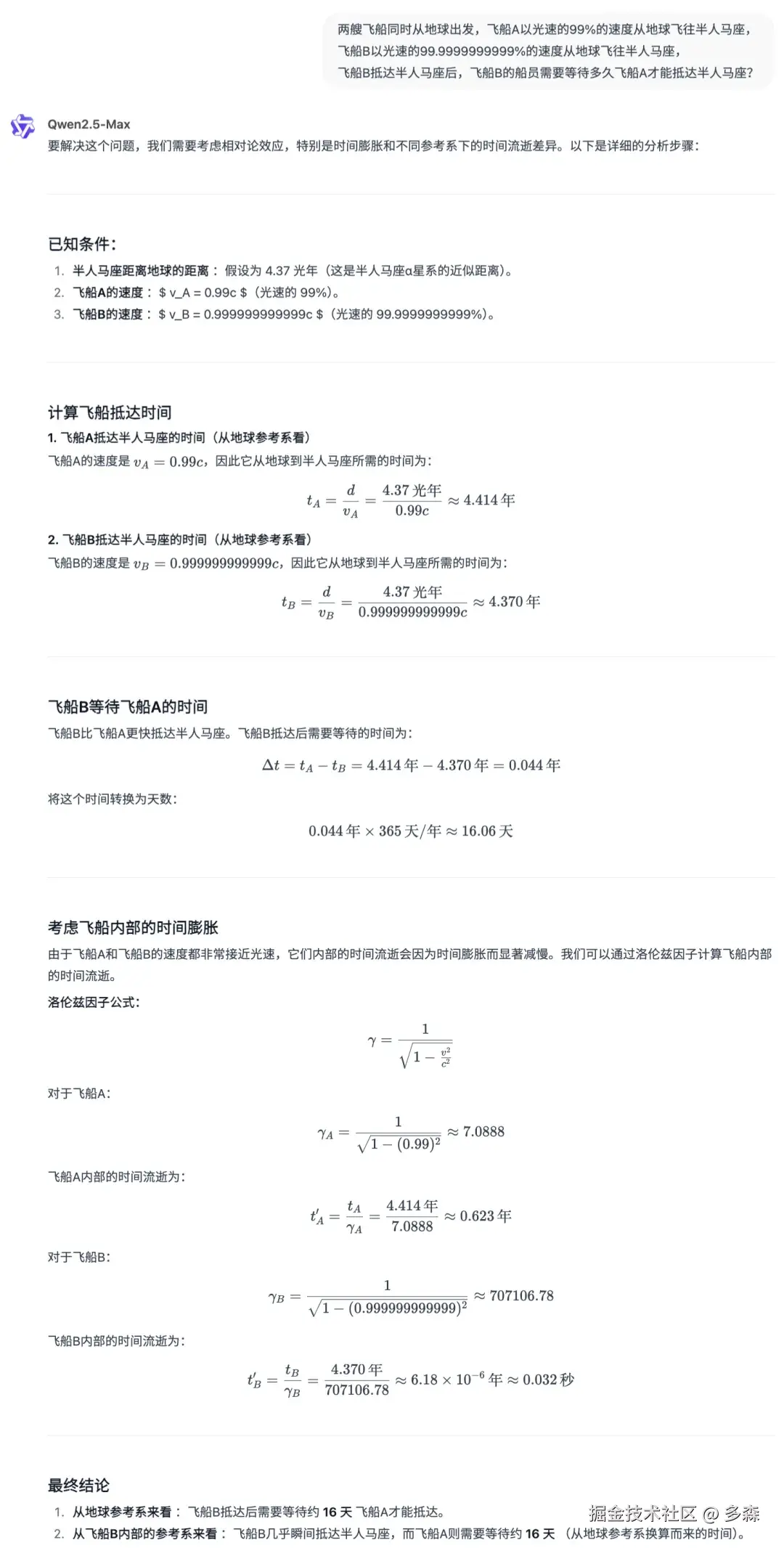

接着我们问一道比较难的题,可以看到它会考虑时间膨胀,整体思路也没有问题。

接着我们分析下其具体好在哪里?

多个基准测试中超越 DeepSeek V3

在多个主流权威基准测试上,阿里云对 Qwen2.5-Max 和 DeepSeek V3 进行了对比。结果显示,在 Arena-Hard、LiveBench、LiveCodeBench、GPQA-Diamond 等基准测试中,Qwen2.5-Max 的表现超越了 DeepSeek V3。达到了与 GPT-4 和 Claude-3.5-Sonnet 等顶尖模型相媲美甚至在某些方面领先的水平。

超大规模预训练数据

Qwen2.5-Max 使用了超过 20 万亿 token 的预训练数据,这为它提供了强大的知识储备和语言理解能力。就像一个人读了无数本书,积累了丰富的知识,从而能够更好地应对各种问题。

先进的 MoE 架构

作为一款超大规模的 MoE 模型,Qwen2.5-Max 通过多个 “专家” 子模型协同工作,能够更有效地处理特定任务。

这就相当于一个团队中各个专家各司其职,共同完成复杂的项目,效率和效果都更上一层楼。模型基于 MoE 架构,通过智能选择适当的 “专家” 模型来优化计算资源,提高推理速度和效率,同时保持高性能。

精心设计的后训练方案

它采用了监督式微调(SFT)和从人类反馈中强化学习(RLHF)的后训练方法。这使得模型在问答、总结等任务上表现得更加出色,更能理解人类的意图和偏好,生成更符合我们需求的回答。

通过精心设计的后训练方案,模型能够更好地对齐人类偏好,改进长文本生成、结构化数据分析和指令遵循等能力。

强大的多模态能力

Qwen2.5-Max 可以处理文本、图像、音频等多种模态的数据。在代码能力方面,能够帮助用户完成各种可视化创作,比如一句话就能做出旋转的球体,甚至还能开发小游戏。在联网搜索功能中,输出内容的每句话来源出处都有标注,运行流畅。

其推出的全新视觉模型 Qwen2.5-VL,能够更准确地解析图像内容,突破性地支持超 1 小时的视频理解,无需微调就可变身为一个能操控手机和电脑的 AI 视觉智能体,实现给指定朋友送祝福、电脑修图、手机订票等多步骤复杂操作。

这种多模态能力使得模型在多种应用场景中都能发挥重要作用,如智能客服、自动化办公、编程辅助等。

高效的长文本推理速度

通过引入稀疏注意力机制和优化技术,Qwen2.5-Max 显著提高了长上下文处理的推理速度。它采用多阶段训练策略,逐步扩展上下文长度,最终支持高达 128K 的上下文长度,能够更好地处理长文本和复杂任务。

Qwen2.5-Max 以卓越性能在 AI 领域脱颖而出,超越 DeepSeek V3。

凭借超大规模数据、先进架构与多模态能力,它为行业发展注入新动力,我们可以关注下,相信未来表现更值得期待!

如果觉得不错,随手点个赞吧,如果想第一时间收到推送,也可以关注下我~谢谢你看我的文章,我们,下次再见。

更多推荐

已为社区贡献58条内容

已为社区贡献58条内容

所有评论(0)