DeepSeek R1+Open WebUI实现本地知识库的搭建和局域网访问

在部署ollama的电脑上打开CMD输入下面命令修改配置,重启后生效,访问主机IP:11434查看生效情况,网页显式“Ollama is running”则修改成功。点击创建的知识库,上传文件,此时上传部分格式文件如pdf可能会提示解析失败,此时我们需要到管理页面切换默认的嵌入向量模型库来处理。直接运行命令'ollama run 模型名'可以启动对应模型,查看已经下载的模型使用命令'ollama

1. 了解核心组件

● DeepSeek R1:一个开源的本地化部署的大型语言模型(LLM),提供自然语言理解和生成能力。

● Open WebUI:类似 Ollama WebUI 的开源交互界面,支持通过网页与 LLM 对话,常用于 RAG(检索增强生成)场景。

● 知识库核心功能:本地文档的存储、向量化、检索与问答。

2. 准备工作

(1) 硬件要求

● 显存:建议 16GB+(如 NVIDIA RTX 4090)以运行大模型。

● 内存:32GB+ 以保证数据处理流畅。

● 存储:至少 50GB 空闲空间(用于模型、文档、向量数据库)。

(2) 软件依赖

● Python 3.10+ Welcome to Python.org

● Ollama Ollama

● Embedding 模型:如 BAAI/bge-small-zh-v1.5(中文文本向量化),nomic-embed-text,bge-m3

3. 部署流程

(1) 部署 DeepSeek R1,嵌入向量模型

下载模型:

下载并安装ollama,地址:Ollama。

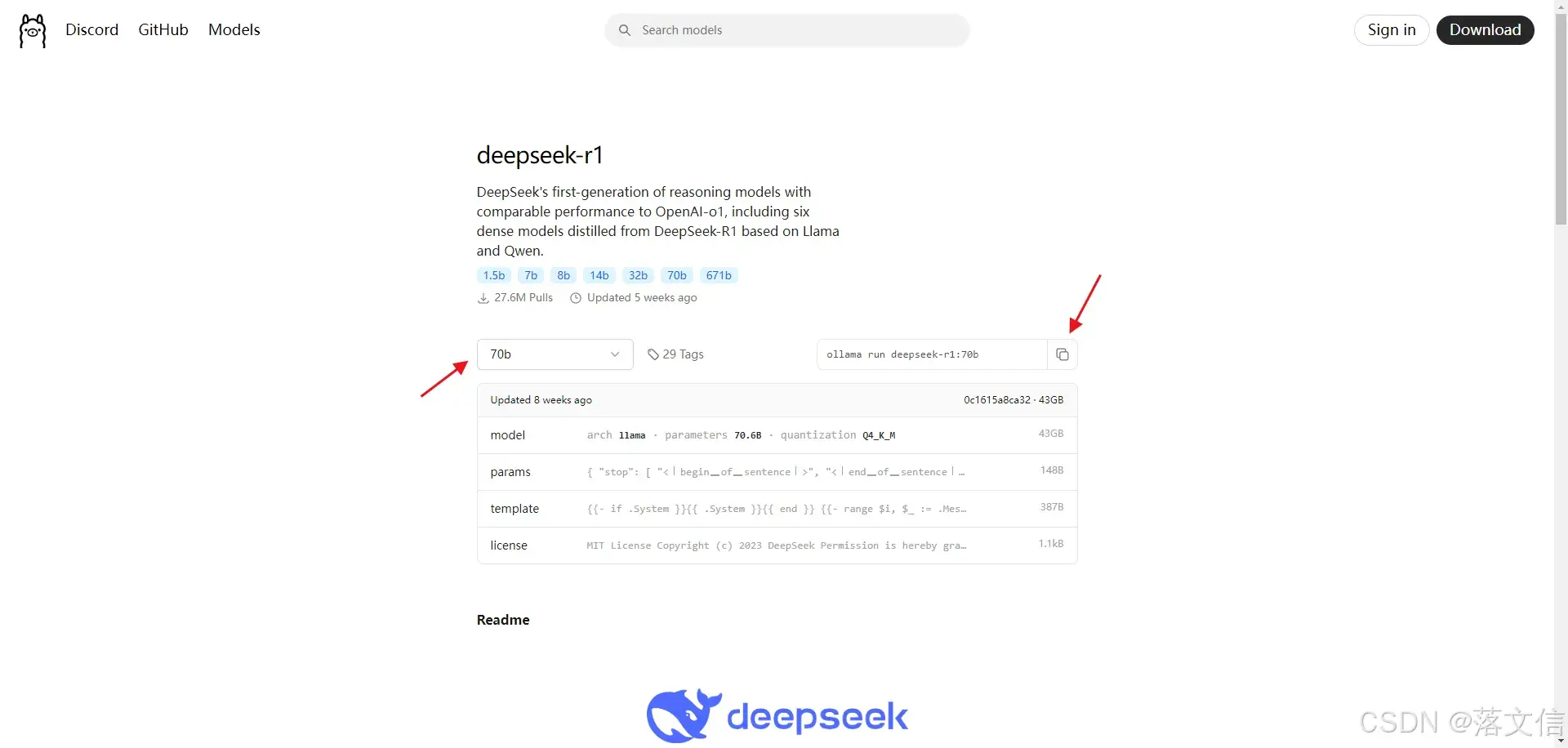

在官网Models里搜索并使用 ollama run deepseek-r1 命令直接下载和配置模型,可以指定版本如 deepseek-r1:70b

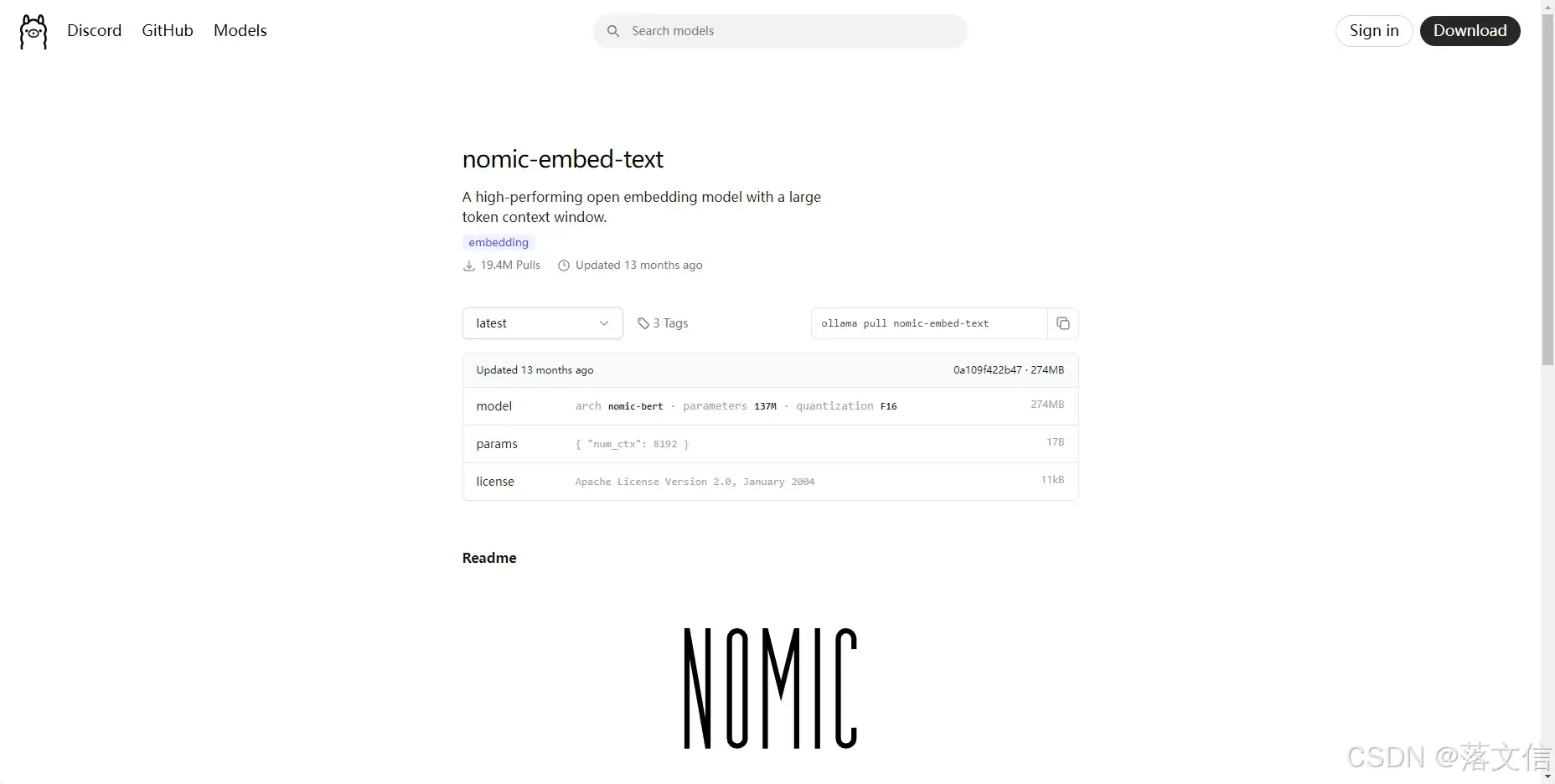

同样的方法下载ollama pull nomic-embed-text模型

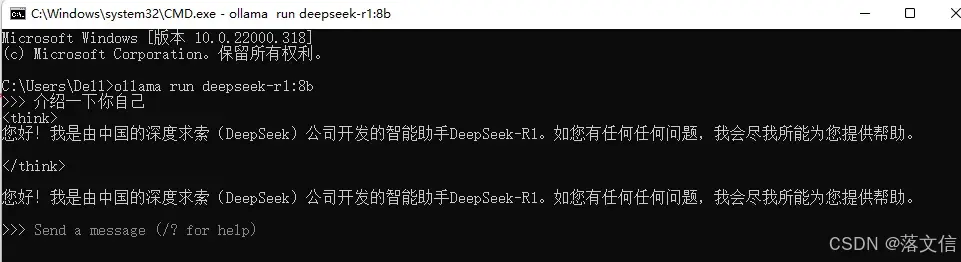

本地启动模型 :

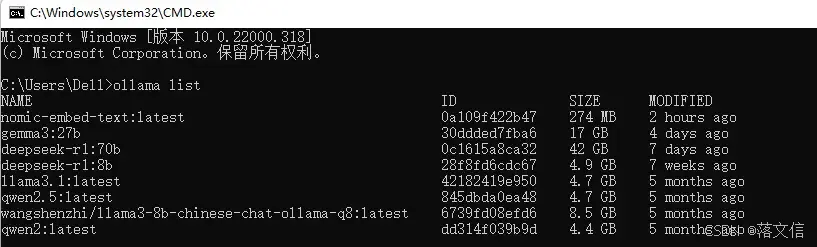

直接运行命令'ollama run 模型名'可以启动对应模型,查看已经下载的模型使用命令'ollama list'

验证模型:

(2) 部署 Open WebUI

使用pip命令快速部署

可以指定国内清华源下载,安装过程中如果出现报错,可能缺少Microsoft Visual C++ Build Tools依赖,可以在Microsoft C++ 生成工具 - Visual Studio官网下载并安装配置使用C++的桌面开发的相关依赖包。

pip install open-webui -i Simple Index启动Open WebUI

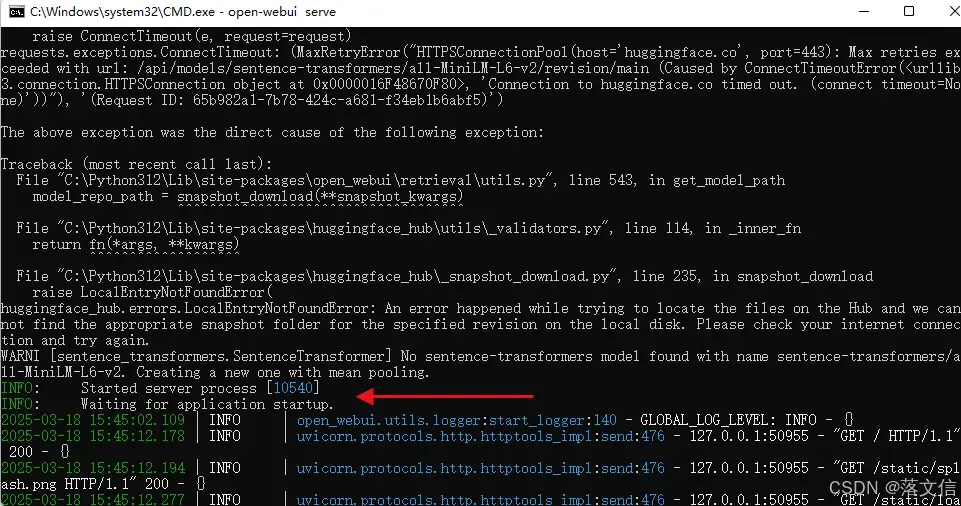

打开CMD窗口输入命令'open-webui serve'启动服务

open-webui serve出现下面信息则启动成功

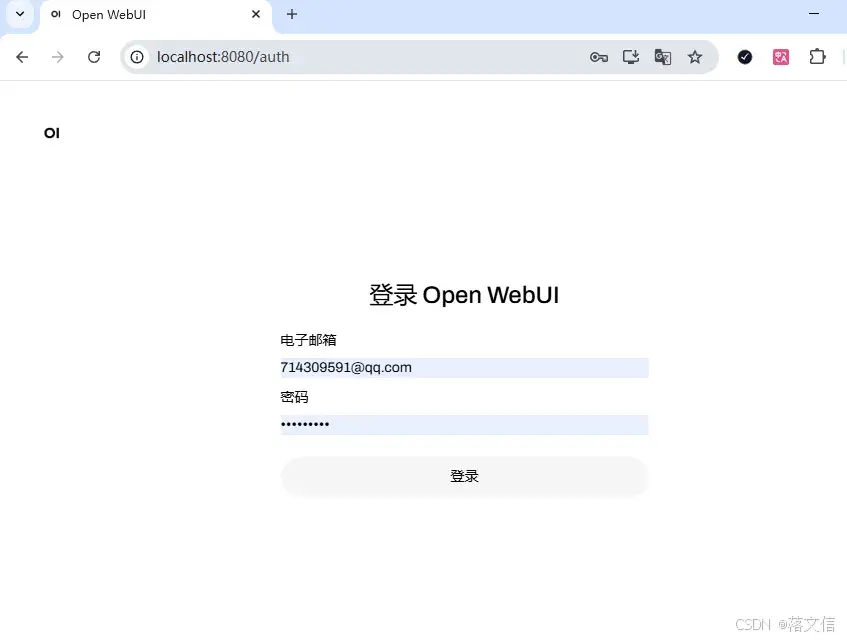

打开浏览器,输入地址http://localhost:8080/访问,首次访问需要注册一个管理员账号

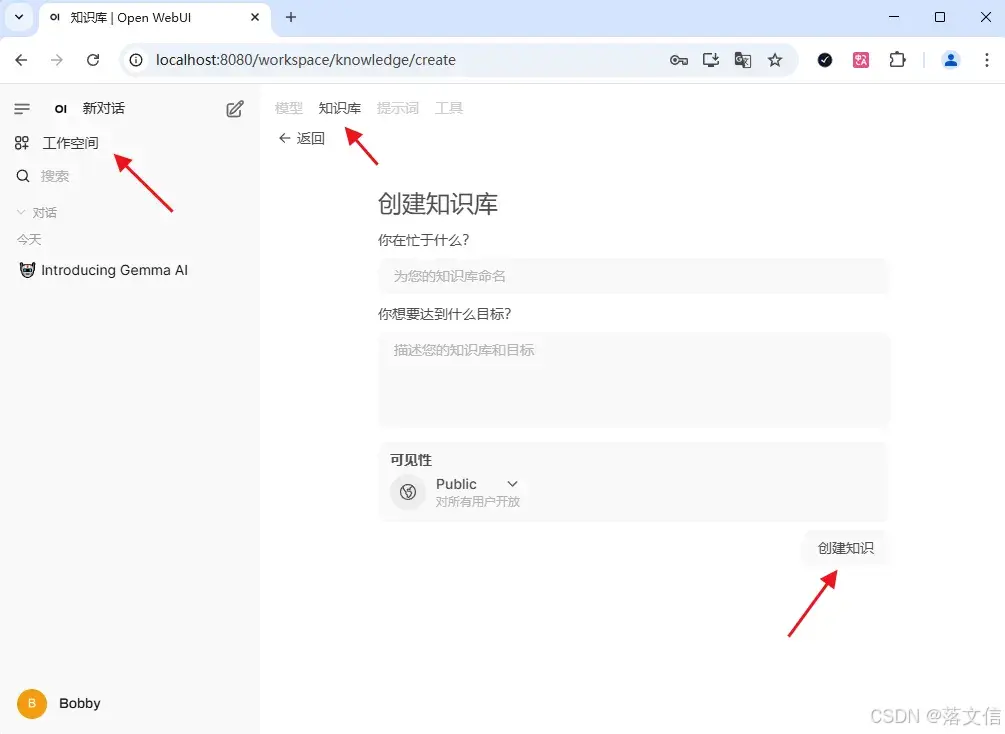

(3) 构建知识库

1. 创建知识库,点击工作空间-知识库,再点击右上角的‘+’新建知识库。

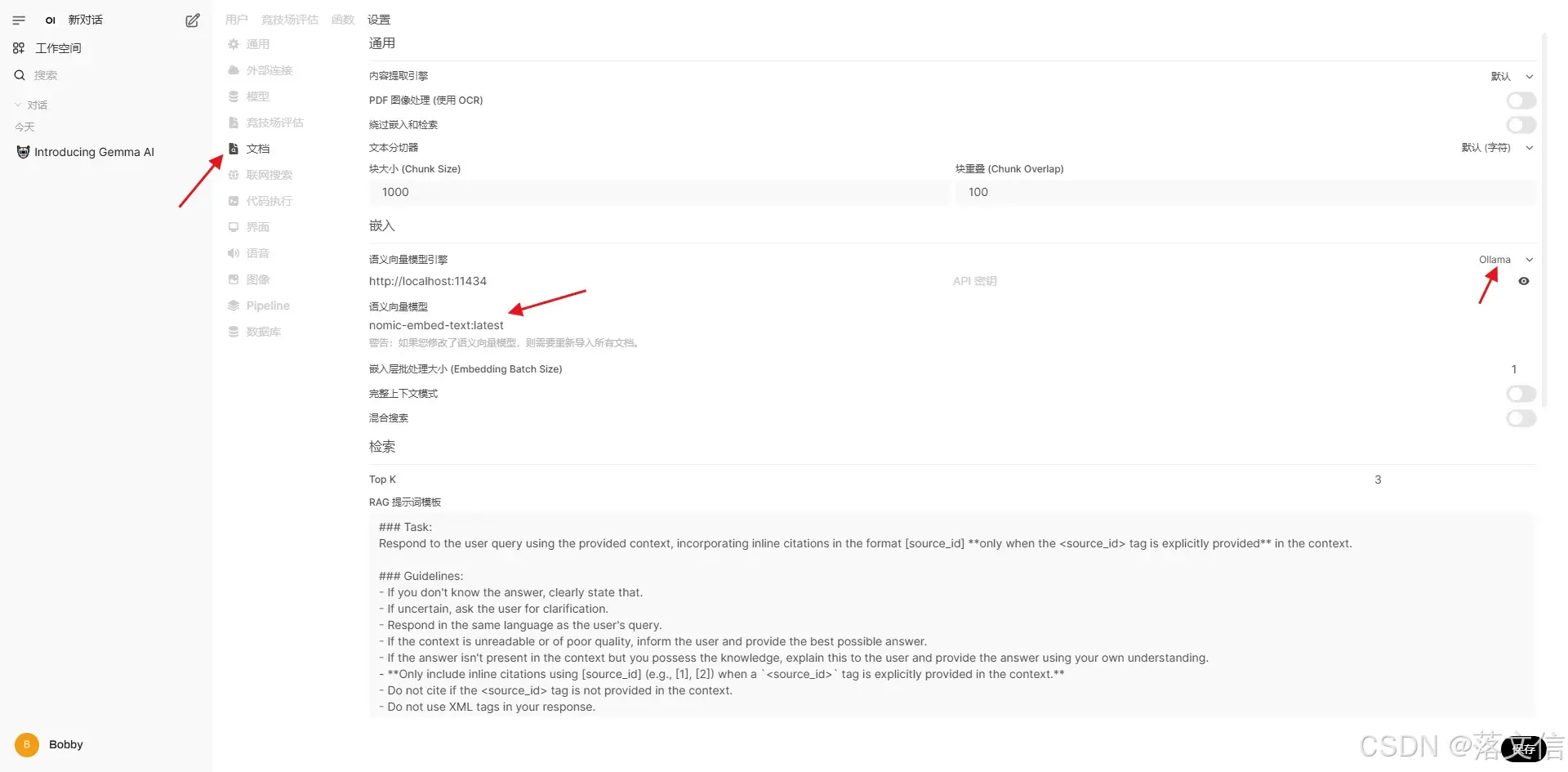

2. 点击创建的知识库,上传文件,此时上传部分格式文件如pdf可能会提示解析失败,此时我们需要到管理页面切换默认的嵌入向量模型库来处理。

左下角点击用户打开管理员设置页面

点击文档选择本地ollama安装好的嵌入向量模型如nomic-embed-text,bge-m3,如果切换了模型,之前上传的文件需要重新上传处理

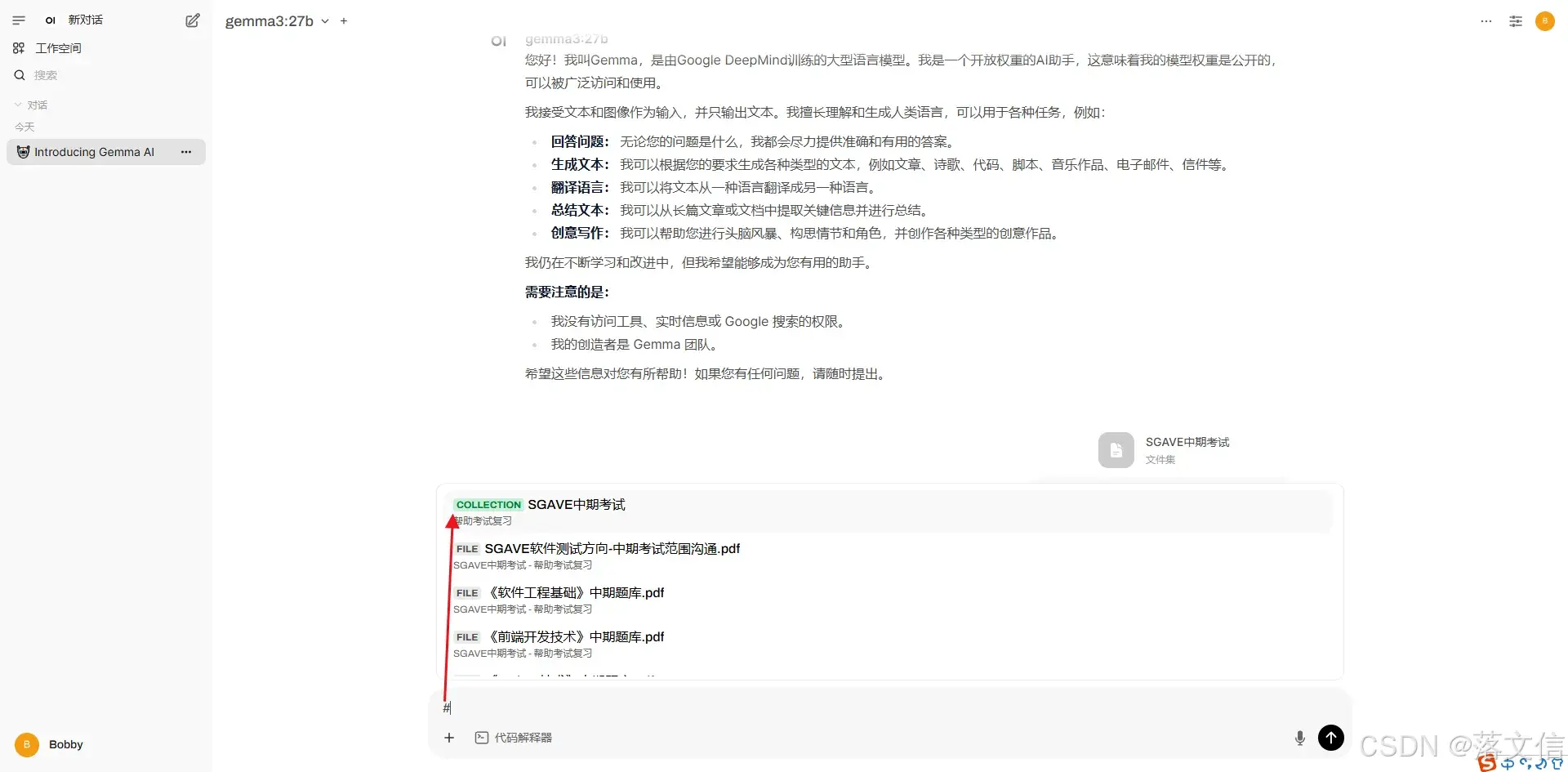

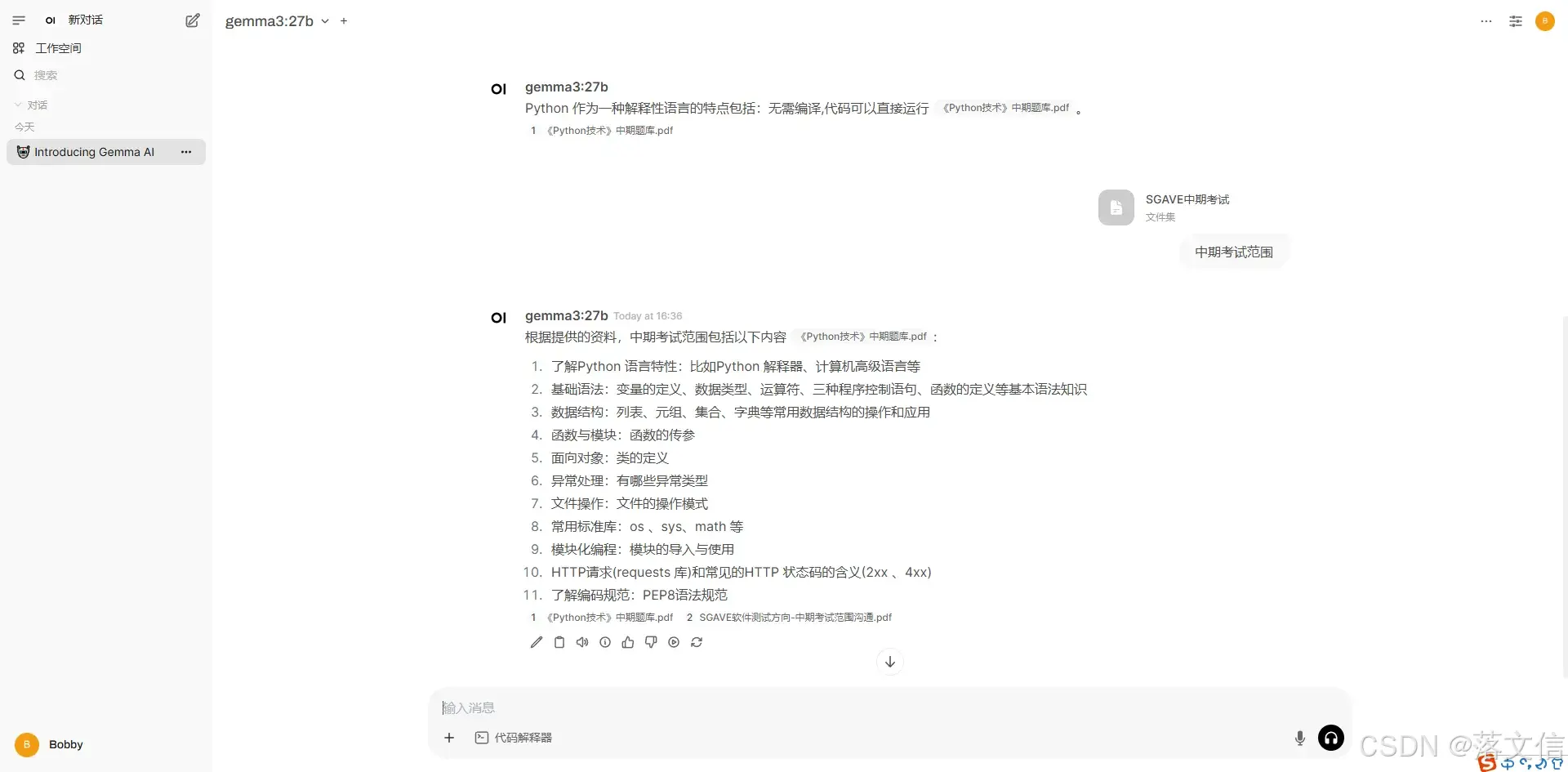

(4) 使用知识库

1. 在对话问答框里使用#选择对应的知识库进行提问,系统会根据知识库检索并做出回答

2. 验证问答功能:

在 Web 界面输入问题后,系统将自动执行以下流程:

问题向量化 → 2. 从知识库检索相关内容 → 3. 将结果拼接为 Prompt → 4. 调用 DeepSeek R1 生成答案。

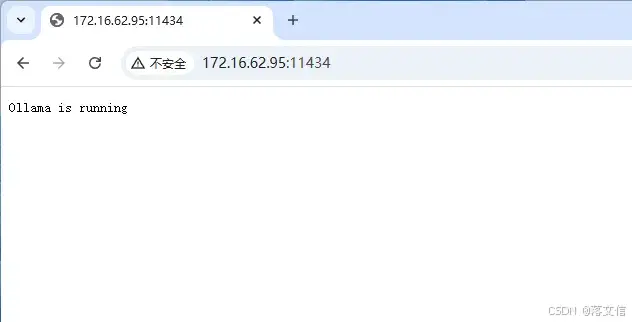

(5) 实现局域网访问知识库

在部署ollama的电脑上打开CMD输入下面命令修改配置,重启后生效,访问主机IP:11434,查看生效情况,网页显式“Ollama is running”则修改成功。

setx OLLAMA_HOST "0.0.0.0"

setx OLLAMA_ORIGINS "*"

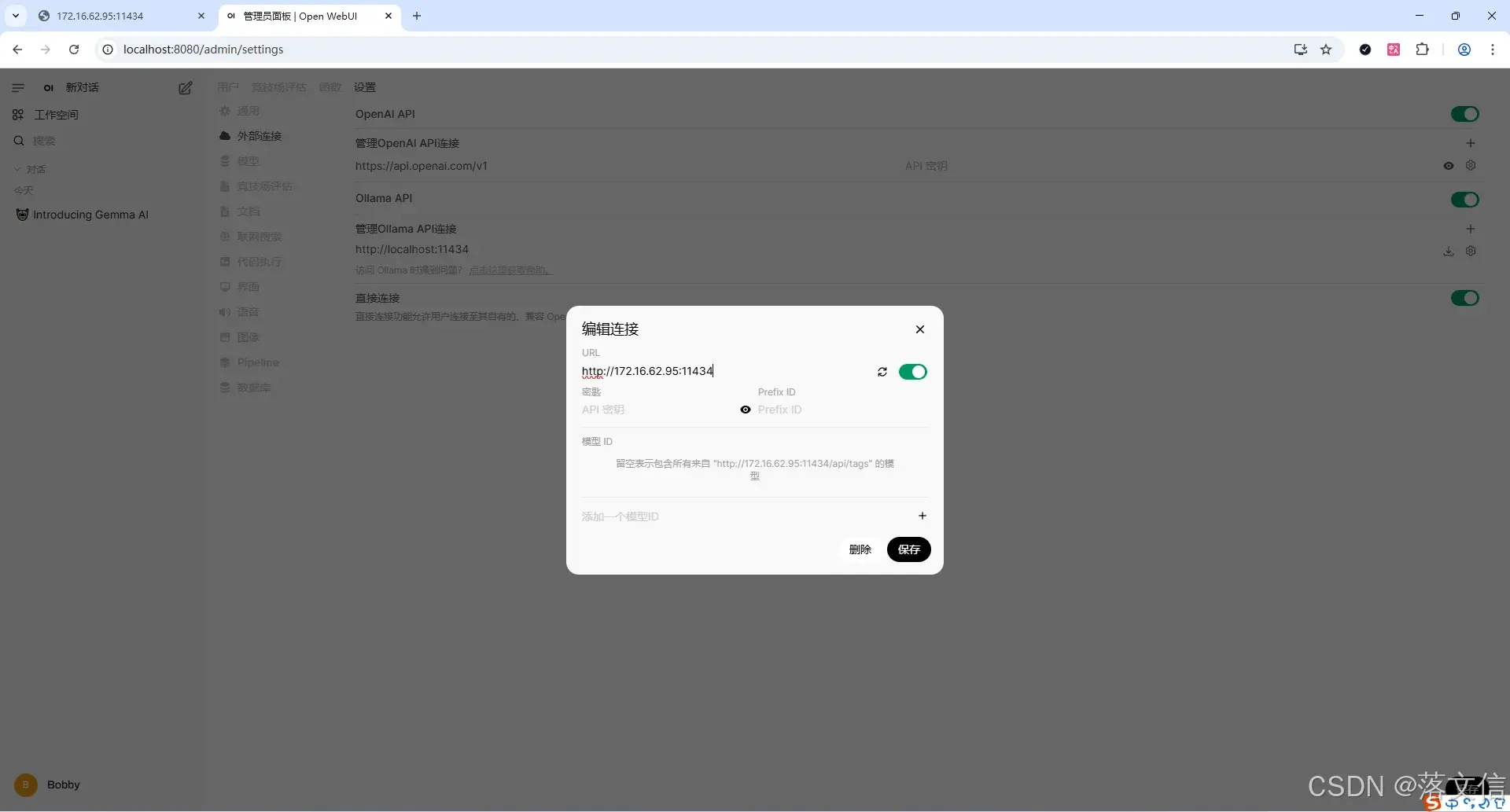

修改Open WebUI设置,修改ollama外部访问链接,地址为主机地址和端口

更详细的知识库管理可以参考官方文档设置:🧠 知识管理 | Open WebUI

关于嵌入模型的概念说明

:嵌入模型 (Embedding Model)-Alibaba CloudSpring Cloud AlibabaOfficial Website

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)